很多同学在面试时,一听到“如何让系统抗住高并发流量”这个问题,思路就容易变得零散。脑海里可能会冒出“用Redis缓存”、“用MQ解耦”等零碎概念,却很难将它们系统地串联起来。其实,面试官想考察的正是你是否具备体系化的架构思维,以及能否从全局视角去审视和解决问题。即使某个具体技术的细节记得不那么牢,但只要你的解题思路清晰、层次分明,面试官也会相信你具备解决复杂问题的潜力。

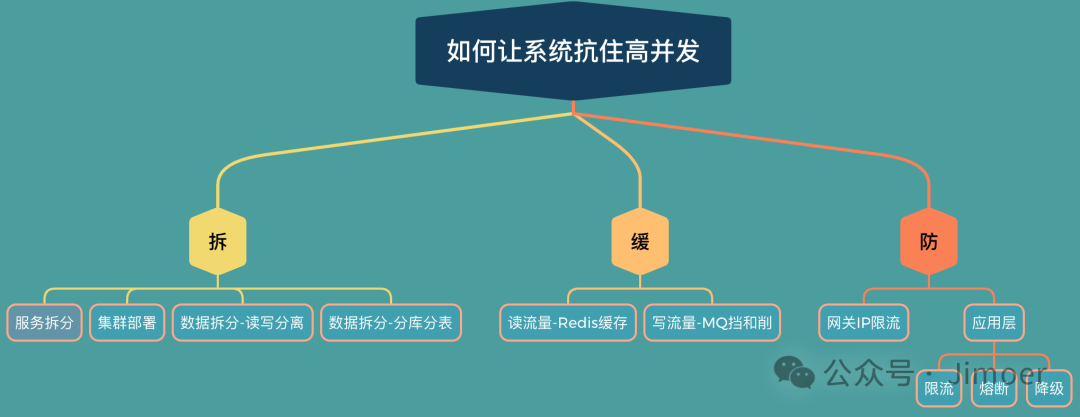

今天,我们就来系统地梳理一下,如何让你的系统从容应对高并发流量。这套方法论可以概括为“拆”、“缓”、“防”三个核心步骤。

第一步:“拆”——分而治之,横向扩展

面对高并发,首要策略永远是“拆分”。其核心思想是分而治之,通过分散压力来提升系统的整体处理能力。具体怎么拆?可以从服务和数据两个维度入手。

服务拆分与治理

服务拆分

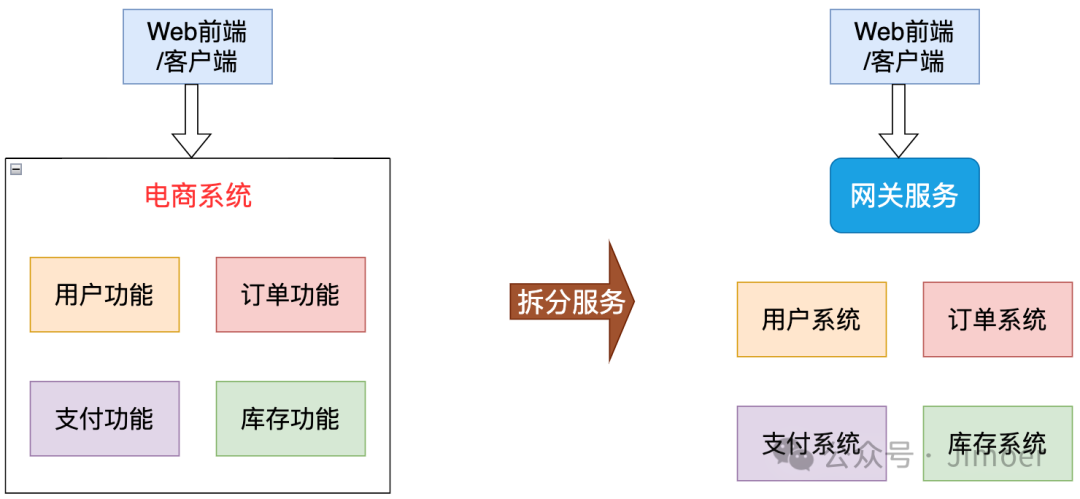

首先是将庞大的单体架构,根据业务领域拆分成多个独立的微服务。这样做的好处是显而易见的:当某个服务遇到性能瓶颈时,我们可以单独针对它进行扩容和优化,而不会因为一个模块的问题导致整个系统瘫痪。

例如,一个典型的电商系统可以拆分为用户、订单、支付、库存等多个独立的服务模块。

服务拆分的核心目标,是运用分布式架构来降低单点故障的风险,同时大幅提升系统的可伸缩性和整体性能。

服务集群部署

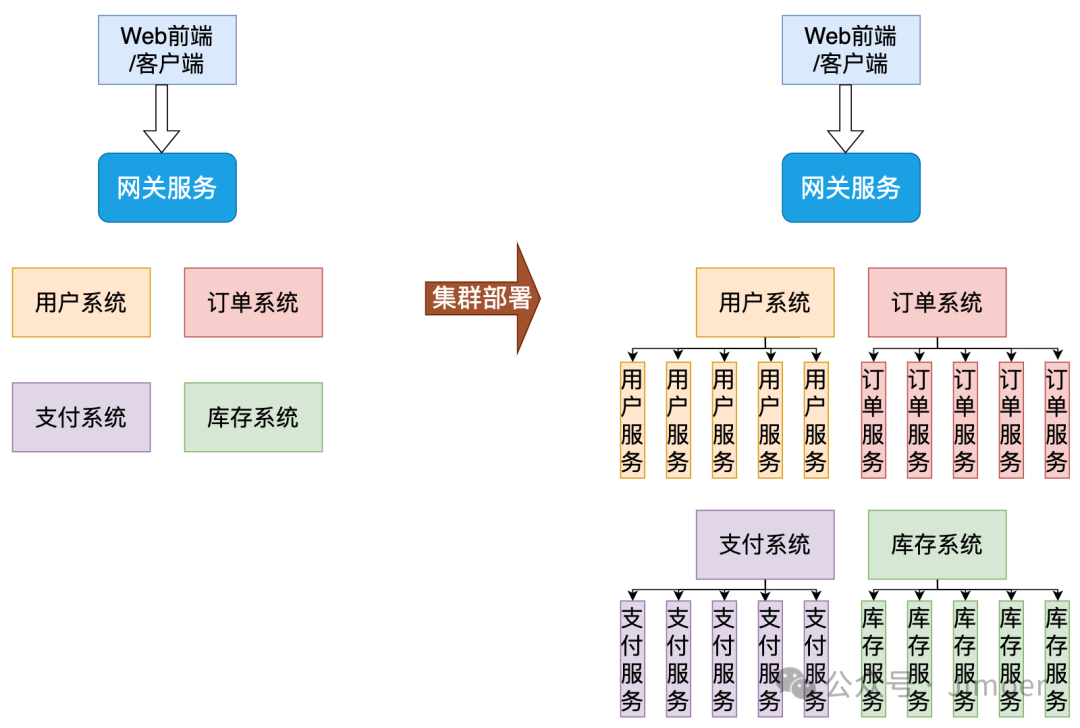

仅仅完成服务拆分,只是将原来单体架构的“单点故障”风险分摊到了各个子服务上,每个子服务自身仍然是一个单点。因此,下一步必须进行集群部署:将每个服务部署在多个服务器实例上,形成一个集群。然后,通过负载均衡技术(如 Nginx、F5 或云服务商的负载均衡器)将用户请求均匀地分发到各个服务器上。

通过集群化,让每一台服务器都承担一部分并发流量,从而指数级地提升系统整体的并发处理能力。这就像从一个人单打独斗,变成了一个分工明确的团队协作。

服务治理

服务拆分了,节点也集群化了,新的问题随之而来:在一个拥有几十个服务、上百个动态 IP 节点的分布式系统中,服务 A 该如何找到服务 B?服务实例上下线时,调用方如何感知?这就需要一个“通讯录”来统一管理和发现所有服务的地址信息,即注册中心。

下面是几种常见注册中心的对比:

| 注册中心 |

CAP 模型 |

健康检查方式 |

多数据中心 |

Spring Cloud 集成 |

典型特点 |

| Eureka |

AP(可用性优先) |

客户端心跳(30s) |

不支持 |

原生支持 |

轻量、与 Spring Cloud 无缝集成,适合入门和中小型项目 |

| Consul |

CP(一致性优先) |

TCP/HTTP/gRPC 主动探测 |

原生支持 |

支持 |

功能最全,支持 KV 存储、ACL、DNS 服务等,适合多语言、多数据中心场景 |

| Zookeeper |

CP |

临时节点存活监听 |

需额外配置 |

支持 |

成熟稳定,强一致性,适合与 Dubbo 等框架配合使用 |

| Nacos |

AP/CP 可切换 |

TCP/HTTP/MySQL/自定义 |

支持 |

原生支持 |

阿里开源,集成注册中心+配置中心+动态DNS,适合云原生和 Spring Cloud 项目 |

那么它们是如何工作的呢? 以目前流行的 Nacos 为例:服务启动时,会自动将自己的 IP 地址和端口注册到 Nacos 服务器。当服务 A 需要调用服务 B 时,它会先从 Nacos 查询服务 B 所有健康的实例列表,然后再通过客户端负载均衡器(如 Ribbon 或 Spring Cloud LoadBalancer)选择一个实例进行调用。这里还可以提一下 Nacos 的动态配置管理能力。在高并发场景下,我们可能需要动态调整线程池参数或日志级别,借助 Nacos 的配置中心功能,无需重启服务,修改配置后即可实时推送并生效,实现了真正的“热更新”。

Nacos 的“动态配置”指的是:在应用运行期,无需重启服务,即可实时推送并生效配置变更的能力。它把“配置”从代码/包内解耦出来,集中存储在 Nacos Server,并通过 长轮询(Long-Polling)+ 版本号对比 机制,让客户端在毫秒级感知到变化,进而触发本地回调或 Bean 重新绑定,实现“热更新”。

数据拆分(读写分离与分片)

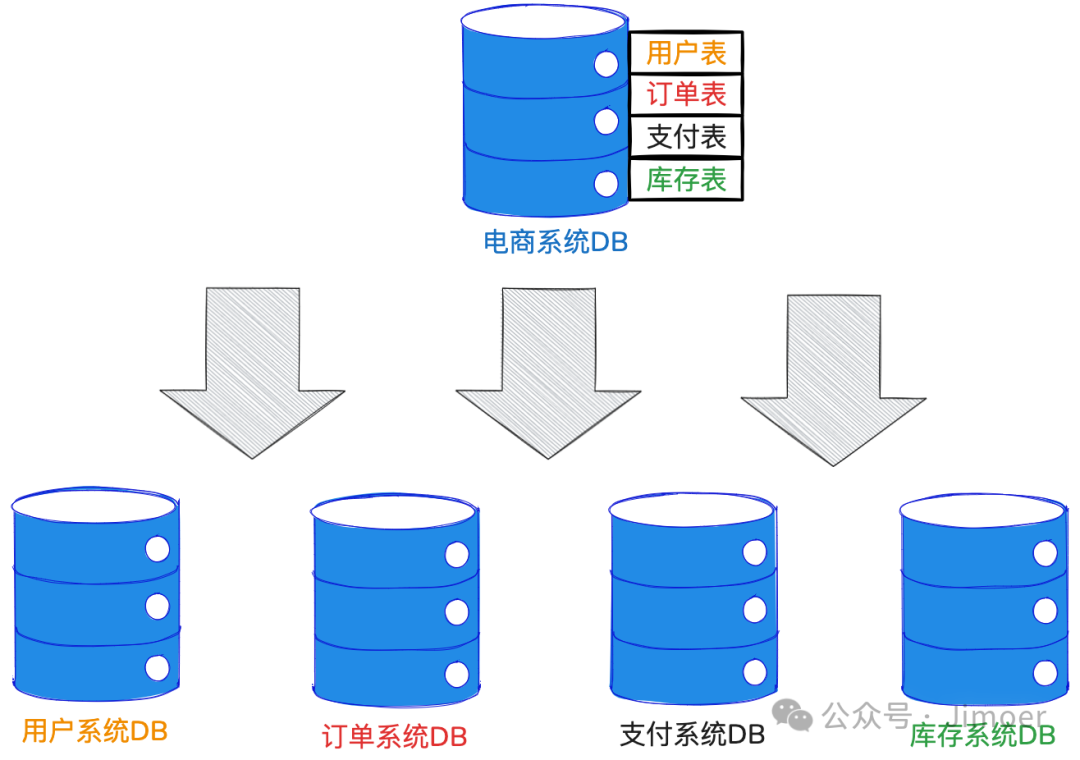

服务拆分后,如果所有服务仍然共用一个数据库,那么数据库很容易成为新的瓶颈。因此,数据库也必须进行相应的拆分。

读写分离

针对“读多写少”的业务场景(如商品浏览、资讯查看),最经典的优化手段就是读写分离。搭建一个主库(Master)负责写操作,多个从库(Slave)负责读操作。通过主从复制机制保持数据同步。

核心策略是:读场景(如商品详情、评论列表)走只读副本,写场景(如下单、支付)走主库。 但必须做好监控,当主从延迟过高时,需要及时告警和处理,避免读到脏数据。

垂直拆分

随着微服务数量的增加,如果所有服务仍连接同一个数据库,会导致数据库连接数暴增,压力巨大。因此,垂直分库是必然选择——做到“专库专用”,让用户服务、订单服务、支付服务各自拥有独立的数据库。

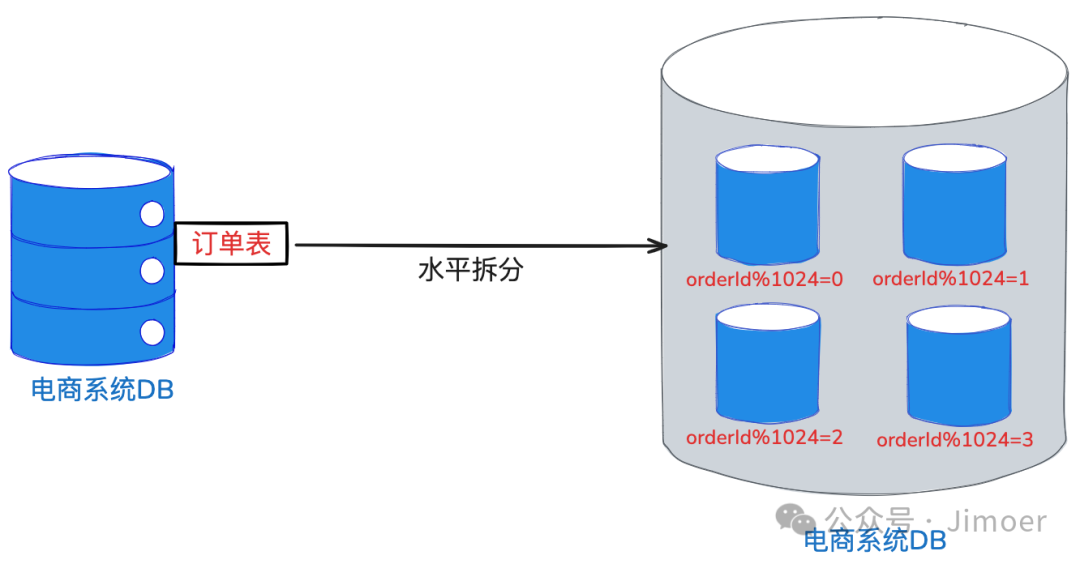

水平拆分

然而,垂直拆分解决不了单表数据量过大的问题。想象一下,订单表每年产生上亿条数据且持续增长。这时,索引优化、SQL调优都只是杯水车薪,必须上水平分库分表。目前业界落地首选是 ShardingSphere。

我们可以利用 Sharding-JDBC 配置分片键(如 order_id),然后通过一致性哈希等算法,将一张大表拆分成1024张小表,均匀分布在不同数据库节点上。这样一来,原本集中在单库单表的 I/O 压力就被彻底分散了。

一旦涉及分库分表,分布式事务就成了绕不开的难题。在单体架构中,一个简单的 @Transactional 注解就能搞定的事务,在跨库跨服务场景下变得异常复杂。如果能清晰地阐述解决方案,将是面试中的巨大加分项。

因为使用了ShardingSphere,可以结合数据库本身的 XA 协议,或者引入 Seata 这类分布式事务框架,采用其 AT 模式或 TCC 模式来解决跨库的事务一致性问题。

第二步:“缓”——削峰填谷,缓冲压力

服务和数据库的拆分主要解决了系统扩展性的问题。但如果面对瞬时流量爆发(如秒杀、618大促),数据库依然可能被瞬间击垮。这时,我们就需要第二招:缓冲。具体来说,就是通过前置的“挡”和有序的“削”,将洪峰流量转化为平稳的队列请求。

读流量处理:Redis缓存

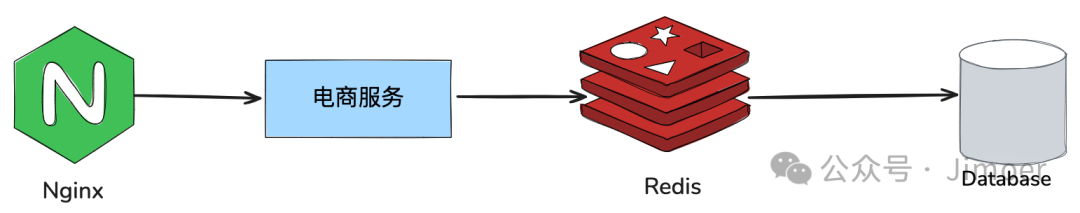

当读请求量巨大时(如秒杀查看库存),第一道缓存防线就是 Redis。其核心目标是拦截无效请求并快速返回热点数据。请求到达后,不是直接查询数据库,而是先查询 Redis。

例如秒杀场景,当库存为 0 时,直接在 Redis 层返回“已售罄”即可,数据库完全感知不到这部分请求压力。

一旦引入缓存,就必然会面临缓存相关的经典问题:缓存穿透、击穿和雪崩。

- 缓存穿透

- 问题:大量请求查询数据库中根本不存在的数据(如不存在的商品ID),导致请求穿透缓存,直接打击数据库。

- 解决方案:

- 缓存空值:对查询结果为

null 的数据也进行缓存,并设置一个较短的过期时间(如30秒)。

- 布隆过滤器:在查询缓存前,先用布隆过滤器判断数据是否存在,不存在则直接返回,避免对数据库的无效查询。

- 缓存击穿

- 问题:某个热点 key(如爆款商品)在缓存过期的瞬间,大量并发请求同时涌入,直接击穿缓存,打到数据库。

- 解决方案:

- 永不过期/延期:对极热点数据不设置过期时间,或每次访问后重置过期时间。

- 互斥锁:缓存失效时,不是所有线程都去查库,而是让其中一个线程去加载数据,其他线程等待,加载完成后释放锁。

- 缓存雪崩

- 问题:大量缓存 key 在同一时间失效,或整个缓存集群宕机,导致所有请求涌向数据库,造成数据库瞬时压力过大而崩溃。

- 解决方案:

- 随机过期时间:为缓存数据设置分散的、随机的过期时间,避免同时失效。

- 缓存集群与高可用:采用 Redis 哨兵或集群模式,确保部分节点宕机不影响整体服务。

- 服务降级:当缓存不可用时,启用降级策略,如返回兜底数据或直接限流,保护数据库。

写流量处理:消息队列缓冲

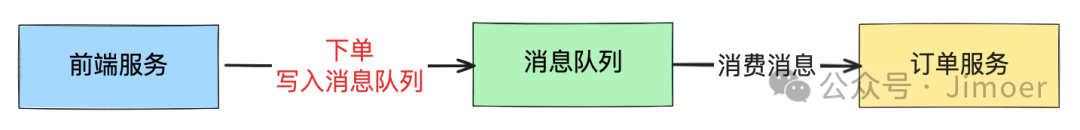

Redis 主要缓冲了读请求,但如果是海量的写请求(如瞬间大量下单)呢?直接写入数据库无疑会导致灾难。此时,就需要引入消息队列(MQ) 作为第二层缓冲。

引入 MQ 后,业务流程变为:用户下单请求到达后,系统并不直接处理订单,而是生成一条消息发送到 MQ 中,然后立即向用户返回“下单成功,正在处理中”的响应。这样,前端响应速度极快,用户体验良好。

后端的订单服务则按照自己的处理能力,匀速地从 MQ 中拉取消息进行消费。这就将一秒内十万笔的高并发下单,转化成了订单服务每秒处理一千笔的稳定流量,实现了完美的“削峰填谷”。

在实际技术选型上,通常推荐 Kafka 或 RocketMQ。Kafka 以其极高的吞吐量著称,更适合日志采集、流式数据处理等场景;而 RocketMQ 在金融、交易等对可靠性和事务性要求极高的场景中表现更佳,它原生支持事务消息,可靠性非常好。

谈到 MQ,面试官常会追问两个问题:如何保证消息不丢失?如何避免重复消费?

- 如何保证消息不丢失?

- 发送方:确保消息成功发送到 Broker(使用同步发送+确认机制)。

- Broker:依靠其自身的持久化机制(如刷盘策略)和多副本机制来保证数据不丢失。

- 消费方:采用“手动提交offset”的方式,确保业务逻辑处理成功后再提交消费进度。

- 如何避免重复消费?

- 发送方:做好幂等发送(如为消息附加唯一ID)。

- 消费方:实现业务幂等,这是根本。例如,利用 Redis 记录已处理消息的 ID,或在数据库层面通过唯一键约束来避免重复插入。

第三步:“防”——层层设防,丢卒保帅

“拆”和“缓”是主动的架构优化,而“防”则是被动的防御体系,用于应对超出系统设计容量的突发流量或内部故障。其核心思路是“层层设防,丢卒保帅”,在最坏的情况下保证核心业务不崩溃。

第一道防线:网关层

网关是流量的入口,可以在这里进行最粗粒度的防护。例如,利用 Nginx 的 limit_req 模块,针对 IP 维度进行限流,限制同一个 IP 每秒只能请求 5 次。这可以有效将恶意的爬虫、脚本攻击挡在门外,避免其消耗宝贵的后端资源。Nginx 作为反向代理和负载均衡器,是实现这层防护的理想组件。

第二道防线:应用层

当流量通过网关进入微服务体系内部后,就需要更精细化的防护手段。目前业界推荐使用阿里巴巴开源的 Sentinel,它比早期的 Hystrix 功能更强大,支持控制台可视化配置。在应用层,主要做三件事:限流、熔断、降级。

- 限流:为某个接口设置阈值,例如 QPS 超过 1000 则直接拒绝后续请求,防止服务被压垮。

- 熔断:当下游依赖服务(如支付服务)出现故障或响应过慢时,上游服务(如订单服务)应及时“熔断”对该服务的调用,快速失败并返回降级逻辑,防止线程池被占满引发雪崩效应。

- 降级:在大促等极端流量高峰期,主动关闭或简化一些非核心功能(如商品评价、个性化推荐),释放系统资源,全力保障核心交易链路(如下单、支付)的畅通。

限流模式(Sentinel示例)

使用 Sentinel 时,可以阐述两种常用的限流模式:

- 线程数模式:适用于处理耗时较长的接口。例如,设置秒杀接口最大并发线程数为 300,超出后直接返回“活动太火爆,请稍后再试”。

- QPS模式:适用于高频调用接口。例如,短信发送接口限制为 1000次/秒,使用令牌桶算法让请求匀速通过。

熔断机制(Sentinel示例)

Sentinel 将“统计窗口 + 三态熔断器(CLOSE、OPEN、HALF_OPEN)”设计成可插拔的处理器链。开发者只需定义受保护的资源和失败后的降级逻辑(fallback),其余的状态流转、阈值判断、超时恢复等均由框架自动完成,实现了业务“零侵入”的熔断保护。

终极防御:异地多活

对于金融、电商等核心业务,为了抵御城市级灾难(如大规模断电、光缆被挖断),还需要部署异地多活架构。

- 其典型设计是“三地五机房”,每个数据库至少有两个副本,通过 Paxos 或 Raft 协议保证数据一致性。

- 当某个城市的机房完全不可用时,系统能在数十秒内完成 Leader 重选和流量切换,目标是实现 RPO(恢复点目标)=0,RTO(恢复时间目标)< 30 秒。

复盘与总结

让我们用一张图来回顾整个高并发架构设计的核心思想:

构建高并发系统,本质上就是“拆、缓、防”三板斧的灵活运用:

- 拆:通过业务拆分、数据分片、集群化部署,将系统横向扩展到极致,解决扩展性问题。

- 缓:利用多级缓存(如Redis)和消息队列(如Kafka/RocketMQ),将瞬时流量洪峰削填成平滑的数据流,解决容量问题。

- 防:借助限流、熔断、降级以及异地多活等机制,在系统容量边界和异常情况下构筑坚固的防线,解决稳定性问题。

这三步环环相扣,层层递进,既体现了架构设计的系统性思维,也展现了在性能、成本、复杂度与可靠性之间寻求平衡的艺术。在实际落地时,并没有银弹,需要紧密结合自身业务特点、团队技术栈和运维能力,在“理想的架构”与“务实的交付”之间找到最佳平衡点。希望这篇系统性的梳理,能帮助你在云栈社区的交流与下一次技术挑战中,构建出更健壮、更可靠的高并发系统。