过去两年,我与不少企业技术负责人探讨过一个共同话题:“我们要不要 All in AI?”

但今天,我想提出一个更值得深思的问题:“我们的组织,真的准备好被 AI 放大了吗?”

AI 绝非普通的效率工具。它不同于 Excel,也并非一套 ERP 或 DevOps 平台。从本质上讲,AI 更像一个 “系统级放大器”。

- 如果企业自身结构稳固、流程清晰,AI 将带来指数级的效率提升。

- 如果企业内部本就存在系统性漏洞,AI 则会以同等指数级的速度放大这些风险。

许多企业存在这样的误解:认为接入一个大模型 API、构建几个智能 Agent、再接入自动化流程,便构成了所谓的“AI 战略”。

但现实往往残酷:在企业的基础治理尚未夯实之前,盲目引入 AI,无异于在高速行驶的汽车上强行加注氮气——速度固然快了,但刹车系统与车身结构并未同步升级,失控风险急剧攀升。

以下五个核心漏洞,若在上线前得不到妥善解决,AI 带来的将不是效率革命,而是一场加速的灾难。这也是为何在进行任何 AI 项目前,深入审视自身的流程治理体系至关重要。

第一大漏洞:流程没有结构化 —— AI 只会放大混乱

一、企业流程的真实状态

在许多企业内部,真实的运作流程往往是这样的:

- 关键决策依赖“经验丰富的人”的直觉与判断。

- 重要文档分散在邮箱、网盘、即时通讯工具等多个孤岛中。

- 工单系统沦为“走过场”的形式,关键信息流转依然靠线下沟通。

- 变更操作没有形成标准化的申请、评审、执行、回溯闭环。

- 审批流程高度依赖关键人物的即时响应和拍板。

表面上看,流程制度似乎存在。但实际上,这些流程是高度“人格化”和“潜规则化”的。而 AI 的运作逻辑是理解“结构”与“规则”,无法解读复杂的人际关系和隐性约定。

二、为什么 AI 必须依赖结构化流程?

AI 的核心工作模式可以简化为:输入 → 语境理解 → 概率预测 → 输出。

如果它所服务的流程本身缺乏清晰的定义,例如:

- 输入条件与格式模糊不清。

- 处理规则与判断标准无法量化。

- 输出结果的质量与格式要求不明确。

那么,AI 就无法在一个稳定的基础上运行。它唯一能做的,就是在信息不全的“迷雾”中进行概率“猜测”。一旦 AI 开始“猜”,整个组织就进入了不可控的状态。

三、典型灾难场景推演

假设你引入了一个高级的 AI Agent,赋予其职责:“自动分析需求并生成变更方案,随后执行上线操作。”

但如果企业存在以下问题:

- 没有标准化的变更申请模板。

- 缺乏对变更风险的量化分级体系。

- 缺少结构化的“影响范围”、“关联服务”等字段定义。

- 没有明确、可自动触发的回滚标准与预案。

结果会怎样?AI 生成的方案可能看起来逻辑完整、语言流畅、条理清晰,但由于缺乏真实业务风险规则的约束,它可能忽略某个关键依赖。最终,一次由 AI 发起的“完美”变更,可能导致核心生产服务中断。问题根源不在于 AI 不智能,而在于企业的流程本身不具备“机器可读性”。

四、正确顺序:流程工程先于 AI 工程

企业在上马 AI 之前,必须优先完成以下工作:

- 核心流程梳理:聚焦于变更、发布、财务审批、采购、客户服务等高频、高价值流程。

- 结构化字段定义:为每个流程环节明确需要采集和传递的信息字段。

- 标准化输入模板:设计机器易于解析的表单或数据接口。

- 明确审批路径与规则:将审批逻辑从“找谁批”变为“符合什么条件自动流转”。

- 构建明确的责任矩阵(RACI):清晰定义谁负责、谁批准、咨询谁、告知谁。

- 构建可追踪的全链路日志:确保每个环节的操作都有迹可循。

只有当流程本身变得“可计算”时,AI 才有了稳定、可靠的工作基础。否则,再强大的 AI 也只能充当一个高级的、但可能出错的文字生成器。

第二大漏洞:数据是脏的 —— AI 会成为幻觉放大器

一、数据问题比模型问题严重百倍

当前,许多企业的讨论焦点集中在:

- 该选用 GPT、Claude 还是国产大模型?

- 应该本地部署还是直接调用云 API?

- 是否有必要对模型进行微调?

然而,他们常常忽略了一个更为基础且致命的问题:你的数据干净、一致、可信吗?

现实情况往往不容乐观:

- 数据分散在 CRM、ERP、财务软件等多个独立系统中,难以打通。

- 同一业务指标(如“营收”),在不同部门的报表中存在口径差异。

- 大量数据依赖人工填报,存在误差和延迟。

- 关键历史数据缺失或记录不完整。

- 数据血缘关系模糊,无法追溯数据的来源和加工过程。

让 AI 在这样的数据环境中工作,会发生什么?它会基于错误或不一致的数据,“自信地”推导出一套逻辑自洽但完全偏离事实的结论。

二、为什么 AI 比传统 BI 更危险?

传统的商业智能(BI)报表如果出现计算错误或数据问题,通常比较容易被有经验的分析师发现,比如数字异常、趋势矛盾等。

但 AI 生成的报告不同,它的“错误”极具迷惑性:

- 语言极其流畅自然,读起来像资深专家的分析。

- 推理过程看起来逻辑合理,环环相扣。

- 表达充满自信,很少出现“可能”、“或许”等不确定性词汇。

这种特性使得人类决策者更容易不加批判地采信其结论,这就是所谓的“幻觉风险”,其危害远大于简单的数据错误。要构建可靠的 AI 应用,扎实的数据治理是基石。

三、真实企业风险场景

假设企业要求 AI 分析:“预测下一季度的现金流情况。”

但企业内部存在如下状况:

- 存在多套账务系统,数据未完全同步。

- 销售收入确认规则在线上线下业务中不一致。

- 市场营销成本在不同产品线间的分摊规则模糊不清。

AI 很可能基于这些混乱的数据,生成一份结构严谨、论述清晰的现金流预测报告。然而,由于输入数据的“根基”就是歪的,报告的核心结论必然是错误的。如果管理层依据这份报告做出重大的投资或收缩决策,后果可能是战略性的失误。

四、AI 上线前必须完成的数据工程

在引入 AI 进行决策支持前,企业至少需要完成以下数据基础建设:

- 主数据管理体系建设:统一客户、产品、供应商等核心实体的定义和编码。

- 指标口径标准化:在全公司范围内对齐关键业务指标的计算逻辑。

- 建立数据质量监控机制:对数据的完整性、准确性、一致性进行定期校验和告警。

- 实现数据血缘可追踪:能够清晰追溯每个数据字段的来源和变换过程。

- 明确数据权责归属:指定每个数据域的负责人,确保问题有人管。

否则,投入再多的 AI,也只会得到一个性能强大的“幻觉引擎”。

第三大漏洞:权限与审计体系缺失 —— Agent 会成为风险炸弹

一、从“建议工具”到“执行主体”的质变

当 AI 仅仅作为辅助人类生成文档、提供创意的工具时,其风险是相对可控的。

但当 AI 开始以 Agent 形态,拥有以下能力时,风险便指数级上升:

- 自动审批流程中的请求。

- 自动调用内部或外部 API 执行操作。

- 自动修改服务器、数据库等基础设施的配置。

- 自动创建或删除云资源。

二、核心问题:责任归属如何界定?

如果某个 AI Agent 执行了错误操作,例如:

- 误删了生产环境的核心数据库。

- 因逻辑错误持续扩容,导致云资源成本瞬间暴涨。

- 改错了防火墙策略,造成网络安全隐患。

- 在数据处理过程中意外泄露敏感信息。

责任应该由谁来承担?是开发 Agent 的工程师,是批准上线的主管,还是提供底层模型的厂商?如果没有事先建立的、清晰的权限模型和不可篡改的审计机制,企业将不仅面临业务损失,更会陷入法律与合规的泥潭。

三、三层安全架构模型(必须构建)

为确保 AI Agent 的安全可控,企业必须设计并实施以下三层防护架构:

1. Human-in-the-loop(人机回环)层

对于高风险的“关键操作”(如删除生产数据、大额支付审批),必须设置强制性的人工确认环节。AI 可以提出建议和方案,但最终执行指令必须由责任人手动触发。

2. 基于角色的最小权限层

为每个 AI Agent 分配严格遵循最小权限原则的身份和访问令牌。它只能访问其完成任务所必需的最少数据源和 API,禁止拥有泛化的、高等级的权限。

3. 全链路不可抵赖审计层

记录并安全存储 AI Agent 从任务开始到结束的完整决策链,确保所有行为可追溯。这包括:

- 接收到的原始输入指令(Prompt)。

- 模型推理过程中的关键中间步骤与思维链。

- 最终输出的决策结果或执行命令。

- 命令在实际系统中执行的详细日志与结果。

缺乏这套体系,所谓的智能 Agent 就是一个在权限黑盒中运行的、可能失控的自动化系统。这对于追求稳定性的运维/DevOps体系而言是不可接受的。

第四大漏洞:组织认知没有升级 —— AI 变成昂贵装饰品

一、技术升级 ≠ 组织能力升级

一个常见的现象是:很多企业轰轰烈烈地引入了 AI,组织了多轮培训,设立了多个试点项目,但半年或一年后复盘,发现整体的业务效率、决策质量并未发生显著提升。

根本原因在于:组织的决策模型和协同方式没有因为 AI 的引入而发生根本性改变。 AI 只是被“嵌入”到了旧有的工作流中,甚至被旧流程同化。

二、AI 时代所需的认知结构变化

- 传统企业模式:人直接控制和管理具体的业务流程与操作。

- AI 时代模式:人的角色转变为“训练、指导和监督 AI 模型”,由模型来驱动或优化流程。

这意味着组织内不同层级的人员都需要进行认知升级:

- 管理层:必须理解不同 AI 模型的能力边界、局限性和潜在风险,学会基于 AI 提供的分析做“二阶判断”。

- 中层管理者:需要从单纯的任务分配者,转型为会利用 AI 工具进行业务分析、流程诊断和团队赋能的“增强型管理者”。

- 一线员工:其价值不再仅仅是执行重复性操作,而应升级为“判断型角色”,负责对 AI 的产出进行质量审核、情境化修正和最终决策。

如果认知不升级,组织结构这只“无形的手”会默默消化、排斥 AI 带来的变化,最终让它沦为展示技术实力的“装饰品”。

三、KPI 与考核体系不变,行为就不会变

如果企业的绩效考核指标(KPI)仍然主要围绕:

- 员工的工作时长。

- 手动处理工单的数量。

- 表面上的文档产出量。

那么,员工天然缺乏动力去真正拥抱和深度使用 AI。因为使用 AI 提高效率后,反而可能让自己显得“工作量不饱和”。于是,员工可能采取的策略是:

- 表面上使用 AI,实际核心工作仍用老办法。

- 回避需要与 AI 协同的新流程,觉得“更麻烦”。

- 甚至刻意隐藏自己利用 AI 提升效率的方法,以防 KPI 标准被提高。

因此,组织的激励机制和成功标准必须与 AI 转型的目标对齐,否则一切技术投入都可能事倍功半。

第五大漏洞:没有成本模型 —— AI 会成为财务黑洞

一、AI 的真实成本远超 API 调用费

企业部署和应用 AI 的全生命周期成本构成复杂,主要包括:

- 直接成本:大模型 API 调用费用、推理算力成本(GPU/TPU)、向量数据库等数据存储与检索成本、模型微调训练成本。

- 间接与隐性成本:为适配 AI 而进行的现有系统重构工程成本、为满足数据安全和行业合规所产生的额外研发与审计成本、持续的提示工程与模型维护人力成本。

很多企业在预算时,仅仅计算了“每百万 Token 的单价”,这严重低估了总拥有成本。

二、AI 成本的“不可见性”风险

与传统服务器“每月固定租金”的模式不同,AI 成本具有高度动态性和不可预测性:

- 随业务量的波动,API 调用次数会剧烈变化。

- 提示词(Prompt)的长度、复杂度直接影响 Token 消耗。

- 为提升准确性而增加的上下文长度,会成倍增加单次请求成本。

- 模型版本的快速迭代,可能导致单价和效能变化。

如果没有建立细粒度的观测体系,AI 成本就像一条暗河,在不知不觉中侵蚀企业的利润。

三、企业必须构建 AI FinOps 模型

将财务运营(FinOps)理念应用于 AI 领域至关重要,企业需要建立:

- Token 消耗可观测化:能够将每一笔 API 调用成本关联到具体的业务部门、项目乃至个人用户。

- 成本归因与分析:清晰了解成本最高的业务场景、模型和提示词模式是什么。

- 单任务成本核算:能够计算完成一次智能客服、生成一份报告的平均成本,用于 ROI 评估。

- 投资回报率评估框架:建立衡量 AI 项目业务价值(如提升的客户满意度、节省的人力工时)的量化方法。

- 成本预警与优化机制:设置成本阈值告警,并持续优化提示词、缓存策略等以降低成本。

缺乏这套模型,AI 很可能变成一个无法关闭、且账单持续增长的“财务黑洞”。

企业 AI 上线成熟度模型

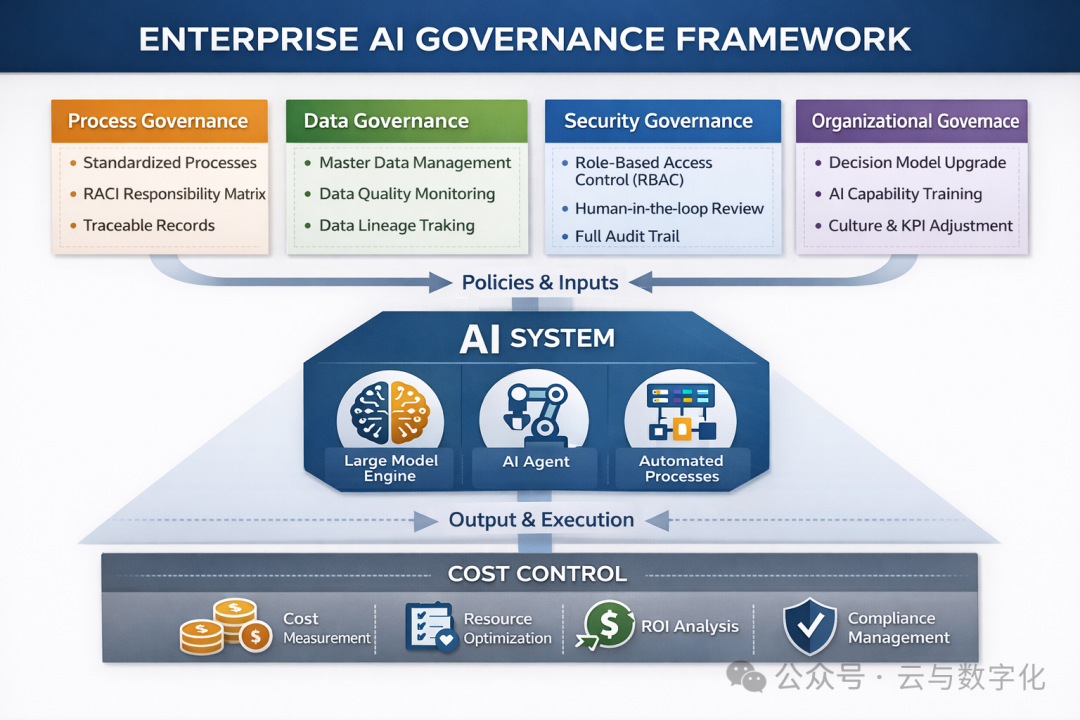

一个真正准备好迎接 AI 的企业,应该初步具备以下特征,构成一个稳固的基座:

- 流程可计算:核心业务流程已完成结构化、标准化改造。

- 数据可信:拥有干净、一致、可追溯的高质量数据供给。

- 权限可控:建立了适应 AI Agent 的精细化权限模型与全链路审计能力。

- 组织适配:团队认知、决策模式及 KPI 体系已向人机协同方向调整。

- 成本透明:具备监控、分析和优化 AI 使用成本的能力。

只有当这五个支柱同时稳固,AI 的引入才会成为企业增长的“乘数因子”,而非混乱的“加速器”。

最终结论:AI 不是单纯的技术选型问题,而是系统工程

因此,制定 AI 战略的核心,不应始于“我们该买哪个模型?”,而应始于对以下五大基础工程的审视与建设:

- 流程工程

- 数据工程

- 安全与权限工程

- 组织与人才工程

- 成本与价值工程

模型的选择、调优与 Agent 开发,只是漂浮在这五大基础工程之上的最后 10%。如果前面 90% 的基础不牢,那么在这之上建造的任何 AI 应用,都难以创造可持续的商业价值,反而会以极高的效率,放大企业原有的所有漏洞与风险。

一句值得所有决策者反复思考的话:AI 不会替代一个混乱的组织,它更可能做的是,以远超人类的速度,加速其暴露出问题直至难以为继。

在踏上 AI 转型之路前,恳请先为你的企业做一次全面的“系统体检”。真正的效率革命,源于稳固基础之上的智能增强,而非在流沙之上建造高楼。在云栈社区,我们持续关注并分享关于AI治理、数据工程与系统架构的深度实践,欢迎一起探讨如何稳健地迈出智能化的每一步。