在物理服务器Linux运维中,网络稳定性至关重要,网卡绑定(NIC Bonding)技术是提升网络可靠性的核心解决方案。该技术通过将多块物理网卡虚拟为一块逻辑网卡,实现负载均衡或故障冗余,确保业务连续性。

本文以Debian系统为例,演示主备模式(active-backup)的配置过程。其核心逻辑同样适用于CentOS、Ubuntu等主流Linux发行版。

一、网卡绑定原理简介

Linux内核通过bonding驱动实现网卡绑定,其核心是将多块物理网卡(slave)聚合到一个虚拟绑定设备(master)。不同绑定模式对交换机有不同要求,以下是常见模式及其适用场景:

实验环境说明:普通交换机通常仅支持模式1(主备模式),无需特殊配置即可完成演示。模式0、2、3、4等需配合支持链路聚合(如LACP)的智能交换机。因实验硬件限制,下文将重点实操主备模式。

二、环境准备:确认硬件与系统

确保拥有一台多网口Debian主机(本文使用4网口迷你主机)和一台普通交换机(无需配置)。首先检查系统环境:

-

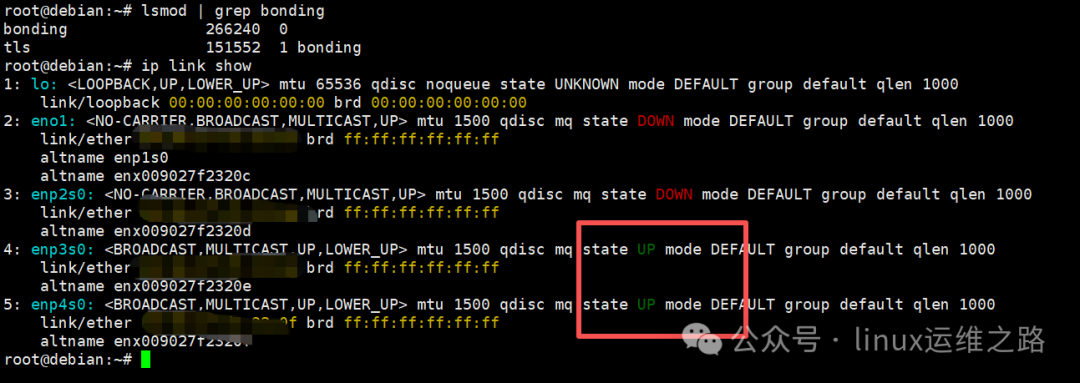

验证bonding驱动:

# 检查bonding驱动是否加载

lsmod | grep bonding

# 若未加载,手动加载(临时生效)

modprobe bonding

# 查看所有网卡状态

ip link show

如上图所示,网卡状态应为UP(例如enp3s0、enp4s0),且lsmod输出中包含bonding模块信息。

-

清理已有网络配置(如之前使用NetworkManager配置了固定IP,需禁用以避免冲突):

- 使用

nmtui工具,选择对应网卡,将IPv4配置设为“Disabled”。

- 或直接通过

nmcli命令修改。

三、实操配置:使用nmcli配置主备绑定

本文通过nmcli命令行工具配置,该方式稳定可靠,适用于远程或本地操作。

-

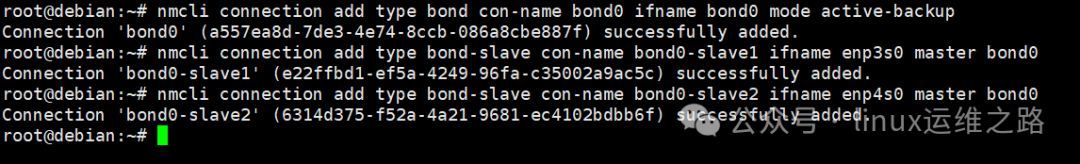

创建bonding主设备及从设备(将enp3s0和enp4s0替换为实际网卡名):

# 创建bond0设备,模式设为active-backup(主备)

nmcli connection add type bond con-name bond0 ifname bond0 mode active-backup

# 添加两个从属网卡到bond0

nmcli connection add type bond-slave con-name bond0-slave1 ifname enp3s0 master bond0

nmcli connection add type bond-slave con-name bond0-slave2 ifname enp4s0 master bond0

-

启用bonding设备(注意:此操作可能导致当前SSH连接中断,建议在本地控制台操作或提前配置静态IP):

nmcli connection up bond0-slave1

nmcli connection up bond0-slave2

nmcli connection up bond0

可选:配置静态IP(若需固定地址,请在启用前设置):

nmcli connection modify bond0 ipv4.addresses 192.168.100.xx/24

nmcli connection modify bond0 ipv4.gateway 192.168.x.x

nmcli connection modify bond0 ipv4.dns "8.8.8.8,114.114.114.114"

nmcli connection modify bond0 ipv4.method manual

四、验证与故障模拟

-

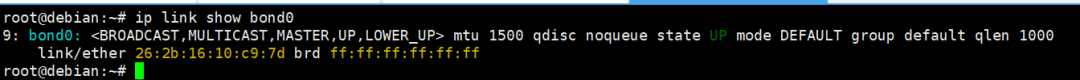

查看绑定设备状态:

ip link show bond0

cat /proc/net/bonding/bond0

正常情况下,/proc/net/bonding/bond0输出中会显示“Active Slave: enp3s0”,表示enp3s0为主网卡,enp4s0处于备用状态。

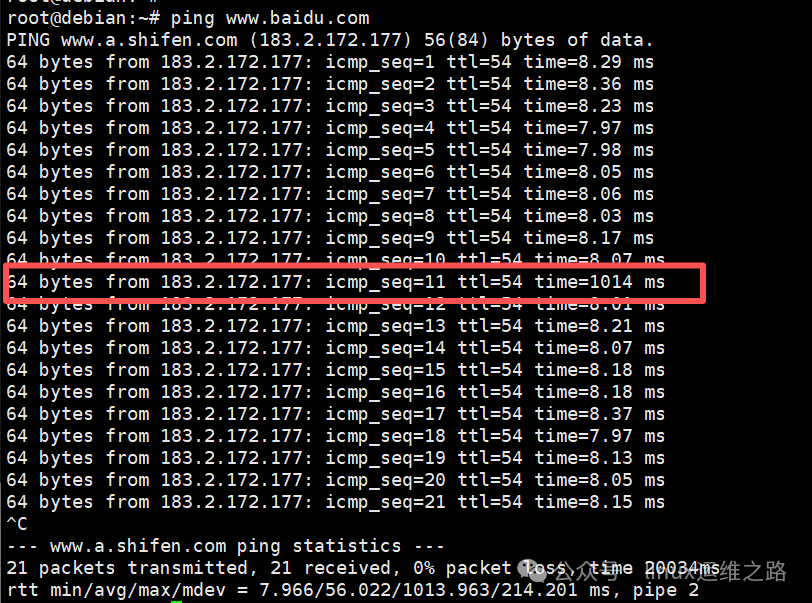

-

模拟网卡故障:

五、删除绑定配置

若需还原,可删除bonding连接(注意:删除后需重新配置原网卡连接):

nmcli connection delete bond0

通过以上步骤,我们实现了Debian系统下双网卡主备绑定。这种配置能有效提升网络系统的冗余能力,为关键业务提供基础的高可用保障。在生产环境中,可根据实际需求选择更高级的绑定模式,并搭配智能交换机发挥最大效能。 |