在Rust并发编程的世界里,性能优化是一个绕不开的核心议题。

最初,当我的一个批处理任务耗时800毫秒时,我并未过分担忧。毕竟不到一秒,用户似乎难以察觉。然而,当该任务在生产环境中被高频调用时,累积的延迟开始显现:用户抱怨系统迟缓,上级追问优化可能。面对自己编写的“精心”多线程代码,我不得不重新审视。

问题代码:典型的“教科书式”实现

以下是我最初采用的标准多线程实现,其思路是将数据分块,为每块数据创建一个线程进行处理:

use std::thread;

fn process_data(v: &Vec<i32>) -> i32 {

v.iter().map(|x| x * 2).sum()

}

fn main() {

let data: Vec<i32> = (0..1_000_000).collect();

let chunks: Vec<&[i32]> = data.chunks(250_000).collect();

let mut handles = vec![];

for chunk in chunks {

handles.push(thread::spawn(move || {

process_data(&chunk.to_vec())

}));

}

let mut total = 0;

for h in handles {

total += h.join().unwrap();

}

println!("Result: {}", total);

}

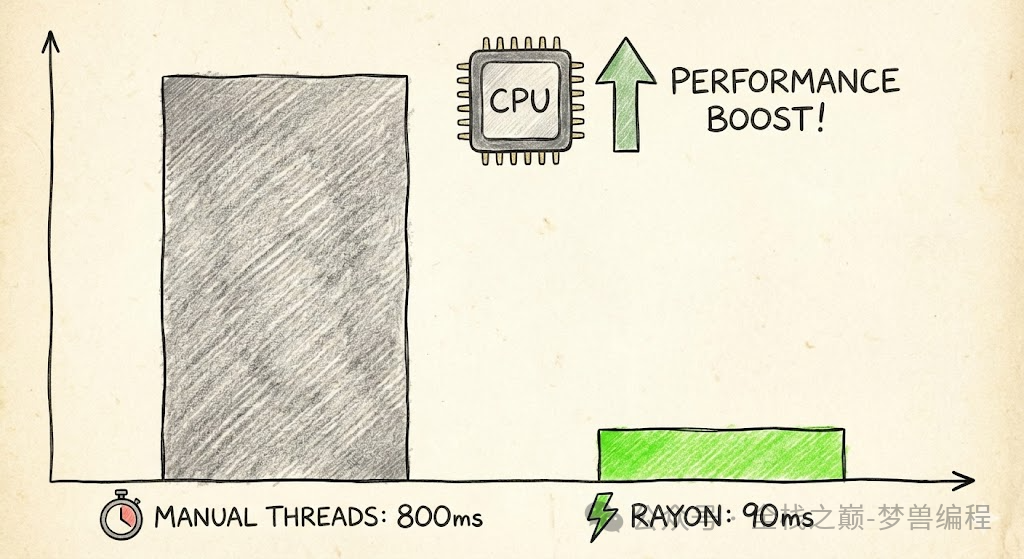

这段代码逻辑清晰:将100万个整数的数据均分为4块,创建4个线程并行计算,最后汇总结果。它看似遵循了 分而治之 的经典算法思想。然而,基准测试结果却令人失望:800毫秒 ± 10毫秒,远未达到预期的线性加速。

性能瓶颈分析

经过分析,主要问题集中在三点:

- 线程创建开销:每次执行任务都需创建和销毁操作系统线程,成本高昂。

- 上下文切换成本:操作系统在多个线程间切换需要保存和恢复状态,消耗额外时间。

- 不必要的数据拷贝:

chunk.to_vec() 导致每个线程都拥有一份数据的完整拷贝,严重消耗内存带宽。

这些源自系统底层的开销,吞噬了并行计算带来的潜在收益。

Rayon 解决方案:简洁与高效的统一

在同事推荐下,我尝试使用了Rust生态中广受欢迎的并行计算库Rayon。改造后的代码令人惊讶地简洁:

use rayon::prelude::*;

fn main() {

let data: Vec<i32> = (0..1_000_000).collect();

let total: i32 = data.par_iter()

.map(|x| x * 2)

.sum();

println!("Result: {}", total);

}

仅需将普通的 .iter() 替换为 .par_iter(),基准测试结果骤降至 90毫秒 ± 5毫秒,性能提升近9倍,代码量却减少了一半以上。

Rayon 的核心魔法:工作窃取调度器

Rayon的性能并非来自魔法,而是其高效的工作窃取调度器(Work-Stealing Scheduler)。与传统静态分片不同,Rayon维护一个全局任务池和线程池。当某个线程提前完成自己的任务后,不会空闲等待,而是会从其他忙碌线程的任务队列中“窃取”一部分任务来执行。

这种动态的负载均衡机制,确保了所有CPU核心都能持续满载工作,避免了因任务划分不均导致的线程空闲,这正是其高效并发的秘诀。

Rayon 适用场景与注意事项

虽然Rayon强大,但并非银弹,需根据场景判断:

适合使用 Rayon 的场景:

- 数据量足够大:通常至少数万条记录,足以分摊并行调度的开销。

- 计算密集型任务:任务是CPU Bound的,例如数值计算、图像处理等。

- 任务间无依赖:每个数据项的处理相互独立。

可能不适用 Rayon 的场景:

- 数据量很小:并行调度开销可能超过串行执行时间。

- IO密集型任务:任务大量时间在等待IO(磁盘、网络),线程可能阻塞。

- 任务间存在复杂依赖:需要严格的执行顺序或频繁的同步通信。

最终性能对比

| 实现方式 |

平均耗时 (ms) |

性能提升倍数 |

| 手动线程管理 (原始方案) |

800 |

1x |

| 使用 Rayon 并行迭代器 |

90 |

~8.9x |

总结

本次优化经历的核心启示在于:有时,最有效的优化并非微调代码细节,而是选择正确的工具和抽象。Rayon库封装了线程池管理、工作窃取、负载均衡等复杂细节,为Rust开发者提供了近乎零成本的高层并行抽象。

对于需要在Rust中进行数据并行处理的场景,Rayon通常是首选方案。其par_iter、par_chunks等API能让开发者以极小的改动代价,获得显著的性能提升。当然,遵循性能优化的黄金法则始终重要:先测量,再优化,通过基准测试来验证优化效果。 |