Google 发布 Android XR SDK Developer Preview 3,面向 AI 眼镜应用开发带来两项新库:Jetpack Projected 与 Jetpack Compose Glimmer。同时,ARCore for Jetpack XR 也扩展到支持 AI 眼镜场景,补齐运动追踪与地理空间能力。

新增两大 Jetpack 库:把手机应用“延伸”到 AI 眼镜

在 Preview 3 中,这两项能力的目标很明确:让开发者在不推倒重来的前提下,把现有移动应用扩展到 AI 眼镜上,利用眼镜的 扬声器、摄像头、麦克风,并在设备具备显示能力时,将信息呈现在镜片显示区域。

一些典型场景包括:视频会议应用增加一个 UI 控件,让用户将视频源从手机摄像头切换到眼镜摄像头,从而提供第一视角画面。

Jetpack Projected:从主机设备“投射”XR体验到眼镜

Jetpack Projected 允许以 Android 手机等“主机设备”为载体,将应用的 XR 体验通过 音频和/或视频 投射到 AI 眼镜。

它提供了几类关键能力:

- 检测目标设备是否有显示屏,并在显示可用时再使用

- 运行时权限申请:在访问设备硬件之前,需要遵循 Android 的标准权限模型进行运行时请求(例如相机、麦克风等权限),以符合系统安全策略

在硬件接入上,文章强调了两点:

- 只要获取到有效的 projected context,你既可以在 AI 眼镜专用 Activity 中访问硬件,也可以从标准应用(如手机端 Activity/Service)访问

- 音频相对简单:AI 眼镜音频设备的行为与标准 Bluetooth 音频设备类似

相机采集:更复杂的生命周期与可用性处理

相比音频,调用眼镜摄像头进行拍照/录像要复杂一些,通常需要:

- 实例化多种组件来检查硬件可用性

- 完成相机初始化与绑定

- 将 Activity 生命周期与相机打开/关闭绑定,确保在不同状态下正确释放资源

Jetpack Compose Glimmer:面向光学透视的眼镜 UI 组件体系

Jetpack Compose Glimmer 提供了一套 UI 组件与视觉语言,用于在“具备显示能力”的 AI 眼镜上构建增强信息呈现体验。

它的视觉语言基于 optical see-through(光学透视),强调:

支持的组件包括:文本、图标、标题标签(title chips)、卡片、列表、按钮等。组件建立在 surface 的基础概念上,开发者也可以直接使用 surface 来实现非标准组件。

组件定制与深度感

Glimmer 组件可通过 modifier 调整布局、外观与交互行为;同时支持沿 z 轴叠放,通过阴影等效果营造深度感。

Android Studio:新增 AI 眼镜模拟器,支持预览与交互模拟

Google 还在 Android Studio 中加入 AI 眼镜模拟器,用于:

- UI 预览(快速迭代 Glimmer 的布局与视觉)

- 模拟用户交互(包括触控板与语音输入)

这类工具对端到端调试尤其有价值:开发者可以在硬件尚未到手或团队共享设备有限时,先完成大部分 UI 与交互验证。

ARCore for Jetpack XR:支持 AI 眼镜的运动追踪与地理空间定位

随着 Preview 3 更新,ARCore for Jetpack XR(用于构建增强体验的一组 API)扩展到了 AI 眼镜使用场景,能力包括但不限于:

- 获取平面数据

- 将内容锚定到空间中的固定位置

- 新增 motion tracking:让眼镜对用户运动做出响应

- 新增 geospatial pose:允许将内容锚定到 Google Street View 覆盖的地理位置

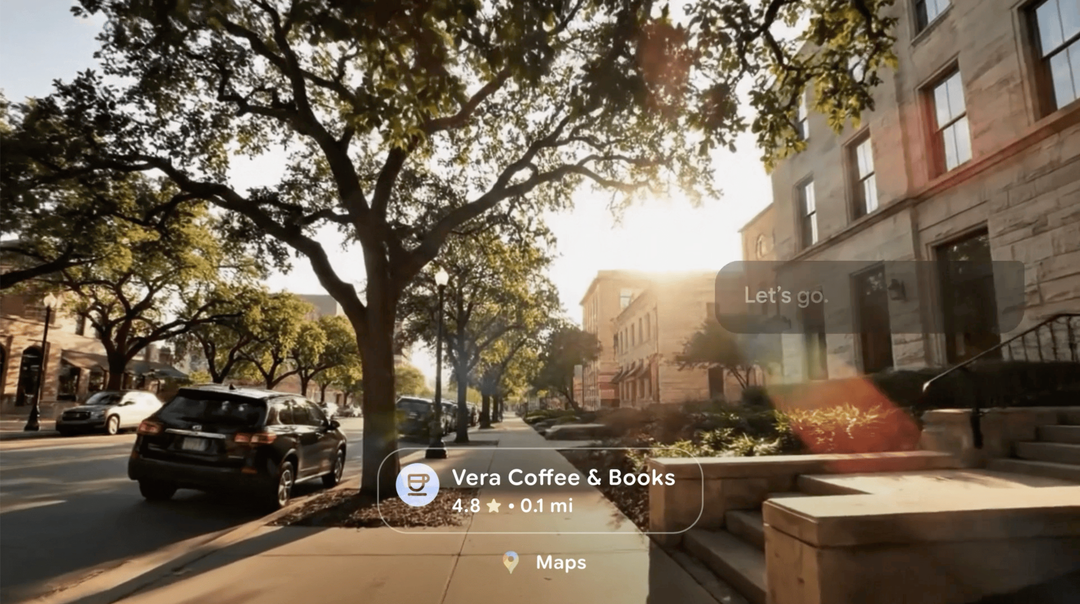

与 AI 眼镜结合后,这些能力可以支撑“在真实世界中稳定贴合”的信息层,例如导航提示、定位标注、空间化指引等,进一步推动面向人工智能的可穿戴交互体验落地。

获取方式与版本要求

Android XR SDK Developer Preview 3 已在 Android Studio Canary 中提供。文章提到需要将模拟器升级到 36.4.3 Canary 或更高版本。

若你正在做移动端到眼镜端的能力延伸,建议同时关注 Android 端工程体系与权限/硬件接入实践,可参考Android相关开发资料,完善从应用到设备的端侧适配流程。

|