上个月,我花费了三天时间优化一个数据可视化项目,当时5万个数据点就让页面渲染卡顿如幻灯片。我已经尝试用Rust重写了核心逻辑并编译为WebAssembly,获得了40%的性能提升,内心一度感到满足。

然而,出于一种“穷尽所有可能”的心态,我决定用WebGPU重构整个渲染循环。

结果令人震惊:性能提升了整整23倍。经过反复验证确认数据无误后,我不禁开始反思,过去几个月我们是否在追逐一个错误的方向。

我们常常陷入一种自我安慰的误区,认为CPU性能是Web应用的主要瓶颈。因此,社区热衷于优化JavaScript,使用TypeScript提升代码质量,甚至在极端情况下祭出WebAssembly来压榨CPU的每一个运算周期。

但仔细想想,我们设备中那块拥有每秒万亿次计算能力的GPU,绝大多数时间仅仅被用于渲染界面圆角和阴影。对于图像处理、物理模拟、机器学习推理及数据转换等计算密集型任务,GPU的并行能力本应比CPU强大数百倍。WebGPU的出现,终于让我们能在浏览器中直接驾驭这股力量。

WebGPU:浏览器中的通用GPU计算引擎

WebGPU是由W3C标准化的现代图形与计算API,它允许JavaScript直接访问GPU进行高性能并行计算。与专注于图形渲染的WebGL不同,WebGPU在设计之初就同等重视通用计算(GPGPU),能够带来10至100倍的性能跃升。

其核心优势包括:

- 大规模并行:直接调用GPU的数千个计算核心。

- 通用计算支持:不仅限于图形渲染,适用于各种并行计算问题。

- 现代API设计:更接近Vulkan、Metal、DirectX 12等原生图形API。

- 广泛的浏览器支持:已在Chrome、Safari、Edge及Firefox(需启用实验标志)中实现。

代码对比:从串行CPU到并行GPU的思维转变

传统CPU(或WebAssembly)处理方式:

// CPU顺序处理 - 通常只能利用有限的核心

function processData(input) {

const output = new Float32Array(input.length);

for (let i = 0; i < input.length; i++) {

output[i] = Math.min(Math.max(input[i] * 2 + 10, 0), 100);

}

return output;

}

WebGPU并行处理方式(使用WGSL着色器):

@group(0) @binding(0) var<storage, read> input: array<f32>;

@group(0) @binding(1) var<storage, read_write> output: array<f32>;

@compute @workgroup_size(64)

fn main(@builtin(global_invocation_id) id: vec3<u32>) {

let i = id.x;

output[i] = clamp(input[i] * 2.0 + 10.0, 0.0, 100.0);

}

WebGPU与WebAssembly核心能力对比

| 特性 |

WebGPU |

WebAssembly |

| 计算单元 |

GPU(数千核心) |

CPU(8-16核心) |

| 并行能力 |

大规模并行 |

有限并行(依赖多线程) |

| 典型性能提升 |

10-100倍 |

2-3倍 |

| 最佳适用场景 |

数据处理、图像处理、模拟计算 |

复杂算法、原生代码移植、安全沙箱 |

| 学习曲线 |

中等 |

较低 |

| 浏览器支持 |

Chrome, Safari, Edge, Firefox(实验性) |

全主流浏览器 |

WebGPU三大核心应用场景解析

1. 大规模数据可视化与客户端数据处理

处理数万至数百万数据点的实时渲染与分析。例如,在一个物联网仪表盘项目中,原本需要后端聚合的2GB传感器时序数据,通过将聚合与过滤逻辑移至WebGPU着色器执行,实现了在客户端50毫秒内完成响应。这不仅提升了用户体验,还将后端数据处理成本降低了60%。对于复杂的前端可视化需求,结合现代化的前端框架与工程化工具链,可以构建出性能卓越的数据驱动应用。

2. 实时图像处理与浏览器端AI推理

超越简单的滤镜应用,深入专业领域:

- 医学影像分析:CT、MRI图像的实时处理与增强。

- 工业质量检测:实现基于浏览器摄像头的实时缺陷检测,替代昂贵的云端ML API,达到零延迟、零API费用。

- 卫星遥感数据处理:实时分析与渲染。

- 本地AI模型推理:为TensorFlow.js、ONNX Runtime Web等框架提供底层GPU加速。

3. 物理模拟与高性能计算

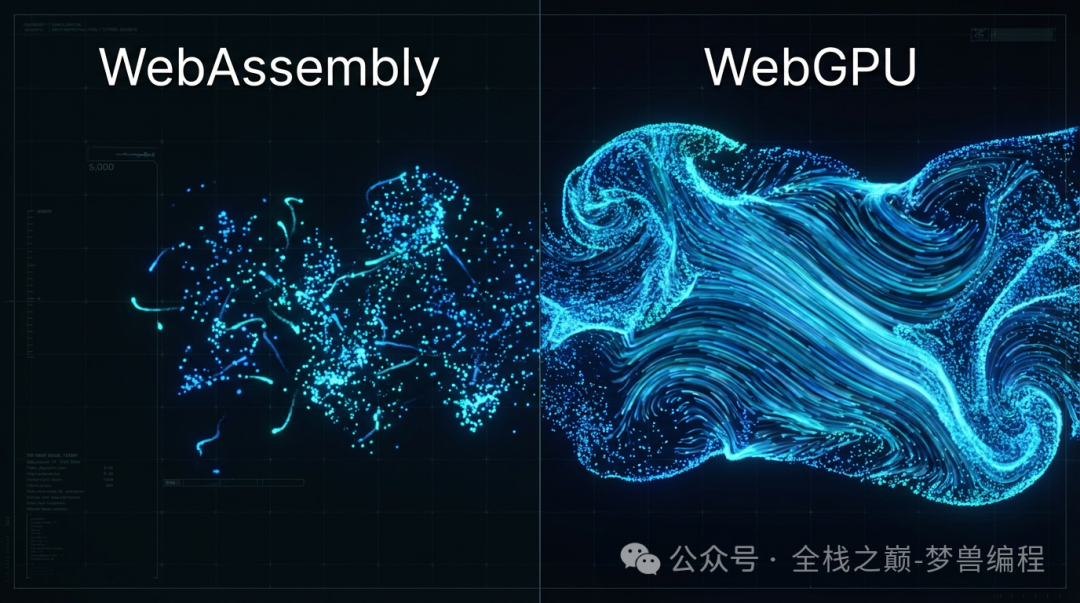

- 流体动力学模拟:如图中所示,WebGPU可流畅模拟50万粒子,而WebAssembly版本在5000粒子时已出现严重卡顿。

- 复杂粒子系统:用于游戏或特效的烟雾、火焰、水流模拟。

- 加密计算:大规模哈希计算、加密解密等操作。

其规律十分明确:任何涉及对大型数据集进行相同或相似独立操作(即“令人尴尬的并行”问题)的任务,都能获得指数级的加速。

重新审视性能优化路径

WebAssembly是一项重要技术,它让C++/Rust等代码能在浏览器中以接近原生的速度运行,对于CPU密集型算法和代码移植意义重大。但它本质上仍受限于CPU的核心数量(通常为8-16个)。而GPU则提供了数千个计算核心的并行能力。

这并不是说WebAssembly无用,而是我们需要认识到,“Web性能的未来”不能仅停留在CPU优化。WebGPU带来的是数量级的不同,它正在让许多过去被认为“必须在后端或原生端实现”的任务,在浏览器中成为可能。

学习曲线与实战路径

WebGPU的API确实更为底层和详细,需要理解缓冲区、绑定组、管线状态等概念。调试WGSL着色器也不同于普通的JavaScript。但这种复杂性换来了对GPU内存和执行的精确控制,这正是其高性能的源泉。

入门建议路径:

- 基础准备:了解GPU并行计算原理与基本的线性代数。

- 核心概念:学习设备初始化、缓冲区管理、WGSL语言基础及管线配置。

- 实战进阶:从简单的数组变换开始,逐步尝试图像滤镜、粒子系统,最终挑战大规模数据可视化项目。

何时应考虑采用WebGPU?

适用场景:

- 需要实时处理万级以上数据点的可视化。

- 对图像或视频流进行实时处理与分析。

- 运行复杂的物理模拟或粒子系统。

- 需要在浏览器中执行机器学习模型推理。

- 涉及大量并行的加密计算操作。

暂不必要场景:

- 简单的CRUD应用或内容展示网站。

- 基础的表单处理与验证。

- 小型UI动画效果。

总结

WebGPU并非银弹,但对于处理海量数据、进行复杂计算渲染的应用而言,它代表着一次范式转移。它要求我们从“如何优化顺序执行”的思维,转向“如何设计并行计算任务”。

工具生态正在快速成熟,Three.js、Babylon.js等主流图形库已提供WebGPU支持。浏览器支持也已就绪。真正的挑战和机遇在于思维层面的转变:将GPU视作每台设备中触手可及的大规模并行计算引擎,而不仅仅是图形渲染器。

WebAssembly在CPU优化领域仍具价值,但如果你正在探索性能边界,WebGPU所提供的可能性是下一个必须关注的维度。毕竟,下一代Web应用很可能会实现我们今天在浏览器中认为不可能的任务。

如果你的应用场景更侧重于服务器端或需要与后端架构深度整合的CPU密集型并行计算,例如利用多线程处理大量请求,也可以了解像Rust Rayon这样的后端与架构优化方案,它们共同构成了现代高性能计算的工具箱。