随着人工智能技术的成熟,构建一个能够全流程自动化生产内容的系统已成为可能。本文将以一个实际开发的AI新闻写作智能体为例,详细介绍其系统架构与技术实现,涵盖从数据抓取、智能筛选、内容生成到自动化发布的完整链路。

AI新闻写作智能体架构总览

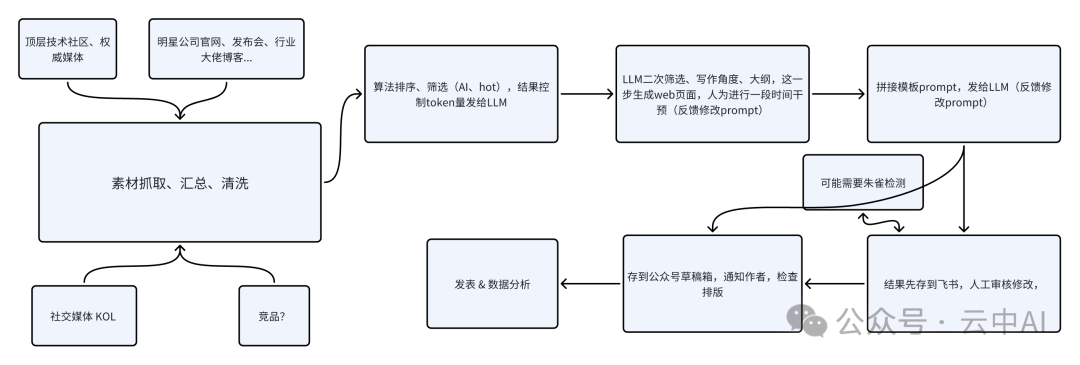

整个系统的核心目标,是实现内容生产工作流的全自动化。其整体架构如下图所示:

该流程模拟了传统编辑从选题到发布的核心工作环节,旨在通过代码与人工智能技术的结合,将人工耗时数小时的工作压缩至几分钟内完成,实现降本增效。对于需要维护多个账号或进行规模化内容运营的团队而言,其价值尤为显著。

核心模块实现细节

1. 数据采集与爬虫适配

系统的起点是多个新闻源的数据采集。这部分是实现自动化的基础,也是典型的“脏活累活”。针对不同信源,需要采取不同的策略:有开放API的优先分析其接口;没有API的则寻找或改造现有的爬虫工具;对于API受限或收费的平台(如Twitter),则需要自行开发解决方案,例如采用基于WebDriver的自动化工具来模拟浏览器操作进行数据抓取。

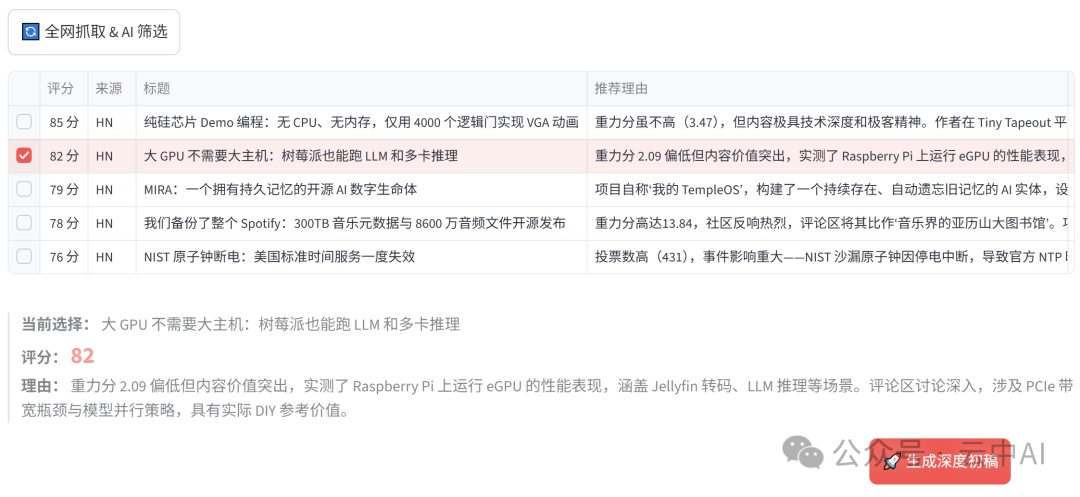

2. 智能选题与内容筛选

在抓取到原始信息后,系统采用两层筛选机制来确定写作主题。首先,通过一套预设的规则算法进行初筛,过滤掉无关或低质量的信息。其次,引入大语言模型(LLM)对候选选题进行深度分析和打分。这里需要结合垂直领域的专业知识,为LLM设定包括时效性、话题热度、受众兴趣等多维度的评估标准,以确保选题质量。

3. 基于LLM的内容生成与风格控制

这是系统的核心创作环节。要引导LLM产出符合特定风格和质量的文章,主要依赖两种手段:调整上下文(Prompt工程与RAG检索增强生成)与调整模型参数(微调)。实践中,大部分工作集中于前者。这需要收集并清洗大量目标风格的文章作为样本,用于提炼写作模板、构建专业知识库,并通过精心设计的Prompt来约束LLM的输出。为了应对平台可能的AI内容检测,还探索了通过微调模型来增加文本“困惑度”(Perplexity)等技术手段,以提升内容的“人类感”。

4. 工作流自动化与发布

生成初稿后,系统会将其自动上传至飞书文档,便于人工进行最终的审核与精修。修改后的版本可以回写覆盖原文。随后,系统自动将定稿文章发布至目标平台(如微信公众号后台),完成闭环。整个Python驱动的流程极大地减少了人工在平台间切换、复制粘贴等重复性操作。

5. 数据反馈与算法优化(持续迭代)

系统在文章发布后,会持续监控阅读量、互动率等数据指标。这些数据将作为反馈信号,用于优化前述的选题算法、内容生成模型等环节,形成一个能够自我学习、持续改进的智能系统,目标是不断产出更符合读者偏好、流量表现更佳的内容。

开发初衷与思考

构建这样一套系统的初衷,远不止于内容自动化生产本身。它更是一个关于“人机协作”和“未来工作模式”的探索。当AI在某些创作任务上已经展现出强大能力时,内容工作者或开发者的价值应当重新定位——从重复的执行中解放出来,转向更高阶的策略制定、创意构思与情感注入。通过技术手段将流程标准化、自动化,正是为了给人留出更多进行深度思考与创造性工作的空间。

该系统整合了数据爬虫、智能算法与自动化工作流技术,展示了如何将前沿的AI能力落地到具体的业务场景中,为内容创作领域的高效运营提供了一种可行的技术解决方案。 |