做过 AI 基础设施的朋友都知道,部署多模态应用简直是运维的噩梦。

以前,如果你要搭建一个既能听(Whisper)、又能看(ViT)、还能聊(LLaMA)的系统,你得维护三套完全不同的推理栈。显存被切得七零八落,API 接口五花八门,监控面板更是乱成一团。

最近,vLLM 项目推出了官方扩展分支 vLLM-Omni,试图终结这种“碎片化”现状。今天我们站在架构师的角度,聊聊它是如何把这些模态“统一步伐”的。

为什么我们需要 vLLM-Omni?

在 人工智能与云原生 技术栈快速演进的今天,多模态模型(Multimodal Models)正在成为标配。

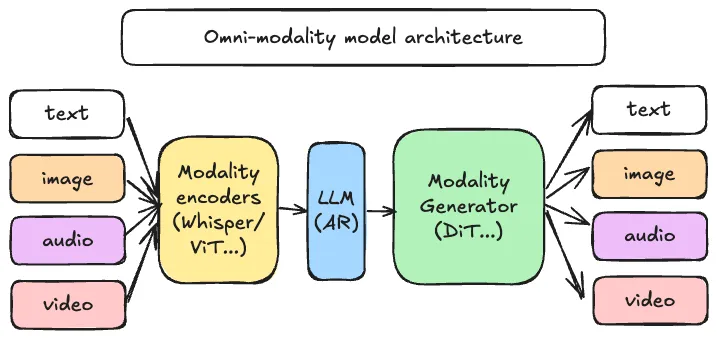

vLLM 凭借 PagedAttention 技术,已经成为了文本推理领域的事实标准。而 vLLM-Omni 的野心在于,它不只做 Text-to-Text,而是将 vLLM 高效的显存管理能力,原生扩展到了 图像(Image)、视频(Video)和音频(Audio) 领域。

简单说,它让你的 GPU 集群能用一套代码,跑通所有类型的 AI 业务。

核心架构与技术亮点

从源码设计来看,vLLM-Omni 并没有暴力堆砌代码,而是做到了架构层面的优雅解耦:

1. 统一的 KV Cache 管理

多模态推理最大的痛点是“长序列”。一段 60 秒的音频解码后,Token 长度惊人。vLLM-Omni 继承了 vLLM 的核心机制,能够非连续地存储多模态数据的 KV Cache。这意味着,无论是处理长视频帧还是长文本对话,显存碎片化问题都得到了根治。

2. 兼容 OpenAI API 协议

这一点对 云栈社区 的开发者来说极其友好。无论后端跑的是 LLaVA-NeXT 还是 Qwen-Audio,对外暴露的都是标准接口。你现有的网关、鉴权和客户端 SDK 几乎不需要改动,就能无缝接入多模态能力。

3. 跨模态连续批处理(Continuous Batching)

它实现了真正的混合调度。系统可以动态地将处理文本、图像和音频的请求打包在一起。这对于基于 Python 生态构建的高并发服务来说,能显著提升 GPU 的计算利用率(Compute Utilization),降低单位请求成本。

运维视角的实战建议

作为 SRE,我们关注的是“稳”和“省”。

在实际部署中,vLLM-Omni 允许我们将多模态推理收敛到一个统一的 Docker 镜像中。这大大简化了 CI/CD 流水线。你不再需要为不同的模型维护不同的 CUDA 版本和依赖库。

对于正在建设 运维 / DevOps / SRE 体系的团队,建议重点关注其 Tensor Parallelism (TP) 特性。它支持跨卡推理超大参数量的多模态模型,是解决单卡显存不足的最佳方案。

总结

vLLM-Omni 的出现,标志着 AI 推理基础设施正在从“单点工具”走向“通用平台”。

对于 云栈社区 的读者而言,掌握这种统一架构方案,不仅能减少线上的故障域,更能为公司节省实打实的算力成本。

项目地址:https://github.com/vllm-project/vllm-omni

官方文档:https://docs.vllm.ai

Python自动化:https://yunpan.plus/f/26

让系统永不宕机,让部署一键完成。

关注我们,获取更多硬核的云原生架构指南。

标签:#vllm-omni #Github #AIInfra #大模型推理 #云原生