比 Python 快 13 倍,比 C 慢 17%,Java 被骂慢骂了 20 年,原来是 Spring 的锅。

“Java 太慢了”,类似这样的话,可能很多开发者都听过。这种刻板印象,有时并非基于数据,而是源于偏见。

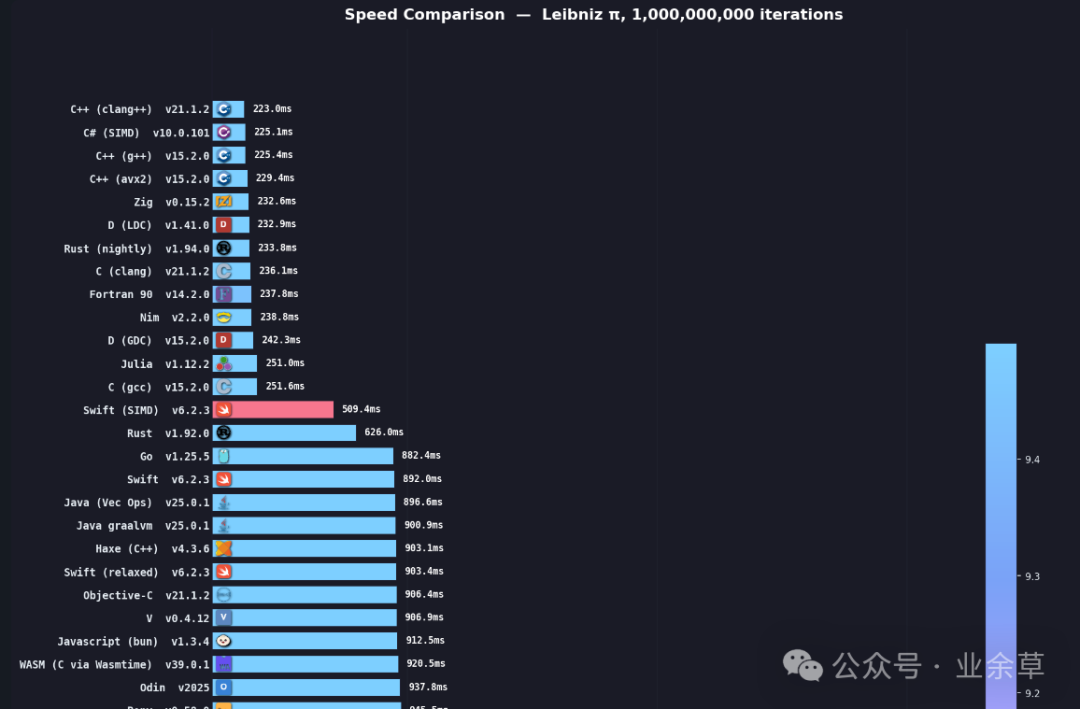

上一次引起广泛讨论,还源于 GitHub 上一个名为 speed-comparison 的开源项目。该项目对 62 门编程语言的速度进行了比较,实验使用莱布尼茨公式计算 π 值,过程与结果均公开透明。其项目地址为:https://github.com/niklas-heer/speed-comparison。

图1:不同编程语言执行10亿次莱布尼茨π计算的时间对比,数据来源 speed-comparison 项目

当 Python 程序员优雅地用一行代码解决问题,或是 JavaScript 在浏览器中快速响应时,一个庞大的 Java 应用可能还在加载 Spring 上下文。这种直观感受上的差异,很容易让人将框架的臃肿归咎于语言本身。

但这真的能说明 Java 语言慢吗?今天,我们尝试从数据和原理出发,探究这些“偏见”的源头,并告诉你:慢的,可能并非语言本身,而是过时的认知与技术栈。

那些关于Java性能的常见偏见

偏见一:解释执行,所以必然慢

这可能是最经典的误解。诚然,Java 需要先编译成字节码,再由 JVM 解释执行,中间确实多了一层抽象。但关键在于,现代 JVM 中,90% 以上的热点代码根本不走解释执行这条“慢车道”。

JVM 的“即时编译”(JIT)和自适应优化能力,使其能在运行时做出静态编译语言难以实现的动态决策。在特定场景下,经过充分优化的 Java 程序,其性能甚至可以媲美 C++。

偏见二:GC 的 STW 导致卡顿

Stop-The-World(STW)确实是 Java 垃圾回收中需要面对的问题。但必须指出,你可能从未体验过真正的低延迟 GC。

虽然没有任何一个商业化的 Java GC 能实现绝对的零 STW,但以 ZGC、Shenandoah 为代表的现代垃圾回收器,其设计核心就是将 STW 时间压缩到极致,有些甚至能达到亚毫秒级别。许多分代式 GC 的大部分阶段也已是并发执行,对应用线程的影响微乎其微。

偏见三:启动慢,运行时性能差

这个印象很大程度上源于某些企业级框架的“厚重感”。例如,一个典型的 Spring Boot + MyBatis + Dubbo 应用,启动耗时数分钟、内存占用数 GB 的情况并不少见。

然而,框架的臃肿不等于语言的低效。反射、AOP 动态代理、Bean 的复杂初始化、连接池建立等框架行为消耗了大量时间。这个“慢”,是框架设计带来的开销,而非 Java 语言或 JVM 的原生性能问题。

数据对比:Java 的真实性能表现

让我们回到开头的基准测试。项目 speed-comparison 使用莱布尼茨公式进行 10 亿次迭代 计算,其网页报告(https://niklas-heer.github.io/speed-comparison/)展示了各语言的性能中位数:

| 语言 |

中位执行时间 |

与最快速度比值 |

| C |

7.08s |

1.0x |

| Rust |

7.11s |

1.0x |

| Java (GraalVM) |

7.33s |

1.04x |

| C++ |

8.16s |

1.15x |

| Java (OpenJDK) |

8.26s |

1.17x |

| Go |

10.4s |

1.47x |

| Node.js |

31.2s |

4.41x |

| Python |

113.17s |

15.99x |

结论非常清晰:Java 只比最快的 C 慢约 17%,但却比 Python 快了近 13 倍。 即便使用标准的 OpenJDK,其性能也显著领先于 Go、Node.js 等语言。

为何“Java慢”的偏见如此普遍?

偏见往往源于信息差和认知滞后。具体分析,主要有以下几个层面:

1. 历史债务与刻板印象

许多人的 Java 印象还停留在 JDK 1.4 时代:纯解释执行、效率低下的早期 JIT、动辄停顿数秒的 Serial/Parallel GC,以及浏览器中卡顿的 Applet。但现在是 2025 年,JDK 21/25 已经发布,ZGC 的停顿时间可控制在 1 毫秒以内,GraalVM 的 AOT 编译能实现亚秒级启动。技术早已迭代,认知也需更新。

2. JVM 的技术复杂性带来的测量陷阱

现代 JVM 的优化策略非常复杂,稍有不慎就会得出错误结论。

- JIT 预热陷阱:代码的执行路径会经历“解释执行 → C1编译 → C2编译优化”的过程。如果在预热阶段(如前几千次调用)就做性能测试,测得的结果远非峰值性能。

- 逃逸分析魔法:JVM 能分析对象作用域,将原本应在堆上分配的对象优化为栈上分配,甚至完全消除,从而实现零 GC 开销。这种优化对开发者透明,传统工具难以观测。

- 微基准测试骗局:没有使用专业工具(如 JMH)的微基准测试很可能无效,因为 JVM 会施展“死代码消除”、“循环展开”等优化,导致你测试的代码根本未被实际执行。

3. 对现代垃圾回收器的认知不足

大部分开发者可能仍在使用 JDK 8 默认的 Parallel GC,却抱怨“GC 卡顿”。实际上,现代 JVM 提供了更强大的选择:

- ZGC:支持超大堆(TB级),停顿时间极短(<1ms)。

- Shenandoah:主打高吞吐与低延迟的平衡。

- G1:JDK 9 后的默认 GC,提供可预测的停顿模型。

问题不在于 Java 没有解决方案,而在于技术栈是否及时升级。

4. 企业级框架的性能损耗

很多时候,慢的不是 Java,而是 Spring 等框架。来看一个对比:

// 纯 Java 计算斐波那契数列

public long fib(int n){ /* 递归实现 */ } // 耗时:~0.5ms

// Spring Bean 版本

@Service

public class FibService {

@Cacheable

public long fib(int n){ /* 同样实现 */ } // 耗时:~15ms

Spring 的代理、AOP、事务管理、缓存等层层封装,可能带来 数十倍的性能开销。开发者往往将框架的设计代价,误认为是语言本身的性能瓶颈。

反射是框架性能损耗的“元凶”之一。依赖注入、ORM 动态代理、JSON 序列化等都重度依赖反射,而反射调用的性能比直接方法调用慢 50-100 倍,且难以被 JIT 优化。

5. 容器化时代的适配挑战

在 Kubernetes 和 Serverless 架构下,Java 传统的“启动慢、内存大”特点确实面临挑战:

- 启动时间长:加载核心类库 + 框架(如 Spring)初始化 Bean。

- 内存占用高:JVM 自身开销 + 堆内存预留。

- 资源感知弱:旧版 JVM 无法正确识别 Docker cgroup 限制。

但这恰恰催生了 Quarkus、Micronaut、Spring Native 等现代框架。它们结合 GraalVM 的 AOT 编译,能将应用启动时间缩短至 0.05秒,内存占用降至 30MB 级别,完美适配云原生环境。

Java 性能的真实定位

综合来看,Java 在现代计算中的性能定位应该是:

- CPU 密集型计算:经过 JIT 优化后,效率可达 C++ 的 90% 以上,远胜 Python。这使其在大数据(Hadoop/Spark)、高频交易等场景仍是首选。

- 内存与并发管理:自动内存管理虽然在延迟上有权衡,但在多线程高吞吐场景下优势明显。JUC 工具包、虚拟线程等提供了成熟度极高的并发编程生态,远超 Python 的 GIL 限制。

- 短板与进化:冷启动和内存占用仍是其相对弱点,但 GraalVM 原生镜像技术已大幅改善。其设计哲学是实现“一次编译,到处运行”的跨平台能力,部分“代价”是达成此目标必需的权衡。

总结

“Java 慢”在很多时候是一个被固化的技术迷思。其根源可能在于:

- 时间差:用十年前的 Java 对比今天的新锐语言。

- 对象错:将 Spring 等框架的损耗误判为 JVM 的缺陷。

- 测量错:在 JIT 预热期或使用错误方法进行性能评估。

- 信息差:不了解 ZGC、GraalVM、Quarkus 等现代技术已解决了诸多历史问题。

- 定位差:忽略了 Java 在稳定性、跨平台、庞大生态及企业级支持上的综合优势。

作为技术人员,我们应保持持续学习,了解 JDK 每六个月一次的迭代所带来的性能革新。Java 的语言性能早已今非昔比,或许到了该升级你的技术认知与项目技术栈的时候了。

Java 的理念始终是平衡与权衡。为了实现“跨平台”与“开发效率”,它在某些方面(如启动、内存)做出了设计上的让步。理性的做法是:理解其设计哲学,认可其固有代价,欣赏其优势领域,并在正确的场景下选用它。技术的讨论应当基于事实与数据,而非停留在过时的偏见里。在 云栈社区 等技术论坛,你总能找到基于最新实践的深度讨论。