大约12年前,在阿里内部,我们曾遭遇一个近乎无解的数据库链路问题。

问题的表象并不复杂:

- 数据库偶发性抖动

- 系统间调用链路极其复杂

- 日志、监控、指标等数据完全割裂,分散在不同系统中

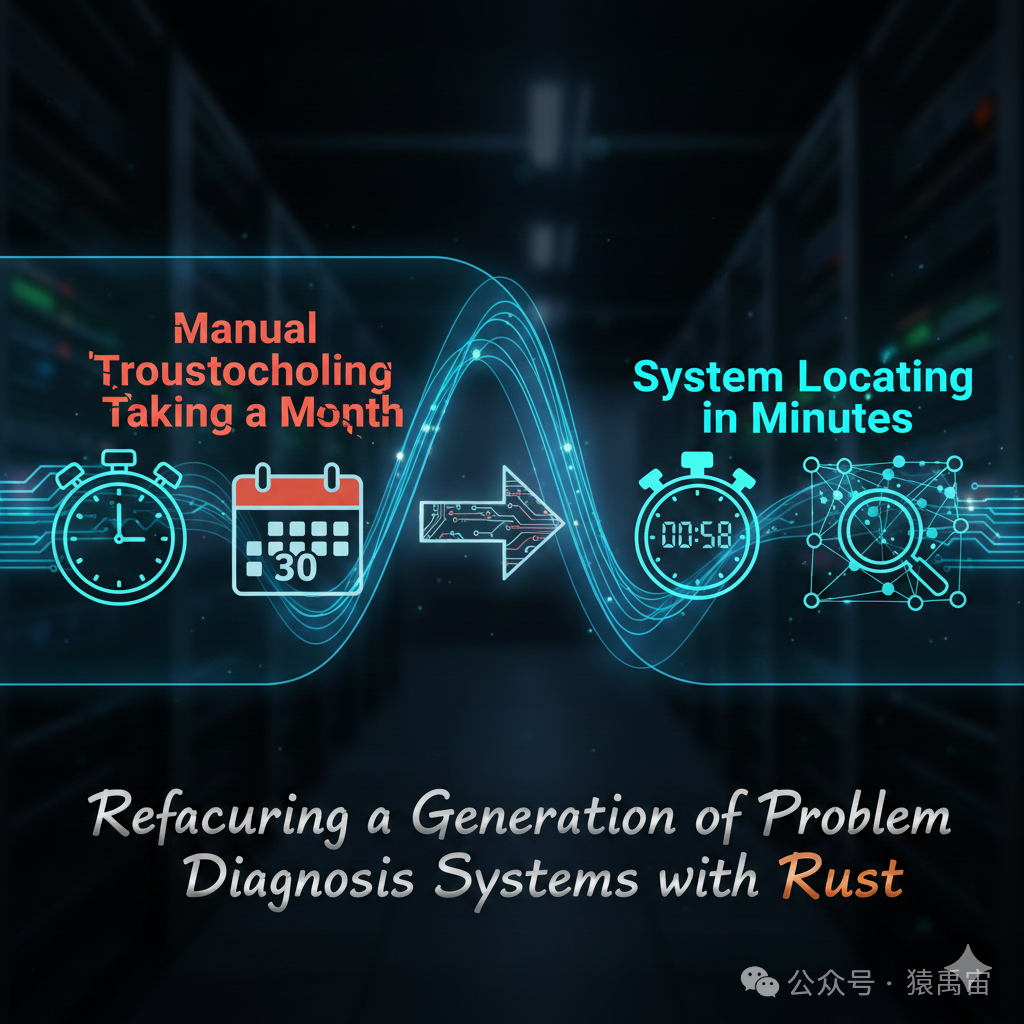

然而,为了真正定位到问题的根本原因,团队足足耗费了整整一个月的时间。

那段时间,基本依赖于最原始的“人肉”排查方式:

- 人工逐条查看海量日志

- 人工对齐各个系统间的时间线

- 依靠个人经验进行猜测和假设

- 在不同系统的控制台与界面之间反复切换、核对

直到某一天,我们幡然醒悟:

如果同样的问题再次发生,我们依然需要再花费一个月。

于是,我们做出了一个关键决定:

将人的排查经验,转化为系统的自动化能力。

第一代系统:将“经验”编码入系统

1. 当年的技术环境有多“原始”

以今天的视角回望,当年的技术条件堪称“地狱级”:

- 没有成熟的ELK(Elasticsearch, Logstash, Kibana)日志套件

- Kafka 还处于 0.7 / 0.9 版本(稳定性与功能都极不完善)

- 市面上缺乏成熟的时序数据库产品

- 没有任何现成的数据库能轻松支撑PB级的数据存储与查询

- 分布式系统的基础设施和最佳实践都处于早期阶段

但线上问题不会等待技术成熟。

2. 我们构建的最终架构

当时,我们最终搭建的系统架构如下:

[C + 汇编 自研采集器]

↓

Kafka 0.7

↓

JStorm(阿里自研流处理框架)

↓

自研分布式数据库(模拟时序数据库特性)

↓

Spring Boot API

↓

AngularJS + Bootstrap 前端

整个架构的核心在于解决了三个关键挑战:

-

采集器极致性能

- 采用 C 语言结合汇编进行开发。

- 直接贴近操作系统内核、网络协议栈和磁盘IO,实现最低损耗的数据采集。

-

PB级数据存储

- 由于市面上没有现成解决方案,我们选择自研分布式存储数据库。

- 核心设计目标明确:优化顺序写入与时间序查询。

-

经验驱动的智能分析系统

- 将资深工程师的人工排查诊断经验进行抽象和总结。

- 将这些经验固化为系统的规则引擎、故障模型和链路推理逻辑。

系统的价值:几分钟定位“以往需月余的难题”

这套系统的开发与打磨持续了近两年时间。

最终达成的效果令人振奋:

- 过去需要一个月才能定位的复杂问题

- 现在通过系统几分钟内即可完成定位

- 系统甚至能发现人类专家都未曾意识到的、隐性的问题模式

在当时的技术背景下:

- 这套设计在国内属于顶尖水平。

- 即便放眼全球,其在问题诊断自动化方面的理念也极具前瞻性。

本质上,我们完成了三件事的工程化转型:

- 将分散在各个孤岛的信号统一到一条标准时间线上。

- 将依赖个人头脑的专家经验转化为可执行的系统规则。

- 让系统以远超人类的“耐心”和一致性,去分析处理全量数据。

如果今天重做一次,技术选择将完全不同

如果将时间线拉回到现在,你会发现一个有趣的事实:

当年那些近乎不可能的技术挑战,如今大多已转变为可评估的“工程选型问题”。

1. 基础设施已全面成熟

今天,工程师可以直接选用一系列成熟的开源或商业组件:

- 消息队列:Kafka / Pulsar

- 大数据存储与分析:ClickHouse / OpenSearch

- 监控与日志:Prometheus / Loki / Grafana

- 完整的云原生(Kubernetes)技术生态

PB级数据的处理,不再是“是否要自研数据库”的生死抉择,而是转变为:

评估哪一套开源技术组合更适合当前的业务场景与性能需求。

为什么选择 Rust 构建新一代系统?

如果让我在今天重新设计并实现这套系统,我会毫不犹豫地选择 Rust。

Rust 语言特性与“系统级、数据密集型”应用场景的要求完美契合。

这类问题诊断系统的核心特点包括:

- 需要处理超高吞吐量的日志和指标数据

- 要求数据处理具有强一致性和准确性

- 追求极低的处理与查询延迟

- 必须能够7x24小时长时间稳定运行,无内存泄漏等问题

Rust 在这些方面的优势几乎是“量身定制”:

- 性能:提供接近 C/C++ 的运行时效率。

- 安全性:通过所有权、借用检查器等机制,在编译期消除数据竞争和内存安全问题,可靠性远高于 C/C++。

- 零成本抽象:高级的语言特性(如迭代器、模式匹配)不会引入运行时开销。

- 优秀的并发模型:Fearless Concurrency,让编写安全、高效的多线程代码更加容易。

用 Rust 构建的现代架构示例

若使用 Rust 进行现代化重构,整体技术架构可以设计如下:

Rust 高性能采集器 (eBPF/异步IO)

↓

Kafka / Pulsar (消息缓冲)

↓

Rust 流式处理引擎 (基于 Tokio 运行时)

↓

ClickHouse / 专用时序数据库

↓

Rust API 服务 (基于 Axum 等框架)

↓

现代化 Web 前端 / 集成 AI 分析界面

核心模块拆解

1️⃣ 高性能采集器(Rust)

- 利用

async/await 进行异步编程,结合 zero-copy 技术减少数据复制。

- 可集成

eBPF 技术进行内核态追踪,或使用 io_uring 实现高性能磁盘IO。

- Rust 的内存与生命周期控制能力,保障采集器长期运行的稳定性。

2️⃣ 流式处理引擎

- 基于

Tokio 运行时构建异步数据处理流水线。

- 天然支持背压(Backpressure)机制,应对数据洪峰。

- 无需再依赖 Storm/JStorm 等外部流处理框架,简化架构。

3️⃣ 规则与智能推理系统

- 保留并完善基于人工经验的规则引擎。

- 增强统计与机器学习模型,进行异常检测。

- 引入 AI 辅助分析能力:这是当年系统完全不具备的维度。

AI 时代:问题诊断系统的再次进化

当年我们所做的核心工作是:

“将人类的经验进行固化,形成系统的确定性规则。”

而在 AI 技术蓬勃发展的今天,我们可以更进一步:

- AI 自动学习异常模式:系统能够从历史数据中自主学习,发现未知的故障模式。

- 自动生成诊断路径:给定一个故障现象,AI 可以推理并生成可能的诊断链路和检查点。

- 自动总结“新经验”:系统能在处理新问题的过程中,不断归纳和沉淀新的诊断知识。

我们甚至可以期待实现这样的场景:

系统能够比团队中最资深的专家更早地感知和预测到潜在的系统性问题。

总结

技术浪潮更迭不息,但复杂系统问题的本质从未改变。

12年前,我们凭借相对原始的技术工具,成功解决了一个极其复杂的工程难题。

今天,基础设施已然成熟,AI 技术方兴未艾,但软件系统的复杂性并未减少,对可观测性与故障诊断的需求反而与日俱增。

真正至关重要的,从来不是具体选择了哪一门编程语言或哪一个框架,而是:

- 是否深刻理解了所要解决问题的本质。

- 是否愿意并能够将模糊的“个人经验”进行工程化、产品化。

- 是否拥有进行长期、系统性建设的决心与耐心。

而 Rust 提供的安全与性能、现代基础设施的丰富选择、以及 AI 带来的智能化潜力,正在让构建下一代智能诊断系统变得比以往任何时候都更加可行。

希望这次从“人肉”到“系统”,再到“智能系统”的技术演进回顾,能为你带来启发。更多关于系统架构、运维与性能优化的深度讨论,欢迎在 云栈社区 与我们一同交流。 |