在构建大型分布式系统时,高并发处理能力是架构设计的核心挑战之一。尤其在电商秒杀这类极端场景下,TPS(Transactions Per Second,每秒事务处理数)成为衡量系统稳定性和性能的关键指标。本文将深入探讨秒杀场景下的TPS衡量标准,并解析实现高TPS的核心架构策略。

秒杀活动以其“瞬间流量洪峰”的特性著称,对系统造成巨大压力。

评估系统能力,首先要对峰值并发量进行合理估算:这需要考虑预估参与用户数、单人请求频率、活动持续时间以及不同类型的请求(如页面浏览、库存查询、提交订单等)。随后,需将峰值并发量转换为对后端系统真正的TPS压力,尤其要区分读请求和写请求。大量的商品详情页等读请求可以通过缓存策略有效缓解,而核心的下单、扣库存等写请求才是对数据库和业务逻辑的真正考验。

那么,电商秒杀场景下,TPS达到多少才算实现了高并发?实际上,并没有一个固定不变的“标准答案”。这个数值高度依赖于具体的业务规模、架构设计、流量管控策略以及基础设施的承载能力。一个基本的原则是:必须结合自身业务目标进行推算,并通过充分的压力测试来验证。

一般而言,对于中小型电商的秒杀活动,其核心下单链路若能稳定支撑 1000 到 5000 TPS,已经是非常不错的表现。而对于天猫双十一这类超大型平台,其系统需要能够处理每秒数万甚至数十万级别的订单请求,这对整体高并发架构提出了极致要求。

要实现高TPS且保障系统不宕机,必须遵循“分层过滤,逐级减压”的设计原则,将绝大部分无效或冗余请求在抵达核心服务前就拦截掉。

第一层:前端与网络层抗压 (目标:拦截90%以上流量)

- CDN加速与静态化:将秒杀活动页、商品图片、CSS/JS脚本等完全静态化的资源推送到CDN边缘节点,利用用户就近访问原理分担源站压力。

- 前端交互限流:通过JavaScript控制提交按钮,在用户点击后立即置灰一段时间(如3-5秒),防止用户连续疯狂点击产生大量无效请求。

第二层:缓存层拦截 (目标:解决9%的读/写请求)

- 热点数据预热:在秒杀开始前,将商品库存、限购规则等关键数据提前加载到高性能缓存中,例如Redis。

- 原子化库存扣减:使用Redis配合Lua脚本,在缓存层完成库存的查询与扣减操作,保证原子性,避免超卖。只有扣减成功的请求才有资格进入后续流程,极大减轻数据库压力。

- 本地缓存:对于极热点的活动配置信息,可以在应用服务器内存中使用Caffeine或Guava Cache建立本地二级缓存,进一步提升读取速度。

第三层:异步化与削峰填谷 (目标:保护核心数据库)

- 消息队列缓冲:用户下单请求经过基础校验和缓存扣库存后,立即返回“排队中”等中间状态,同时将创建订单的请求异步写入消息队列,如Kafka或RocketMQ。

- 平稳消费:后端的订单处理服务按照自身可控的处理能力(例如5000 TPS)从消息队列中匀速消费消息,完成订单落地、支付通知等后续操作。这样,即便前端涌入十万QPS的流量,也能被平滑成数据库可承受的TPS,避免连接池被瞬间击穿。

第四层:数据库层终极防护

- 避免热点行竞争:切忌在秒杀时刻使用

UPDATE stock SET count=count-1 WHERE id=商品ID这类语句,这会在数据库行锁层面造成严重拥堵甚至死锁。库存扣减逻辑应前置到缓存层完成。

- 分库分表:对于订单、流水等海量数据,进行分库分表设计,将数据分散到不同的数据库实例和表中,提升整体的IOPS和处理容量。

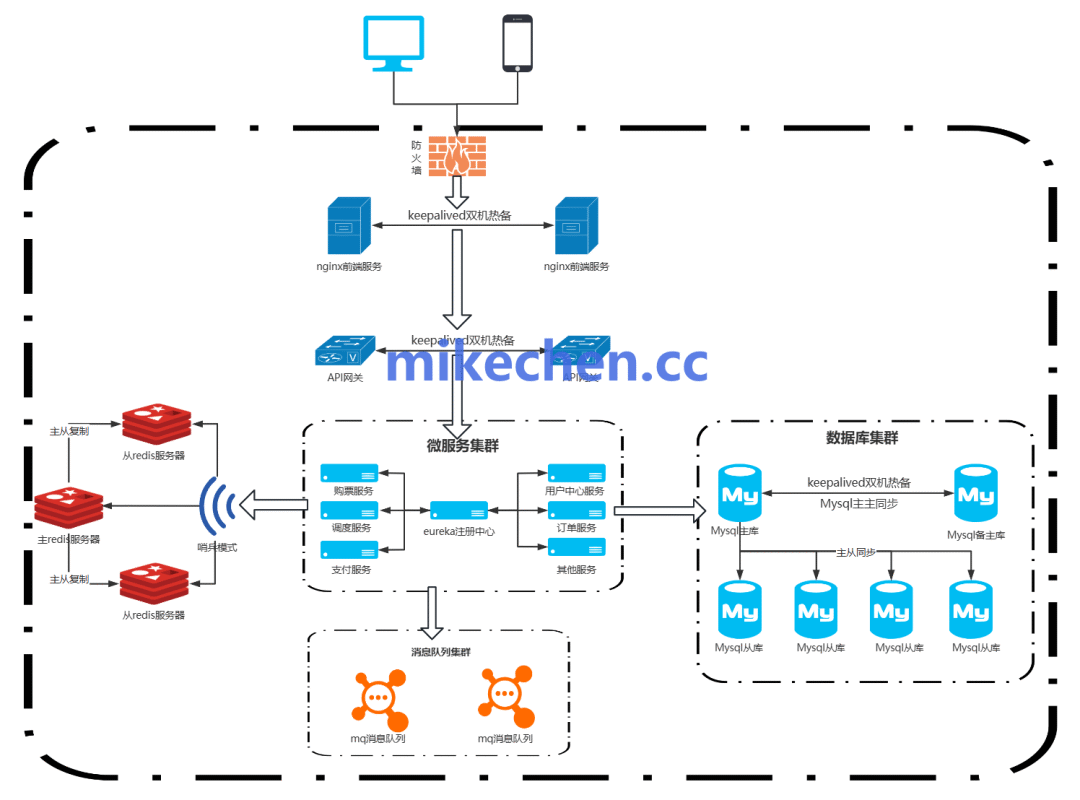

下图展示了一个典型的、包含上述分层过滤思想的秒杀系统微服务架构示意图:

总结来说,秒杀系统的TPS高低并非一个孤立的数字,而是整个技术体系共同作用的结果。从客户端限流、CDN、到多级缓存、异步消息,再到数据库优化,每一层都承担着流量过滤和压力卸载的职责。设计时关键在于定位自身业务的性能瓶颈,并针对性地实施上述分层优化策略,通过全链路压测来验证TPS目标是否达成。更多关于分布式系统与高可用设计的讨论,欢迎访问云栈社区进行交流。 |