作为程序员,你是否遇到过这些困扰?

- 想使用GPT-4、GLM-4等顶级AI模型辅助编码,但昂贵的API费用让人望而却步

- 担心代码隐私,不敢将核心代码发送到第三方AI平台

- 不同AI模型的接口不统一,切换使用非常麻烦

- 本地部署AI模型性能不足,体验卡顿

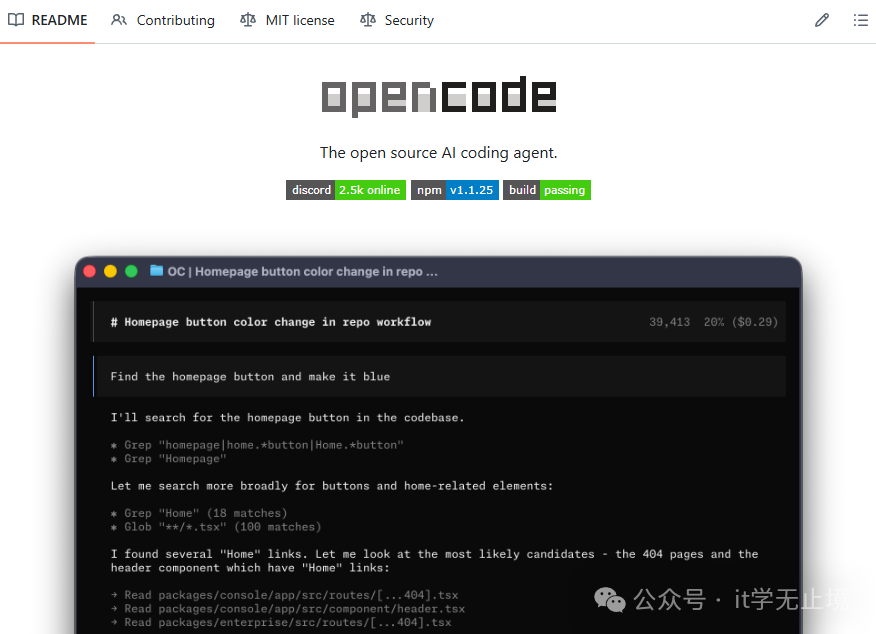

如果你也有这些问题,那么今天要介绍的这个 GitHub 项目绝对能让你眼前一亮!它就是 OpenCode——一个拥有5.3万星标的开源编码代理,让你免费使用GLM-4等顶级AI模型,还能保护代码隐私!

🚀 OpenCode 是什么?

OpenCode 是一个开源的 AI 编码代理项目,它提供了一个统一的接口,可以对接多种顶级 AI 模型,堪称模型聚合的“翻译官”。支持的主流模型包括:

- 智谱AI:GLM-4、GLM-3-Turbo

- OpenAI:GPT-4、GPT-3.5-Turbo

- Anthropic:Claude 3、Claude 2

- Google:Gemini Pro

- 百度:文心一言

- 阿里:通义千问

- 腾讯:混元大模型

简单来说,你只需要面对 OpenCode 这一个接口,它就能帮你将请求适配到上述任意一个模型,极大地简化了多模型切换的复杂度。

🌟 为什么 OpenCode 如此受欢迎?

能够在 GitHub 上获得超过 5.3 万星标,成为最受欢迎的 AI 编码工具之一,OpenCode 主要凭借以下几点优势:

1. 免费使用顶级 AI 模型

OpenCode 支持通过各种免费渠道使用顶级 AI 模型,例如智谱AI开放平台的免费额度、各大厂商的免费 API 测试,甚至是本地部署的开源模型(如 Llama 3、Qwen 等),有效降低了使用门槛。

2. 统一接口,无缝切换

无论你想使用 GPT-4 还是 GLM-4,都通过完全相同的 OpenCode 接口调用。你无需学习和适配不同厂商各异的 API 格式,可以根据任务需求或性价比,随时在配置中切换模型,灵活性极高。

3. 代码隐私保护

你可以将 OpenCode 部署在本地或自己的私有服务器上。这意味着你所有的代码查询和对话历史都只在你的可控环境中处理,无需上传至第三方云端,从根本上保障了核心代码的隐私与安全。对于关注代码安全性的团队和个人开发者而言,这是一个关键特性。

📖 快速开始

让我们看看如何快速上手 OpenCode。

第一步:安装 OpenCode

OpenCode 支持多种安装方式,最推荐的是使用 Docker 进行一键部署:

docker run -d -p 3456:3456 \

-e OPENAI_API_KEY=your_api_key \

-e ZHIPUAI_API_KEY=your_zhipu_key \

opencode/pilot

也可以通过 npm 全局安装:

npm install -g opencode-ai

或者使用其他你熟悉的包管理器:

# bun

bun install -g opencode-ai

# pnpm

pnpm install -g opencode-ai

# yarn

yarn global add opencode-ai

第二步:配置 AI 模型

安装并启动后,打开浏览器访问 http://localhost:3456 ,进入 OpenCode 的 Web 配置页面。在这里,你可以添加你需要使用的 AI 模型的 API 密钥,例如 OpenAI API Key、智谱 AI API Key、Claude API Key 等。

第三步:使用 OpenCode

配置完成后,你可以通过多种方式使用它:

1. VS Code 扩展

在 VS Code 扩展商店中搜索并安装“OpenCode Pilot”扩展。安装后,你可以:

- 选中代码,右键选择“OpenCode: 解释代码”

- 在侧边栏输入问题,获取 AI 的智能回答

- 使用快捷键

Ctrl+Shift+P 打开命令面板,调用更多功能

2. 命令行工具

通过命令行,你可以快速完成各种编码任务:

# 解释代码

opencode explain file.js

# 生成代码

opencode generate “创建一个React组件”

# 修复错误

opencode fix bug.js

# 查看帮助

opencode --help

3. Web 界面

直接通过 http://localhost:3456 访问 Web 界面,在浏览器中享受完整的 AI 编码辅助功能,适合快速测试或没有安装 IDE 的场景。

💡 核心功能介绍

1. 智能代码补全

OpenCode 可以根据当前文件的上下文,智能地补全代码行甚至整个函数块,支持包括 JavaScript/TypeScript、Python、Java、Go、C/C++、Rust、PHP、Ruby 在内的主流编程语言。

2. 代码解释和文档生成

只需选中一段令人费解的代码,OpenCode 就能为你生成清晰的中文解释和规范的 API 文档。

// 原始代码

function quickSort(arr) {

if (arr.length <= 1) return arr;

const pivot = arr[Math.floor(arr.length / 2)];

const left = arr.filter(x => x < pivot);

const middle = arr.filter(x => x === pivot);

const right = arr.filter(x => x > pivot);

return [...quickSort(left), ...middle, ...quickSort(right)];

}

// OpenCode 生成的解释

/**

* 快速排序算法实现

* @param {Array} arr - 要排序的数组

* @returns {Array} - 排序后的数组

*

* 算法步骤:

* 1. 选择数组中间元素作为基准值

* 2. 将数组分为三部分:小于基准值、等于基准值、大于基准值

* 3. 递归地对左右两部分进行快速排序

* 4. 合并排序后的结果

*

* 时间复杂度:平均O(nlogn),最坏O(n²)

* 空间复杂度:O(logn)

*/

3. 错误修复和调试

遇到运行时错误或逻辑缺陷?将相关代码抛给 OpenCode,它能帮你分析问题并提供修复建议。

# 有错误的代码

def divide(a, b):

return a / b

result = divide(10, 0)

print(result)

# OpenCode 修复后的代码

def divide(a, b):

try:

return a / b

except ZeroDivisionError:

print(“错误:除数不能为零”)

return None

result = divide(10, 0)

if result is not None:

print(result)

4. 多模型对比

OpenCode 允许你向多个 AI 模型同时提问,并对比它们的回答,帮助你选择最优解或获取更全面的思路。

问题:如何优化React应用的性能?

GPT-4的回答:

1. 使用React.memo避免不必要的重渲染

2. 使用useCallback和useMemo缓存函数和计算结果

3. 虚拟列表优化长列表渲染

4. 代码分割和懒加载

GLM-4的回答:

1. 组件级优化:React.memo、useCallback、useMemo

2. 渲染优化:虚拟列表、窗口化渲染

3. 资源优化:代码分割、图片懒加载

4. 状态管理优化:减少不必要的状态更新

5. 构建优化:Tree Shaking、代码压缩

Claude 3的回答:

1. 优化渲染:React.memo、shouldComponentUpdate

2. 优化状态:合理使用useState和useReducer

3. 优化数据获取:使用Suspense和Error Boundary

4. 优化资源:使用Webpack Bundle Analyzer分析包大小

🎯 高级功能

1. 自定义提示词

你可以为特定场景创建自定义提示词模板,让 AI 模型更精准地理解你的需求,例如设定一个“代码审查专家”或“Python 风格指南”的角色。

{

"name": “React最佳实践”,

"prompt”: “作为一名React专家,请根据以下代码提供最佳实践建议:\n\n{{code}}”

}

2. 本地模型支持

除了连接云端商业 API,OpenCode 还支持在本地部署和调用开源大模型,如 Llama 3、Qwen 2、Mistral、Gemma 等,实现完全离线的 AI 编码辅助。

3. API 集成

OpenCode 提供了标准的 REST API,方便你将其集成到自己的自动化工具链或工作流中。

curl -X POST http://localhost:3456/api/v1/chat \

-H “Content-Type: application/json” \

-d ‘{“model”:”gpt-4”,”messages”:[{“role”:”user”,”content”:”解释这段代码:function add(a,b){return a+b}”}]}’

🔧 技术架构

OpenCode 采用了清晰的分层架构设计,确保了良好的可扩展性和可维护性:

- 核心层:负责请求的路由分发和模型调度管理。

- 模型适配器层:为不同的 AI 模型提供商(如 OpenAI、智谱AI等)实现统一的接口适配。

- 编码引擎层:专门针对代码生成、解释、重构等场景进行优化的提示词工程模块。

- 客户端层:包括 VS Code 扩展、命令行工具和 Web 界面,提供多样化的使用入口。

📊 OpenCode vs 其他 AI 编码工具

| 特性 |

OpenCode |

GitHub Copilot |

Cursor |

| 开源免费 |

✅ 完全开源 |

❌ 付费订阅 |

❌ 付费订阅 |

| 多模型支持 |

✅ 支持10+模型 |

❌ 仅OpenAI |

❌ 仅OpenAI |

| 本地部署 |

✅ 支持 |

❌ 不支持 |

❌ 不支持 |

| 代码隐私 |

✅ 本地处理 |

❌ 上传到OpenAI |

❌ 上传到OpenAI |

| 统一接口 |

✅ 所有模型同一接口 |

❌ 仅支持Copilot |

❌ 仅支持Cursor |

| 社区支持 |

✅ 活跃社区 |

❌ 闭源 |

❌ 闭源 |

💡 使用小贴士

- 合理选择模型:根据任务复杂度选择合适的模型。简单的语法补全可以用轻量级模型,复杂的系统设计或算法问题则交给 GPT-4 或 GLM-4 等顶级模型。

- 优化提示词:在提问时,提供清晰的任务描述、必要的上下文(如相关代码片段)和期望的输出格式,能显著提升 AI 回答的质量。

- 使用快捷键:熟练掌握 VS Code 扩展提供的快捷键,可以让你在不中断编码流的情况下快速获得 AI 辅助。

- 定期更新:关注 OpenCode 项目的 GitHub 仓库,及时更新以获取最新支持的模型和功能改进。

- 贡献社区:作为一款开源工具,OpenCode 的成长离不开社区。遇到问题可以在 Issue 中提出,有好的想法或修复也可以提交 Pull Request。

🎉 总结

总而言之,OpenCode 是一款真正以开发者为中心的开源 AI 编码代理 工具。它通过聚合多模型接口、支持本地化部署,巧妙地解决了使用成本、隐私安全和切换繁琐三大痛点。

无论你是想体验最新 AI 模型的个人开发者,还是需要为团队搭建安全、高效编码辅助平台的技术负责人,OpenCode 都提供了一个极具吸引力的选择。它让顶级的 AI 编码能力变得触手可及,且完全可控。

如果你对这类能提升开发效率的 开源实战 项目感兴趣,欢迎来 云栈社区 交流探讨,发现更多优秀的工具与实践。