Kafka 作为构建现代化、高吞吐数据管道与实时流应用的核心组件,其卓越的性能源于一系列精妙的底层设计。本文将深入剖析支撑 Kafka 达到百万级吞吐量的四大核心技术。

1. 顺序写入与零拷贝机制

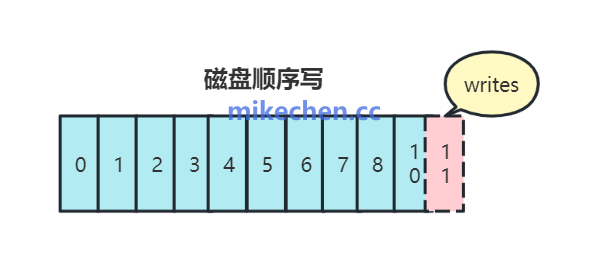

Kafka 消息持久化的首要原则是 顺序写入磁盘,彻底避免了随机写入操作。对于磁盘而言,顺序写入的速率远超随机写入,即使是机械硬盘也能达到接近内存的访问性能。

这一机制的核心实现包括:

- Segment 文件顺序写入:每个 Partition 在物理上对应一组顺序追加的日志文件(Segment),所有新消息都追加到当前活跃 Segment 的末尾。

- 高效利用 OS Page Cache:Kafka 并未自行维护复杂的缓存系统,而是充分依赖操作系统的页缓存(Page Cache)来缓冲文件读写,利用操作系统自身成熟且高效的缓存管理策略。

- 零拷贝传输:在消费者拉取消息时,Kafka 通过

sendfile() 系统调用,实现了零拷贝。数据无需从内核空间拷贝到用户空间,再拷贝回内核空间套接字缓冲区,而是直接在内核中完成从磁盘文件到网卡的数据传输。

这种从生产到消费全链路的磁盘I/O优化策略,极大减少了数据拷贝次数和 CPU 消耗,是提升吞吐、降低延迟的关键。

2. 分区化与并行处理架构

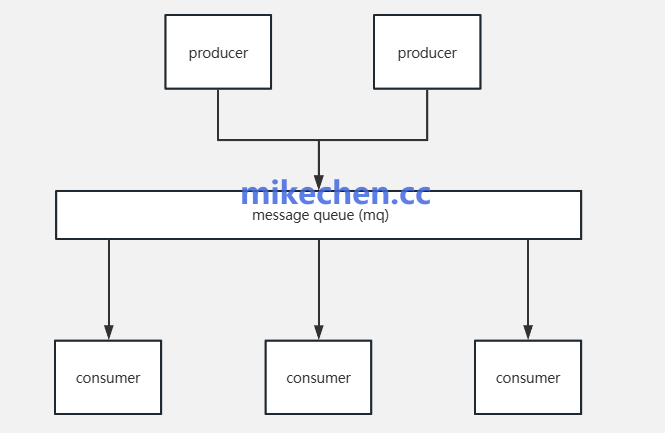

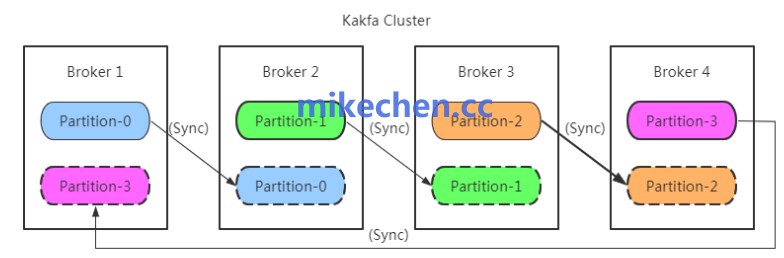

Kafka 通过分区机制实现了数据的分布式存储与并行处理。其核心逻辑结构为 Topic → Partition → Replica。

分区机制带来的核心优势:

- 数据分片与独立消费:每个 Partition 都是一个有序的日志序列,可以独立进行读写和消费。

- 读写并行化:多个 Partition 可以分布在不同的 Broker 上,允许生产者和消费者同时与多个 Broker 交互,实现读写操作的完全并行。

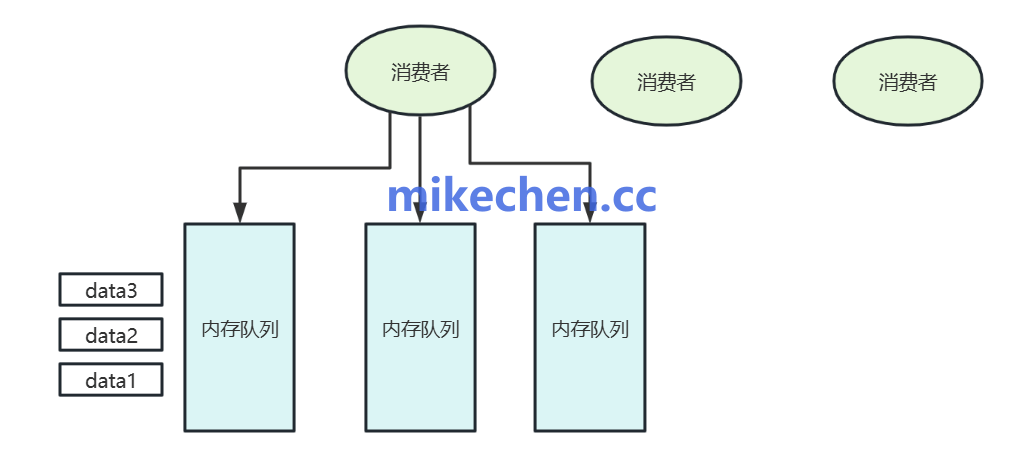

- 消费组并行消费:在一个 Consumer Group 内,每个 Partition 只能被一个消费者实例消费,多个消费者可以并行消费不同的 Partition,实现水平扩展的消费能力。

例如,将一个 Topic 划分为 10 个 Partition,并由 10 个消费者同时消费,理论上消费吞吐量可线性提升 10 倍。这种设计是 Kafka 能够支撑海量数据和高并发访问,并实现系统水平扩展的基础。

3. 批量传输与数据压缩

为了减少网络往返开销和带宽占用,Kafka 在网络通信层面采用了批量和压缩策略。

主要优化手段:

- 生产者端批量发送:Producer 并非逐条发送消息,而是通过

batch.size(批次大小)和 linger.ms(等待时间)参数将多条消息在内存中聚合成一个批次(Batch)再一次性发送,有效减少了网络请求次数。

- 服务端批量存储:Broker 将接收到的消息批次直接以追加形式写入日志文件,将多次小 I/O 合并为一次大 I/O,显著提升了磁盘写入效率。

- 端到端压缩支持:Kafka 支持 gzip、snappy、lz4、zstd 等多种压缩算法。生产者可以对整个消息批次进行压缩,Broker 以压缩格式存储,消费者端再进行解压。这能在网络传输过程中减少高达 70% 以上的带宽占用,对于跨数据中心传输场景尤为重要。

通过批量与压缩,Kafka 在网络传输优化上实现了巨大飞跃,大幅提升了单位时间内的数据传输效率。

4. 高效网络模型与异步处理

Kafka 的整个通信层基于 Java NIO(非阻塞 I/O)构建,实现了高并发下的高性能网络通信。

其网络层的优化点包括:

- 基于 Selector 的 Reactor 模型:使用少量线程(通常包含 Acceptor 线程和多个 Processor 线程)即可管理成千上万个网络连接,处理读写事件,极大减少了线程上下文切换的开销。

- 复用零拷贝机制:如前所述,在数据发送时使用

sendfile(),避免了内核态与用户态之间的数据拷贝。

- 批量请求与响应:不仅生产者可以批量发送,Broker 也可以批量处理请求并返回响应,进一步减少了网络交互的延迟。

这套高效的网络/系统通信模型,使得 Kafka 在高并发连接下依然能保持很低的 CPU 占用率和网络延迟,从而支撑起整体的高吞吐量。 |