在探讨新手团队如何接入业务数据到Doris前,我们首先回顾并解答一个上篇文章遗留的关于“Doris Catalog导入数据”的问题。根据社区同学的反馈,之前遇到的“数据丢失”与“数据错乱”现象,根源在于源表与目标表的字段顺序不一致。

具体来说,当源MySQL表的主键字段(Primary Key)不在第一列时,通过Flink-Doris-Connector自动同步到Doris后,Doris会依据其建表规范,强制将Key列排在最前面,从而导致了字段映射错位。由于自动建表过程不透明,这个问题在当时很难被直观发现。这虽然算不上Doris的Bug,但其强制的字段顺序要求确实是一个需要留意的“坑”。

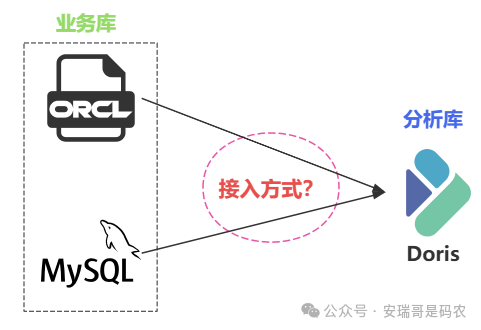

言归正传,本文将围绕一个典型的企业客户需求展开:他们希望将现有的MySQL与Oracle业务库数据,以最简单的方式接入Doris集群,快速构建BI系统进行验证。团队技术栈以SQL为主,追求“一切从简”。

一、需求与现状:追求极简的数据接入

客户的核心诉求很明确:在数据量不大、计算逻辑简单的初期,快速将业务数据同步至Doris,并通过SQL生成报表,以验证技术方案的可行性。团队非专业数据团队,技术能力集中在SQL层面,因此强烈倾向于使用配置化工具或SQL方案,避免编码。

在市面上,他们初步筛选出两款工具:Kettle 和 Seatunnel。但这两类基于图形化“拖、拉、拽”的ETL工具,其通用性在应对复杂、个性化的业务逻辑时往往显得力不从心,调试和维护成本可能远超预期。相较之下,像 Apache Spark 或 Flink 这类编程框架,虽然入门门槛稍高,但灵活性和可控性更强。

二、核心建议:利用Doris Catalog实现“零代码”接入

基于客户“极简”的核心诉求,我给出的建议是:直接使用Doris的Catalog功能接入MySQL和Oracle。这是目前最轻量、最直接的方案,无需引入任何额外的ETL工具。

Doris官方支持通过Catalog建立与多种外部数据源(包括MySQL和Oracle)的映射,允许用户像查询本地表一样使用SQL直接查询和导入外部数据。对于主要技术栈为SQL的团队来说,学习成本极低。从实践反馈来看,该方案在满足基础同步需求上运行良好。

三、方案优缺点与注意事项

当然,Doris Catalog方案并非银弹,其主要优缺点如下:

优点:

- 简单高效:无需编写代码,通过SQL配置即可完成数据同步,契合新手团队的技术栈。

- 维护方便:链路清晰,依赖少。

缺点与坑点:

- 对源库有侵入性:与 Flink CDC 读取Binlog的方式不同,Catalog查询会直接访问源表,产生一定的IO压力,使用时需注意对业务库的影响。

- 大数据量导入风险:如果目标表需要一次性导入海量历史数据,该方式可能出现失败,且失败反馈可能滞后,导致时间浪费。

- 功能与支持度限制:如果遇到Catalog的Bug或当前数据源类型不被支持,则需要备用方案。

关于备用方案:当Catalog不适用时,推荐使用Spark JDBC作为退路。相较于Flink JDBC,Spark的方案在批处理同步场景下通常更简洁稳定。

四、演进路径:从业余到专业的必然选择

对于所述客户而言,采用Doris Catalog接入数据,是在资源、技能和时间约束下的最优起步策略。它能够帮助团队快速验证想法,看到初步成果。

然而,随着项目发展,面临更实时、更复杂的数据同步与加工需求时,这套简易方案就会显得捉襟见肘。向专业化演进的下一个关键步骤,通常是引入Flink CDC这类专业的流式数据集成框架,以实现对业务库无侵入、低延迟、高容错的实时数据同步。

目前,该客户团队已经在积极学习Flink,这正是从业余走向专业、从验证迈向生产的经典成长路径。通过一个轻量级方案快速启动,在解决实际问题的过程中驱动团队学习更强大的工具,最终构建起健壮的数据管道,这无疑是技术团队演进的高效实践。

|