在数字化转型的背景下,企业应用架构日益复杂,面临着跨云、跨地域、跨边缘的分布式部署与统一管理的挑战。Kurator 作为业界首个开源的分布式云原生套件,通过深度整合 Karmada、KubeEdge、Volcano、Istio 等主流云原生技术栈,为企业构建统一、高效的分布式基础设施提供了强大的解决方案。本文将深入解析 Kurator 的整体架构、核心组件与集成实践,并提供从环境搭建到应用部署的完整指南。

一、Kurator 技术背景与核心价值

随着业务全球化与数字化的深入,单一 Kubernetes 集群已难以满足复杂场景的需求。企业需要同时管理公有云、私有云及海量边缘节点,在多集群协同、应用分发、流量治理与统一观测等方面面临巨大挑战。

Kurator 应运而生,它并非从零造轮子,而是作为一个“胶水”层,将分散的顶级云原生项目整合为有机整体。其核心价值在于通过统一的控制平面,实现跨集群、跨云、跨边缘的资源协同与应用管理,显著降低了分布式云原生基础设施的构建与运维复杂度。

作为 kurator-dev 组织的核心项目,Kurator 采用 Apache 2.0 许可证,鼓励社区共同构建。自发布以来,项目持续迭代,功能已从基础的多集群管理,扩展至统一备份恢复、流量治理与可观测性等全栈能力。

Kurator 平台欢迎页面

二、核心组件深度解析与集成实践

2.1 Karmada:多集群管理的核心引擎

Karmada(Kubernetes Armada)是 Kurator 实现多集群管理的基石。其架构设计遵循 Kubernetes 原生理念,控制平面包含 API Server、Scheduler、Controller Manager 等组件,专门为多集群场景优化。

Karmada 架构示意图

在 Kurator 中,用户可以通过定义 PropagationPolicy 来声明应用的部署策略。以下示例配置定义了 nginx 应用需要在北京、上海、广州三个集群中同时部署,并采用 Duplicated 模式(即每个集群部署完整副本)。

apiVersion: policy.karmada.io/v1alpha1

kind: PropagationPolicy

metadata:

name: nginx-propagation

spec:

resourceSelectors:

- apiVersion: apps/v1

kind: Deployment

name: nginx

placement:

clusterAffinity:

clusterNames:

- cluster-beijing

- cluster-shanghai

- cluster-guangzhou

replicaScheduling:

replicaSchedulingType: Duplicated

对于更复杂的调度需求,Karmada 支持基于集群标签、资源配额等多种策略。例如,下面的 ClusterPropagationPolicy 实现了对华东地区生产环境集群的精细化加权调度。

apiVersion: policy.karmada.io/v1alpha1

kind: ClusterPropagationPolicy

metadata:

name: frontend-app

spec:

resourceSelectors:

- apiVersion: apps/v1

kind: Deployment

name: frontend

placement:

clusterAffinity:

labelSelector:

matchLabels:

environment: production

region: east-china

replicaScheduling:

replicaSchedulingType: Weighted

replicaDivisionPreference: Aggregated

weightList:

- targetCluster:

clusterNames:

- cluster-shanghai

weight: 60

- targetCluster:

clusterNames:

- cluster-hangzhou

weight: 40

2.2 KubeEdge:云边协同的关键支撑

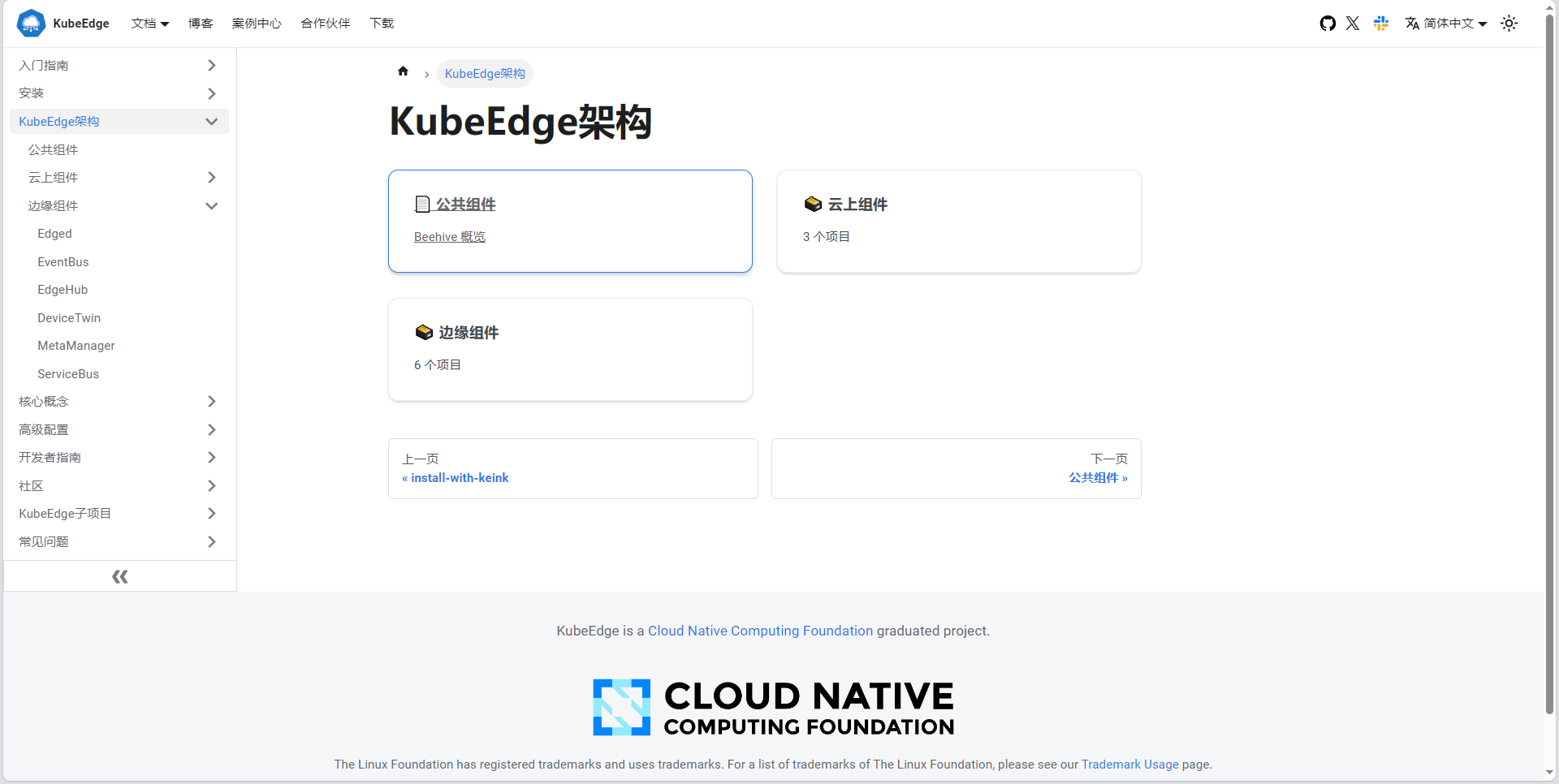

KubeEdge 是 CNCF 毕业项目,负责将 Kubernetes 的容器编排能力延伸至边缘侧。其架构清晰分为云侧(CloudCore)和边侧(EdgeCore),通过稳定的信道进行同步与管理。

KubeEdge 架构图

在 Kurator 中,KubeEdge 与 Karmada 深度集成。首先需要创建边缘节点资源,随后可将其作为“边缘集群”注册到 Karmada 控制平面,从而实现中心云与边缘节点的统一纳管与应用下发。

apiVersion: edge.kubeedge.io/v1

kind: EdgeNode

metadata:

name: edge-node-01

spec:

nodeInfo:

nodeID: edge-node-01

nodeIP: 192.168.1.100

labels:

region: east-china

environment: production

edge-type: industrial

2.3 Volcano:批处理与AI工作负载调度器

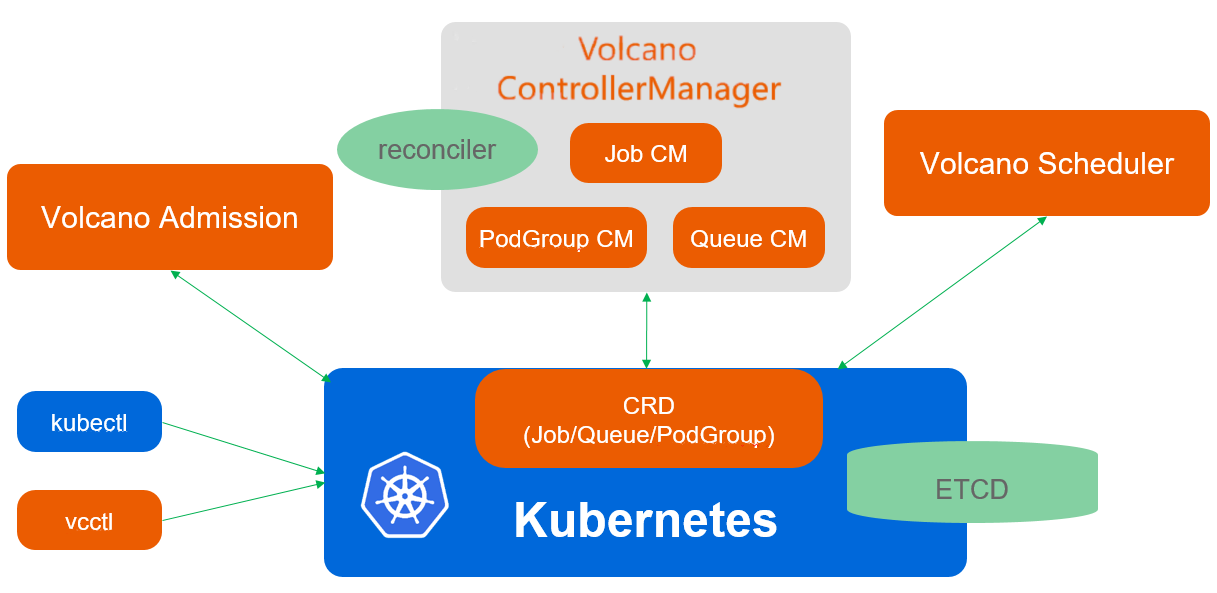

对于 AI 训练、大数据处理等批处理任务,Kubernetes 原生调度器可能力有未逮。Volcano 作为 CNCF 下首个基于 Kubernetes 的批量计算平台,提供了任务拓扑感知、资源装箱、队列管理等高级调度策略。

Volcano 架构图

以下是一个使用 Volcano 调度 TensorFlow 分布式训练作业的示例,它定义了 1 个参数服务器(ps)和 2 个需要 GPU 资源的工作节点(worker)。

apiVersion: batch.volcano.sh/v1alpha1

kind: Job

metadata:

name: tensorflow-training

spec:

minAvailable: 3

schedulerName: volcano

tasks:

- replicas: 1

name: ps

template:

spec:

containers:

- image: tensorflow/tensorflow:2.8.0

name: tensorflow

command: ["python", "/app/ps.py"]

resources:

limits:

cpu: "1"

memory: "4Gi"

- replicas: 2

name: worker

template:

spec:

containers:

- image: tensorflow/tensorflow:2.8.0

name: tensorflow

command: ["python", "/app/worker.py"]

resources:

limits:

cpu: "2"

memory: "8Gi"

nodeSelector:

node-type: gpu

2.4 Istio:跨集群服务网格与流量治理

服务网格是管理微服务通信、安全与可观测性的关键基础设施。Kurator 集成了 Istio,并将其能力扩展到多集群环境,实现跨集群的服务发现与智能流量治理。

Istio 官网首页

通过定义 VirtualService,可以轻松实现跨集群的灰度发布与地域亲和性流量调度。如下配置将 user-service 的流量按权重分配至不同地域的集群。

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: user-service

spec:

hosts:

- user-service

http:

- route:

- destination:

host: user-service

subset: beijing

weight: 50

- destination:

host: user-service

subset: shanghai

weight: 30

- destination:

host: user-service

subset: guangzhou

weight: 20

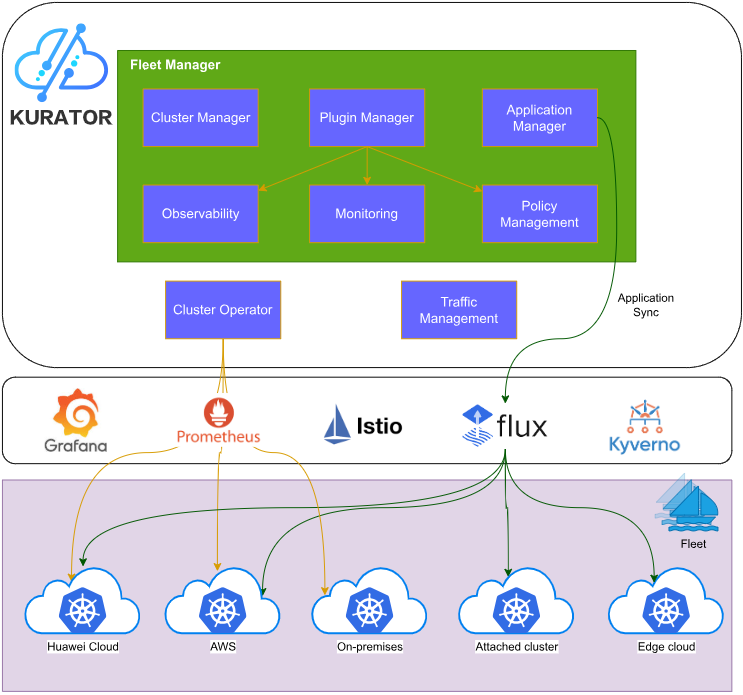

三、Kurator 整体架构设计与关键技术

3.1 分层架构与组件协同

Kurator 采用清晰的分层架构设计,自下而上整合基础设施,并通过统一的控制平面提供上层能力。

Kurator 整体架构图

其核心管理器各司其职:

- Fleet Manager:负责集群(包括边缘集群)的生命周期管理。

- Application Manager:提供跨集群的应用统一编排与部署。

- Plugin Manager:管理各类插件(如网络、存储)的集成。

- Observability:整合 Prometheus、Thanos 等,提供统一监控。

这些组件通过扩展 Kubernetes API(CRD)和事件机制紧密协同,将 Karmada 的多集群调度、KubeEdge 的云边协同、Istio 的流量治理等能力融合为单一平台体验。

3.2 统一资源编排与备份恢复

Kurator 通过自定义资源定义实现了更高层次的抽象。例如,使用 FederatedDeployment 可以声明式地定义跨集群部署策略,平台会自动将其转换为底层各集群的具体资源。

更值得一提的是其基于 Velero 构建的统一备份恢复机制。通过定义一个 BackupPolicy,即可轻松为跨集群应用配置定时备份、保留策略及存储位置。

apiVersion: backup.kurator.dev/v1alpha1

kind: BackupPolicy

metadata:

name: production-backup

spec:

schedule: "0 2 * * *" # 每天凌晨2点执行

retentionPolicy:

keepLast: 7 # 保留最近7份备份

backupContent:

namespaces:

- production

storageLocation:

provider: aws

bucket: kurator-backups

3.3 性能优化与高可用实践

在大规模场景下,Kurator 通过分层调度、缓存优化、批处理和异步化等策略显著提升调度性能。同时,其控制平面组件本身支持多副本部署,并结合 Pod 反亲和性、资源配额及健康检查,确保生产环境的高可用性。

apiVersion: apps/v1

kind: Deployment

metadata:

name: kurator-controller-manager

spec:

replicas: 3

template:

spec:

affinity:

podAntiAffinity: # 确保Pod分散在不同节点

requiredDuringSchedulingIgnoredDuringExecution:

- labelSelector:

matchExpressions:

- key: app

operator: In

values:

- kurator-controller-manager

topologyKey: "kubernetes.io/hostname"

containers:

- name: manager

image: kurator/kurator-controller-manager:v0.5.0

livenessProbe:

httpGet:

path: /healthz

port: 8081

四、从零开始:Kurator 实践指南

4.1 环境快速搭建

可以使用项目提供的脚本快速安装 Kurator,对于生产环境,更推荐使用 Helm 进行管理。

# 1. 克隆仓库并安装依赖

git clone https://github.com/kurator-dev/kurator.git

cd kurator

./scripts/install-dependencies.sh

# 2. 部署Kurator

./scripts/deploy-kurator.sh

# 3. 验证安装

kubectl get pods -n kurator-system

4.2 跨集群应用部署示例

以下是一个完整的 FederatedDeployment 示例,它将一个前端应用部署到北京和上海两个集群,并配置了相应的 Service 和 Ingress。

apiVersion: apps.kurator.dev/v1alpha1

kind: FederatedDeployment

metadata:

name: frontend-app

spec:

template:

spec:

replicas: 3

selector:

matchLabels:

app: frontend

template:

metadata:

labels:

app: frontend

spec:

containers:

- name: nginx

image: nginx:1.21

ports:

- containerPort: 80

placement:

clusters:

- name: cluster-beijing

replicas: 2

- name: cluster-shanghai

replicas: 1

---

apiVersion: v1

kind: Service

metadata:

name: frontend-service

spec:

selector:

app: frontend

ports:

- port: 80

targetPort: 80

---

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: frontend-ingress

spec:

rules:

- host: frontend.example.com

http:

paths:

- path: /

pathType: Prefix

backend:

service:

name: frontend-service

port:

number: 80

4.3 统一可观测性配置

运维多集群环境,统一的监控视图至关重要。Kurator 简化了 Thanos 的安装,可以轻松构建跨集群的监控系统。以下配置部署了一个高可用的 Prometheus,并集成 Thanos 用于长期存储和全局查询。

apiVersion: monitoring.coreos.com/v1

kind: Prometheus

metadata:

name: kurator-prometheus

spec:

replicas: 2

thanos:

image: quay.io/thanos/thanos:v0.24.0

五、未来展望

Kurator 社区持续演进,其技术路线图聚焦于 AI 原生支持、Serverless 集成、增强的多租户管理与安全合规等方向。

Kurator 未来发展方向

随着边缘智能、云边协同等趋势的发展,Kurator 这类能够统一管理异构分布式资源的平台,将成为企业构建下一代云原生基础设施的关键选择。通过拥抱并参与此类开源项目,开发者不仅能解决当下的架构难题,更能深入理解云原生与分布式系统的前沿实践。