一、服务容灾的核心目标与挑战

在微服务架构中,服务间的依赖关系日益复杂,“雪崩效应”的风险也随之增高。一旦某个服务节点出现故障或响应缓慢,其影响可能会像多米诺骨牌一样迅速扩散,导致整个系统瘫痪。因此,构建一套健壮的容灾体系,是保障微服务高可用性的生命线。

容灾体系的核心目标包括:

- 故障隔离:防止单个服务或组件的故障蔓延至整个系统。

- 快速恢复:在服务出现故障时,能迅速提供降级方案,确保核心业务流程的可用性。

- 弹性伸缩:能够根据系统负载自动或手动调整资源,从容应对突发流量冲击。

- 数据保全:确保关键业务数据在故障期间不丢失,服务恢复后能保持状态一致性。

二、服务容灾核心模式详细对比

| 容灾模式 |

核心目标 |

触发条件 |

实现方式 |

适用场景 |

| 熔断器 |

快速失败,防止连锁故障 |

错误率/慢调用超过阈值 |

状态机(关闭/打开/半开) |

依赖的下游服务不稳定 |

| 降级 |

保障核心功能可用 |

手动触发或监控系统自动触发 |

返回默认值、缓存、简化逻辑 |

非核心功能故障 |

| 限流 |

控制入口流量,保护系统 |

QPS、线程数、连接数超过限制 |

计数器、漏桶、令牌桶算法 |

突发流量、秒杀场景 |

| 隔离 |

资源隔离,避免相互影响 |

资源竞争激烈 |

线程池隔离、信号量隔离 |

保护数据库连接池等重要资源 |

| 重试 |

处理暂时性、可恢复的故障 |

调用失败、超时 |

指数退避、重试策略 |

网络抖动、服务短暂不可用 |

三、核心技术原理深度解析

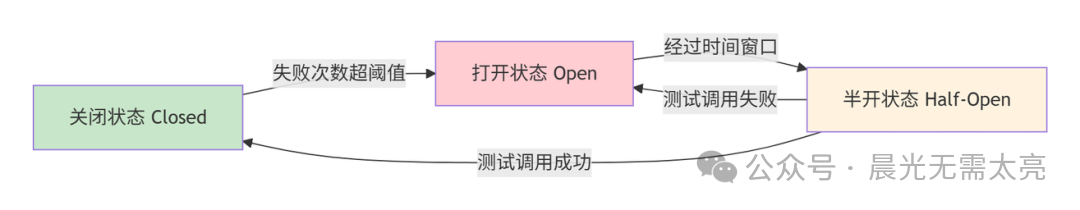

1. 熔断器模式

熔断器通过一个状态机来工作,其工作流程如下图所示:

代码实现(基于 Resilience4j):

@Slf4j

@Service

public class OrderService {

// 1. 定义熔断器

private final CircuitBreaker orderCircuitBreaker;

public OrderService() {

// 配置熔断器

CircuitBreakerConfig config = CircuitBreakerConfig.custom()

.failureRateThreshold(50) // 失败率阈值50%

.waitDurationInOpenState(Duration.ofSeconds(60)) // 打开状态等待60秒

.slidingWindowSize(10) // 滑动窗口大小10个请求

.build();

this.orderCircuitBreaker = CircuitBreaker.of("orderService", config);

}

// 2. 使用熔断器保护服务调用

public Order getOrder(Long orderId) {

return orderCircuitBreaker.executeSupplier(() -> {

// 实际的远程调用

return orderClient.getOrderById(orderId);

});

}

// 3. 带降级的熔断调用

public Order getOrderWithFallback(Long orderId) {

return CircuitBreaker.decorateSupplier(orderCircuitBreaker,

() -> orderClient.getOrderById(orderId))

.recover(throwable -> {

log.warn("订单服务熔断,返回降级数据", throwable);

return getCachedOrder(orderId); // 返回缓存数据

}).get();

}

}

2. 服务降级策略

一个健壮的降级策略通常是多级的,以保证在极端情况下仍能提供最基本的服务。

@Service

public class ProductService {

@Autowired

private ProductClient productClient;

@Autowired

private RedisTemplate redisTemplate;

@Autowired

private LocalCache localCache;

public ProductDTO getProductDetail(Long productId) {

try {

// 第一级:正常调用远程服务

return productClient.getProductDetail(productId);

} catch (Exception e) {

log.warn("商品服务调用失败,尝试降级方案", e);

// 第二级:查询Redis分布式缓存

ProductDTO cachedProduct = (ProductDTO) redisTemplate.opsForValue()

.get("product:" + productId);

if (cachedProduct != null) {

return cachedProduct;

}

// 第三级:查询应用本地缓存

ProductDTO localCached = localCache.get("product_" + productId);

if (localCached != null) {

return localCached;

}

// 第四级:返回静态的默认兜底数据

return createDefaultProduct(productId);

}

}

private ProductDTO createDefaultProduct(Long productId) {

ProductDTO defaultProduct = new ProductDTO();

defaultProduct.setId(productId);

defaultProduct.setName("商品信息加载中...");

defaultProduct.setPrice(BigDecimal.ZERO);

defaultProduct.setStatus(ProductStatus.UNAVAILABLE);

return defaultProduct;

}

}

3. 限流算法详解

令牌桶算法实现:

@Component

public class TokenBucketLimiter {

private final AtomicLong tokens;

private final long capacity; // 桶容量

private final long refillRate; // 每秒补充的令牌数

private long lastRefillTimestamp;

public TokenBucketLimiter(long capacity, long refillRate) {

this.capacity = capacity;

this.refillRate = refillRate;

this.tokens = new AtomicLong(capacity);

this.lastRefillTimestamp = System.currentTimeMillis();

}

public boolean tryAcquire() {

refillTokens(); // 补充令牌

while (true) {

long currentTokens = tokens.get();

if (currentTokens <= 0) {

return false; // 没有令牌,拒绝请求

}

if (tokens.compareAndSet(currentTokens, currentTokens - 1)) {

return true; // 获取令牌成功

}

}

}

private void refillTokens() {

long now = System.currentTimeMillis();

long duration = now - lastRefillTimestamp;

long newTokens = duration * refillRate / 1000; // 计算需要补充的令牌

if (newTokens > 0) {

lastRefillTimestamp = now;

tokens.updateAndGet(current -> {

long newTokenCount = current + newTokens;

return Math.min(newTokenCount, capacity); // 不超过桶容量

});

}

}

}

// 使用示例

@RestController

public class OrderController {

@Autowired

private TokenBucketLimiter orderLimiter;

@PostMapping("/orders")

public ResponseEntity<?> createOrder(@RequestBody OrderRequest request) {

// 限流检查

if (!orderLimiter.tryAcquire()) {

return ResponseEntity.status(429)

.body(Result.error("系统繁忙,请稍后重试"));

}

// 处理订单创建逻辑

return ResponseEntity.ok(orderService.createOrder(request));

}

}

4. 隔离策略实现

常见的隔离方式有线程池隔离和信号量隔离,二者各有适用场景。

@Configuration

public class IsolationConfig {

// 1. 线程池隔离 - 适合IO密集型或耗时较长的操作

@Bean("orderThreadPool")

public ThreadPoolTaskExecutor orderThreadPool() {

ThreadPoolTaskExecutor executor = new ThreadPoolTaskExecutor();

executor.setCorePoolSize(10);

executor.setMaxPoolSize(20);

executor.setQueueCapacity(50);

executor.setThreadNamePrefix("order-thread-");

executor.setRejectedExecutionHandler(new ThreadPoolExecutor.CallerRunsPolicy());

executor.initialize();

return executor;

}

// 2. 信号量隔离 - 适合CPU密集型或快速操作

@Bean

public Semaphore dbConnectionSemaphore() {

return new Semaphore(20); // 最大允许20个并发数据库连接

}

}

@Service

public class InventoryService {

@Autowired

@Qualifier("orderThreadPool")

private ThreadPoolTaskExecutor threadPool;

@Autowired

private Semaphore dbConnectionSemaphore;

// 线程池隔离示例:异步检查库存

@Async("orderThreadPool")

public CompletableFuture<Boolean> checkInventoryAsync(Long productId, Integer quantity) {

// 库存检查逻辑

boolean available = inventoryDao.checkStock(productId, quantity);

return CompletableFuture.completedFuture(available);

}

// 信号量隔离示例:保护数据库连接

public boolean updateInventory(Long productId, Integer quantity) {

boolean acquired = false;

try {

acquired = dbConnectionSemaphore.tryAcquire(1, TimeUnit.SECONDS);

if (!acquired) {

throw new RuntimeException("系统繁忙,请稍后重试");

}

// 执行数据库操作

return inventoryDao.updateStock(productId, quantity);

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

throw new RuntimeException("操作被中断", e);

} finally {

if (acquired) {

dbConnectionSemaphore.release();

}

}

}

}

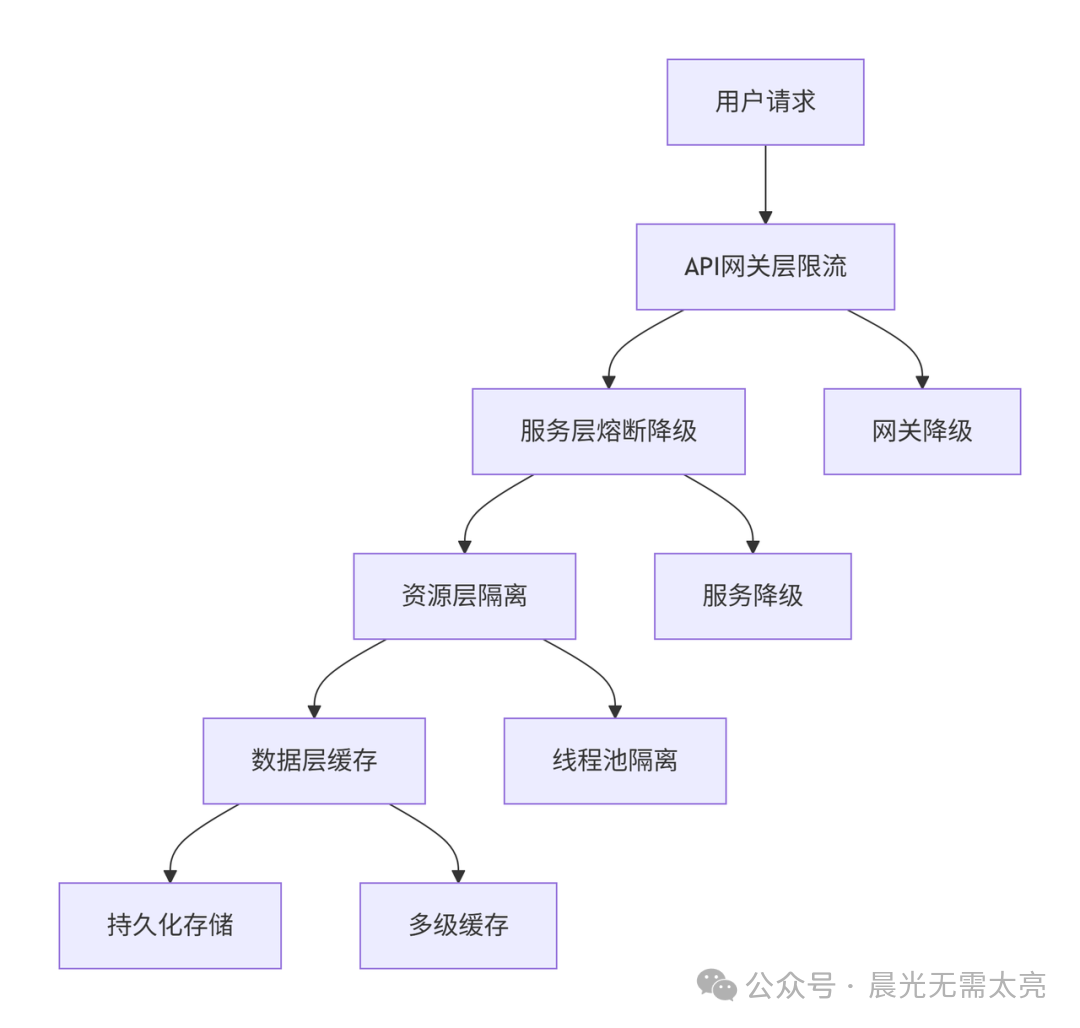

四、生产环境容灾架构

1. 多层次容灾防护体系

一个完善的微服务容灾体系应该是多层次的,从入口网关到具体服务调用,层层设防。

2. 基于 Sentinel 的全方位容灾配置

Sentinel 是阿里巴巴开源的流量控制与熔断降级组件,在 Spring Cloud 微服务体系中应用广泛。

YAML 配置示例:

# application.yml

spring:

cloud:

sentinel:

transport:

dashboard: localhost:8080 # Sentinel控制台地址

eager: true

datasource:

# 流控规则

flow:

nacos:

server-addr: localhost:8848

dataId: ${spring.application.name}-flow-rules

rule-type: flow

# 降级规则

degrade:

nacos:

server-addr: localhost:8848

dataId: ${spring.application.name}-degrade-rules

rule-type: degrade

# 系统保护规则

system:

nacos:

server-addr: localhost:8848

dataId: ${spring.application.name}-system-rules

rule-type: system

Nacos 中存储的规则配置示例:

// order-service-flow-rules 限流规则

[

{

"resource": "createOrder",

"count": 100,

"grade": 1, # 1代表QPS限流模式

"limitApp": "default",

"strategy": 0,

"controlBehavior": 0

}

]

// order-service-degrade-rules 熔断降级规则

[

{

"resource": "getProductInfo",

"count": 5000, # 慢调用临界响应时间5000ms

"grade": 0, # 0代表按慢调用比例熔断

"timeWindow": 10, # 熔断恢复时间窗口10s

"minRequestAmount": 5,

"statIntervalMs": 1000,

"slowRatioThreshold": 0.5 # 慢调用比例阈值50%

}

]

3. 基于 Hystrix 的容灾实现

虽然 Hystrix 已进入维护模式,但其设计思想依然值得学习。

@Service

public class PaymentService {

// 1. 使用命令模式封装受保护的方法

@HystrixCommand(

fallbackMethod = "processPaymentFallback",

commandProperties = {

@HystrixProperty(name = "execution.isolation.thread.timeoutInMilliseconds", value = "5000"),

@HystrixProperty(name = "circuitBreaker.requestVolumeThreshold", value = "20"),

@HystrixProperty(name = "circuitBreaker.errorThresholdPercentage", value = "50"),

@HystrixProperty(name = "circuitBreaker.sleepWindowInMilliseconds", value = "5000")

},

threadPoolProperties = {

@HystrixProperty(name = "coreSize", value = "10"),

@HystrixProperty(name = "maxQueueSize", value = "100")

}

)

public PaymentResult processPayment(PaymentRequest request) {

// 实际的支付处理逻辑

return paymentClient.process(request);

}

// 2. 降级方法

public PaymentResult processPaymentFallback(PaymentRequest request) {

log.warn("支付服务降级,订单进入待支付状态");

// 将支付请求记录到本地数据库或消息队列,等待后续异步重试

asyncPaymentService.recordPendingPayment(request);

return PaymentResult.pending();

}

}

五、容灾策略选型与最佳实践

不同场景下的容灾方案

| 业务场景 |

核心风险 |

推荐容灾策略 |

技术实现要点 |

| 电商下单 |

库存服务超时导致订单失败 |

熔断 + 降级 + 异步重试 |

熔断快速失败,本地记录订单,异步同步库存 |

| 支付系统 |

第三方支付通道不稳定 |

限流 + 熔断 + 事务补偿 |

网关层限流,TCC/SAGA补偿事务保证最终一致性 |

| 秒杀活动 |

瞬时流量远超系统处理能力 |

多层次限流 + 队列削峰 |

网关层限流,请求入消息队列,后台异步处理 |

| 数据查询 |

复杂查询导致数据库压力过大 |

缓存降级 + 查询熔断 |

前置多级缓存,慢查询自动熔断,返回默认结果集 |

| 文件处理 |

大文件上传下载阻塞线程 |

线程池隔离 + 超时控制 |

使用独立线程池处理文件IO,设置合理的超时时间 |

容灾配置最佳实践

使用 Resilience4j 进行统一的容灾配置管理是一个不错的选择。

@Configuration

public class ResilienceConfig {

@Bean

public CircuitBreakerConfig circuitBreakerConfig() {

return CircuitBreakerConfig.custom()

.failureRateThreshold(50) // 失败率阈值50%

.slowCallRateThreshold(50) // 慢调用率阈值50%

.slowCallDurationThreshold(Duration.ofSeconds(2)) // 慢调用定义为响应超过2秒

.waitDurationInOpenState(Duration.ofSeconds(60)) // 熔断打开60秒后进入半开状态

.permittedNumberOfCallsInHalfOpenState(10) // 半开状态允许试探10个请求

.minimumNumberOfCalls(10) // 最小统计样本数

.slidingWindowType(SlidingWindowType.TIME_BASED) // 基于时间的滑动窗口

.slidingWindowSize(100) // 滑动窗口大小为100个请求

.build();

}

@Bean

public RateLimiterConfig rateLimiterConfig() {

return RateLimiterConfig.custom()

.limitForPeriod(100) // 每个周期限制100个请求

.limitRefreshPeriod(Duration.ofSeconds(1)) // 限流周期为1秒

.timeoutDuration(Duration.ofMillis(500)) // 获取许可的超时时间为500ms

.build();

}

@Bean

public RetryConfig retryConfig() {

return RetryConfig.custom()

.maxAttempts(3) // 最大重试3次(包含首次调用)

.waitDuration(Duration.ofMillis(500)) // 重试间隔500ms

.retryOnException(throwable ->

throwable instanceof TimeoutException ||

throwable instanceof SocketTimeoutException) // 仅对超时异常重试

.build();

}

}

六、面试回答要点

深度回答框架

在面试中,不应只罗列概念,而应展现系统性的思考。可以这样组织回答:

“微服务容灾是一个体系化的工程。我们通常从四个层面来构建防护体系:

1. 预防层面:通过网关和应用层限流(如令牌桶、漏桶算法),在流量入口控制请求速率,防止系统因突发流量而瘫痪。

2. 控制层面:在服务间调用时,使用熔断器(如Sentinel、Resilience4j)实现快速失败。一旦检测到下游服务不稳定,立即熔断并执行预定义的降级逻辑(如返回缓存、默认值或简化流程),确保核心链路可用。

3. 隔离层面:采用资源隔离策略。对耗时操作(如远程调用)使用线程池隔离,避免其占满公共线程资源;对快速操作(如本地计算)使用信号量隔离,控制并发度。这能有效阻止故障蔓延。

4. 恢复层面:设计智能重试机制(如指数退避)和合理的超时控制,以应对网络抖动等临时性故障。同时,配合全链路追踪系统(如SkyWalking),确保能快速定位和恢复故障。

以我们之前的电商项目为例,订单服务使用Sentinel配置了QPS限流和慢调用比例熔断;支付服务使用Hystrix进行线程池隔离,并在熔断后将支付请求降级到本地事务记录表进行异步补偿。这套方案在‘双十一’大促期间,有效保障了系统的整体稳定和高可用性。”

常见追问及回答思路

-

熔断和降级的区别?

- 熔断是自动的故障检测和快速失败机制,是一种状态。它关注的是依赖服务是否可用,目标是防止故障扩散。

- 降级是功能性的备选方案,可以是手动或自动触发。它关注的是当前功能如何以可控的方式降低标准,目标是保证核心业务流程继续。

- 两者常结合使用:熔断触发后,通常会执行降级逻辑。

-

如何确定限流的阈值?

- 基准值获取:通过全链路压测(如使用JMeter),找出单实例或集群在保证可接受响应时间下的最大吞吐量(QPS/TPS)。

- 动态调整:结合实时监控系统(如Prometheus + Grafana),观察CPU、内存、线程池等关键指标,动态调整限流阈值。

- 预留缓冲:线上设置的阈值通常为压测最大值的70%-80%,预留20%-30%的安全余量以应对波动。

-

服务隔离有哪些方式?

- 线程池隔离:为不同的依赖服务分配独立的线程池。优点是隔离彻底,一个服务的慢调用不会影响其他服务;缺点是线程上下文切换有一定开销。适合耗时IO操作。

- 信号量隔离:通过计数器(Semaphore)限制对某个资源(如数据库连接)的并发访问数。优点是开销极小;缺点是无法对等待的请求做超时控制。适合CPU密集型或快速操作。

- 物理/逻辑隔离:将不同重要级别的服务部署到不同的Kubernetes集群、命名空间或虚拟机,实现物理或逻辑上的完全隔离,这是最彻底的方式。

-

容灾配置的注意事项?

- 避免“过度保护”:配置过于激进的熔断或限流规则,可能导致大量正常请求被拒绝,反而影响用户体验和业务。规则启用初期建议设置较高的触发阈值,逐步调优。

- 降级数据需合理:降级返回的数据(如默认值、缓存旧数据)应设计合理,不能误导用户或引发业务逻辑错误。例如,商品价格降级应显示为“暂不可用”而非“0元”。

- 监控告警必须到位:任何容灾规则的触发(如熔断开启、限流生效)都应配置清晰的监控指标和告警(接入钉钉、短信等),以便开发运维人员能及时感知并介入处理。