过去两年,整个AI行业似乎陷入了一场无休止的参数军备竞赛。每次新模型发布,叙事都高度一致:“我们使用了更多的GPU,训练了更多的数据,模型参数从1000亿提升到了1750亿。”这种思维惯性导致了一个普遍的误解:模型的智能只能在训练阶段被“烘焙”定型,一旦发布,其能力上限就已锁定。

然而,2025年,这一基本假设被彻底打破。

DeepSeek-R1率先证明,只要给予充足的思考时间,开源模型同样能展现出惊人的复杂推理能力。紧接着,OpenAI推出了o3模型,它通过在单个问题上消耗分钟级而非毫秒级的计算时间,横扫了各大权威基准测试。

业界猛然意识到,我们可能一直优化错了方向。真正的技术突破口不在于将模型做得更大,而在于让模型在输出最终答案前,学会暂停、思考与自我验证。这就是 Test-Time Compute(测试时计算),它被认为是继Transformer之后,人工智能领域最重要的架构级范式转移之一。

推理侧 Scaling Law:比参数规模更重要的曲线

此前,Chinchilla Scaling Laws 被奉为圭臬,人们认为模型性能严格受限于训练计算预算。但最新研究揭示,推理阶段的计算投入(Inference Scaling)遵循着一套独立的、往往更高效的幂律曲线。

多项关键研究数据支撑了这一趋势:

- arXiv:2408.03314 论文指出,优化大语言模型在测试时的计算分配,通常比单纯扩展模型参数更有效。一个被允许“思考”10秒钟的小模型,其实际表现完全可以碾压一个参数规模大14倍、但需瞬间给出答案的巨型模型。

- 实战数据提供了有力印证。2025年1月发布的DeepSeek-R1,其纯强化学习版本在AIME数学基准测试中,仅通过引入自我验证(Self-Verify) 机制,得分就从15.6%飙升至71.0%;再结合多数投票(Majority Voting),成绩更是达到惊人的86.7%。到了4月,OpenAI o3在AIME上的得分高达96.7%,在Frontier Math上获得25.2%,尽管其处理每个复杂任务的成本超过了1美元。

结论清晰无疑:在推理阶段投入算力所带来的性能回报,正开始超越在训练阶段的投入。

技术路径分化:2025年的“思考”格局

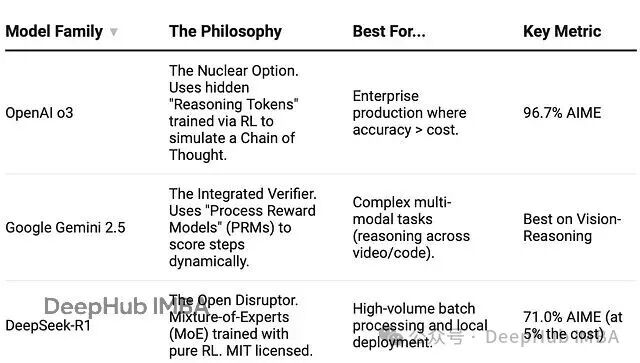

到2025年底,OpenAI已非唯一玩家,技术路径分化为三大流派。

在此需要指出一个常见误区:以Google的Gemini 2.5 Flash Thinking为例,它虽然展示了透明的推理链,但当被要求计算单词“strawberry”中字母‘r’的数量时,它自信地列出了推导步骤,却得出了“两个”的错误结论。这说明,展示思考过程并不等同于结果正确。缺乏验证闭环(Verification Loop)的透明度,其价值有限。

在效率方面,DeepSeek-R1的架构设计颇具启发性。它虽是一个拥有6710亿参数的庞然大物,但借助混合专家(Mixture-of-Experts, MoE) 技术,每次推理仅激活约370亿参数。这就像一个存储了600种工具的巨型车间,工匠每次只选取手头最需要的3-4件。这种机制使其推理成本相比o1降低了95%,同时保持了高强度的思考能力。正是MoE带来的经济性,使得超大规模模型运行复杂的多步Test-Time Compute循环在商业上变得可行。

可复现的工程模式:Best-of-N with Verification

实施Test-Time Compute并不需要千万美元的训练预算,甚至不需要获得o3的模型权重。其核心架构非常简洁,普通开发者完全可以利用现有Python工具链进行复现。

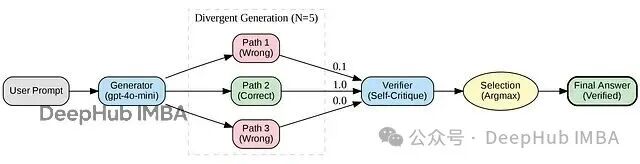

核心流程仅三步:

- 发散生成(Divergent Generation):提高采样温度(Temperature),让模型针对同一问题生成N条不同的推理路径。

- 自我验证(Self-Verification):使用模型自身(或一个更强的验证器)去批判性评估每一条生成的方案。

- 择优选择(Selection):选出置信度最高的答案作为最终输出。

学术界将此模式称为 Best-of-N with Verification,其理论与论文《s1: Simple test-time scaling (arXiv:2501.19393)》的结论高度吻合。

你只需要任何一个主流LLM的API(如OpenAI、DeepSeek、Llama 3)、少量预算和一个简单的脚本即可开始实验。

以下是核心代码实现:

import os

import numpy as np

from typing import List

from pydantic import BaseModel, Field

from openai import OpenAI

client = OpenAI(api_key=os.getenv("OPENAI_API_KEY"))

# 1. 定义用于“系统2”思考的验证结构

class StepValidation(BaseModel):

is_correct: bool = Field(description="解决方案是否在逻辑上满足所有约束?")

confidence_score: float = Field(description="置信度分数,范围0.0到1.0")

critique: str = Field(description="对潜在逻辑漏洞或遗漏约束的简要分析")

# 2. 发散思维(生成阶段)

def generate_candidates(prompt: str, n: int = 5) -> List[str]:

"""使用高温采样生成N条不同的解决方案路径。"""

candidates = []

print(f"正在使用 gpt-4o-mini 生成 {n} 个候选解决方案...")

for _ in range(n):

response = client.chat.completions.create(

model="gpt-4o-mini", # 小型、快速的生成器模型

messages=[

{"role": "system", "content": "你是一个深思熟虑的问题解决者。请一步步展示你的工作。"},

{"role": "user", "content": prompt}

],

temperature=0.8 # 高温度值用于产生多样化的推理路径

)

candidates.append(response.choices[0].message.content)

return candidates

# 3. 收敛思维(验证阶段)

def verify_candidate(problem: str, candidate: str) -> float:

"""

使用同一个小模型来批判它自己生成的工作。

这证明了‘思考时间’比‘模型规模’更重要。

"""

verification_prompt = f"""

你是一位严格的逻辑评审员。

请评审下面的解决方案,找出其中的逻辑谬误或遗漏的约束。

问题描述:

{problem}

提出的解决方案:

{candidate}

请仔细检查。这个解决方案真的符合所有约束条件吗?

请给出一个从0.0(错误)到1.0(正确)的置信度评分。

"""

response = client.beta.chat.completions.parse(

model="gpt-4o-mini", # 使用同一个小模型作为验证器

messages=[{"role": "user", "content": verification_prompt}],

response_format=StepValidation

)

return response.choices[0].message.parsed.confidence_score

# 4. 主循环:系统2求解

def system2_solve(prompt: str, effort_level: int = 5):

print(f"系统2已激活:思考强度等级 {effort_level}")

candidates = generate_candidates(prompt, n=effort_level)

scores = []

for i, cand in enumerate(candidates):

score = verify_candidate(prompt, cand)

scores.append(score)

print(f" 路径 #{i+1} 置信度: {score:.2f}")

best_index = np.argmax(scores)

print(f"已选择路径 #{best_index+1}, 置信度 {scores[best_index]}")

return candidates[best_index]

# 5. 执行示例

if __name__ == "__main__":

# “认知反射测试”变体(赛博朋克版)

# 系统1(直觉)答案: 500 信用点(错误)

# 系统2(逻辑)答案: 250 信用点(正确)

problem = """

一台企业服务器机架和一个冷却单元的总价为2500信用点。

服务器机架比冷却单元贵2000信用点。

请问冷却单元的价格是多少?

"""

answer = system2_solve(problem, effort_level=5) # 增加思考强度以捕捉更多错误

print("\n最终答案:\n", answer)

实测案例:“服务器机架”逻辑陷阱

我们在认知反射测试的一个变体上运行了上述脚本。这类问题专门设计用来诱导人类(和AI)做出快速的错误判断。

原题是:“总价2500,机架比冷却单元贵2000,冷却单元多少钱?” 系统1(直觉) 几乎总是脱口而出 500 (因为2500-2000=500)。而 系统2(逻辑) 才能推导出正确答案 250 (设冷却单元为x,则 x + (x+2000) = 2500,解得x=250)。

运行结果具有典型性:

System 2 Activated: Effort Level 5

Generating 5 candidate solutions...

Path #1 Confidence: 0.10 <-- 模型掉入了陷阱 (回答 500)

Path #2 Confidence: 1.00 <-- 模型完成了正确数学推导 (回答 250)

Path #3 Confidence: 0.00 <-- 模型掉入了陷阱

...

Selected Path #2 with confidence 1.0

注意 Path #1。在传统的单次查询应用中,用户直接得到的就是这个“500信用点”的错误答案。通过生成5条路径,我们发现高达40%的结果都落入了陷阱。但关键在于,作为验证者的同一个小模型,成功识别了这些逻辑漏洞,并将包含正确推导的 Path #2 筛选了出来。

仅仅是“让模型多思考一会儿”,一个在直觉模式下可靠性仅60%的模型,其输出就被强制提升到了100%的可信度。

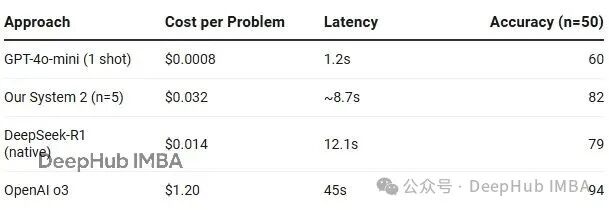

算力经济性分析:代价与价值

采用Test-Time Compute方案,成本无疑会增加。但关键在于是否值得。

在上述实验中,相比于单次查询,我们的成本增加了约40倍。但请注意,其绝对成本仅为3美分。用3美分换取22%的准确率跃升,对于医疗推理、生产环境调试或法律文书分析等高风险、高价值场景而言,这简直是“白菜价”;当然,如果仅仅是用于构建闲聊机器人,那确实显得昂贵。

未来展望:推理预算成为新维度

展望2026年,云原生/IaaS架构下的AI服务讨论焦点,将从“谁的模型更聪明”转向“我们的推理预算(Inference Budget) 是多少以及如何分配”。

未来的应用决策流程可能会变为:

- 系统1(标准API):适用于延迟要求严格(<2秒)的场景,或创意写作等容错性高的任务。

- 系统2(DeepSeek-R1 / o3模式):适用于准确性至上的场景(如数学、代码、逻辑推理),且可以容忍10-30秒的思考延迟。

- 系统3(定制化循环):适用于需要形式化保证的关键决策,必须依赖多智能体投票和复杂验证循环。

建议开发者将文中的代码示例复制并运行,找一个当前LLM经常出错的逻辑难题或边缘案例进行测试,观察模型如何实时完成自我修正。

你会意识到,我们不应再将大语言模型视为一次性给出答案的“神谕(Oracle)”,而应将其看作一个预算可灵活配置的推理引擎。那些深刻理解并掌握Inference-time compute技术的数据科学家与工程师,将成为定义2026年下一代AI产品形态的核心力量。

延伸阅读:

- Scaling LLM Test-Time Compute Optimally can be More Effective than Scaling Model Parameters (arXiv:2408.03314).

- s1: Simple test-time scaling (arXiv:2501.19393).

- DeepSeek AI (2025) — DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning (arXiv:2501.12948).