你有没有想过,让AI看完一部2小时的电影,然后告诉你某个镜头出现在第几分钟?或者给AI一张手机截图,它能自动帮你点击按钮完成操作?

阿里云通义千问团队开源的 Qwen3-VL 正在把这些场景变成现实。这个第三代多模态模型,不仅能"看懂"图片和视频,还能精确定位时间点、操控界面、理解3D空间关系。

一、核心能力解析

1. 超长上下文记忆

Qwen3-VL 原生支持 256K token上下文,可扩展至1M。具体来说:

- 可以处理数小时的视频内容

- 一次性阅读整本技术文档

- 保持完整的多轮对话历史

传统模型处理长视频时需要切成片段分析,容易丢失上下文信息。而 Qwen3-VL 能保持完整记忆,就像人类看完整部电影后回答问题一样自然。

2. 视觉Agent能力

模型可以理解PC和移动端的GUI界面,识别按钮、输入框等控件的位置,并执行操作指令。

实际应用场景:

- 自动化测试:让AI操作APP完成测试流程

- 辅助操作:通过语音指令"帮我打开设置里的WiFi",AI自动完成点击

3. 精确的时间定位

在视频分析中,模型不仅能描述内容,还能给出秒级精度的时间戳。

举个例子:

- 问:"视频中何时出现红色汽车?"

- 答:"在01:23:15和02:47:32两个时间点"

这对会议记录、视频内容索引等场景特别实用。

4. 增强的OCR能力

支持 32种语言的文字识别(前代仅10种),并且能处理:

- 低光照环境下的文字

- 模糊或倾斜的文本

- 复杂背景下的文字提取

二、技术创新点

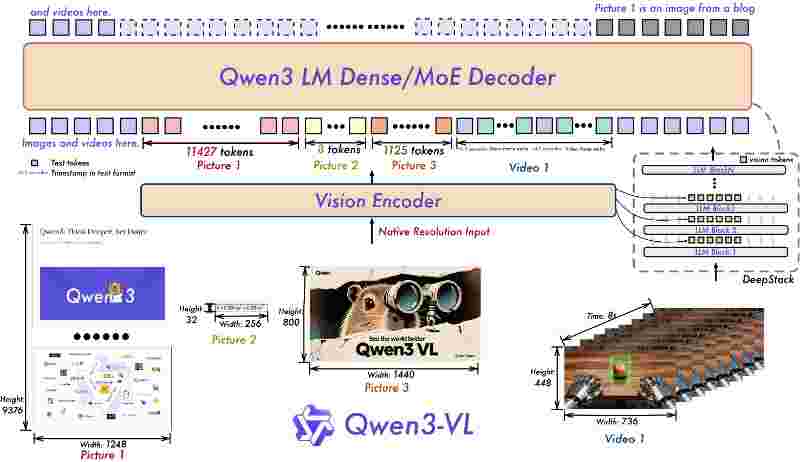

Interleaved-MRoPE(交错式位置编码)

传统模型处理视频时,容易混淆不同帧的位置关系。Qwen3-VL 通过为时间、高度、宽度三个维度分配独立的位置编码,实现更准确的时空建模。

通俗点说,就像给视频的每一帧打上"时间戳+坐标"标签,模型能清楚知道"这个物体在第10秒时出现在画面左上角"。

DeepStack(深度特征融合)

从视觉编码器的多个层级提取特征并融合,而不是只用最后一层。

这样做的好处是:

- 浅层特征捕获细节(如文字边缘、纹理)

- 深层特征理解语义(如"这是一只猫")

- 融合后既有细节又有全局理解

文本-时间戳对齐

在处理视频时,模型会为每个文本描述关联精确的视频帧时间点,而不是模糊地说"视频中出现了某物"。

三、模型规格与部署

Qwen3-VL 提供多个版本:

- 4B/8B 指令模型:适合边缘设备和实时应用

- 30B A3B 思考模型:支持复杂推理任务

- FP8量化版本:降低显存占用,提升推理速度

部署方面:

- 支持 HuggingFace Transformers 直接加载

- 提供 vLLM、SGLang 等推理框架适配

- 可在消费级GPU上运行(8B模型约需16GB显存)

四、实际应用场景

| 场景 |

应用方式 |

| 视频内容分析 |

会议记录自动生成时间轴摘要 |

| 文档处理 |

扫描件OCR + 多语言翻译 |

| 自动化测试 |

GUI自动化操作与验证 |

| 教育辅助 |

分析课程视频并生成知识点索引 |

| 辅助功能 |

为视障用户描述屏幕内容并执行操作 |

五、开源意义

Qwen3-VL 的开源让多模态AI能力不再是大厂专属。开发者可以:

- 在自己的应用中集成视觉理解能力

- 针对特定领域进行微调(如医疗影像、工业检测)

- 研究多模态模型的架构设计

相比闭源的商业模型,开源方案在数据隐私、成本控制、定制化方面有明显优势。

📢 关注《异或Lambda》

主打AI与未来生产力

今天的科幻,明天的日常 —— AI改造世界进行时

我们持续追踪前沿AI项目,解读技术趋势,探索生产力工具的未来形态。

🔗 项目资源

GitHub仓库:

https://github.com/QwenLM/Qwen3-VL

官方文档:

https://qwen.ai/blog

https://huggingface.co/docs/transformers/main/model_doc/qwen3_vl

模型下载:

https://huggingface.co/Qwen

🏷️ 标签:#Qwen3VL #Github #多模态AI #开源模型 #计算机视觉 #视觉Agent #阿里云通义千问