在语音交互系统中,最关键的一步往往不是识别内容本身,而是先精准判断“是否有人在说话”。这一步技术称为VAD(语音活动检测)。一个高效的VAD模块能显著降低系统延迟、减少无效音频处理带来的计算开销,并使语音起止点的判定更为精确,从而全面提升语音链路的用户体验。

近期在GitHub上出现了一款专为实时语音流设计的开源VAD工具——TEN VAD。它能够快速、稳定地检测语音的起始与结束,旨在让语音助手、实时语音识别(STT)以及对话式AI的交互体验更加流畅自然。

项目简介

TEN VAD是一款面向实时语音流的轻量级语音活动检测器。它基于深厚的实时语音处理技术积累,专注于在各种复杂声学环境下精准识别并定位人声。无论是有效过滤背景噪声,还是精确判断说话人的自然停顿与语句结束,TEN VAD都能提供可靠支持,帮助开发者构建响应迅捷、交互流畅的AI语音应用。

简而言之,它可以被视作AI系统的“智能耳朵”,负责精确侦听用户何时开始说话、何时讲话完毕,是语音识别流程前的第一道关卡。

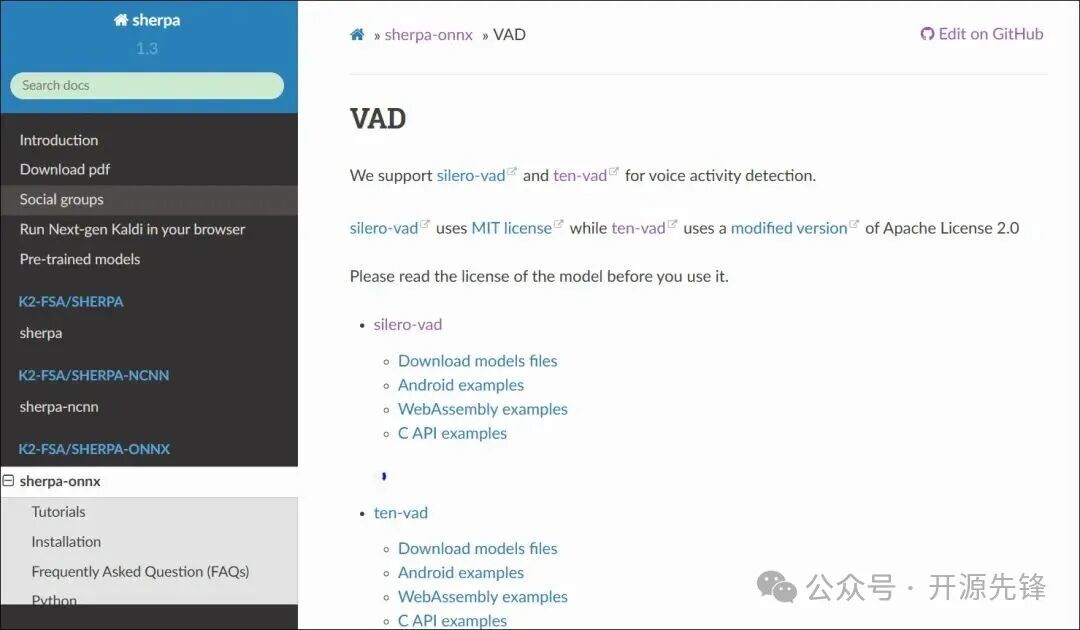

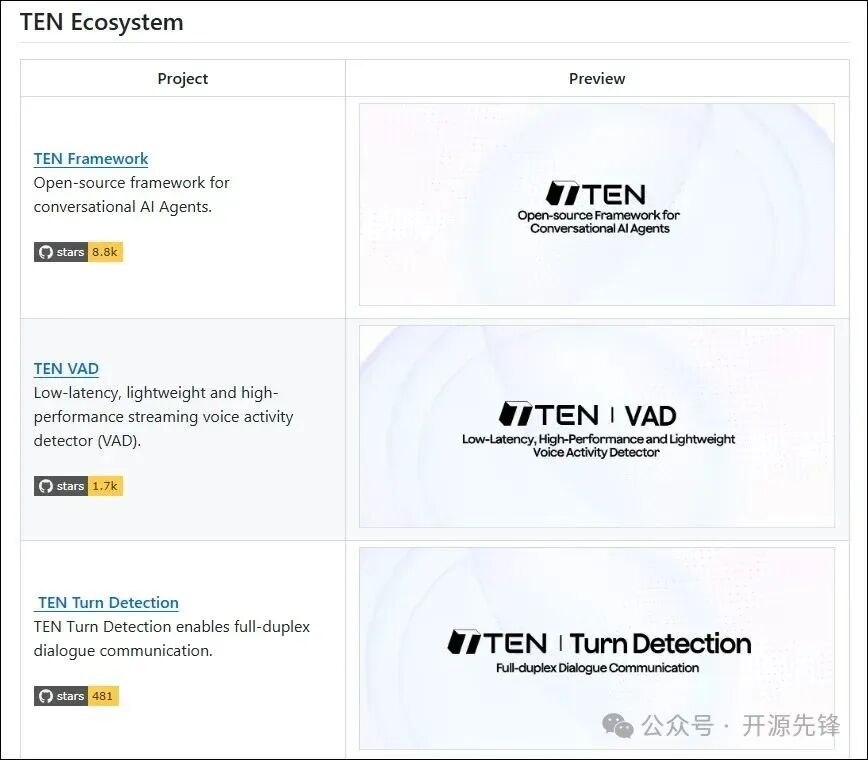

作为GitHub Trending的上榜项目,它不仅是替代WebRTC VAD和Silero VAD的优秀方案,更已被语音识别领域的权威框架Kaldi(具体为k2-fsa/sherpa-onnx项目)集成,成为其官方支持的唯二VAD选项之一,这充分证明了其可靠性与高性能。

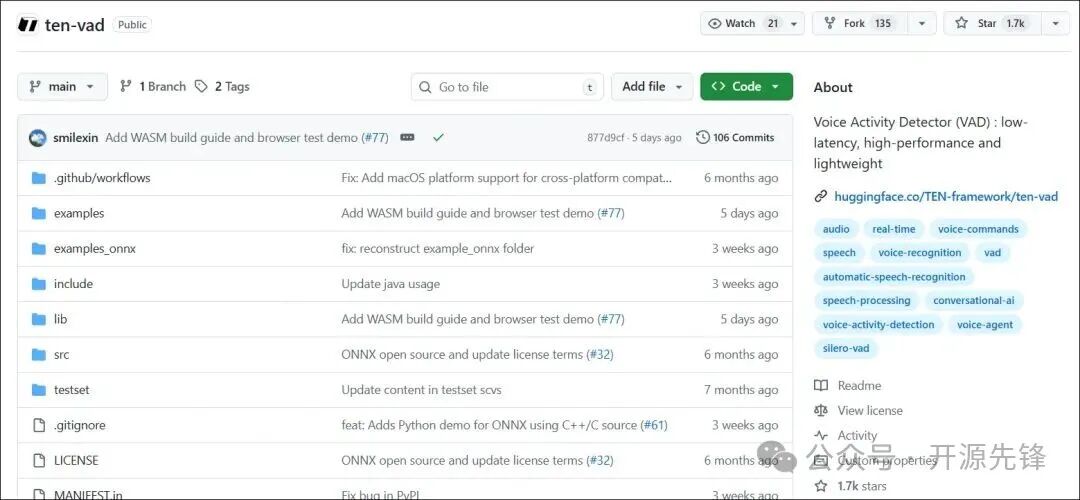

目前,该项目在GitHub上已收获近2k星标,关注度持续攀升。

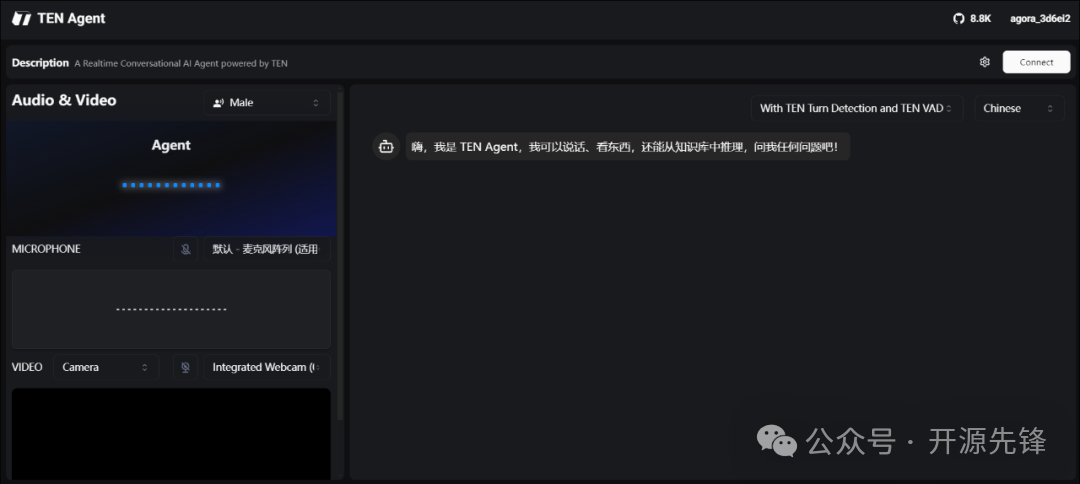

项目体验展示

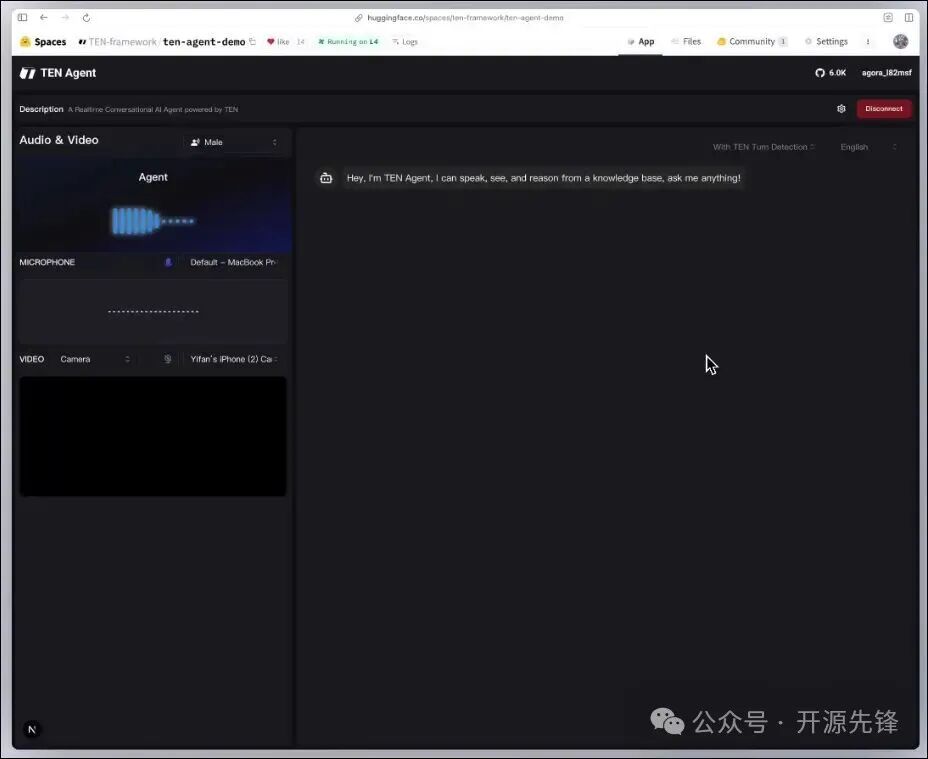

对于希望快速体验TEN VAD效果的开发者,推荐使用Hugging Face Space上提供的在线演示。

https://huggingface.co/spaces/TEN-framework/ten-agent-demo

访问上述链接即可在线体验TEN VAD的实时语音检测能力。

测试表明,在中英文混合语境下,TEN VAD结合其TEN Turn Detection(对话轮次检测)功能后,表现尤为出色。它能够自然地判断用户是正在思考中的短暂停顿,还是已完成发言等待回复,而非机械地抢答或中断用户。

此外,它具备极强的抗干扰能力,键盘敲击声、背景交谈或远处音乐等常见噪音均不易引发误触发,从而避免了AI的“胡乱插话”。

这种拟人化的实时交互体验,显著优于许多常规的AI语音工具。

功能特性

- 超低延迟:能极速检测语音的开始与结束,相比Silero VAD有数百毫秒的响应优势,使智能体(Agent)反应更为迅捷。

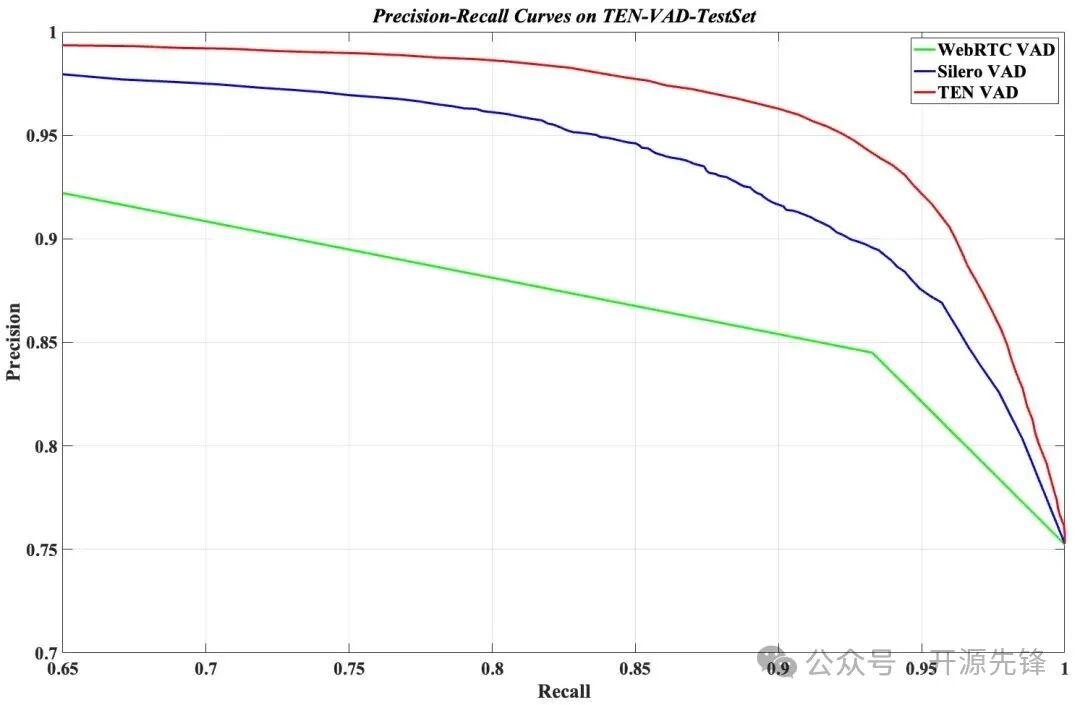

- 高准确率:在公开测试集上,其精准度-召回率曲线优于WebRTC VAD和Silero VAD,误触发和漏触发的情况更少。

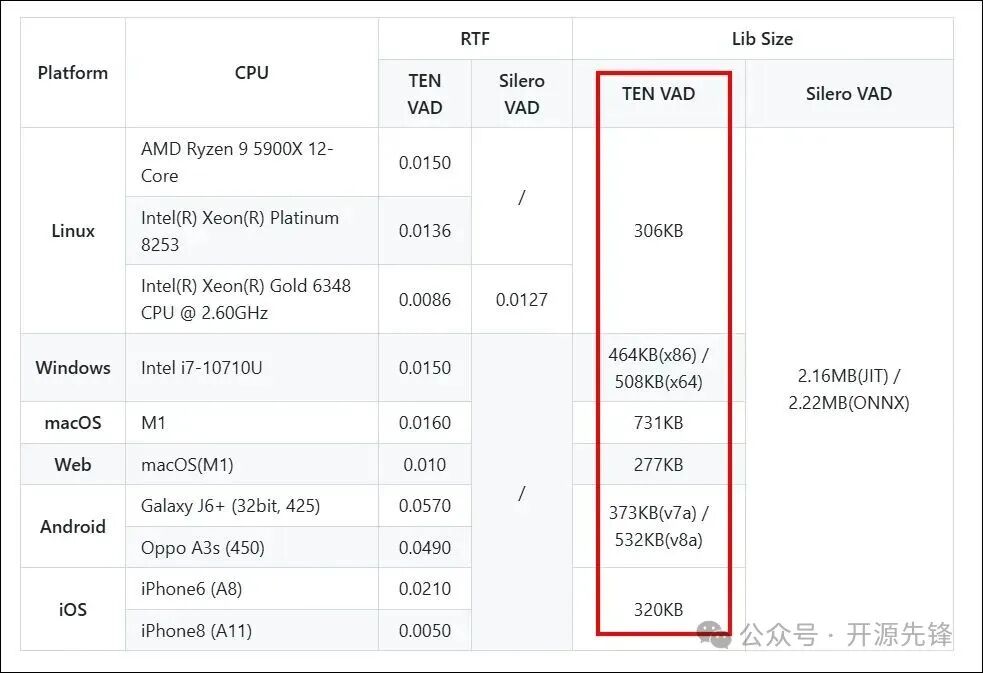

- 极致轻量与低功耗:Linux平台动态库体积仅306KB,计算复杂度低,内存占用少,适合边缘设备部署;在不同性能的CPU上均能保持较低的RTF(实时因子),无需GPU即可流畅运行,对老旧设备友好。

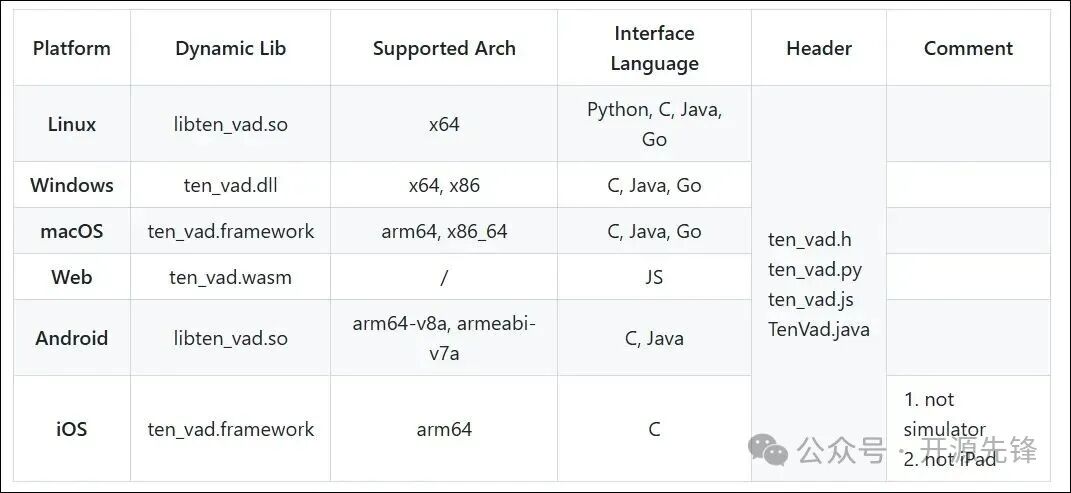

- 跨平台灵活部署:支持Windows、Linux、macOS等六大主流平台,并提供多语言接口。模型采用ONNX格式,可在多种硬件上直接推理,集成简便。

- 灵活适配音频参数:默认支持16kHz音频输入,提供160采样点(10ms)和256采样点(16ms)两种优化帧配置选项,其他采样率可通过重采样兼容,满足不同实时处理场景的需求。

- 强大的生态整合:作为TEN Framework的重要组成部分,它可以与框架内的对话状态管理、轮次检测等组件无缝协同,为构建复杂的语音交互应用提供坚实基础。

快速安装与使用

TEN VAD提供了覆盖全平台、支持多语言的本地化部署方案,无需复杂配置。

以Python为例,可以通过git克隆或pip两种方式安装:

# 方式1:git克隆

git clone https://github.com/TEN-framework/ten-vad.git

cd ten-vad/examples

pip install -r requirements.txt

# 方式2:pip直接安装

pip install -U --force-reinstall -v git+https://github.com/TEN-framework/ten-vad.git

在Linux系统上可能需要安装额外的运行库:

sudo apt update && sudo apt install libc++1

基础调用示例非常简洁,三步即可完成,开发者无需深入底层细节:

# 1. 导入模块

from ten_vad import TenVad

import numpy as np

# 2. 初始化VAD实例

vad = TenVad()

# 3. 处理音频(输入需为16kHz采样率的PCM音频数据)

audio_data = np.fromfile("test.wav", dtype=np.int16) # 加载音频文件

probability, is_speech = vad.process(audio_data)

print(f"语音概率:{probability:.2f},是否为语音:{is_speech}")

对于流式处理场景,可以直接使用项目提供的示例脚本:

# 测试音频文件并将结果输出到文本文件

python test.py s0724-s0730.wav out.txt

此外,它也支持在JavaScript/Node.js/Web环境中使用,可通过npm直接安装。同时也提供了对原生C、C++、Java (JNI) 的支持,便于在不同技术栈的项目中集成。对于使用Node.js进行后端开发的团队来说,集成同样便捷。

小结

语音活动检测(VAD)是构建自然语音交互系统的“第一道门槛”,其性能直接决定了AI助手的“听感”与最终用户体验。TEN VAD凭借其低延迟、高准确、轻量级和跨平台的核心优势,有效解决了传统VAD工具的一些常见痛点。无论是个人开发者进行快速原型验证,还是企业级项目的生产环境落地,它都能提供良好的适配性。

该项目目前仍在积极迭代中,未来计划扩展更多语言支持和场景适配。如果你正在开发语音助手、实时音视频通话、AI客服等相关应用,不妨尝试集成这款开源工具,短短几分钟即可完成部署,有望让你产品的语音交互体验迈上一个新台阶。

更多详细功能与更新,请访问项目GitHub仓库查看:

https://github.com/ten-framework/ten-vad