Nginx作为现代大型分布式架构的基石,其性能表现直接决定了整个系统的吞吐能力。要实现性能的指数级提升,关键在于充分压榨硬件潜力,并对连接处理机制进行深度优化。以下是几个决定性的核心配置项。

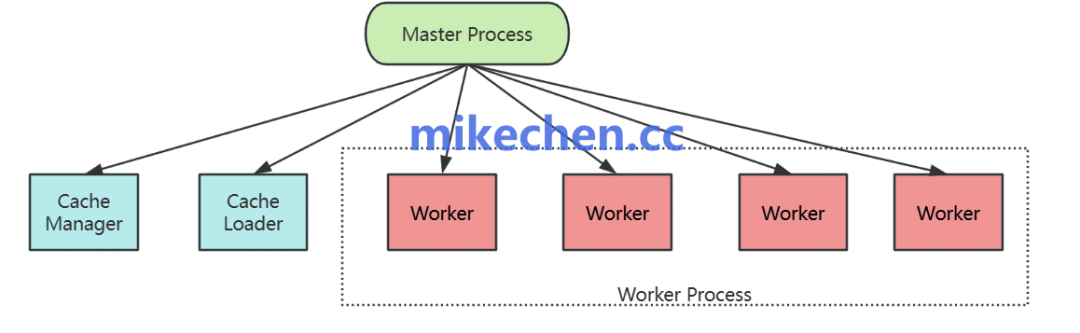

一、worker_processes —— 榨干多核CPU性能

Nginx采用单线程、异步非阻塞的事件驱动模型。要最大化硬件性能,必须让Nginx的工作进程数与CPU核心数相匹配,实现真正的并行处理。

优化配置:

worker_processes auto; # 自动检测并设置为CPU核心数

worker_cpu_affinity auto; # 自动绑定工作进程到特定CPU核心,减少上下文切换开销

将worker_processes设置为auto,Nginx会自动根据服务器的CPU核心数启动对应数量的工作进程,这是充分利用多核Linux系统计算资源的基础。

二、worker_connections —— 突破系统连接数瓶颈

在高并发场景下,单机面临的第一个瓶颈往往是操作系统的文件描述符(File Descriptor)限制。在Linux中,每个TCP连接都被视作一个文件。

核心配置与公式:

worker_rlimit_nofile 65535; # 提升单个worker进程能打开的最大文件数限制

events {

worker_connections 10240; # 单个工作进程允许的最大并发连接数

use epoll; # 在Linux系统下必须使用的高效I/O多路复用模型

multi_accept on; # 允许一个工作进程同时接受多个新连接

}

最大并发连接数计算公式:worker_processes * worker_connections。通过调整worker_rlimit_nofile和worker_connections,可以显著提升Nginx处理高并发连接的能力。

三、keepalive_timeout —— 减少TCP握手开销

频繁地建立和关闭TCP连接会产生大量的“三次握手”和“四次挥手”开销,并导致TIME_WAIT状态连接堆积,消耗系统资源。保持长连接是优化关键。

优化配置:

http {

keepalive_timeout 65; # 客户端长连接在服务器端保持的超时时间

keepalive_requests 10000; # 单个长连接可以处理的最大请求数

}

默认情况下,keepalive_requests值通常较低(如100),这意味着一个连接处理少量请求后就会断开。在持续高压力场景下,将其大幅提升至10000,可以极大减少连接重建的次数,这是提升后端架构整体吞吐量的“隐藏技巧”。

四、sendfile与TCP优化 —— 加速网络传输

网络数据包的传输效率直接影响响应速度与CPU负载。

优化配置:

http {

sendfile on; # 开启零拷贝技术,文件数据直接从内核缓存发送到网卡,绕过用户态

tcp_nopush on; # 在sendfile开启时生效,确保数据包满载后再发送,提升网络效率

tcp_nodelay on; # 禁用Nagle算法,允许小数据包立即发送,降低延迟

}

sendfile on是性能提升的关键,它通过“零拷贝”技术,避免了数据在内核缓冲区与用户缓冲区之间的多次拷贝,直接由内核处理并发送,显著降低了CPU和内存的占用。

通过系统性地调整以上四个维度的配置,并确保服务器硬件与操作系统参数(如net.core.somaxconn, fs.file-max等)与之匹配,Nginx完全有能力应对极端高并发流量,实现吞吐量质的飞跃。 |