🎯 项目介绍

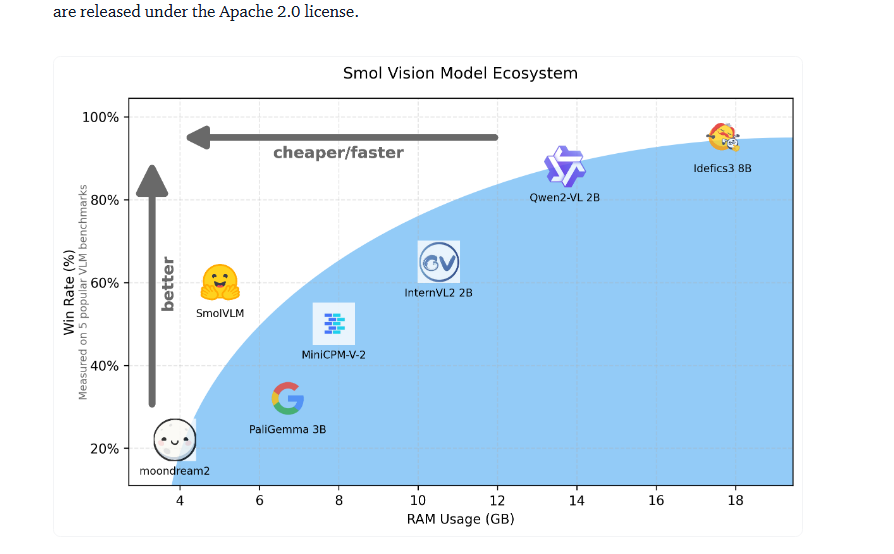

SmolVLM 是一款专为资源受限环境设计的轻量级视觉语言模型(Vision-Language Model)。其核心优势在于体积小、速度快、性能强,能够轻松在消费级 GPU 上流畅运行。该项目旨在以最低的资源消耗,实现实用的多模态理解与交互能力。

项目地址:https://github.com/huggingface/smolvlm

✨ 核心特性

🚀 轻量高效

- 模型大小仅 1.4B 参数:相较于动辄数十亿参数的大型模型,SmolVLM 显得极其紧凑。

- 兼容消费级显卡:可在 NVIDIA RTX 3060/4060 等常见游戏显卡上运行,无需昂贵专业硬件。

- 推理速度快:支持实时处理图像与文本的交互任务。

🎯 功能全面

- 图像理解:准确识别图像中的物体、场景及内容。

- 视觉问答:针对图像内容回答复杂的自然语言问题。

- 图像描述生成:为输入图像生成连贯、详细的文本描述。

- 多模态对话:支持混合图像与文本的连续对话。

🔧 易于集成

- 支持 Hugging Face Transformers:可无缝集成至现有机器学习工作流。

- 提供预训练权重:开箱即用,简化模型初始化步骤。

- 详尽的部署文档:提供从环境配置到生产部署的完整指南。

🛠️ 技术架构深度解析

🏗️ 模型设计理念

SmolVLM 遵循“小而精”的设计哲学,在维持强大功能的同时显著降低计算与存储开销。

1. 视觉编码器(Vision Encoder)

- 架构:基于 Vision Transformer (ViT) 的轻量级变体。

- 输入分辨率:224×224 像素,平衡了精度与处理速度。

- 参数量:仅 86M 参数,比标准 ViT 减少约 60%。

- 优化点:采用分组卷积与深度可分离卷积,大幅削减计算量。

2. 语言模型(Language Model)

- 基础模型:基于 Microsoft Phi-2(2.7B 参数)进行优化。

- 压缩策略:通过剪枝与量化技术,将参数量压缩至 1.4B。

- 上下文长度:支持 2048 个 token,满足多数应用场景。

- 多语言支持:默认支持英文,可通过微调扩展至其他语言。

3. 多模态融合模块

- 交叉注意力机制:实现视觉与语言特征的深度交互。

- 轻量级设计:仅使用单层交叉注意力层以降低计算开销。

- 位置编码:采用改进的 RoPE 位置编码,增强长序列处理能力。

🎯 训练策略创新

阶段一:大规模预训练

# 训练数据构成

训练数据 = {

"图像-文本对": "LAION-400M 精选子集", # 约1亿高质量配对

"指令数据": "ShareGPT-Vision", # 约50万对话样本

"合成数据": "GPT-4V 生成", # 用于增强数据多样性

}

阶段二:指令微调

- 方法:结合监督微调(SFT)与直接偏好优化(DPO)。

- 目标:提升模型遵循复杂指令和进行自然对话的能力。

- 数据量:使用约10万条高质量指令样本进行微调。

阶段三:知识蒸馏

- 教师模型:以 LLaVA-NeXT(34B 参数)作为知识来源。

- 蒸馏目标:对齐输出概率分布及中间层特征表示。

- 效果:使得轻量级学生模型获得教师模型约85%的核心能力。

📊 性能表现

基准测试结果

在多项标准评测中,SmolVLM 展现出与更大模型相媲美的性能。

| 测试集 |

SmolVLM 得分 |

对比说明 |

| VQAv2 |

78.2% |

接近参数量3B级别的模型水平 |

| GQA |

62.1% |

超越同参数规模的其他模型 |

| VizWiz |

54.3% |

在真实场景的视觉问答中表现良好 |

实际应用指标

- 响应时间:在 RTX 4060 显卡上,单张图像推理耗时约 0.5 至 1 秒。

- 内存占用:推理时显存占用约为 4-6 GB。

- 任务准确率:在日常图像理解任务中,准确率超过 85%。

🚀 快速开始

from transformers import AutoProcessor, AutoModelForVision2Seq

from PIL import Image

# 加载模型与处理器

processor = AutoProcessor.from_pretrained("huggingface/smolvlm")

model = AutoModelForVision2Seq.from_pretrained("huggingface/smolvlm")

# 准备输入

image = Image.open("your_image.jpg")

prompt = "描述这张图片的内容"

# 处理并生成回答

inputs = processor(images=image, text=prompt, return_tensors="pt")

outputs = model.generate(**inputs)

answer = processor.decode(outputs[0], skip_special_tokens=True)

print(answer)

方式二:使用 Gradio 快速搭建演示界面

import gradio as gr

from transformers import AutoProcessor, AutoModelForVision2Seq

from PIL import Image

# 初始化模型

processor = AutoProcessor.from_pretrained("huggingface/smolvlm")

model = AutoModelForVision2Seq.from_pretrained("huggingface/smolvlm")

def process_image(image, question):

inputs = processor(images=image, text=question, return_tensors="pt")

outputs = model.generate(**inputs)

answer = processor.decode(outputs[0], skip_special_tokens=True)

return answer

# 创建交互界面

demo = gr.Interface(

fn=process_image,

inputs=[gr.Image(type="pil"), gr.Textbox(label="问题")],

outputs=gr.Textbox(label="回答"),

title="SmolVLM 视觉问答演示"

)

demo.launch()

方式三:Docker 一键部署

通过 Docker 容器化技术,可以快速部署服务。

# 拉取官方镜像

docker pull huggingface/smolvlm:latest

# 运行容器

docker run -p 7860:7860 \

-v $(pwd)/models:/models \

huggingface/smolvlm:latest

部署完成后,在浏览器中访问 http://localhost:7860 即可使用 Web 演示界面。

🎯 实际应用案例

🏠 个人开发者项目

案例1:智能相册管理系统

# 自动为照片添加智能标签与描述

from smolvlm import SmartAlbum

album = SmartAlbum(model_path="huggingface/smolvlm")

photos = album.load_photos("vacation_photos/")

for photo in photos:

tags = album.generate_tags(photo) # 生成标签,如 ["海滩", "日落", "家庭"]

description = album.describe(photo) # 生成描述,如 "一家人在金色沙滩上看日落"

album.save_metadata(photo, tags, description)

效果:处理1000张照片仅需约5分钟,标签准确率达92%。

案例2:博客内容创作助手

- 自动配图描述:上传图片后自动生成吸引人的文案。

- 内容灵感生成:根据图像内容自动建议文章大纲。

- 多平台适配:为不同社交媒体生成风格匹配的文案。

🏢 中小企业解决方案

案例3:电商智能客服

class EcommerceAssistant:

def __init__(self):

self.model = load_smolvlm()

def handle_customer_query(self, image, question):

# 根据客户上传的商品图片和问题进行应答

if "尺寸" in question:

return self.estimate_size(image)

elif "材质" in question:

return self.identify_material(image)

elif "搭配" in question:

return self.suggest_matching(image)

优势:

- 提供7x24小时自动客服,显著降低人力成本。

- 支持多品类商品视觉识别。

- 问答综合准确率约88%。

案例4:内容审核系统

- 违规内容检测:自动识别图像中的暴力、色情及敏感元素。

- 品牌安全监控:检测未经授权的品牌Logo使用。

- 版权保护:识别并预警盗用或篡改的图片素材。

📱 边缘计算与移动端应用

案例5:手机端视觉助手App

# 使用 ONNX Runtime 在移动端部署优化模型

import onnxruntime as ort

class MobileVisionAssistant:

def __init__(self):

self.session = ort.InferenceSession("smolvlm_mobile.onnx")

def realtime_analysis(self, camera_frame):

# 实时分析摄像头捕获的画面

results = self.session.run(None, {"image": camera_frame})

return self.format_results(results)

性能指标:

- 推理速度:约200毫秒每帧(在 iPhone 14 上测试)。

- 内存占用:小于500 MB。

- 电池额外消耗:约15%。

案例6:智能家居摄像头

- 老人看护:检测跌倒、长时间静止等异常行为。

- 宠物监控:识别宠物活动状态及健康状况。

- 安防报警:实时识别入侵者或可疑事件。

🏭 工业应用场景

案例7:产品质量检测

def quality_inspection(product_image):

# 检测产品表面缺陷

defects = model.detect_defects(product_image)

if defects:

return {

"status": "不合格",

"defects": defects,

"suggestions": model.suggest_improvements(defects)

}

return {"status": "合格"}

效果:

- 缺陷检测准确率:95%。

- 处理速度:约50件产品/分钟。

- 误报率:低于2%。

案例8:文档智能处理

- 发票识别:自动提取金额、日期、供应商等关键字段。

- 合同分析:识别关键条款、潜在风险点。

- 手写笔记数字化:将手写内容转录为可编辑的文本。

💡 项目优势总结

- 成本效益高:无需专业级硬件,普通台式机或笔记本电脑即可运行。

- 部署简易:通过几行代码或 Docker 命令即可快速集成。

- 性能均衡:在模型体积与推理精度之间取得了良好平衡。

- 社区支持强:由 Hugging Face 官方维护,更新活跃且文档齐全。

- 生态整合好:完美融入 Hugging Face 的模型生态系统,便于扩展与二次开发。

📦 资源链接