Nginx是构建现代大型应用架构的基石,其性能表现直接影响系统的整体吞吐与稳定性。很多开发者可能只是简单部署Nginx,却忽略了其内部核心参数的调优,这可能导致性能瓶颈。本文将深入解析四个关键的Nginx性能参数,帮助您实现性能的显著提升。

一、worker_processes —— 设定CPU利用率的基石

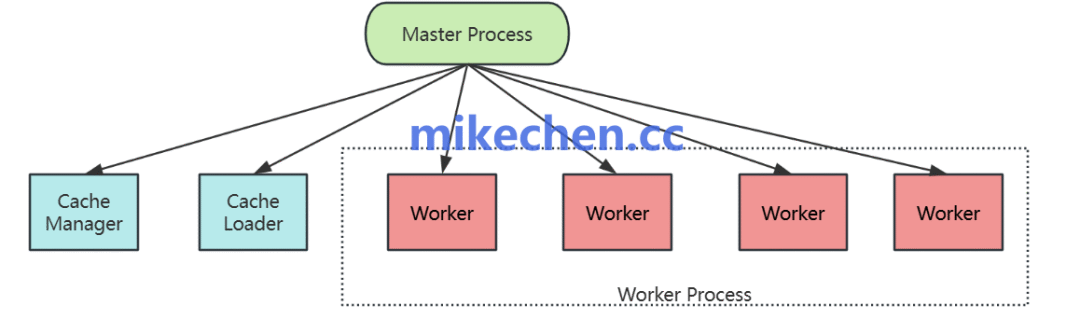

这个参数决定了Nginx启动时的工作进程(Worker Process)数量。每个工作进程都是一个独立的实例,运行自己的事件循环,用于处理网络连接和请求。

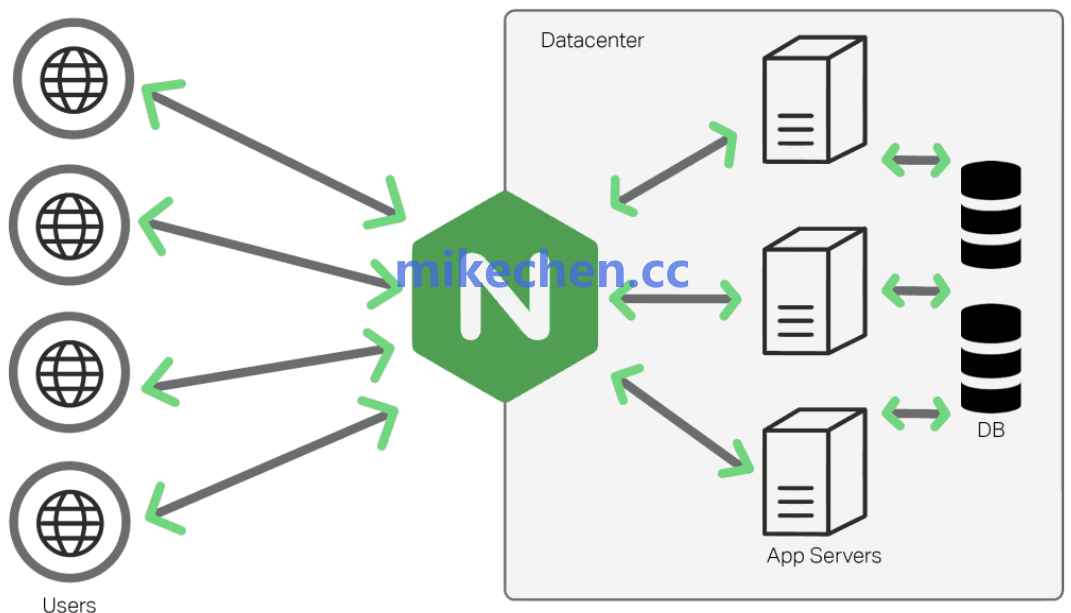

图1:用户请求通过Nginx分发至后端应用服务器与数据库的典型流程

配置示例:

worker_processes auto;

每个worker进程在同一时刻只会被调度到一个CPU核心上运行。因此,合理配置此参数是榨干多核CPU性能的第一步。

配置原则与实践

核心原则是让工作进程数与CPU逻辑核心数相等。使用 auto 参数是推荐做法,Nginx会自动检测并设置为CPU核心数。

错误的配置会导致资源浪费或性能下降:

- 配置过少:例如在32核CPU上仅启动2个worker,将无法充分利用硬件资源,造成性能浪费。

- 配置过多:例如在1核CPU上启动8个worker,会导致操作系统在进程间频繁切换(上下文切换),消耗大量CPU资源,反而降低性能。

二、worker_connections —— 定义并发连接能力上限

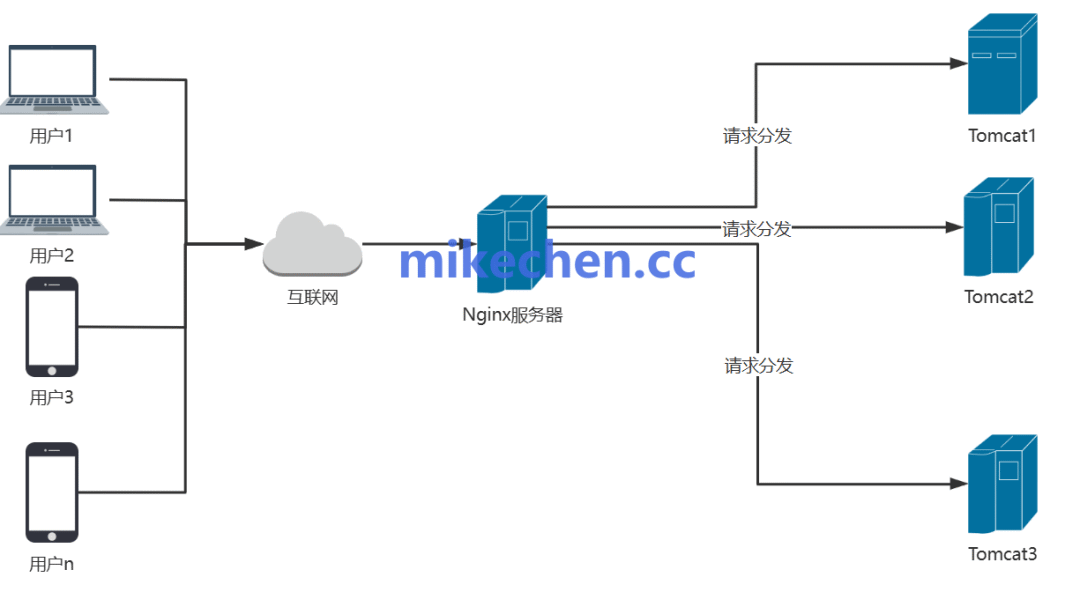

此参数定义了每个工作进程能够同时处理的最大连接数。这里的连接包括了客户端到Nginx的连接,以及Nginx到后端服务器的连接。

图2:Nginx的Master进程管理多个Worker进程,每个Worker独立处理连接

理论最大并发连接数

Nginx服务的整体并发连接能力由以下公式决定:

最大并发连接数 = worker_processes × worker_connections

举例来说,一个8核服务器,配置8个worker,每个worker的 worker_connections 设为65535,那么理论上的并发连接处理能力约为 8 * 65535 ≈ 52万。

必须配套的系统级调优

仅仅调整Nginx配置是不够的。每个进程能打开的文件描述符(连接本质上就是文件描述符)受限于操作系统。如果系统级参数(如 ulimit -n 和 /proc/sys/fs/file-max)设置过低,即使Nginx配置再高,也会遇到 “too many open files” 的错误,导致性能瓶颈。因此,在调整 worker_connections 的同时,必须确保操作系统级别的文件描述符限制已经相应调高,这正是运维/DevOps/SRE工作中常见的系统调优环节。

三、use epoll —— 选择高性能事件驱动模型(Linux)

在Linux系统下,这是决定Nginx能否支撑超高并发的核心技术选项。它配置在 events 模块中。

图3:Nginx作为负载均衡器,将海量用户请求分发到后端服务器集群

配置示例:

events {

use epoll;

}

为什么epoll如此关键?

epoll 是Linux内核提供的一种I/O事件通知机制。相比于传统的 select 或 poll 模型,epoll 在管理大量并发连接时,其时间复杂度是O(1),而 select/poll 是O(n)。这意味着,当连接数(n)增长到数万甚至百万时,epoll 的性能几乎不会下降,而 select/poll 的CPU消耗会线性飙升。

性能差距有多大?

在高并发场景下,这种差异是数量级的:

- 使用

select/poll:CPU使用率会迅速达到100%,但实际处理的请求却不多,大部分算力浪费在轮询检测空闲连接上。

- 使用

epoll:CPU能够高效、稳定地处理海量连接和请求,利用率高且平稳。

对于追求极致的后端 & 架构设计而言,使用 epoll 是Linux下的不二之选。

四、accept_mutex —— 解决“惊群效应”的利器

“惊群效应”(Thundering herd)是指当一个新的网络连接到来时,操作系统会唤醒所有正在等待这个连接的进程(即Nginx的所有worker进程),但最终只有一个进程能成功“抢到”并处理该连接,其他被唤醒的进程做了无用功,白白消耗了CPU资源。

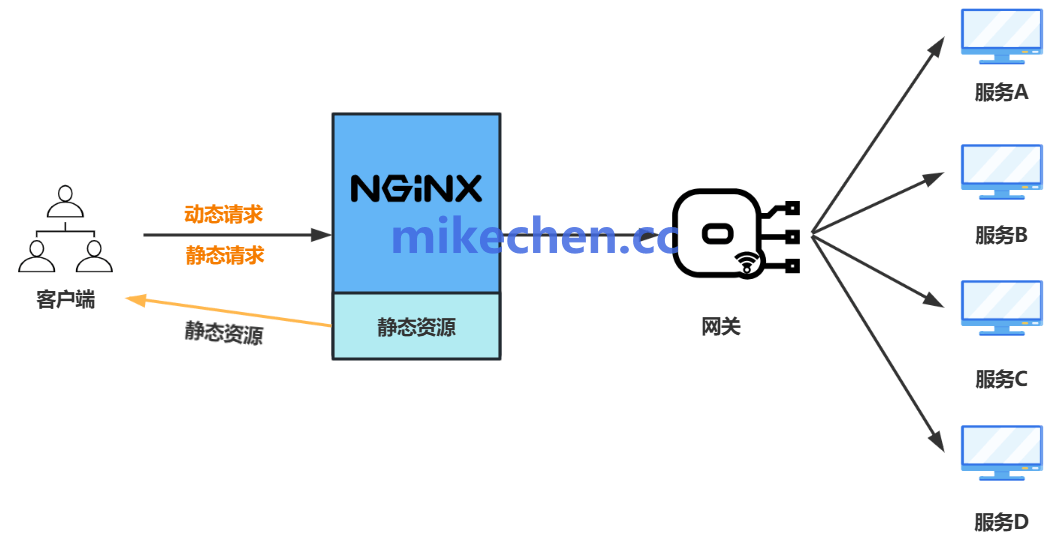

图4:Nginx作为网关,将动态与静态请求路由至不同的后端微服务

解决方案

通过开启 accept_mutex(接受互斥锁),可以让同一时间只有一个worker进程去监听并接受新的连接请求,其他worker则继续处理已有的连接。这样就避免了大量进程被无效唤醒。

配置示例:

events {

accept_mutex on;

}

适用场景

这个优化在高并发短连接场景下效果尤为显著,例如QPS(每秒查询率)极高、连接创建和销毁非常频繁的业务。对于数据库/中间件/技术栈中的各类服务,尤其是通过Nginx暴露的API网关,合理配置此参数可以有效降低CPU的不必要开销,提升整体吞吐量。

希望这篇关于Nginx核心参数调优的解析能对您有所帮助。获取更多深入的架构知识、技术讨论及资源分享,欢迎访问云栈社区。