在企业级IT架构演进中,超融合基础设施(HCI)凭借“计算+存储+网络”一体化整合的优势,已成为中小企业数字化转型及大型企业边缘节点部署的优选方案。其中,Proxmox VE与Ceph的组合,以其开源免费、高可扩展性、低门槛落地的特性,在开源超融合领域树立了标杆。

本文将带你从架构本质出发,拆解Proxmox VE与Ceph的协同逻辑,详解部署关键要点与性能优化策略,助你快速掌握这套方案的落地核心。

一、核心认知:Proxmox VE + Ceph 超融合的底层逻辑

在深入部署前,我们需要明确一点:Proxmox VE与Ceph的组合并非简单的“软件叠加”,而是“计算与存储的深度协同”。

Proxmox VE作为开源的虚拟化平台,核心价值在于提供KVM/容器一体化的虚拟化管理能力。它支持集群化部署、高可用(HA)配置,并提供了直观的Web管理界面,极大地降低了虚拟化集群的运维门槛。而Ceph作为分布式存储系统,以“RADOS(可靠的自治分布式对象存储)”为核心,具备块存储、文件存储、对象存储“三位一体”的能力,其分布式架构天然适配超融合的横向扩展需求。

两者协同的核心逻辑在于:Proxmox VE集群节点同时承担“计算节点”与“存储节点”双重角色,节点本地磁盘组成Ceph存储集群,由Proxmox VE管理的虚拟机/容器直接使用Ceph提供的分布式存储资源,无需额外部署独立存储阵列。这种架构不仅简化了硬件部署(只需x86服务器+本地磁盘),更通过分布式存储的冗余机制(多副本、纠删码)保障了数据可靠性,并借助横向扩展能力轻松应对业务增长。

二、部署前置:硬件与环境规划要点

硬件选型建议(按节点角色)

超融合节点需同时承载计算与存储压力,硬件配置需兼顾两者需求。以下是针对不同场景的参考配置:

- 最小化测试环境(3节点,核心目的:验证功能):每节点配置CPU≥4核(支持虚拟化)、内存≥16GB(Ceph OSD进程占用内存较多,建议至少8GB/节点用于存储)、磁盘≥3块(1块系统盘+2块数据盘,数据盘建议SSD以提升读写性能)、网卡≥2块(1块管理网+1块存储网,实现网络流量分离)。

- 企业级生产环境(≥3节点,核心目的:性能+可靠性):每节点配置CPU≥16核(支持超线程)、内存≥64GB(按每块OSD盘2-4GB内存预留)、磁盘配置建议为:系统盘(1-2块SSD,RAID1)+ 数据盘(≥6块,可采用SSD+HDD混合方案,SSD作为Ceph Journal盘提升IO写入性能,HDD作为数据盘降低成本;或全SSD部署追求极致性能)、网卡≥4块(2块管理网+2块存储网,存储网建议使用10GbE SFP+网卡并绑定LACP,以提升带宽与冗余性)。

三、安装部署:关键步骤详解

第一步:安装Proxmox VE

下载Proxmox VE ISO镜像,制作启动U盘,在三台服务器上分别完成安装。请注意节点名称不要重复! 并配置同一网段的IP地址,例如:

节点1: 192.168.7.12 (主机名 pve1)

节点2: 192.168.7.43 (主机名 pve2)

节点3: 192.168.7.88 (主机名 pve3)

安装完成后,即可通过Web界面访问管理,例如 https://192.168.7.12:8006。

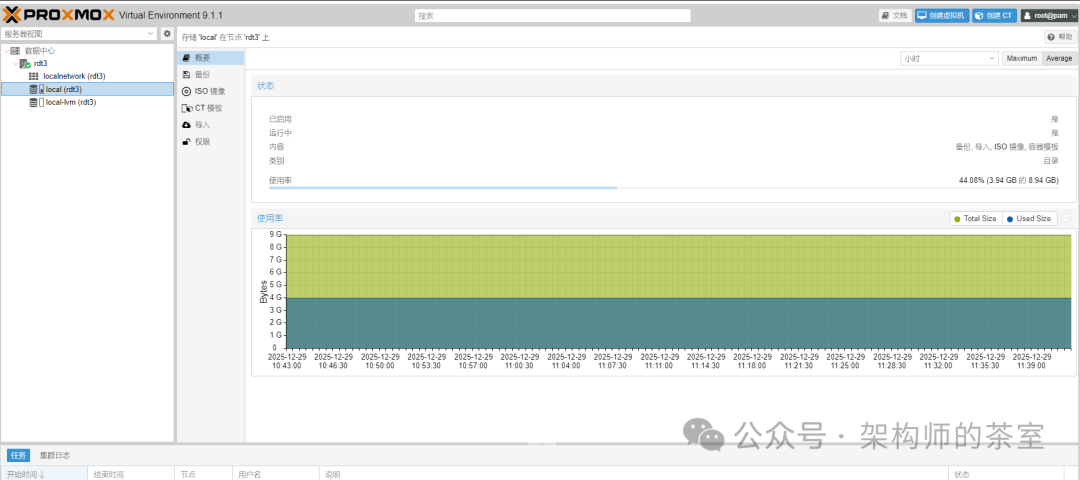

图1:Proxmox VE 虚拟机的资源使用情况监控界面

第二步:一键创建集群

在第一个节点 pve1 上执行命令创建集群:

pvecm create my-cluster

第三步:加入其他节点

分别在 pve2 和 pve3 节点上执行命令加入集群(注意使用正确的IP地址):

pvecm add 192.168.7.12

等待命令执行完成,一个三节点的集群便瞬间建立完毕,此后所有节点都可在Web界面中统一管理。这极大简化了传统虚拟化平台集群的配置复杂度。

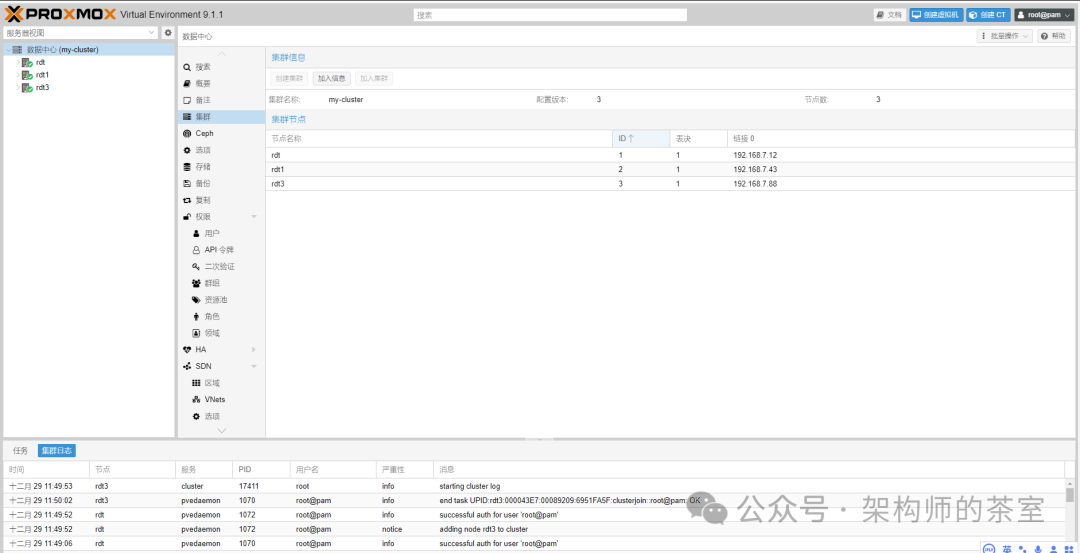

图2:Proxmox VE 集群信息与任务日志查看界面

第四步:部署Ceph分布式存储

这是实现超融合架构的核心步骤。通过Proxmox Web界面即可轻松操作:

- 点击“数据中心” → “Ceph” → 安装(此操作会自动将Ceph部署到所有集群节点)。

- 为每个节点添加Monitor(仲裁节点)。

- 将各节点的数据硬盘初始化为OSD(对象存储设备)。

部署完成后,Ceph会自动将数据复制三份,这意味着即使有两个节点同时宕机,数据依然安全。

第五步:创建第一台高可用虚拟机

在Web界面创建虚拟机时,关键选择如下:

- 存储:选择刚才创建的Ceph存储池。

- 开启高可用(HA):勾选HA选项。

- CPU/内存:根据实际需求分配。

至此,虚拟机磁盘将不再绑定于特定主机,而是存在于整个集群的共享存储池中,这是实现后续实时迁移功能的基础。

四、核心功能实测:体验超融合优势

1. 实时迁移:业务零中断

通过一条命令,即可将正在运行的虚拟机从一台主机迁移到另一台,整个过程业务无感知:

# 将ID为100的虚拟机从pve1在线迁移到pve2

qm migrate 100 pve2 --online

迁移过程中进行ping测试,可实现0丢包,保障了关键业务的连续性。

2. 一键扩容:资源线性增长

当需要增加计算或存储资源时,扩容变得异常简单:

# 添加第四台服务器到集群

pvecm add 192.168.1.104

# 在新节点上添加OSD硬盘

ceph osd create

通过这种线性扩展的方式,存储容量和计算资源得以无缝增长,无需停机,也无需复杂的数据迁移操作。

通过上述步骤,你不仅可以搭建一套高可用的开源超融合环境,更能深刻体会到其在简化运维、提升可靠性方面的巨大优势。对于希望深入探索运维 & 测试自动化与高可用架构的工程师而言,这是一次极具价值的实践。如果你想了解更多关于虚拟化、分布式存储或其它开源技术的一手实践与深度讨论,欢迎访问云栈社区与广大开发者交流。