一、Socket编程的哲学:通信的抽象化

1.1 设计思想的核心:一切皆文件

你是否曾思考过,网络编程为何能与文件操作如此相似?这源于Linux“一切皆文件”的核心理念,Socket正是这一哲学的最佳体现。通过将网络连接抽象为文件描述符,系统为开发者提供了一致性的操作接口。这意味着你可以使用熟悉的read()、write()等标准I/O函数来处理网络数据流,就像读写本地文件一样直观。

// Socket被抽象为文件描述符

int sockfd = socket(AF_INET, SOCK_STREAM, 0);

// 之后可以像操作文件一样操作socket

write(sockfd, buffer, strlen(buffer));

read(sockfd, buffer, sizeof(buffer));

1.2 分层架构:网络通信的“洋葱模型”

为了理解Socket如何工作,我们需要审视其背后的分层架构,这类似于一个精密的“洋葱模型”。每一层只专注于自己的职责,并通过定义良好的接口与相邻层交互,这种隔离性为整个OSI模型协议栈的灵活演进和替换奠定了基础。

┌─────────────────────────────────────┐

│ 应用程序层 (Application) │

├─────────────────────────────────────┤

│ Socket抽象层 (API接口) │

├─────────────────────────────────────┤

│ 传输层 (TCP/UDP/其他传输协议) │

├─────────────────────────────────────┤

│ 网络层 (IP/路由/转发) │

├─────────────────────────────────────┤

│ 链路层 (以太网/WiFi/其他链路) │

├─────────────────────────────────────┤

│ 物理层 (电缆/无线电波) │

└─────────────────────────────────────┘

二、Socket核心数据结构解剖

2.1 三层核心数据结构关系

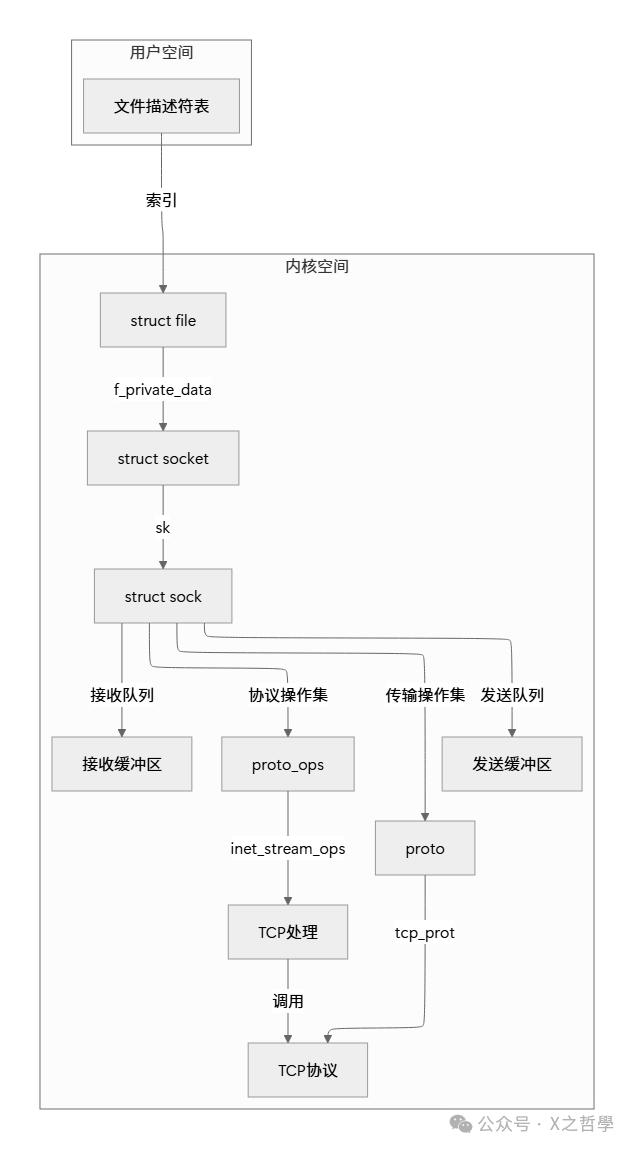

用户空间的简单文件描述符,在内核中关联着一系列复杂的结构。下图清晰地展示了从文件描述符到struct socket,再到真正承载协议状态和数据的struct sock之间的关系,这是理解Linux TCP/IP栈内部运作的关键。

2.2 struct socket:Socket的“身份证明”

struct socket结构体并不直接处理数据,它更像是一个“前台接待处”。它记录了Socket的状态、关联的文件结构,并持有一个指向具体协议操作函数集的指针,负责将数据引导至正确的处理流程。

// 简化的socket结构(基于Linux 5.x内核)

struct socket {

socket_state state; // 状态: SS_CONNECTED等

unsigned long flags; // 标志位

const struct proto_ops *ops; // 协议操作函数集

struct file *file; // 关联的文件结构

struct sock *sk; // 指向实际的sock结构

struct socket_wq wq; // 等待队列

};

// Socket状态枚举

typedef enum {

SS_FREE = 0, // 未分配

SS_UNCONNECTED, // 未连接(UDP或TCP监听前)

SS_CONNECTING, // 连接建立中

SS_CONNECTED, // 已连接

SS_DISCONNECTING // 断开连接中

} socket_state;

2.3 struct sock:协议的“工作车间”

如果说struct socket是前台,那么struct sock就是真正的“后厨”。它包含了协议处理所需的一切:网络层标识(地址族、IP地址、端口)、管理数据收发的队列、协议特定的操作函数指针,以及连接状态、定时器、引用计数等核心信息。

// 简化的sock结构(包含关键字段)

struct sock {

// 网络层标识

unsigned short sk_family; // 地址族: AF_INET等

union {

struct inet_sock *inet;

struct ipv6_sock *ipv6;

// 其他协议族

} sk_pinfo;

// 队列管理

struct sk_buff_head sk_receive_queue; // 接收队列

struct sk_buff_head sk_write_queue; // 发送队列

struct sk_buff_head sk_error_queue; // 错误队列

// 协议操作

struct proto *sk_prot; // 传输层协议操作

void (*sk_state_change)(struct sock *sk);

void (*sk_data_ready)(struct sock *sk);

void (*sk_write_space)(struct sock *sk);

// 状态和标志

volatile unsigned char sk_state; // TCP状态

unsigned int sk_shutdown : 2; // 关闭标志

unsigned long sk_flags; // 标志位

// 定时器

struct timer_list sk_timer; // 各种定时器

// 引用计数

refcount_t sk_refcnt; // 引用计数

};

2.4 sk_buff:数据的“标准化集装箱”

网络数据在内核中如何流动?答案是通过sk_buff结构体。它可以被看作是数据的“标准集装箱”。无论内部装载的是TCP段、UDP数据报还是ICMP消息,都使用这个统一的“箱子”在协议栈各层之间传递,只是通过内部指针标记出不同协议头的位置。

// 简化的sk_buff结构

struct sk_buff {

// 双向链表

struct sk_buff *next;

struct sk_buff *prev;

// 数据区管理

unsigned char *head; // 缓冲区的头

unsigned char *data; // 实际数据的头

unsigned char *tail; // 实际数据的尾

unsigned char *end; // 缓冲区的尾

// 元数据

unsigned int len; // 数据长度

unsigned int data_len; // 分段数据长度

// 网络层信息

__be16 protocol; // 协议类型

__u32 priority; // QoS优先级

// 协议头指针

union {

struct tcphdr *th;

struct udphdr *uh;

struct icmphdr *icmph;

struct iphdr *ipiph;

// 其他协议头

} h;

// 设备信息

struct net_device *dev; // 接收/发送的设备

};

三、Socket工作流程深度解析

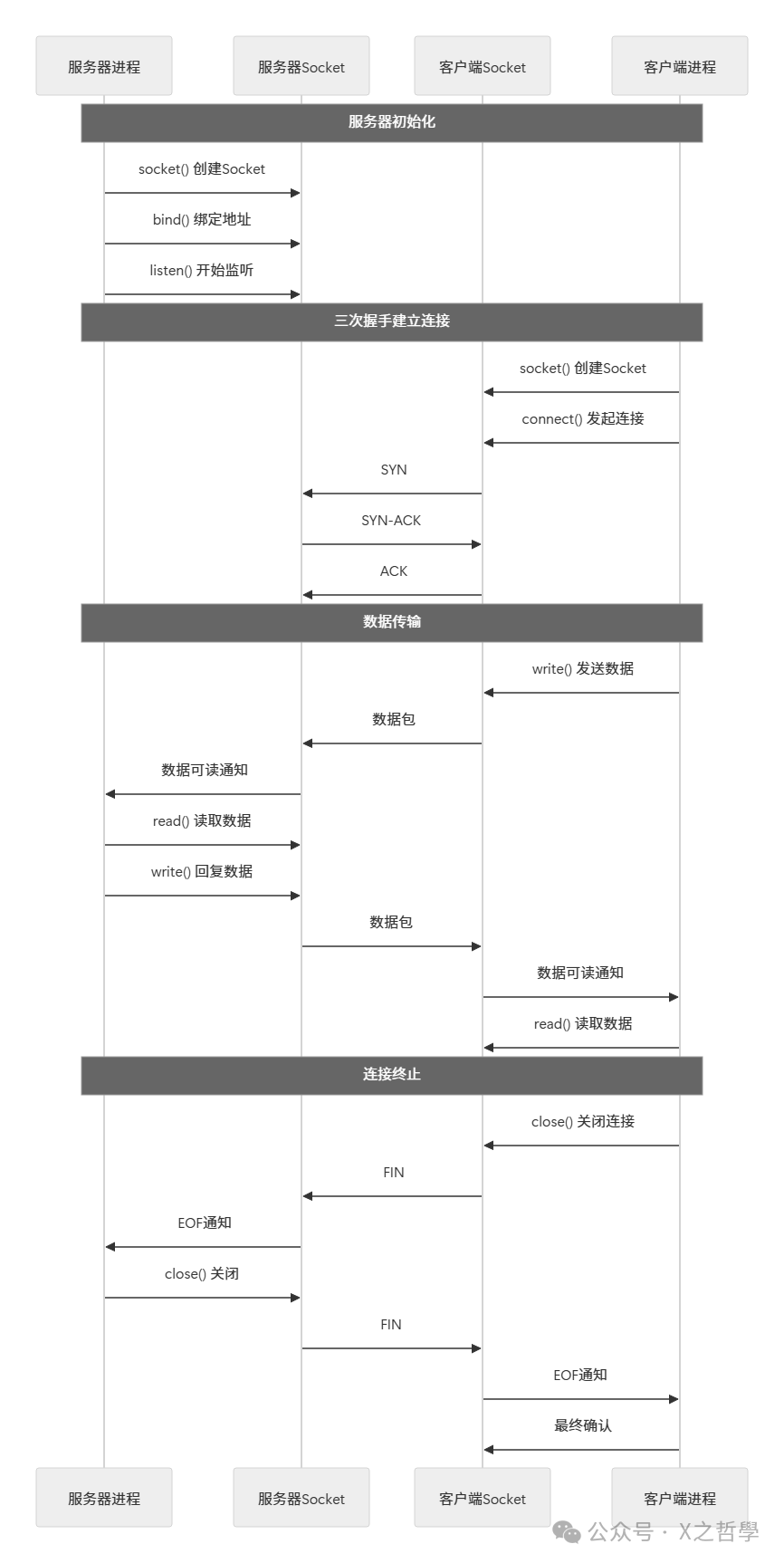

3.1 TCP Socket的完整生命周期

一个TCP连接从建立、通信到关闭,经历了标准的三次握手、数据传输和四次挥手过程。下图完整描绘了服务器与客户端Socket在此生命周期内的交互与状态变迁。

3.2 内核中的数据流路径

当应用程序调用write()发送数据时,这个请求是如何穿越内核层层封装,最终变成电信号发送出去的呢?

应用程序 write() 调用

↓

系统调用入口 (sys_write/sys_sendto)

↓

sock_write() / sock_sendmsg()

↓

inet_sendmsg() (传输层入口)

↓

tcp_sendmsg() (TCP特定处理)

↓

构建sk_buff,填入数据

↓

tcp_transmit_skb() 处理TCP头部

↓

ip_queue_xmit() 添加IP头部

↓

dev_queue_xmit() 发送到网络设备

↓

网卡驱动程序 DMA传输

接收路径则是一个完美的逆过程:数据从网卡驱动接收,经过网络层、传输层层层解封装,最终通过文件系统接口,送达应用程序的read()调用缓冲区。理解这条路径对进行高并发网络编程和性能调优至关重要。

四、核心概念详解与生活类比

4.1 地址族(Address Family):通信的“语言体系”

地址族定义了Socket通信所使用的底层协议“语言”。不同的地址族就像是不同的通信系统。

| 地址族常量 |

数值 |

描述 |

生活类比 |

| AF_UNIX/AF_LOCAL |

1 |

本地进程间通信 |

公司内部电话系统 |

| AF_INET |

2 |

IPv4网络协议 |

国际电话系统(旧版) |

| AF_INET6 |

10 |

IPv6网络协议 |

国际电话系统(新版) |

| AF_NETLINK |

16 |

内核与用户空间通信 |

管理层专用通信线路 |

| AF_PACKET |

17 |

原始数据包访问 |

直接操作电话交换机 |

4.2 Socket类型:通信的“服务模式”

Socket类型决定了通信的“服务模式”,是像电话一样稳定连接,还是像明信片一样即发即走?

// 主要Socket类型

SOCK_STREAM // 面向流的TCP Socket - 像电话通话

SOCK_DGRAM // 数据报UDP Socket - 像发送明信片

SOCK_RAW // 原始Socket - 像自己组装信封和邮票

SOCK_SEQPACKET // 有序分组Socket - 像挂号信,保证顺序和完整

SOCK_STREAM vs SOCK_DGRAM 详细对比:

| 特性 |

SOCK_STREAM (TCP) |

SOCK_DGRAM (UDP) |

| 连接性 |

面向连接,需建立/断开连接 |

无连接,直接发送 |

| 可靠性 |

可靠传输,自动重传、校验 |

最大努力交付,可能丢失 |

| 顺序性 |

保证数据顺序 |

不保证顺序 |

| 流量控制 |

有滑动窗口机制 |

无控制,可能淹没接收方 |

| 拥塞控制 |

有复杂拥塞避免算法 |

无控制 |

| 数据边界 |

无边界,是字节流 |

保持消息边界 |

| 头部开销 |

20字节+选项 |

8字节 |

| 适用场景 |

文件传输、Web、邮件 |

DNS查询、视频流、游戏 |

4.3 端口号:公寓楼的“房间号”

想象一栋公寓楼(IP地址),里面的每个房间(端口号)可以住不同的租户(应用程序)。端口号的范围和用途有如下划分:

- 0-1023:知名端口,像大楼的公共设施(FTP: 21,HTTP: 80,HTTPS: 443)

- 1024-49151:注册端口,像预定的商务办公室,可供用户进程注册使用

- 49152-65535:动态/私有端口,像临时储物柜,通常由操作系统动态分配给客户端连接

五、实战:最简单的TCP Echo服务器

5.1 完整示例代码

理论需要结合实践。下面是一个完整的TCP回显服务器示例,它清晰地展示了从创建Socket到处理连接的每一个步骤,是学习C/C++网络编程的经典起点。

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <unistd.h>

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#define PORT 8080

#define BACKLOG 5

#define BUFFER_SIZE 1024

int main() {

int server_fd, client_fd;

struct sockaddr_in server_addr, client_addr;

socklen_t addr_len = sizeof(client_addr);

char buffer[BUFFER_SIZE];

// 1. 创建Socket - 买一部电话机

if ((server_fd = socket(AF_INET, SOCK_STREAM, 0)) < 0) {

perror("socket creation failed");

exit(EXIT_FAILURE);

}

// 设置SO_REUSEADDR避免"Address already in use"

int opt = 1;

setsockopt(server_fd, SOL_SOCKET, SO_REUSEADDR, &opt, sizeof(opt));

// 2. 绑定地址 - 给电话机分配号码

memset(&server_addr, 0, sizeof(server_addr));

server_addr.sin_family = AF_INET;

server_addr.sin_addr.s_addr = INADDR_ANY; // 监听所有接口

server_addr.sin_port = htons(PORT); // 端口号,转为网络字节序

if (bind(server_fd, (struct sockaddr*)&server_addr,

sizeof(server_addr)) < 0) {

perror("bind failed");

close(server_fd);

exit(EXIT_FAILURE);

}

// 3. 开始监听 - 打开电话铃声等待来电

if (listen(server_fd, BACKLOG) < 0) {

perror("listen failed");

close(server_fd);

exit(EXIT_FAILURE);

}

printf("Echo server listening on port %d\n", PORT);

// 4. 接受连接 - 接听电话

if ((client_fd = accept(server_fd, (struct sockaddr*)&client_addr,

&addr_len)) < 0) {

perror("accept failed");

close(server_fd);

exit(EXIT_FAILURE);

}

printf("Client connected: %s:%d\n",

inet_ntoa(client_addr.sin_addr),

ntohs(client_addr.sin_port));

// 5. 回声处理 - 对话过程

while (1) {

ssize_t bytes_read = read(client_fd, buffer, BUFFER_SIZE - 1);

if (bytes_read <= 0) {

if (bytes_read == 0) {

printf("Client disconnected\n");

} else {

perror("read error");

}

break;

}

buffer[bytes_read] = '\0'; // 确保字符串结束

printf("Received: %s", buffer);

// 原样发回 - 回声

if (write(client_fd, buffer, bytes_read) != bytes_read) {

perror("write error");

break;

}

}

// 6. 清理 - 挂电话

close(client_fd);

close(server_fd);

return 0;

}

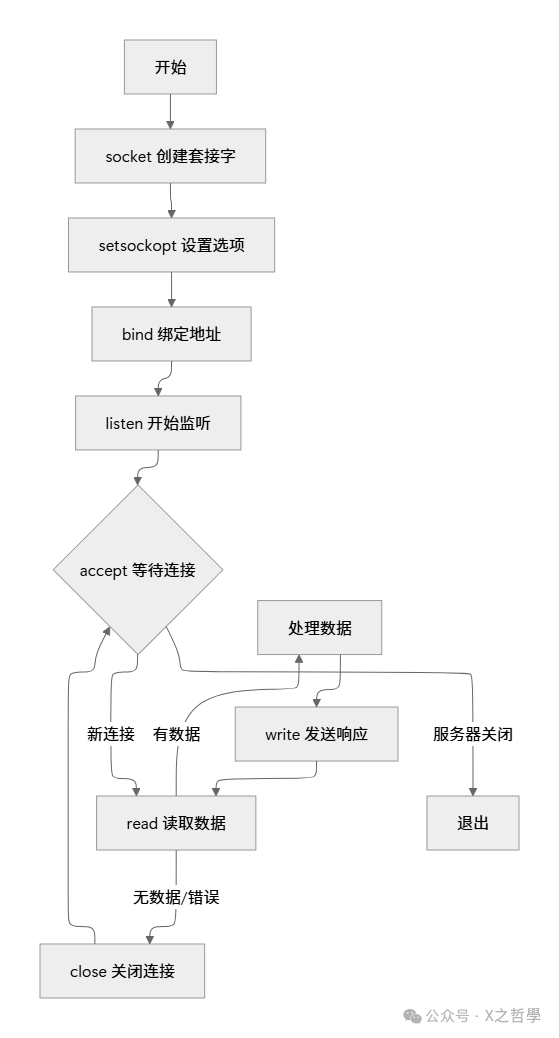

5.2 核心函数执行流程图

编写服务器端Socket程序有一个标准流程。下面的流程图直观地展示了从socket()创建到close()关闭的每一步决策路径,帮助你建立起清晰的编程思维。

六、高级主题:多路复用与并发模型

6.1 I/O多路复用模型对比

当需要同时管理成百上千个连接时,为每个连接创建一个线程是低效且不可扩展的。I/O多路复用技术允许单个线程监视多个文件描述符(Socket)的就绪状态,是实现高并发网络服务器的基石。

| 模型 |

工作机制 |

优点 |

缺点 |

适用场景 |

| select |

轮询所有fd,线性扫描 |

跨平台,超时精度高 |

fd数量有限(1024),效率O(n) |

小型并发,跨平台应用 |

| poll |

基于事件链表,无数量限制 |

无fd数量限制 |

仍需遍历所有fd |

中等并发 |

| epoll |

事件回调,就绪列表 |

高效O(1),支持边缘触发 |

Linux独有,API稍复杂 |

高并发服务器 |

| kqueue |

类似epoll,事件通知 |

FreeBSD高效实现 |

BSD系特有 |

BSD系统高并发 |

6.2 epoll工作模式详解

epoll是Linux下性能最出色的I/O多路复用机制。它提供了两种触发模式,适用于不同的编程场景。

// epoll的两种触发模式

EPOLLLT // 水平触发(默认)- 像门铃,只要缓冲区有数据,事件会一直通知

EPOLLET // 边缘触发 - 像门铃只响一次,只在状态变化时通知一次,要求非阻塞IO

// epoll核心API使用示例

int epfd = epoll_create1(0);

struct epoll_event ev, events[MAX_EVENTS];

// 添加监听socket到epoll监控

ev.events = EPOLLIN; // 监听可读事件

ev.data.fd = server_fd;

epoll_ctl(epfd, EPOLL_CTL_ADD, server_fd, &ev);

// 等待事件

int nfds = epoll_wait(epfd, events, MAX_EVENTS, -1);

for (int i = 0; i < nfds; i++) {

if (events[i].data.fd == server_fd) {

// 接受新连接

int client_fd = accept(server_fd, ...);

// 设置新socket为非阻塞并加入epoll

set_nonblocking(client_fd);

ev.events = EPOLLIN | EPOLLET; // 对新连接使用边缘触发

ev.data.fd = client_fd;

epoll_ctl(epfd, EPOLL_CTL_ADD, client_fd, &ev);

} else {

// 处理客户端数据

handle_client(events[i].data.fd);

}

}

七、调试与诊断工具集

7.1 网络状态诊断命令

强大的命令行工具是网络程序员的瑞士军刀。

# 查看Socket状态统计

netstat -tulpn # 查看所有监听端口

ss -tan # 更快的netstat替代品

cat /proc/net/tcp # 直接查看内核TCP表

# 连接追踪

lsof -i :8080 # 查看谁在使用8080端口

tcpdump -i any port 8080 -nn # 抓取8080端口数据包

# 性能分析

sar -n TCP,ETCP 1 # TCP统计信息

netstat -s # 详细协议统计

cat /proc/net/sockstat # Socket内存使用统计

7.2 内核级调试技术

对于复杂问题,我们需要深入到系统调用和内核层面。

# 1. 使用strace追踪系统调用

strace -f -e trace=network ./server # 跟踪所有网络相关调用

# 2. 使用gdb调试网络程序

gdb ./server

(gdb) break accept # 在accept处设断点

(gdb) break tcp_v4_connect # 内核函数断点(需内核符号)

# 3. 使用SystemTap进行动态追踪

# 追踪所有TCP连接建立(示例)

# sudo stap -e 'probe kernel.function("tcp_connect") {

# printf("TCP connect from %s:%d\n",

# ip_ntop($inet_af, &$sk->__sk_common.skc_daddr),

# ntohs($sk->__sk_common.skc_dport))

# }'

# 4. 使用perf分析网络性能

perf record -e 'net:*' ./server # 记录网络事件

perf report # 分析报告

7.3 常见问题诊断矩阵

快速定位问题是运维和开发的关键能力。

| 问题现象 |

可能原因 |

诊断命令 |

解决方案 |

| “Address already in use” |

TIME_WAIT状态未释放 |

ss -tan state time-wait |

设置SO_REUSEADDR |

| 连接拒绝 |

服务未启动/防火墙 |

telnet 主机 端口 iptables -L |

启动服务/配置防火墙 |

| 连接超时 |

路由问题/服务繁忙 |

traceroute 主机 ping 主机 |

检查网络/优化服务 |

| 数据截断 |

缓冲区太小 |

getsockopt SO_RCVBUF |

增大接收缓冲区 |

| 高延迟 |

网络拥塞/CPU瓶颈 |

sar -n DEV 1 top |

QoS配置/代码优化 |

系统性的监控与日志分析,可以借助Grafana等工具构建可视化仪表盘,实现问题的预警与快速定位。

八、Socket编程最佳实践

8.1 错误处理模式

健壮的网络程序必须有完善的错误处理。

// 良好的错误处理示例

int create_server_socket(int port) {

int fd;

struct sockaddr_in addr;

if ((fd = socket(AF_INET, SOCK_STREAM, 0)) < 0) {

log_error("socket failed: %s", strerror(errno));

return -1;

}

// 设置地址重用

int reuse = 1;

if (setsockopt(fd, SOL_SOCKET, SO_REUSEADDR,

&reuse, sizeof(reuse)) < 0) {

log_warn("setsockopt SO_REUSEADDR failed: %s",

strerror(errno));

// 注意:这不是致命错误,继续执行

}

// 设置非阻塞(如果适用)

int flags = fcntl(fd, F_GETFL, 0);

if (flags < 0 || fcntl(fd, F_SETFL, flags | O_NONBLOCK) < 0) {

log_error("fcntl nonblock failed: %s", strerror(errno));

close(fd);

return -1;

}

memset(&addr, 0, sizeof(addr));

addr.sin_family = AF_INET;

addr.sin_addr.s_addr = htonl(INADDR_ANY);

addr.sin_port = htons(port);

if (bind(fd, (struct sockaddr*)&addr, sizeof(addr)) < 0) {

log_error("bind failed: %s", strerror(errno));

close(fd);

return -1;

}

if (listen(fd, SOMAXCONN) < 0) {

log_error("listen failed: %s", strerror(errno));

close(fd);

return -1;

}

return fd;

}

8.2 性能优化要点

- 缓冲区调优:根据应用特性调整系统缓冲区大小,避免频繁的上下文切换。

int bufsize = 256 * 1024; // 256KB

setsockopt(fd, SOL_SOCKET, SO_RCVBUF, &bufsize, sizeof(bufsize));

setsockopt(fd, SOL_SOCKET, SO_SNDBUF, &bufsize, sizeof(bufsize));

- Nagle算法与TCP_NODELAY:对于交互式应用,禁用Nagle算法可以减少延迟,但可能增加小包数量。

int nodelay = 1; // 禁用Nagle算法,减少延迟

setsockopt(fd, IPPROTO_TCP, TCP_NODELAY, &nodelay, sizeof(nodelay));

- 保活机制:用于检测对端是否存活,避免占用半开连接资源。

int keepalive = 1; // 开启保活

int keepidle = 60; // 60秒后开始探测

int keepinterval = 10; // 探测间隔10秒

int keepcount = 5; // 探测5次

setsockopt(fd, SOL_SOCKET, SO_KEEPALIVE, &keepalive, sizeof(keepalive));

setsockopt(fd, IPPROTO_TCP, TCP_KEEPIDLE, &keepidle, sizeof(keepidle));

setsockopt(fd, IPPROTO_TCP, TCP_KEEPINTVL, &keepinterval, sizeof(keepinterval));

setsockopt(fd, IPPROTO_TCP, TCP_KEEPCNT, &keepcount, sizeof(keepcount));

九、总结:Socket编程的精髓

通过本文从用户空间API到内核数据结构的深度探索,我们可以总结出Linux Socket编程的几个核心设计哲学与不同层次的理解。

9.1 核心设计哲学总结

| 设计原则 |

具体体现 |

带来的好处 |

| 一切皆文件 |

Socket使用文件描述符 |

统一I/O模型,简化编程 |

| 分层抽象 |

协议栈分层设计 |

各层独立演进,易于扩展 |

| 生产者-消费者模型 |

接收/发送队列分离 |

解耦数据处理,提高并发性 |

| 事件驱动 |

就绪通知机制(select/poll/epoll) |

高效利用系统资源 |

9.2 Socket编程的四个层次理解

要真正掌握Socket,需要从多个视角来审视它:

1. 应用层视角:Socket是通信端点,提供send()/recv()等API

2. 内核视角:Socket是struct socket+struct sock+文件系统集成

3. 协议栈视角:Socket是协议处理的状态机和缓冲区管理器

4. 硬件视角:Socket是DMA描述符和中断处理程序的抽象

理解这些层次,不仅能帮助你编写出更高效、更稳定的网络程序,也能让你在遇到复杂问题时,具备从应用代码一路追踪到底层硬件的系统性调试能力。希望这篇深度解析能成为你在云栈社区探索网络编程世界的有力指南。