在实际运维工作中,我们难免会遇到各种疑难杂症。当通用的监控告警无法迅速定位根因时,就需要我们登录服务器,运用专业的工具和系统性的方法进行深入分析。这个过程不仅能有效解决问题,更是积累经验、提升技术深度的绝佳机会。拥有一套得心应手的分析工具和方法论,将使我们事半功倍。本文将系统性地介绍 Linux 系统性能分析的核心方法论,并结合 CPU、内存、磁盘 I/O、网络、系统负载等维度,详细讲解各类工具的使用,最后通过一个真实的 Nginx 性能故障案例,展示如何运用 火焰图 等高级工具进行深度剖析。

分析问题的方法论:5W2H

进行性能分析时,可以套用经典的 5W2H 方法,提出以下关键问题,以理清思路:

- What - 现象具体是什么样的?(例如:CPU 飙升、响应变慢、错误率增加)

- When - 问题什么时候发生?是持续性的还是周期性的?

- Why - 为什么会发生?(探究根本原因,而不仅仅是表面现象)

- Where - 问题出现在哪个环节?(是应用层、系统层还是网络层?)

- How much - 耗费了多少资源?(量化影响,例如 CPU 使用率、内存增长量)

- How to do - 如何解决问题?(制定具体的优化或修复方案)

CPU 性能分析

核心概念

对于应用程序,我们主要关注 Linux 内核 CPU 调度器的功能和性能。线程状态是分析的重点,主要分为两类:

- on-CPU: 线程正在执行。执行时间又可细分为用户态时间 (user) 和内核态时间 (sys)。

- off-CPU: 线程处于等待状态。可能是等待下一轮 CPU 调度,也可能是等待 I/O、锁、内存页交换等。

如果系统大量时间花在 on-CPU 状态,那么针对 CPU 的剖析通常能快速定位原因;如果大量时间处于 off-CPU 状态,则问题定位会更复杂,可能涉及 I/O、锁竞争或内存瓶颈。

常用工具一览

说明:

uptime, vmstat, mpstat, top, pidstat 主要用于查看 CPU 及系统负载的整体使用情况。perf 功能强大,可以深入到进程内部,统计具体函数的耗时,并且能够跟踪指定的内核或用户态函数,实现“指哪打哪”的精准分析。

工具使用示例

// 查看系统CPU使用情况及进程列表

top

// 查看所有CPU核心的统计信息(每秒刷新一次)

mpstat -P ALL 1

// 查看CPU使用情况以及系统平均负载

vmstat 1

// 查看特定进程的CPU统计信息

pidstat -u 1 -p pid

// 跟踪进程内部函数级的CPU使用情况(使用cpu-clock事件)

perf top -p pid -e cpu-clock

内存性能分析

核心概念

内存管理的目标是提高效率,但内存问题往往不仅影响性能,还可能直接导致服务崩溃(如 OOM)。分析前需要理清以下概念:主存、虚拟内存、常驻内存、地址空间、页缓存、缺页异常、交换空间等。

常用工具一览

说明:

free, vmstat, top, pidstat, pmap 用于统计系统内存整体信息和进程的内存使用概况。valgrind 是强大的程序调试与分析工具,其 memcheck 组件常用于检测内存泄漏、非法内存访问等问题。dtrace 是一种动态跟踪框架,功能极其灵活,但需要使用者对内核有深入理解并能用 D 语言编写跟踪脚本。

工具使用示例

// 查看系统内存使用情况(以MB为单位)

free -m

// 查看虚拟内存统计信息

vmstat 1

// 动态查看系统内存及进程情况

top

// 以1秒为周期,采集并报告进程的内存统计信息

pidstat -p pid -r 1

// 查看指定进程的内存映射信息

pmap -d pid

// 使用valgrind检测程序内存问题(如内存泄漏)

valgrind --tool=memcheck --leak-check=full --log-file=./log.txt ./program_name

磁盘 I/O 性能分析

核心概念

磁盘通常是计算机中最慢的子系统,极易成为性能瓶颈。CPU 访问磁盘涉及到机械操作(如寻道、旋转),其速度与访问内存相差数个数量级。理解磁盘 I/O 需要了解文件系统、VFS、页缓存 (page cache)、缓冲区缓存 (buffer cache)、inode 等概念。

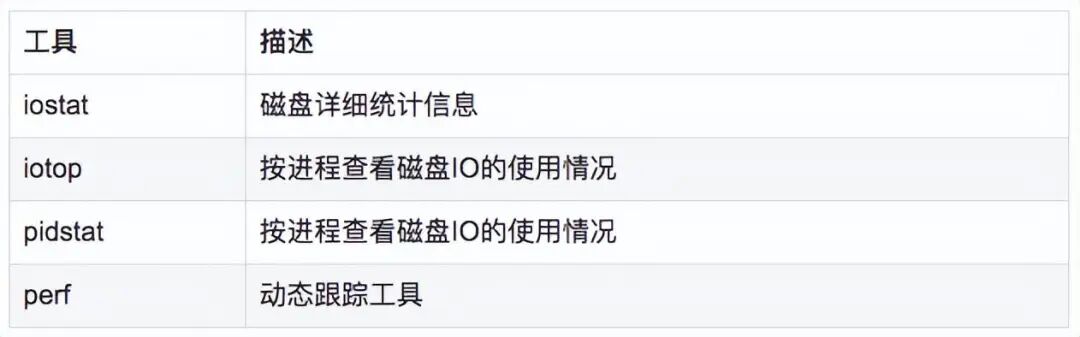

常用工具一览

工具使用示例

// 动态查看每个进程的I/O使用情况(类似top)

iotop

// 详细统计磁盘I/O信息(每秒一次,共10次)

iostat -d -x -k 1 10

// 查看进程级别的I/O统计信息

pidstat -d 1 -p pid

// 使用perf记录块设备I/O请求事件,用于分析异常I/O

perf record -e block:block_rq_issue -ag

# 按 Ctrl+C 停止记录

perf report

网络性能分析

核心概念

网络监测是 Linux 子系统中最复杂的部分,受延迟、阻塞、冲突、丢包等诸多因素影响,且常常与外部网络设备(路由器、交换机)的状态交织在一起,增加了定位难度。现代的 网络 适配器多为自适应网卡,能根据对端设备自动调整速率和工作模式。

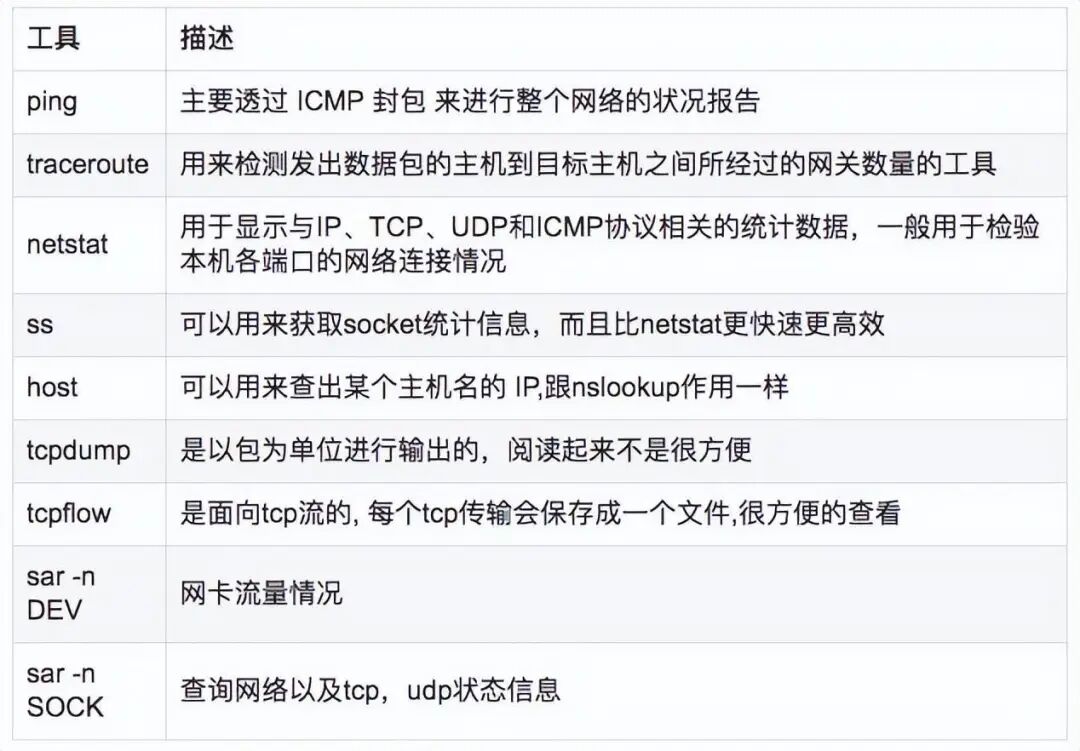

常用工具一览

工具使用示例

// 显示网络统计信息

netstat -s

// 显示当前UDP连接状况

netstat -nu

// 统计机器中网络连接各个状态个数(经典命令)

netstat -a | awk ‘/^tcp/ {++S[$NF]} END {for(a in S) print a, S[a]}’

// 显示TCP连接(比netstat更高效)

ss -t -a

// 显示sockets摘要信息

ss -s

// 查看TCP和ETCP状态统计

sar -n TCP,ETCP 1

// 查看网络设备流量统计

sar -n DEV 1

// 抓取指定主机和端口的数据包

tcpdump -i eth1 host 192.168.1.1 and port 80

// 以流为单位抓包并显示数据内容

tcpflow -cp host 192.168.1.1

系统负载分析

核心概念

系统负载 (Load) 是对系统正在执行和等待执行的工作量的度量,简单理解就是运行队列的长度。平均负载 (Load Average) 是指一段时间(1分钟、5分钟、15分钟)内负载的平均值。

常用工具一览

工具使用示例

// 查看系统平均负载和运行时间

uptime

// 查看系统负载和进程详情(动态)

top

// 查看系统负载、内存、I/O等综合信息

vmstat 1

// 统计指定进程的系统调用耗时情况

strace -c -p pid

// 跟踪指定进程的特定系统调用(如epoll_wait)及其耗时

strace -T -e epoll_wait -p pid

// 查看内核环形缓冲区中的日志信息,常用于诊断硬件和驱动问题

dmesg

深入剖析利器:火焰图 (Flame Graph)

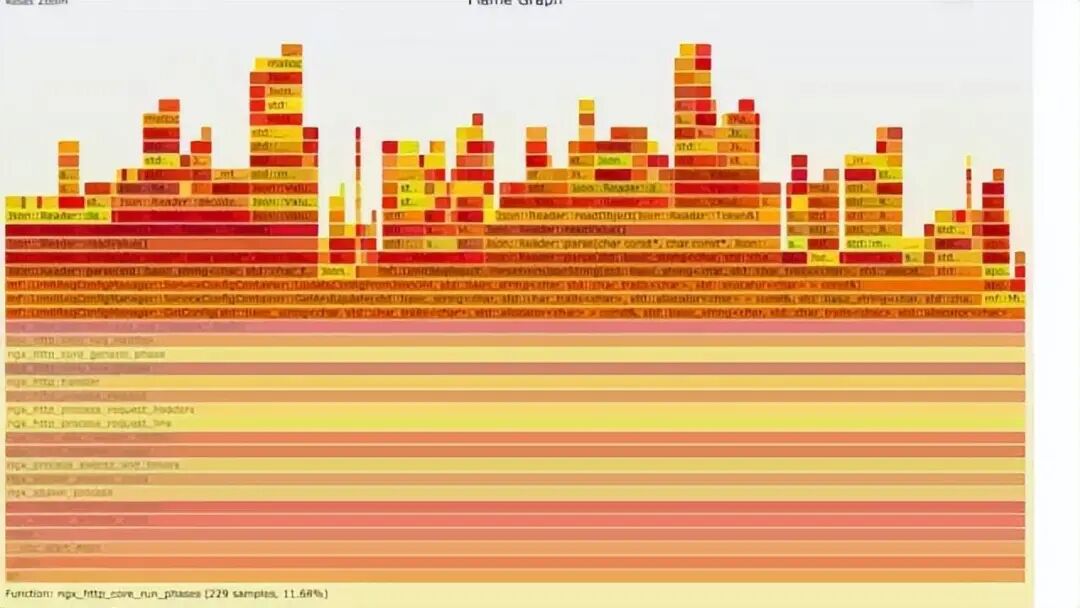

火焰图由性能分析大师 Brendan Gregg 发明,因其形似火焰而得名。它主要用于可视化 CPU 的调用栈,是定位性能热点函数的终极武器之一。

- Y轴:表示调用栈深度,每一层代表一个函数,顶部是正在执行的函数,下方是其父函数。

- X轴:表示抽样数量,而非时间。一个函数在 X 轴越宽,表示它被采样到的次数越多,即执行时间越长。所有调用栈按字母顺序排列。

- 怎么看:主要关注顶部最宽的“平顶”,它通常代表可能存在性能瓶颈的函数。

常见的火焰图类型包括:On-CPU(CPU占用)、Off-CPU(阻塞时间)、内存火焰图等。

安装与准备

生成火焰图通常需要 perf 或 systemtap 等工具,并可能依赖内核调试符号。

# 安装 systemtap(部分系统已默认安装)

yum install systemtap systemtap-runtime

# 安装内核调试符号包(版本必须与当前内核完全一致)

debuginfo-install --enablerepo=debuginfo search kernel

debuginfo-install --enablerepo=debuginfo search glibc

此外,还需要下载火焰图生成脚本:

git clone https://github.com/lidaohang/quick_location.git

cd quick_location

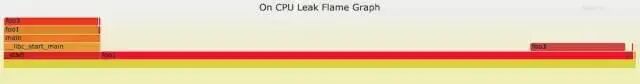

1. On-CPU 火焰图

用于分析 CPU 占用过高的场景,即线程在 on-CPU 状态(用户态或内核态)耗时过长。

// 生成用户态On-CPU火焰图

sh ngx_on_cpu_u.sh pid

cd ngx_on_cpu_u

python -m SimpleHTTPServer 8088

// 然后浏览器访问 http://127.0.0.1:8088/pid.svg

// 生成内核态On-CPU火焰图

sh ngx_on_cpu_k.sh pid

cd ngx_on_cpu_k

python -m SimpleHTTPServer 8088

示例程序与火焰图

#include <stdio.h>

#include <stdlib.h>

void foo3() {}

void foo2() {

int i;

for(i=0 ; i < 10; i++)

foo3();

}

void foo1() {

int i;

for(i = 0; i< 1000; i++)

foo3();

}

int main(void) {

int i;

for( i =0; i< 1000000000; i++) {

foo1();

foo2();

}

}

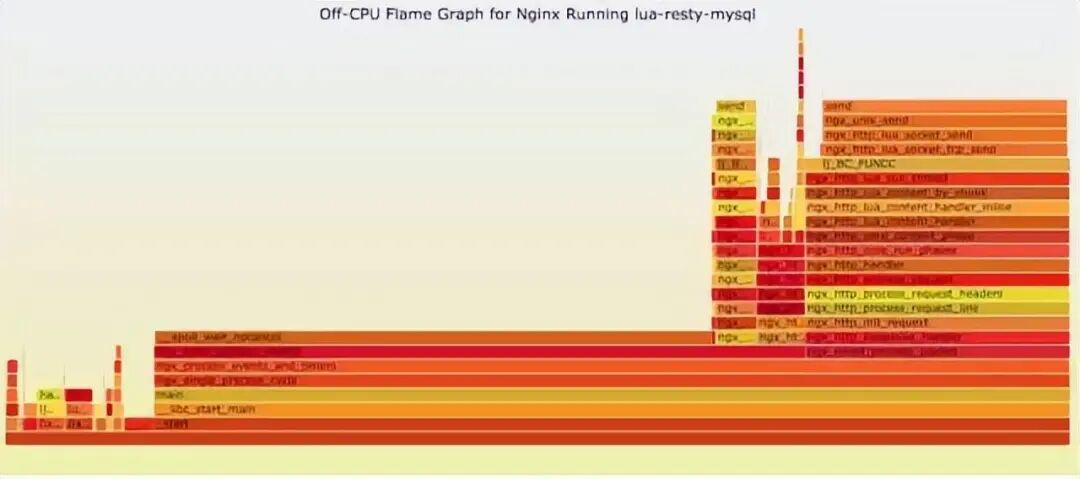

2. Off-CPU 火焰图

用于分析 CPU 利用率不高,但线程因等待 I/O、锁、内存页交换等而处于 off-CPU 状态的场景。

// 生成用户态Off-CPU火焰图

sh ngx_off_cpu_u.sh pid

cd ngx_off_cpu_u

python -m SimpleHTTPServer 8088

// 生成内核态Off-CPU火焰图

sh ngx_off_cpu_k.sh pid

cd ngx_off_cpu_k

python -m SimpleHTTPServer 8088

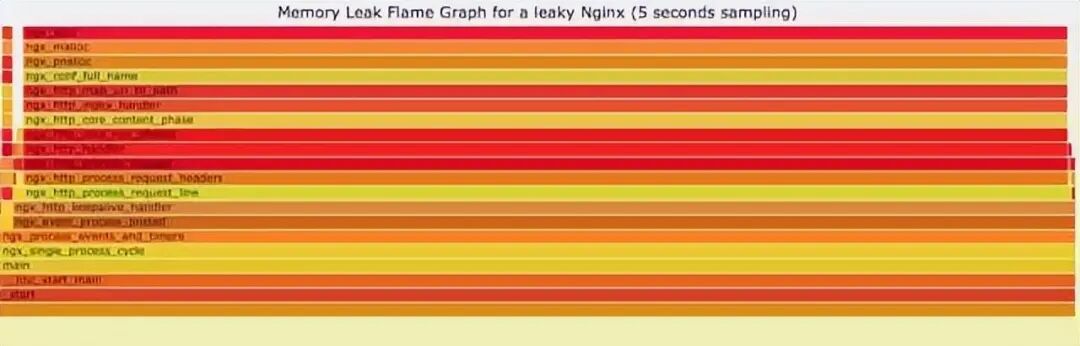

3. 内存火焰图

用于分析内存泄漏或高内存使用的场景,可以直观显示哪些函数调用路径分配了最多的内存。

sh ngx_on_memory.sh pid

cd ngx_on_memory

python -m SimpleHTTPServer 8088

4. 红蓝差分火焰图

用于对比两个时间点或两个版本之间的性能差异,快速定位性能回退的代码。

- 红色:表示在第二个 Profile 中,该函数调用路径的耗时或次数有所增加。

- 蓝色:表示有所减少。

cd quick_location

// 1. 抓取代码修改前的性能数据(Profile 1)

perf record -F 99 -p pid -g -- sleep 30

perf script > out.stacks1

// 2. 抓取代码修改后的性能数据(Profile 2)

perf record -F 99 -p pid -g -- sleep 30

perf script > out.stacks2

// 3. 生成差分火焰图

./FlameGraph/stackcollapse-perf.pl ../out.stacks1 > out.folded1

./FlameGraph/stackcollapse-perf.pl ../out.stacks2 > out.folded2

./FlameGraph/difffolded.pl out.folded1 out.folded2 | ./FlameGraph/flamegraph.pl > diff2.svg

### 实战案例分析:Nginx 集群异常

#### 现象描述

监控系统显示,某 Nginx 集群在特定时间点开始,请求大量返回 499、5xx 状态码,同时服务器 CPU 使用率持续升高。

#### 分析过程

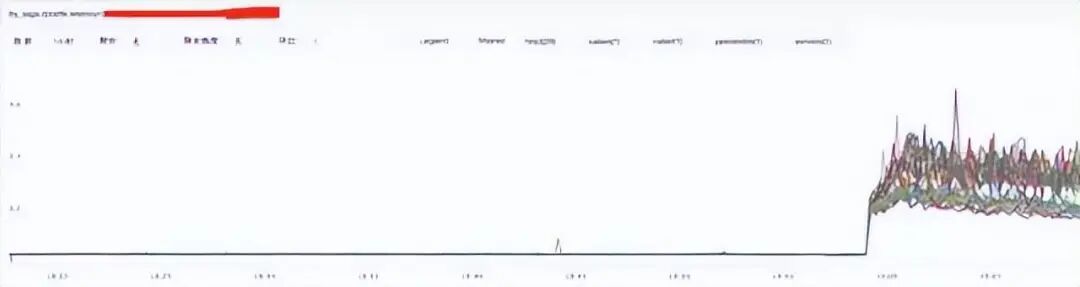

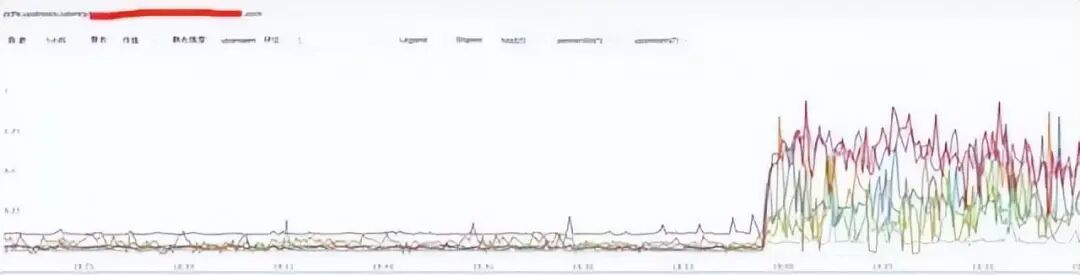

**1. 分析 Nginx 流量与响应时间**

* **流量**:通过流量监控图发现,异常时间段内请求流量并未突增,反而略有下降,排除了流量洪峰导致问题的可能性。

* **Nginx响应时间**:监控显示 Nginx 自身的响应时间变长。

* **Upstream响应时间**:进一步发现,Nginx 后端 upstream 服务的响应时间也显著增加。

**初步结论**:问题可能与后端服务响应变慢有关。

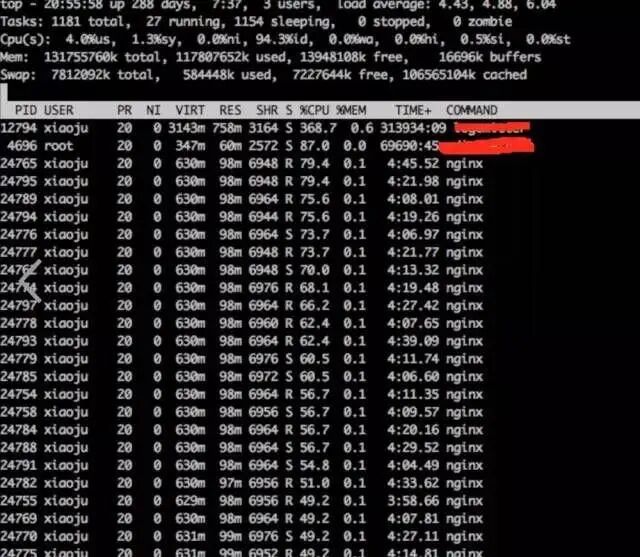

**2. 分析系统 CPU 情况**

* 使用 `top` 命令,发现 Nginx worker 进程的 CPU 使用率异常高。

* 使用 `perf top -p [nginx-pid]` 初步分析,发现 CPU 时间主要消耗在 `free`、`malloc` 和 JSON 解析相关的函数上。

**3. 使用火焰图精准定位**

生成该 Nginx 进程的 **On-CPU 用户态火焰图**,图形化地确认了性能热点。

**火焰图结论**:代码中存在频繁且性能低下的 JSON 解析操作,占用了大量 CPU 时间。

#### 案例总结与解决

**分析矛盾与推理**:最初怀疑是上游服务拖慢 Nginx,但火焰图显示 Nginx 自身存在 CPU 密集型操作。一个合理的推测是:**上游服务可能调用了 Nginx 的某个接口,而这个接口正好触发了高 CPU 消耗的 JSON 解析逻辑**,形成了环路,最终表现为上下游互相拖累。

**解决方式**:采取优先解决明确问题的策略。立即降级或关闭 Nginx 中触发高 CPU 消耗的模块。操作后观察,Nginx 的 CPU 使用率恢复正常,请求状态码也恢复正常。这验证了分析的正确性,后续可针对该 JSON 解析模块进行性能优化或代码重构。

通过这个案例可以看出,结合监控指标、基础命令和高级剖析工具(如火焰图),能够形成一套完整高效的 [故障排查](https://yunpan.plus/f/16-1) 链路,从现象层层深入,最终定位到代码级别的根本原因。更多类似的实战经验和工具分享,欢迎在技术社区进行交流探讨。