在分布式系统中,如何让多个服务节点协同工作?如何实现服务注册与发现?又如何保证配置在众多实例间的一致性?要解决这些经典的分布式难题,一个强大而可靠的协调服务是必不可少的。答案,就藏在 Apache ZooKeeper 之中。它不仅是众多知名开源项目(如Hadoop、HBase、Kafka)的基石,更是构建高可用微服务架构的得力助手。

一、什么是ZooKeeper?

简单来说,ZooKeeper 是一个开源的分布式协调服务,它提供了一个类似文件系统的层级命名空间,并以此为基础,实现了高可用、强一致性的核心特性。它最初由雅虎公司开发,用于解决其内部大型分布式系统的协调问题,如今已成为 Apache 基金会的顶级项目。

1.1 ZooKeeper的核心特性

- 简单性:采用直观的树形数据模型,易于理解和使用。

- 高可用性:通过集群部署,允许部分节点故障而不影响整体服务。

- 强一致性:保证所有客户端读取到的数据状态是一致的。

- 实时性:客户端可以注册监听器,实时获取数据变化的通知。

1.2 为什么需要ZooKeeper?

在构建分布式系统,尤其是微服务架构时,我们总会遇到一些共性的挑战:

- 服务注册与发现:服务实例动态上下线,消费者如何找到它们?

- 配置管理:成百上千个服务实例,如何统一、实时地更新配置?

- 分布式锁:多个服务同时操作共享资源时,如何保证互斥访问?

- Leader选举:集群中多个对等节点,如何自动选出一个“主事人”?

- 分布式协调:如何让多个节点在某个事件上达成一致,或按特定顺序执行?

ZooKeeper 正是为解决上述问题而设计的强大工具。

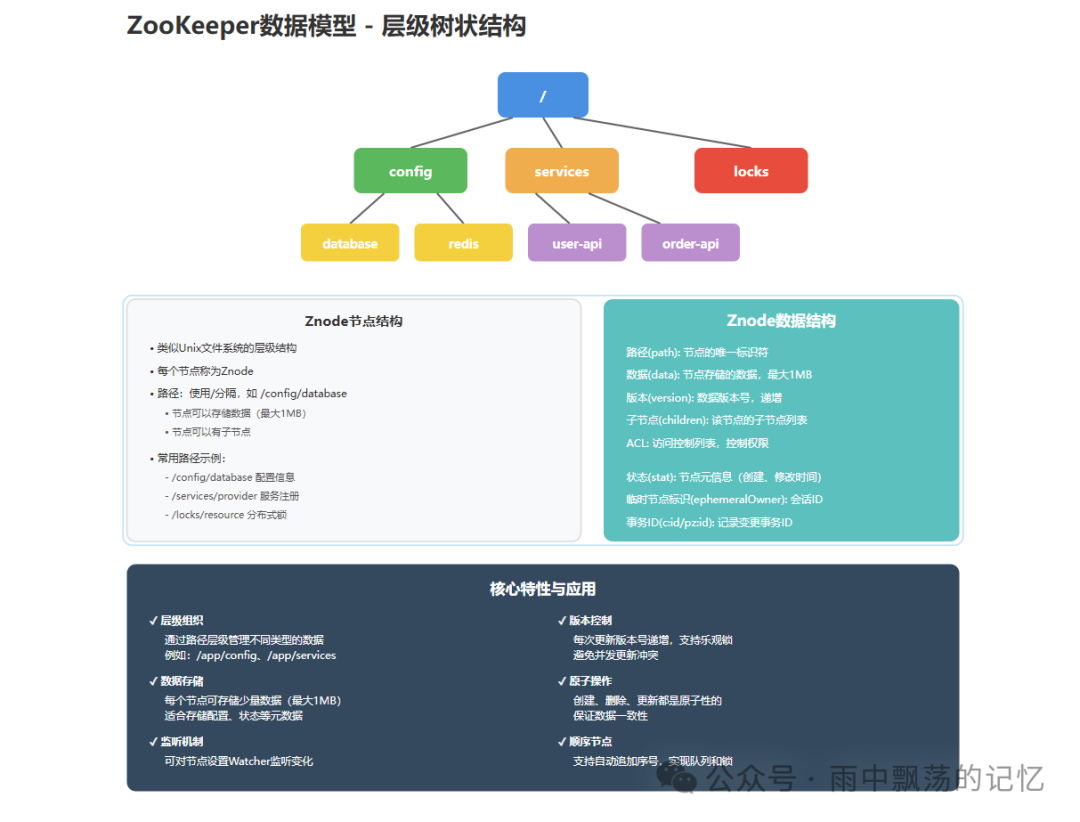

二、ZooKeeper的数据模型

ZooKeeper 的数据模型类似于 Unix 文件系统,是一个层级的树状结构。树中的每个节点被称为 Znode。

2.1 Znode的类型

根据生命周期和特性,Znode 主要分为四种类型:

1. 持久节点(PERSISTENT)

- 生命周期:节点创建后会一直存在,直到被显式删除。

- 应用场景:存储配置信息、服务列表等需要持久化的数据。

- 示例:

/config/database

2. 临时节点(EPHEMERAL)

- 生命周期:与创建它的客户端会话绑定。会话结束(客户端断开连接),节点自动删除。

- 应用场景:服务注册、客户端心跳检测。

- 示例:

/services/provider-001

3. 持久顺序节点(PERSISTENT_SEQUENTIAL)

- 生命周期:与持久节点相同,永久存在。

- 特性:创建时,ZooKeeper 会自动在其名称后追加一个单调递增的10位数字序号。

- 应用场景:分布式队列、生成全局唯一ID。

- 示例:

/tasks/task-0000000001

4. 临时顺序节点(EPHEMERAL_SEQUENTIAL)

- 生命周期:与临时节点相同,会话绑定。

- 特性:创建时自动追加序号。

- 应用场景:实现公平的分布式锁、Leader选举。

- 示例:

/locks/resource-0000000001

2.2 Znode的结构

每个 Znode 不仅仅是一个路径,它还存储着一系列元数据信息。

public class ZnodeData {

String path; // 节点路径

byte[] data; // 节点数据(最大1MB)

int version; // 数据版本号

int cversion; // 子节点版本号

int aversion; // ACL版本号

long ephemeralOwner; // 临时节点所属会话ID

long dataLength; // 数据长度

int numChildren; // 子节点数量

long pzxid; // 最后修改子节点的事务ID

}

三、ZooKeeper的基本操作

ZooKeeper 客户端提供了一套丰富的 API 用于节点操作。

3.1 创建连接

首先需要建立与 ZooKeeper 集群的连接。

public class ZooKeeperConnection {

private static final int SESSION_TIMEOUT = 30000; // 30秒会话超时

private static final String CONNECTION_STRING = "localhost:2181";

private ZooKeeper zooKeeper;

private CountDownLatch connectedLatch = new CountDownLatch(1);

public ZooKeeper connectSync() throws IOException, InterruptedException {

zooKeeper = new ZooKeeper(CONNECTION_STRING, SESSION_TIMEOUT, event -> {

if (event.getState() == Event.KeeperState.SyncConnected) {

connectedLatch.countDown();

}

});

connectedLatch.await(10, TimeUnit.SECONDS);

return zooKeeper;

}

}

关键参数说明:

connectionString:服务器地址,格式为 host:port,多个服务器用逗号分隔。sessionTimeout:会话超时时间(毫秒)。客户端在此期间未与服务器通信,会话将失效。watcher:默认的全局监听器,用于接收连接状态变化等事件。

3.2 创建节点

// 创建持久节点

String path = zooKeeper.create(

"/config/database", // 节点路径

"mysql://localhost:3306/db".getBytes(), // 数据

ZooDefs.Ids.OPEN_ACL_UNSAFE, // 权限(开放)

CreateMode.PERSISTENT // 节点类型

);

// 创建临时节点

String tempPath = zooKeeper.create(

"/services/provider-001",

"192.168.1.100:8080".getBytes(),

ZooDefs.Ids.OPEN_ACL_UNSAFE,

CreateMode.EPHEMERAL

);

// 创建顺序节点

String seqPath = zooKeeper.create(

"/tasks/task-",

"task data".getBytes(),

ZooDefs.Ids.OPEN_ACL_UNSAFE,

CreateMode.PERSISTENT_SEQUENTIAL

);

// 返回路径如:/tasks/task-0000000001

最佳实践:

- 创建节点前建议检查父路径是否存在。

- 做好异常处理,特别是

NodeExistsException。

- 顺序节点的序号是全局单调递增的,可安全用于生成唯一ID。

3.3 读取节点数据

// 简单读取数据

byte[] data = zooKeeper.getData("/config/database", false, null);

String config = new String(data);

// 读取数据并同时注册监听器,获取节点状态信息

Stat stat = new Stat();

byte[] data = zooKeeper.getData("/config/database", watcher, stat);

System.out.println("版本号:" + stat.getVersion());

System.out.println("数据大小:" + stat.getDataLength());

数据版本控制:

- 每次数据更新,版本号(

version)都会递增。

- 结合版本号可以实现 CAS(Compare-And-Swap)乐观锁更新。

Stat 对象包含了节点的所有元信息。

3.4 更新节点数据

// 获取当前状态

Stat stat = zooKeeper.exists("/config/database", false);

// 使用版本号进行乐观锁更新

Stat newStat = zooKeeper.setData(

"/config/database",

"mysql://prod-db:3306/appdb".getBytes(),

stat.getVersion() // 指定版本号

);

注意事项:

- 如果提供的版本号与当前版本不匹配,会抛出

BadVersionException。

- 版本号传

-1 表示不检查版本,强制更新。

- 单个 Znode 存储的数据大小不能超过 1MB。

3.5 删除节点

// 删除节点(需要指定版本号)

Stat stat = zooKeeper.exists("/config/old", false);

if (stat != null) {

zooKeeper.delete("/config/old", stat.getVersion());

}

// 递归删除节点及其所有子节点

public void deleteRecursive(String path) throws Exception {

List<String> children = zooKeeper.getChildren(path, false);

for (String child : children) {

deleteRecursive(path + "/" + child);

}

zooKeeper.delete(path, -1);

}

3.6 获取子节点列表

// 获取子节点列表

List<String> children = zooKeeper.getChildren("/services", false);

// 遍历子节点并获取数据

for (String child : children) {

String childPath = "/services/" + child;

byte[] data = zooKeeper.getData(childPath, false, null);

System.out.println(child + " -> " + new String(data));

}

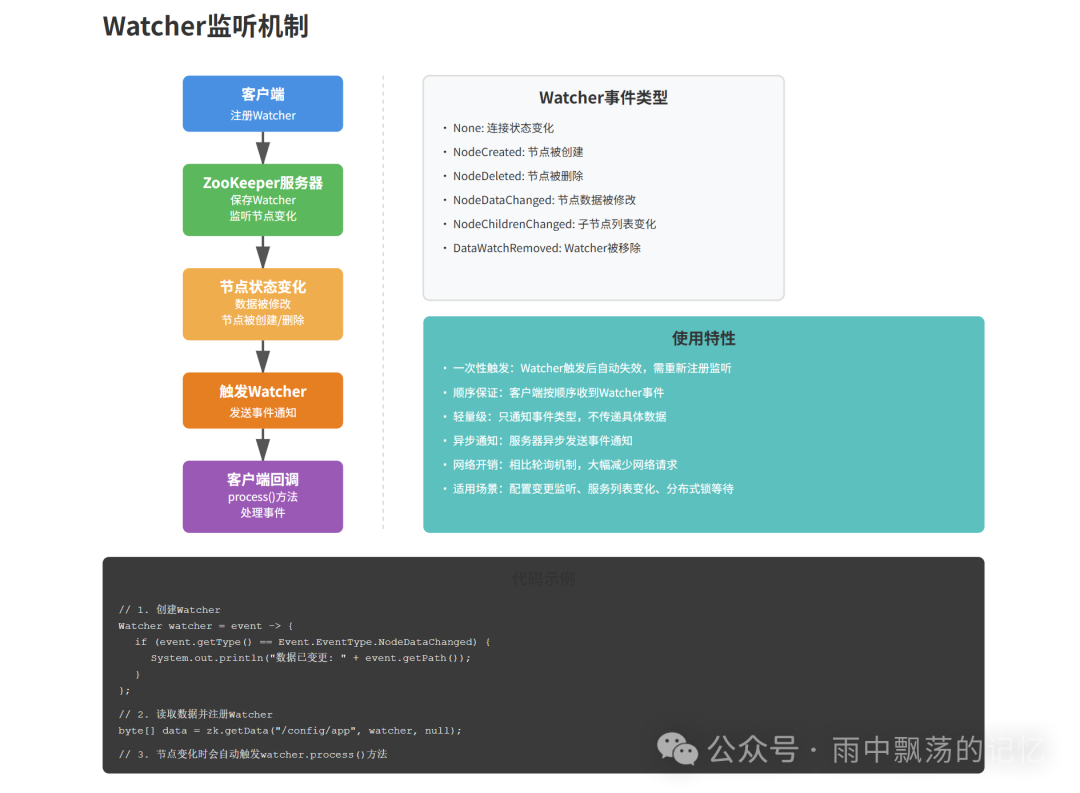

四、Watcher监听机制

Watcher 是 ZooKeeper 实现实时性的核心。客户端可以在指定节点上注册监听器,当该节点发生变化时,ZooKeeper 服务器会主动向客户端发送事件通知。

4.1 Watcher的工作原理

重要特性:

- 一次性触发:Watcher 被触发一次后就会自动失效,如果需要持续监听,必须在回调函数中重新注册。

- 顺序保证:客户端会严格按照事件发生的顺序收到 Watcher 通知。

- 轻量级:通知只包含事件类型和节点路径,不包含具体的变化数据,客户端需主动拉取新数据。

4.2 可监听的事件类型

public enum EventType {

None(-1), // 连接状态变化

NodeCreated(1), // 节点被创建

NodeDeleted(2), // 节点被删除

NodeDataChanged(3), // 节点数据被修改

NodeChildrenChanged(4),// 子节点列表变化

DataWatchRemoved(5), // Watcher被移除

ChildWatchRemoved(6) // 子节点Watcher被移除

}

4.3 Watcher使用示例

public class ConfigWatcher implements Watcher {

private ZooKeeper zooKeeper;

@Override

public void process(WatchedEvent event) {

switch (event.getType()) {

case NodeDataChanged:

System.out.println("配置数据已变更:" + event.getPath());

// 读取新配置,并重新注册Watcher以实现持续监听

try {

byte[] data = zooKeeper.getData(event.getPath(), this, null);

System.out.println("新配置:" + new String(data));

} catch (Exception e) {

e.printStackTrace();

}

break;

case NodeDeleted:

System.out.println("配置节点已删除");

break;

default:

break;

}

}

}

4.4 Watcher的最佳实践

- 实现持续监听:在

process 方法中,针对关心的变化,重新调用 getData、exists 或 getChildren 并传入 this 以重新注册 Watcher。

- 妥善处理异常:注意处理

ConnectionLoss(连接丢失)、SessionExpired(会话过期)等异常,并实现重连和状态恢复逻辑。

- 避免过度监听:Watcher 虽然高效,但过多或不必要的监听仍会带来开销。应根据业务需求设计合理的监听粒度。

五、实战应用

5.1 服务注册与发现

场景描述:在微服务架构中,服务提供者启动时将自身网络地址注册到 ZooKeeper,服务消费者则从 ZooKeeper 动态获取可用的提供者列表。

实现方案:

// 服务提供者注册

public class ServiceProvider {

private ZooKeeper zooKeeper;

private String servicePath = "/services/user-service";

public void register(String address) throws Exception {

// 创建临时顺序节点,会话断开后自动删除,实现服务下线自动清理

String path = zooKeeper.create(

servicePath + "/provider-",

address.getBytes(),

ZooDefs.Ids.OPEN_ACL_UNSAFE,

CreateMode.EPHEMERAL_SEQUENTIAL

);

System.out.println("服务注册成功:" + path);

}

}

// 服务消费者发现

public class ServiceConsumer {

private ZooKeeper zooKeeper;

public List<String> discover(String serviceName) throws Exception {

String path = "/services/" + serviceName;

List<String> providers = zooKeeper.getChildren(path, false);

List<String> addresses = new ArrayList<>();

for (String provider : providers) {

byte[] data = zooKeeper.getData(path + "/" + provider, false, null);

addresses.add(new String(data));

}

return addresses;

}

}

生产环境增强:

- 负载均衡:消费者获取地址列表后,可结合随机、轮询、最少连接等策略选择提供者。

- 健康检查与实时更新:消费者监听服务路径(

/services/user-service)的子节点变化事件,实时更新本地服务列表,剔除下线实例。

- 容错与重试:调用失败时自动重试其他服务实例。

5.2 分布式配置中心

场景描述:多个微服务实例需要共享同一份配置(如数据库连接串),且配置变更时需要实时推送到所有实例,无需重启服务。

public class ConfigCenter {

private ZooKeeper zooKeeper;

private volatile ConfigData currentConfig;

public void init(String configPath) throws Exception {

// 1. 监听配置变化

watchConfig(configPath);

// 2. 加载初始配置

loadConfig(configPath);

}

private void watchConfig(String path) throws Exception {

zooKeeper.exists(path, event -> {

if (event.getType() == Event.EventType.NodeDataChanged) {

try {

loadConfig(path); // 加载新配置

watchConfig(path); // 重新注册Watcher,实现持续监听

} catch (Exception e) {

e.printStackTrace();

}

}

});

}

private void loadConfig(String path) throws Exception {

byte[] data = zooKeeper.getData(path, false, null);

ConfigData newConfig = parseConfig(data);

this.currentConfig = newConfig; // 原子更新配置

System.out.println("配置已更新:" + newConfig);

}

public ConfigData getConfig() {

return currentConfig;

}

}

配置格式示例:

{

"database": {

"url": "jdbc:mysql://localhost:3306/appdb",

"username": "admin",

"password": "password"

},

"redis": {

"host": "localhost",

"port": 6379

}

}

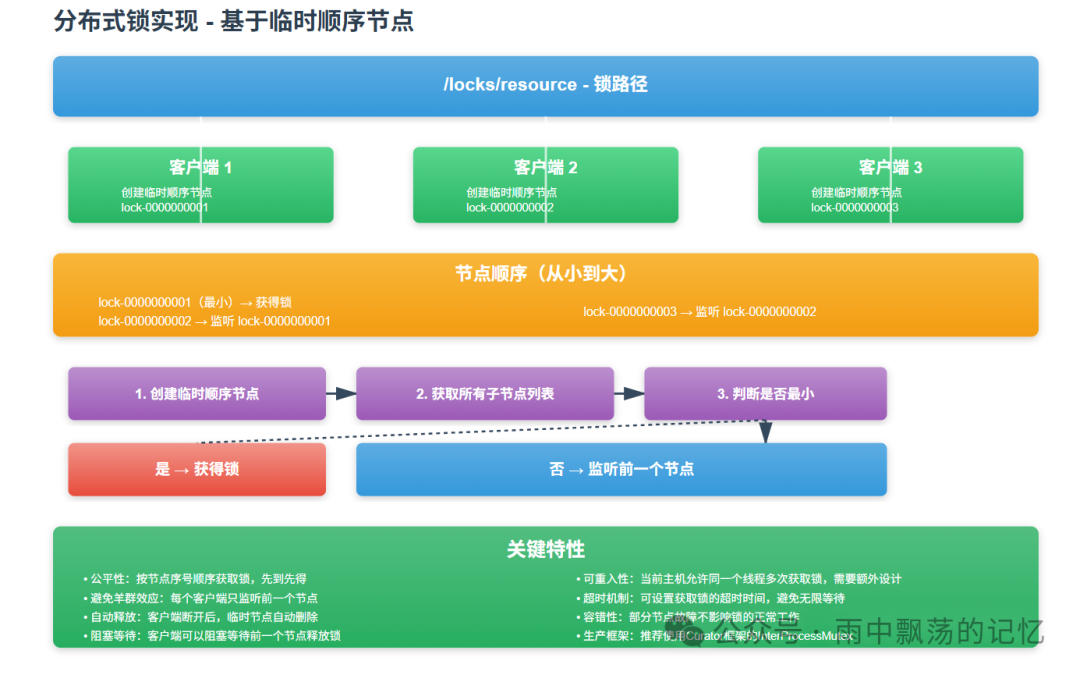

5.3 分布式锁

场景描述:在分布式环境下,多个服务实例需要互斥地访问某一共享资源(如扣减库存、生成唯一订单号)。

实现方案:使用临时顺序节点实现公平锁。

public class DistributedLock {

private ZooKeeper zooKeeper;

private String lockPath;

private String currentLock;

public boolean lock(long timeout, TimeUnit unit) throws Exception {

// 1. 创建临时顺序节点

currentLock = zooKeeper.create(

lockPath + "/lock-",

null,

ZooDefs.Ids.OPEN_ACL_UNSAFE,

CreateMode.EPHEMERAL_SEQUENTIAL

);

// 2. 检查自己是否是最小的节点

while (true) {

List<String> locks = zooKeeper.getChildren(lockPath, false);

Collections.sort(locks); // 按序号排序

String current = currentLock.substring(currentLock.lastIndexOf('/') + 1);

int index = locks.indexOf(current);

if (index == 0) {

return true; // 当前节点序号最小,获得锁

}

// 3. 监听前一个节点(序号比自己小1的节点)

String previousLock = locks.get(index - 1);

final CountDownLatch latch = new CountDownLatch(1);

Stat stat = zooKeeper.exists(

lockPath + "/" + previousLock,

event -> {

if (event.getType() == Event.EventType.NodeDeleted) {

latch.countDown(); // 前一个节点释放了锁

}

}

);

if (stat == null) {

continue; // 前一个节点可能已释放,重新检查

}

// 4. 阻塞等待,直到前一个节点释放锁或超时

if (!latch.await(timeout, unit)) {

return false; // 获取锁超时

}

}

}

public void unlock() throws Exception {

zooKeeper.delete(currentLock, -1); // 释放锁,删除自己的临时节点

}

}

使用示例:

DistributedLock lock = new DistributedLock(zk, "/locks/order-resource");

try {

if (lock.lock(10, TimeUnit.SECONDS)) {

// 成功获取锁,执行业务逻辑

processOrder();

}

} finally {

lock.unlock(); // 确保锁被释放

}

锁的实现要点:

- 公平性:按节点创建顺序(序号)获取锁,先到先得。

- 避免羊群效应:每个客户端只监听它前面的一个节点,而不是监听根节点或所有节点,大大减少了事件通知的数量。

- 自动释放:客户端会话异常断开时,其创建的临时节点会被自动删除,相当于自动释放了锁,防止死锁。

- 生产建议:实际项目中推荐使用 Netflix Curator 框架的

InterProcessMutex,它封装了更完善的重试、容错逻辑。

5.4 Leader选举

场景描述:在集群中,多个对等的服务节点需要选举出一个 Leader 来执行某些特定的管理任务(如 HBase 的 HMaster、Spark 的 Standalone Master)。

实现方案:其核心思想与分布式锁类似,都是利用临时顺序节点的特性。

public class LeaderElection {

private ZooKeeper zooKeeper;

private String electionPath;

private String currentNode;

public void elect() throws Exception {

// 1. 创建临时顺序节点参与选举

currentNode = zooKeeper.create(

electionPath + "/node_",

null,

ZooDefs.Ids.OPEN_ACL_UNSAFE,

CreateMode.EPHEMERAL_SEQUENTIAL

);

// 2. 检查自己是否成为Leader

checkLeader();

// 3. 监听前一个节点,等待Leader变更

watchPreviousNode();

}

private void checkLeader() throws Exception {

List<String> nodes = zooKeeper.getChildren(electionPath, false);

Collections.sort(nodes);

String current = currentNode.substring(currentNode.lastIndexOf('/') + 1);

int index = nodes.indexOf(current);

if (index == 0) {

onBecomeLeader(); // 成为Leader

} else {

onBecomeFollower(); // 成为Follower

}

}

private void onBecomeLeader() {

System.out.println("成为Leader节点");

// 开始执行Leader独有的任务,如任务调度、数据分发

}

private void onBecomeFollower() {

System.out.println("成为Follower节点");

// 等待或执行非Leader任务

}

}

六、最佳实践

6.1 部署架构

- 集群规模:

- 开发/测试环境:3个节点(允许1个节点故障)。

- 生产环境:建议5个或7个节点(遵循“2n+1”原则,允许n个节点故障)。避免使用偶数个节点。

- 服务器配置:

- CPU:4核以上。

- 内存:4GB以上,根据数据量和客户端连接数调整。

- 磁盘:使用 SSD 以获得低延迟的读写性能,将数据目录(

dataDir)和事务日志目录(dataLogDir)分开以提高吞吐量。

- 网络:确保集群节点间网络低延迟、高带宽且稳定。

6.2 配置优化(zoo.cfg)

# 基本配置

tickTime=2000 # 心跳基时(毫秒),所有其他时间配置都是它的倍数

initLimit=10 # 集群中Follower与Leader初始连接时能容忍的最大心跳数

syncLimit=5 # 集群中Follower与Leader同步数据时的最大响应等待心跳数

dataDir=/var/lib/zookeeper # 数据快照目录

dataLogDir=/var/log/zookeeper # 事务日志目录(建议与dataDir分开)

clientPort=2181 # 客户端连接端口

# 集群配置(3节点示例)

server.1=zk1:2888:3888

server.2=zk2:2888:3888

server.3=zk3:2888:3888

# 格式:server.myid=host:port1:port2

# myid: 每个服务器的唯一ID(1-255),需在对应服务器的dataDir下创建myid文件并写入该ID。

# port1: Leader和Follower之间通信和数据同步的端口。

# port2: 用于Leader选举的端口。

# 性能与资源限制

maxClientCnxns=60 # 单个IP到单台服务器的最大连接数

jute.maxbuffer=1048575 # 单个数据节点最大数据量(字节),接近1MB

autopurge.snapRetainCount=3 # 保留的快照文件数量

autopurge.purgeInterval=1 # 清理任务执行间隔(小时)

preAllocSize=64M # 预分配事务日志文件大小

6.3 客户端配置

// 生产环境推荐的客户端配置

public ZooKeeper createProductionClient() throws IOException {

// 连接字符串:包含所有集群节点地址,提高容错性

String connectionString = "zk1:2181,zk2:2181,zk3:2181";

// 会话超时:根据网络状况和业务容忍度设置,通常30-60秒

int sessionTimeout = 30000; // 30秒

// 创建连接

ZooKeeper zk = new ZooKeeper(

connectionString,

sessionTimeout,

event -> handleEvent(event) // 处理连接状态事件

);

return zk;

}

七、总结

通过本文,我们从核心概念到实战应用,系统性地剖析了 ZooKeeper。作为分布式系统的“瑞士军刀”,它主要提供了以下核心能力:

- 统一的数据模型与原子操作:以树形 Znode 为基础,提供强一致性的增删改查。

- 高效的监听机制(Watcher):实现了服务端向客户端的主动事件推送,是实时性的关键。

- 丰富的节点类型:尤其是临时顺序节点,是构建分布式锁、Leader 选举等高阶功能的基石。

- 经典的应用模式:直接支持服务注册发现、配置中心、分布式锁、Leader选举等分布式通用模式。

掌握 ZooKeeper,意味着你掌握了解决分布式系统核心协调问题的一套成熟方法论。虽然如今有 etcd、Consul 等后起之秀,但 ZooKeeper 在稳定性、社区生态和与大数据栈的整合度上依然拥有不可替代的地位。

在实际开发中,对于 Java 应用,强烈建议使用 Netflix 开源的 Curator 框架,它对 ZooKeeper 原生 API 进行了高级封装,提供了更多易用的配方(Recipes),如分布式锁、计数器、屏障等,能极大地降低开发复杂度和出错概率。

希望这篇从入门到实战的指南能帮助你更好地理解和使用 ZooKeeper。如果你在实践过程中遇到任何问题,或想深入探讨分布式系统的其他主题,欢迎来到 云栈社区 与更多开发者交流分享。