昨天,Ultralytics 正式发布了 YOLO26,这不仅是迄今为止最先进的模型,也是最易于部署的 YOLO 版本。YOLO26 最早在 YOLO Vision 2025(YV25)大会上首次亮相,它标志着计算机视觉模型在训练、部署以及规模化路径上发生了根本性转变。

如今,视觉 AI 正快速向边缘端迁移。图像和视频越来越多地直接在设备、摄像头和嵌入式系统上进行本地处理,在这些场景中,低延迟、高可靠性和成本控制远比纯粹的云计算能力更为重要。YOLO26 正是为这一现实场景量身打造,它能够在 CPU、边缘加速器和低功耗硬件上高效运行,同时提供业界领先的性能。

尽管实现了跨越式升级,YOLO26 依然延续了 Ultralytics YOLO 家族简洁易用的特性。模型能够无缝融入现有工作流程,支持多种视觉任务,无论是研究团队还是生产团队都能轻松上手。

官方使用地址: https://pse.is/8lgx94

本文将详细解析 Ultralytics YOLO26 的核心技术特性,并探讨这款更轻量化、更快速的模型对计算机视觉未来发展的意义。

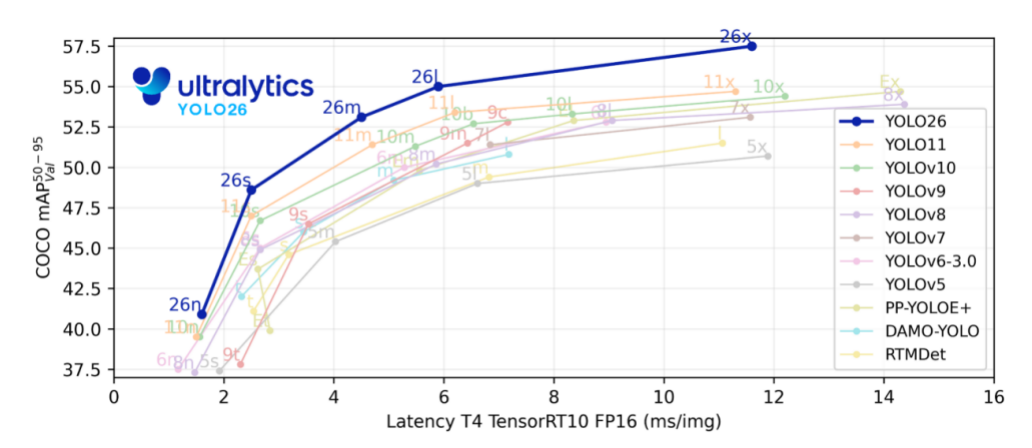

Ultralytics YOLO26:树立视觉 AI 新标杆

Ultralytics YOLO26 的核心设计理念是:让真正具备实用价值的视觉 AI 技术触手可及,惠及每一个人。 强大的工具不应只掌握在少数组织手中。

在 YV25 大会上,公司创始人兼首席执行官 Glenn Jocher 分享道:“最顶尖的 AI 技术往往被束之高阁。大型企业掌控着新技术的发展,其他人只能等待。Ultralytics 选择了一条不同的道路,我们希望 AI 能真正掌握在每个人手中。”

他进一步解释,这意味着要将 AI 从云端带到真实世界:“我们希望这项技术下沉到边缘设备、手机、车辆以及低功耗系统中。让那些致力于创造解决方案的优秀开发者们能够获得这样的技术支持。”

YOLO26 的设计正是这一愿景的实践:它专为视觉 AI 的实际部署场景而生,而非只适合原型验证。

Ultralytics YOLO26 的核心优势

与前辈一样,YOLO26 采用统一的模型家族设计,支持多种计算机视觉任务。模型提供五种尺寸选择:Nano(n)、Small(s)、Medium(m)、Large(l)和 Extra Large(x),开发者可以根据部署环境,在速度、精度和模型大小之间灵活权衡。

在性能层面,YOLO26 进一步提升了上限。与 YOLO11 相比,YOLO26 的 Nano 版本在 CPU 推理场景下最高可实现 43% 的性能提升,成为目前边缘端和基于 CPU 部署场景中,速度与精度兼顾的领先目标检测模型之一。

YOLO26 支持的计算机视觉任务包括:

- 图像分类:对整张图像进行分析并归类,帮助系统理解场景整体语义。

- 目标检测:在图像或视频中定位并识别多个目标。

- 实例分割:以像素级精度勾勒单个物体的轮廓。

- 姿态估计:识别关键点并估计人体或其他对象的姿态。

- 旋转框(OBB)检测:支持不同角度目标检测,适用于航拍和卫星影像。

- 目标跟踪:结合 Ultralytics Python 包,可在视频流中持续跟踪目标。

所有任务均在同一框架下支持训练、验证、推理与模型导出。

Ultralytics YOLO26 的关键创新

YOLO26 引入了多项核心创新,全面提升了推理速度、训练稳定性和部署便捷性:

- 移除分布焦点损失(DFL):删除了 DFL 模块,简化了边界框预测过程,提升了硬件兼容性,让模型更易于导出并在边缘设备上运行。

- 端到端无 NMS 推理:YOLO26 原生支持端到端推理,可直接输出最终预测,无需依赖非极大值抑制(NMS),减少了延迟和部署复杂度。

- 渐进式损失平衡(ProgLoss)+ 小目标感知标签分配(STAL):这些优化的损失策略稳定了训练过程,提升了检测精度,尤其针对难以检测的小目标。

- MuSGD 优化器:采用全新混合优化器,融合了 SGD 与 Muon 的优化方法,使模型训练更加稳定。

- CPU 推理速度提升高达 43%:专为边缘计算优化,可在边缘设备上实现实时性能。

接下来,我们将详细拆解这些下一代特性。

移除分布焦点损失(DFL),简化预测流程

早期 YOLO 模型使用分布焦点损失(DFL)来提升边界框精度。尽管有效,但 DFL 增加了模型复杂度,且对回归范围设置了固定限制,给模型导出和部署带来挑战。

YOLO26 完全移除了 DFL 模块。这一改动消除了固定边界框回归限制,提升了检测超大物体时的可靠性和准确性。通过简化预测流程,YOLO26 更易于导出,且能在各类边缘硬件上稳定运行。

端到端无 NMS 推理

传统目标检测流程依赖非极大值抑制(NMS)作为后处理步骤来过滤重叠预测。尽管有效,但 NMS 会增加延迟和复杂度,且在不同硬件上部署时容易不稳定。

YOLO26 引入原生端到端推理模式,模型可直接输出最终预测,重复预测的过滤操作在[网络内部完成。移除 NMS 不仅降低了延迟、简化了部署,还减少了集成错误的风险,使 YOLO26 特别适合实时和边缘部署场景。

渐进式损失平衡(ProgLoss)+ 小目标感知标签分配(STAL),提升识别能力

训练相关的关键特性是引入了渐进式损失平衡(ProgLoss)和小目标感知标签分配(STAL)。ProgLoss 让模型在训练过程中学习更稳定,减少了训练波动。同时,STAL 则针对小目标进行了优化,改善模型在视觉信息有限情况下的学习效果。

二者的结合实现了更可靠的检测效果,尤其在小目标识别方面有显著提升。这对于物联网(IoT)、机器人技术和航空影像等边缘应用至关重要。

MuSGD 优化器,实现更稳定的训练

YOLO26 采用了新的优化器 MuSGD,用于提升训练的稳定性和效率。MuSGD 将传统随机梯度下降(SGD)的优势,与源自大语言模型训练的 Muon 类优化思想相结合。

受相关训练经验启发,MuSGD 融入了有助于模型更平稳收敛的策略。这使得 YOLO26 能够更快达到出色性能,同时减少训练不稳定性,在更大规模或更复杂的训练场景中效果显著。

CPU 推理速度提升高达 43%

随着视觉 AI 不断向数据产生端靠近,边缘性能的重要性持续提升。YOLO26 针对边缘计算场景进行了深度优化,在无 GPU 的条件下,CPU 推理速度最高提升可达 43%。

这一能力使实时视觉系统能够直接运行在摄像头、机器人和嵌入式硬件上,满足低延迟、高可靠性和成本受限的实际需求。

对视觉任务进一步优化

除了提升目标检测精度的架构改进外,YOLO26 还包含针对特定任务的优化:

- 实例分割:YOLO26 使用语义分割损失改进训练,从而生成更准确、更一致的实例掩码。升级后的原型模块支持利用多尺度信息,有效处理不同尺寸的物体。

- 姿态估计:集成 Residual Log-Likelihood Estimation(RLE),更好地建模关键点预测的不确定性,同时优化解码流程,实现更高精度与实时性。

- 旋转边界框检测:新增角度损失函数,帮助模型更准确地学习物体旋转角度,尤其适用于方向模糊的方形物体。优化后的 OBB 解码过程减少了预测突变,实现了更稳定、一致的方向估计。

Ultralytics YOLOE-26:基于 YOLO26 的开放词汇分割模型

Ultralytics 同时推出了 YOLOE-26:一个基于 YOLO26 架构和训练策略的开放词汇分割模型系列。

YOLOE-26 并非全新任务,而是一个专用模型家族,它复用了现有的分割任务,同时支持文本提示、视觉提示和无提示推理。该模型家族涵盖所有标准尺寸,相比早期开放词汇分割模型,精度更高,实际应用性能更可靠。

Ultralytics YOLO26:为视觉 AI 的实际运行场景量身打造

从视觉驱动的摄像头到计算机视觉赋能的机器人,计算机视觉正越来越多地部署在设备本地。YOLO26 正是为这些对延迟、效率和稳定性要求极高的场景而设计。

在实际应用中,YOLO26 可轻松部署在各类硬件上。 通过 Ultralytics Python 包,模型可以导出为针对不同平台优化的格式。例如,导出为 TensorRT 格式可在 NVIDIA GPU 上实现高性能推理,CoreML 格式支持苹果设备原生部署,OpenVINO 则能优化英特尔硬件的性能。YOLO26 还可导出至多款专用边缘加速器,在专业边缘 AI 硬件上实现高能效推理。

这种灵活性使得单个 YOLO26 模型能够适配多种部署目标,简化了生产工作流程,让视觉 AI 更贴近边缘端应用。

重塑各行业计算机视觉应用场景

YOLO26 专为实际部署设计,可广泛应用于不同行业:

- 机器人领域:用于导航、障碍物检测和物体交互,支持机器人在动态环境中安全高效运行。

- 制造业:在生产线上分析图像和视频,识别缺陷或流程问题。本地数据处理确保了检测速度,减少对云的依赖。

- 航空和无人机应用:部署在无人机上处理航空影像,用于实时检测、测绘和勘测。

- 嵌入式和物联网系统:凭借轻量化设计,在低功耗嵌入式硬件上运行,实现本地视觉数据处理,如智能摄像头和监控设备。

- 智慧城市:分析交通和公共区域摄像头视频流,支持边缘端的交通监控和公共安全管理。

快速上手 Ultralytics YOLO26

YOLO26 提供两种主要使用方式:

方式一:通过 Ultralytics 平台使用 YOLO26(推荐)

Ultralytics 平台提供了集中式的训练、部署和监控方案,可在生产环境中管理 YOLO26 模型。它将数据集、实验和部署流程整合在一起,便于规模化管理视觉 AI 工作流程,尤其适合面向边缘和生产环境部署的团队。

在平台上,用户可以获取模型、在自定义数据集上训练和微调、导出模型用于部署,并在统一工作流程中监控进度。

前往 Ultralytics 平台探索 YOLO26: https://pse.is/8lgx94

方式二:通过开源工作流使用 YOLO26

YOLO26 仍可通过 Ultralytics 开源生态系统完全访问,支持使用现有的基于 Python 的流程进行训练、推理和导出。

开发者可以安装 Ultralytics 包,加载预训练的 YOLO26 模型,并使用常用工具和格式进行部署。

pip install ultralytics

from ultralytics import YOLO

# 加载COCO预训练的YOLO26n模型

model = YOLO("yolo26n.pt")

# 使用YOLO26n模型对图像进行推理

results = model("path/to/bus.jpg")

完整的使用指南和教程可以在Ultralytics 文档中查看: https://docs.ultralytics.com/

结语

Ultralytics YOLO26 旨在满足未来视觉 AI 解决方案的需求,其快速、高效且易于部署的特性,使其能自然适配各类实际应用场景。通过提升性能、简化部署并扩展功能,YOLO26 为视觉 AI 的构建、部署和规模化应用树立了新基准。我们期待看到社区基于 YOLO26 构建出更多实用的计算机视觉系统。

想要了解更多 AI 相关内容,欢迎访问我们的 GitHub仓库: https://github.com/ultralytics/ultralytics

如果你对这类前沿计算机视觉技术的部署与实战感兴趣,欢迎到云栈社区与更多开发者交流探讨。