“医生,这张病理切片能放大看看吗?”

“稍等,我先下载 3 个 G……”

在数字病理、医学影像或生物信息领域,你一定对这样的场景不陌生:一张全切片图像动辄 1-3GB。传统工作流需要将整个文件下载到本地,或挂载网络存储后,才能用 OpenSlide、QuPath 这类工具查看。这个过程不仅慢,还消耗大量硬盘空间和网络带宽,在远程协作或云端部署时尤为不便。

今天介绍的这个 开源实战 项目——WSIStreamer,完全颠覆了这一流程。它只需一行命令,就能直接从 S3 或兼容的对象存储中“流式”读取瓦片数据,无需下载完整文件,无需本地缓存,打开浏览器即可秒看高清病理切片。更令人印象深刻的是,它采用 Rust 编写,性能极致,架构极简,Docker 镜像仅有几十 MB。

本文将深入剖析这个“小而美”的工具,探究它如何运用 HTTP Range 请求、原生格式解析与多级缓存,将一个复杂的医学图像服务难题,简化成“一行命令搞定”的工程实践。

为什么我们需要“流式”瓦片服务器?

在深入技术细节前,我们首先要明白:为何传统方式如此低效?

一张 WSI 文件本质上是一个多分辨率金字塔结构的图像。它类似于 Google Maps:最顶层是整个图像的缩略图,往下每一层的分辨率都加倍,直到最底层的原始高分辨率。每一层又被规则地切分成许多 256x256 的小块,称为“瓦片”。

当你在浏览器中拖动、缩放查看时,前端只会请求当前视口所需的几个瓦片。理论上,只需几百 KB 的数据就能看到局部高清细节。

但核心问题在于:这些瓦片并非物理上独立的文件,它们被封装在一个巨大的 TIFF 或 SVS 文件中。传统基于 OpenSlide 的方案必须将整个数 GB 的文件完整下载到本地,解析其内部结构后,才能按需提取瓦片。这导致了:

- 首次加载极慢:即使只想查看一个小区域,也必须等待整个文件下载完毕。

- 存储成本高昂:每台服务器都需要配备大容量本地磁盘用于缓存。

- 扩展性差:难以直接与云存储对接,无法轻松实现横向扩展。

因此,“流式瓦片服务” 的概念应运而生:只读取文件中特定的一小段字节,通过 HTTP Range 请求直接从对象存储获取,实时解码后返回给前端。

实现这一目标极具挑战,它要求开发者:

- 深刻理解 WSI 文件内部结构。

- 精确计算每个瓦片在文件中的字节偏移。

- 高效发起并管理 Range 请求。

- 处理 JPEG、JPEG2000 等压缩格式的解码。

而 WSIStreamer,正是用 Rust 优雅地攻克了这些难题。

一行命令,开启“云原生”病理图像服务

让我们从最直观的部分开始:如何使用?

首先安装 WSIStreamer(需要 Rust 环境):

cargo install wsi-streamer

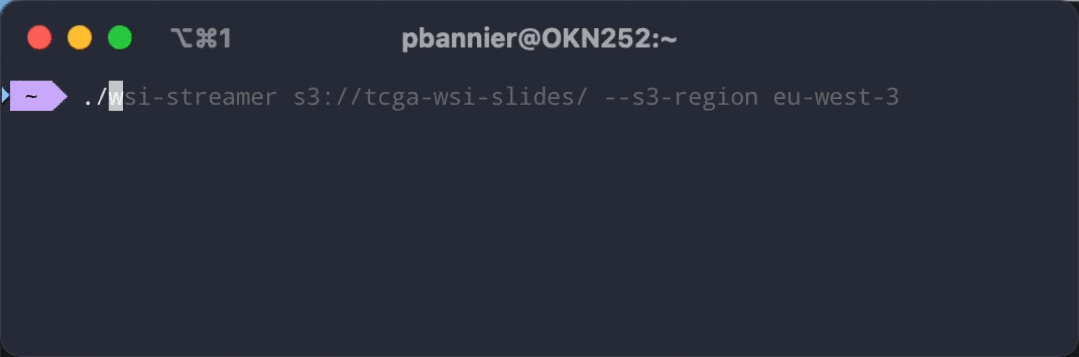

然后,启动服务并直接对接 S3:

wsi-streamer s3://my-pathology-slides --s3-region us-west-2

服务启动后,打开浏览器访问 http://localhost:3000/view/sample.svs,即可看到一个内置的 OpenSeadragon 查看器,支持平移、缩放,体验丝滑流畅。整个过程,你的本地磁盘不会新增任何文件,所有数据都按需从 S3 流式读取。

支持多种部署方式

- 本地开发:配合 MinIO(S3 兼容存储),使用

docker-compose up 一键启动完整环境。

- 生产环境:可直接运行在 Kubernetes 集群中,轻松对接 AWS S3、阿里云 OSS、腾讯云 COS 等主流对象存储。

- Docker 容器:官方提供轻量级镜像,执行

docker run -p 3000:3000 ghcr.io/pabannier/wsistreamer 即可快速体验。

内置标准 API,方便集成

除了 Web 查看器,WSIStreamer 还暴露了清晰的 REST API,便于与其他系统集成:

# 列出所有可用的切片文件

curl http://localhost:3000/slides

# 获取某张切片元数据(分辨率、层级数等)

curl http://localhost:3000/slides/tumor_001.svs

# 获取切片缩略图(自动缩放到指定尺寸内)

curl “http://localhost:3000/slides/tumor_001.svs/thumbnail?max_size=512” -o thumb.jpg

# 直接获取特定瓦片(第0层,x=10, y=5)

curl http://localhost:3000/tiles/tumor_001.svs/0/10/5.jpg -o tile.jpg

这些 API 完全兼容 Deep Zoom Image 标准,可轻松集成到任何支持 DZI 的前端框架中。

核心技术揭秘:Rust 如何实现“零本地存储”的瓦片流?

现在,让我们深入技术内核,探究 WSIStreamer 如何做到“不下载完整文件也能读取瓦片”。

1. HTTP Range 请求:精准获取所需字节

S3 及所有兼容 S3 的对象存储都支持 HTTP Range 请求。例如,要读取文件的第 1000 到 2000 字节,只需发送以下请求头:

GET /slide.svs HTTP/1.1

Host: my-bucket.s3.amazonaws.com

Range: bytes=1000-2000

S3 将返回 206 Partial Content 响应,仅包含指定范围的字节数据。这正是 WSIStreamer 架构的基石。

2. 原生解析 WSI 格式:彻底摆脱本地依赖

传统方案依赖 OpenSlide 库,但它强制要求文件位于本地。WSIStreamer 则选择了一条更彻底的道路:用 Rust 从零实现了 Aperio SVS 和金字塔式 TIFF 的解析器。

以 TIFF 格式为例:

- 文件由多个 Image File Directory 组成,每个 IFD 描述一个分辨率层级。

- 每个 IFD 包含一系列 条目,如

ImageWidth、ImageHeight、TileOffsets、TileByteCounts 等。

TileOffsets 数组指明了每个瓦片在文件中的 起始字节位置,TileByteCounts 则指明了每个瓦片的数据长度。

WSIStreamer 在启动时,会先发起一次小范围的 Range 请求(通常只需读取文件头部几 KB),解析出所有 IFD 的偏移信息,从而在内存中构建出完整的金字塔结构索引。

当用户请求某个瓦片(例如 /tiles/slide.svs/2/100/200.jpg)时,服务端会执行以下操作:

- 根据层级 2、坐标 (100,200),查询到该瓦片对应的

offset 和 size。

- 向 S3 发起一次精确的 Range 请求:

Range: bytes=offset-(offset+size-1)。

- 收到原始的压缩数据块(例如 JPEG 流)后,无需解压,直接将其作为 JPEG 图像响应返回给前端。

关键洞察:许多 WSI 格式(如 Aperio SVS)的瓦片在存储时已经是 预压缩的 JPEG 格式。因此,服务器端完全不需要进行图像解码和重编码,直接透传数据即可,这极大地提升了性能。

3. 多级缓存:在性能与成本之间寻找最佳平衡

尽管“按需读取”的理念很酷,但频繁发起大量小范围的 Range 请求也会带来额外的网络开销。为此,WSIStreamer 设计了 三级缓存策略:

- Slide Metadata Cache:缓存文件的 IFD 结构信息(通常仅几 KB),避免对同一文件头部进行重复解析。

- Block Cache:缓存从 S3 读取的原始数据块(例如每次读取 64KB)。当后续请求的瓦片数据落在已缓存的块内时,可直接复用,减少 S3 请求次数。

- Encoded Tile Cache:缓存已生成的 JPEG 瓦片响应(可配置大小,如 100MB),用于应对热点瓦片的频繁请求。

缓存策略可以根据服务器资源和应用场景灵活调整。例如,在内存充裕的服务器上可以增大瓦片缓存,以最大化性能;在边缘计算节点上则可以关闭缓存以节省内存。

安全与生产就绪性:它不只是一个玩具

很多人会质疑:这种直接代理 S3 数据的方案,安全吗?WSIStreamer 在安全方面考虑得非常周全。

HMAC-SHA256 签名 URL

通过启动参数 --auth-enabled --auth-secret "your_secret" 启用认证后,所有 API 请求都必须携带经过签名的参数。例如:

http://localhost:3000/tiles/slide.svs/0/0/0.jpg?expires=1700000000&signature=abc123...

签名算法基于 HMAC-SHA256,涵盖了请求路径、过期时间和密钥,能有效防止 URL 被恶意猜测或盗用。前端查看器会自动调用一个内部的 /sign 接口来生成临时有效的签名 URL,对终端用户完全透明。

CORS 与跨域支持

可以通过 --cors-origins 参数指定允许访问 API 的前端域名,有效防范跨站攻击。

内置的健康检查与验证工具

WSIStreamer 提供了 wsi-streamer check 命令,可以快速验证与 S3 的连接、列出存储桶中的切片、测试单个文件是否可被正确解析,这大大简化了运维和故障排查流程。

为什么选择 Rust?性能与安全的双重保障

WSIStreamer 选择 Rust 作为实现语言,是基于深刻的工程考量:

- 零成本抽象与高性能 I/O:基于

tokio 异步运行时,能够轻松处理高并发的瓦片请求,性能卓越。

- 内存安全:从根本上避免了 C/C++ 解析器中常见的缓冲区溢出、内存泄漏等安全问题(医学图像解析器历史上曾多次曝出此类漏洞)。

- 单二进制部署:编译后生成一个独立的可执行文件,没有任何外部依赖,使得 Docker 镜像可以做到极致的轻量化。

- 强大的生态系统:

aws-sdk-rust、image、serde 等库成熟稳定,为开发提供了坚实基础。

在实际测试中,WSIStreamer 在普通的 4 核 8GB 内存云服务器上,可以轻松支撑数百名并发用户同时浏览不同的病理切片,请求延迟稳定在 50 毫秒以内。

适用场景与未来展望

谁需要 WSIStreamer?

- 数字病理平台:替代笨重、难以扩展的本地部署方案,构建真正的 云原生/IaaS WSI 可视化服务。

- AI 辅助诊断:在模型训练或推理时,按需拉取特定组织区域的瓦片,极大节省带宽和临时存储成本。

- 远程会诊系统:医生通过浏览器即可实时查看并讨论高清病理切片,无需安装任何专用客户端软件。

- 科研数据共享:将公开的病理数据集存放在对象存储上,使用 WSIStreamer 即可为其提供一个开箱即用的可视化入口。

未来的扩展方向

目前 WSIStreamer 主要支持 SVS 和金字塔式 TIFF 格式,社区未来可以对其进行扩展:

- 支持更多格式:如 Hamamatsu NDPI、3DHistech MRXS、Leica SCN 等(需要社区贡献相应的解析器实现)。

- GPU 加速:对 JPEG2000 等计算密集型压缩格式,引入硬件解码支持以进一步提升性能。

- 动态瓦片生成:支持非标准瓦片尺寸或自定义缩放级别。

- 与 DICOM 标准集成:将 WSI 流式服务更好地融入医疗影像的标准生态体系中。

结语:小工具,大价值

WSIStreamer 看起来只是一个功能聚焦的工具,但其背后 利用现代云存储特性,以最小工程复杂度解决核心痛点 的设计理念,极具启发性。

它揭示了一个朴素却深刻的道理:很多时候,我们并非缺乏技术,而是缺少一个“重新审视问题”的视角。当其他人仍在纠结如何更快地下载一个 3GB 的文件时,WSIStreamer 直接提出了根本性质疑:为什么我们一定要先下载它?

这种对问题本质的洞察和基于云原生架构的优雅实践,正是优秀开源项目的魅力所在,也值得每一位开发者借鉴。如果你对构建高性能、可扩展的存储服务感兴趣,不妨到 云栈社区 的相关板块与同行深入交流。

项目地址:https://github.com/PABannier/WSIStreamer