你是否想过,支撑起每天数十亿次访问的网站背后,那个默默无闻的流量调度员是如何工作的?作为现代Web架构的基石,Nginx的性能直接决定了整个系统的并发处理能力。今天,我们就来深入探讨如何通过四个关键维度的配置优化,让你的Nginx服务器从容应对从1K到10万乃至更高并发的挑战。

一、worker_processes:决定并发上限的天花板

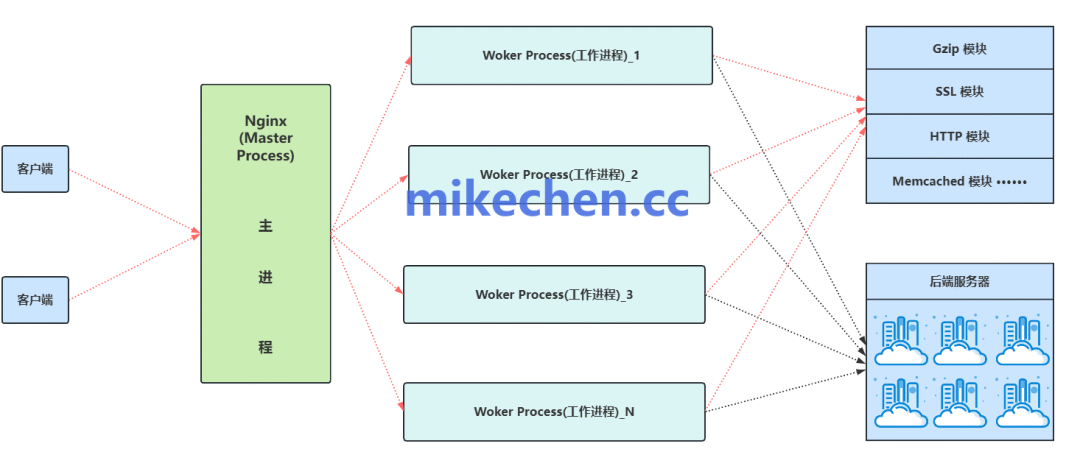

Nginx采用经典的多进程事件驱动模型,而worker_processes指令直接决定了有多少个“工人”可以同时处理请求。这个值设得太低,CPU无法被充分利用;设得太高,又会因过多的进程上下文切换而拖累性能。那么,如何设定才是最优解?

worker_processes auto; # 推荐写法,自动设置为CPU核数

# 或者明确指定:worker_processes 8; # 假设服务器有8核

核心原则是与CPU核数对齐,以最大化并行处理能力。但在实际生产环境中,还需要考虑负载类型:对于I/O密集型场景(如大量静态文件代理),可以适当增加进程数以覆盖I/O阻塞时间;对于CPU密集型场景(如复杂压缩、加密),则应保持与核心数一致甚至略少。

二、worker_connections与事件模型:单进程能扛住多少连接

确定了“工人”数量,接下来要解决每个“工人”最多能同时处理多少任务。这由events块中的worker_connections指令控制。结合高效的epoll(Linux)或kqueue(BSD)等多路复用I/O模型,单个Nginx工作进程能够以极低的开销管理数以万计的连接。

events {

worker_connections 65535; # 单个worker进程允许的最大连接数

multi_accept on; # 一次性接受多个新连接,提升效率

use epoll; # Linux下性能最佳的事件驱动模型

# use kqueue; # 在FreeBSD或macOS上使用

}

这里有一个关键公式:最大并发连接数 ≈ worker_processes × worker_connections。但请注意,这个数值最终受限于操作系统的文件描述符(File Descriptor)限制。因此,仅调高Nginx配置是不够的,必须同步调整系统资源限制。

三、突破瓶颈:系统资源与内核参数调优

Nginx再强大,也必须运行在操作系统之上。要支撑10万级别的并发,对内核参数的调整是必不可少的。以下关键配置通常需要写入/etc/sysctl.conf并执行sysctl -p生效。

# 增大系统全局文件描述符上限

fs.file-max = 2097152

# 增大TCP连接队列长度,应对瞬间高并发

net.core.somaxconn = 65535

net.ipv4.tcp_max_syn_backlog = 8192

# 优化TCP连接回收,缓解TIME_WAIT状态过多的问题

net.ipv4.tcp_tw_reuse = 1

net.ipv4.tcp_fin_timeout = 15

# 扩大本地可用端口范围,这对Nginx作为反向代理时尤为重要

net.ipv4.ip_local_port_range = 1024 65535

# 禁用TCP空闲后的慢启动,保持长连接性能

net.ipv4.tcp_slow_start_after_idle = 0

除了内核参数,还需修改/etc/security/limits.conf,提升Nginx进程用户的nofile(可打开文件数)限制,确保其值大于worker_connections。

四、性能加速器:内存与网络I/O优化

在处理海量静态资源或进行大流量代理时,数据在内存与网络间的拷贝次数直接影响吞吐量。Nginx提供了两项关键优化指令:

# 开启零拷贝技术,数据直接在内核缓冲区发送,跳过用户空间

sendfile on;

# 与sendfile搭配,优化网络数据包的发送方式,提高填充率

tcp_nopush on;

开启sendfile可以避免数据在用户态和内核态之间的多次拷贝,对于传输大文件尤其有效。而tcp_nopush则在sendfile开启时,帮助Nginx在发送最后一个数据包时再填充缓冲区,减少网络报文数量,从而提升网络效率。

总结

实现Nginx的高并发能力,是一个从应用配置到系统调优的立体化工程。它始于合理的worker_processes与worker_connections配置,依赖于高效的事件驱动模型,最终必须得到底层操作系统内核参数和资源限制的有力支撑。每一次性能飞跃,都离不开对TCP/IP网络栈和I/O模型的深刻理解与实践。

希望这份实战指南能帮助你更好地驾驭Nginx。如果你在架构设计或性能优化中遇到了其他挑战,欢迎到 云栈社区 与更多开发者交流探讨,共同解决高并发场景下的技术难题。