在开始探讨实现细节之前,我们先明确一个关键概念:设备指纹(Device Fingerprint)的核心目的,并非为了识别“张三”这个人,而是为了给访问者的设备生成一个唯一的、可追踪的标识符,例如“编号9527”。

其背后的逻辑非常直接:利用浏览器暴露的各种底层硬件信息及其处理差异(如显卡、声卡、屏幕、电池),组合计算出一个熵值极高、近乎唯一的ID。 这意味着,即使用户清空了Cookie或更换了网络IP,只要其硬件设备不变,通过这套方法计算出的哈希值就会保持恒定。

下面,我们将深入剖析并代码实现当前最主流的三种前端设备指纹生成技术。

Canvas 指纹:利用图形渲染差异

这是目前应用最广泛、识别率也相当高的技术。

实现原理

Canvas绘图过程并非完全由浏览器引擎控制,它深度依赖底层的GPU绘图指令、操作系统图形驱动以及抗锯齿算法。

当你命令浏览器在Canvas上绘制一个红色矩形并写入“Hello, world!”时,不同设备会产生微妙的差异:

- 显卡差异:NVIDIA和AMD的显卡在处理边缘像素混合(抗锯齿)时,其底层数学算法存在细微不同。

- 字体渲染差异:Windows和macOS系统在字体渲染(如亚像素渲染)上,对笔画粗细的处理方式也不同。

- 结果:同一段Canvas绘图代码,在不同设备上最终生成的图像像素数据是完全不同的。 我们正是捕捉这种差异来生成指纹。

核心代码实现

关键在于设计能够触发这些差异的绘图操作,通常包括叠加光影效果、使用特殊字体或emoji(探测字体库支持)。

function getCanvasFingerprint() {

// 1. 创建一个不会挂载到DOM的隐藏画布

const canvas = document.createElement('canvas');

const ctx = canvas.getContext('2d');

canvas.width = 200;

canvas.height = 50;

// 2. 利用字体渲染差异:设置文字基线为top,这会触发不同的垂直对齐算法

ctx.textBaseline = "top";

ctx.font = "14px 'Arial'";

ctx.fillStyle = "#f60";

ctx.fillRect(125, 1, 62, 20); // 绘制一个背景色块

// 3. 叠加混合:触发GPU的颜色混合与抗锯齿算法

ctx.fillStyle = "#069";

// 写入带emoji的文字,测试系统字体支持度

ctx.fillText("Hello, world! \ud83d\ude03", 2, 15);

// 再次叠加绘制,利用rgba透明度进一步触发抗锯齿差异

ctx.fillStyle = "rgba(102, 204, 0, 0.7)";

ctx.fillText("Hello, world! \ud83d\ude03", 4, 17);

// 4. 导出指纹:将画布图像转换为Base64字符串

// 注意:相同的视觉图像,不同显卡生成的Base64字符串的CRC校验码是不同的

const b64 = canvas.toDataURL().replace("data:image/png;base64,", "");

// 5. 将超长的Base64字符串哈希化(此处为简化示例,生产环境建议使用MurmurHash3等)

let bin = atob(b64);

let crc = bin2hex(bin.slice(-16, -12)); // 取部分字节作为校验码

return crc;

}

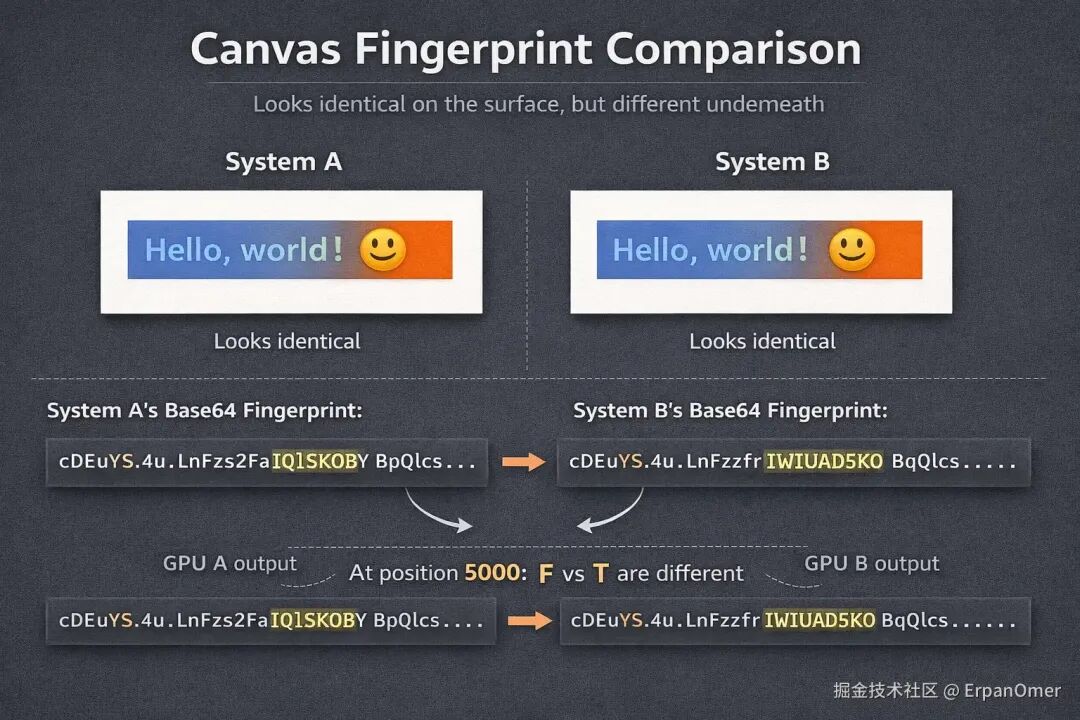

肉眼看上去,两台设备生成的图像可能完全一致。但如果你对比它们生成的Base64字符串,可能会发现在第5000个字符的位置,有一个字母(F vs T)不同——这就是底层图形硬件留下的独特“签名”。

AudioContext 指纹:捕捉声卡处理差异

既然显卡有独特之处,声卡(音频处理栈)也不例外。与Web Audio API相关的音频指纹技术,为我们提供了另一种维度的识别手段。

原理

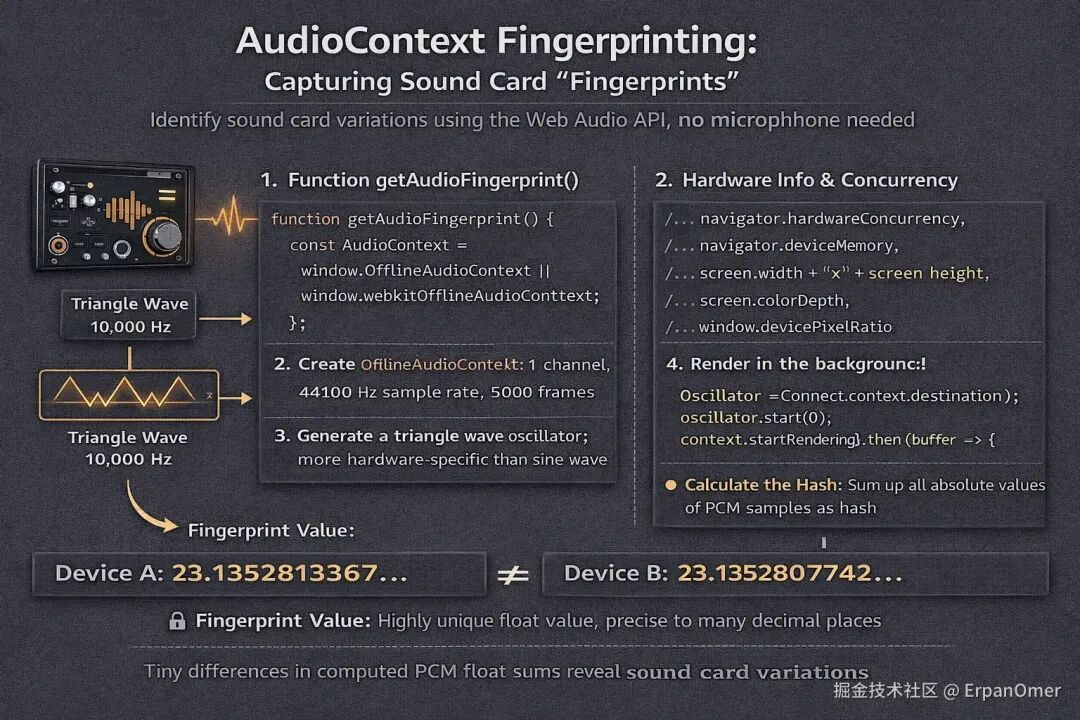

音频指纹无需录音,也不需要麦克风权限。它的原理是利用 Web Audio API 在后台生成一段特定的数字音频信号(如正弦波、三角波),并经过压缩、滤波等处理。

由于不同设备在浮点数运算精度和底层数字信号处理单元实现上的微小差异,最终计算出的PCM音频数据流会有极其细微的差别,这些差别足以构成设备的音频指纹。

代码实现

我们使用 OfflineAudioContext(离线音频上下文),它可以在后台静默渲染音频,用户听不到任何声音,且处理速度非常快。

function getAudioFingerprint() {

// 兼容性处理

const AudioContext = window.OfflineAudioContext || window.webkitOfflineAudioContext;

if (!AudioContext) return null;

// 1. 创建离线音频上下文:1个声道,44100Hz采样率,5000个采样帧

const context = new AudioContext(1, 5000, 44100);

// 2. 创建振荡器 (Oscillator)

// 使用三角波(triangle)比正弦波更容易暴露硬件处理的非线性差异

const oscillator = context.createOscillator();

oscillator.type = 'triangle';

oscillator.frequency.value = 10000; // 10000 Hz

// 3. 创建动态压缩器 (Compressor) - 这是产生差异的关键步骤

// 不同浏览器/硬件对压缩器算法的实现差异较大

const compressor = context.createDynamicsCompressor();

compressor.threshold.value = -50;

compressor.knee.value = 40;

compressor.ratio.value = 12;

compressor.reduction.value = -20;

// 4. 连接音频节点:振荡器 -> 压缩器 -> 输出目标

oscillator.connect(compressor);

compressor.connect(context.destination);

// 5. 开始渲染音频

oscillator.start(0);

return context.startRendering().then(buffer => {

// 6. 获取渲染后的PCM数据(一个Float32Array数组)

const data = buffer.getChannelData(0);

// 7. 计算哈希值(指纹)

let sum = 0;

// 简单累加所有采样点的绝对值作为指纹值

for (let i = 0; i < data.length; i++) {

sum += Math.abs(data[i]);

}

console.log("Audio Fingerprint:", sum);

return sum; // 返回这个高精度的浮点数

});

}

在不同设备上运行这段JavaScript代码,得到的 sum 值会精确到小数点后十几位,那微小的尾数差异就是该设备声卡的“指纹”。

电池状态与硬件并发信息

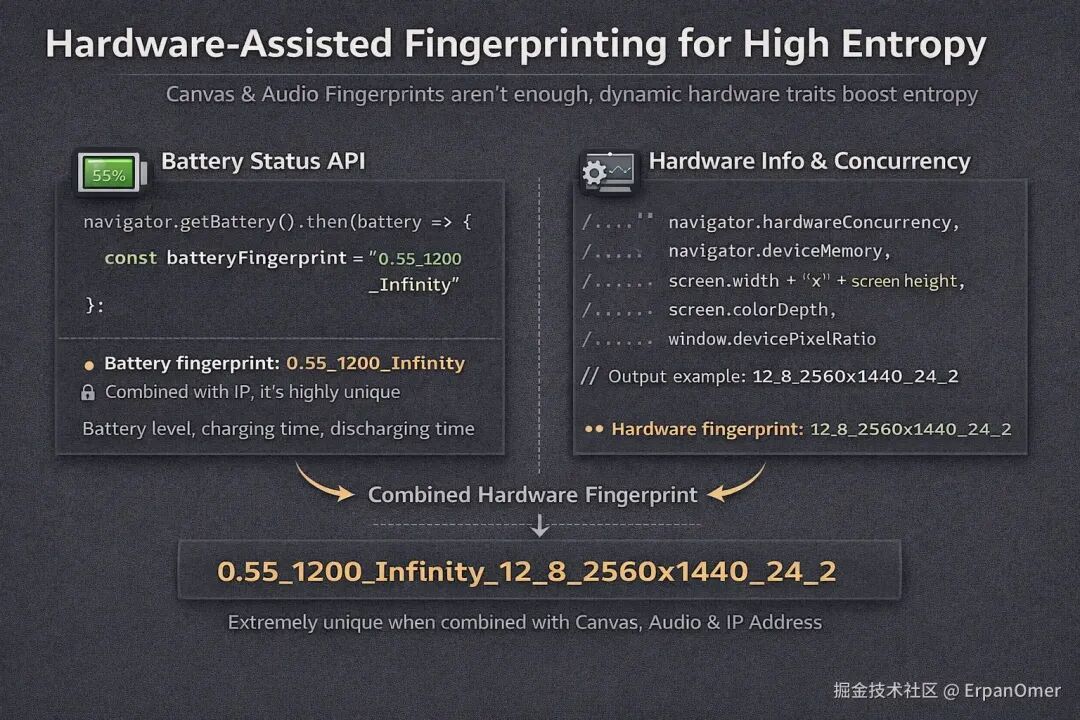

仅靠Canvas和Audio指纹有时还不够(例如,同一型号的iPhone可能产生相同的值)。为了进一步提高熵值和唯一性,我们需要引入动态的硬件特征。

电池状态 API

注:由于隐私争议,Firefox和Safari已禁用此API,但在Chrome(部分版本)和Android WebView中仍可能获取。

这个API的逻辑非常直接:电量百分比、充满/放空所需时间这个组合在任何一个特定的时间点,都具有很高的唯一性。

// 核心代码

navigator.getBattery().then(battery => {

const level = battery.level; // 例如 0.55 (55%)

const chargingTime = battery.chargingTime; // 例如 1200 (秒)

const dischargingTime = battery.dischargingTime; // 例如 Infinity

// 生成电池指纹因子,如:"0.55_1200_Infinity"

// 若再结合用户IP地址,其锁定能力将非常强

const batteryFingerprint = `${level}_${chargingTime}_${dischargingTime}`;

});

更有趣的是,如果你在短时间内连续获取两次电量,发现其从 0.42 变成了 0.41,这个电量变化曲线本身也可以成为一种强有力的行为指纹。

硬件并发数与内存信息

Navigator 和 Screen 对象直接暴露了一批硬件参数,我们可以轻松获取:

const hardwareInfo = [

navigator.hardwareConcurrency, // CPU逻辑核心数,例如 12

navigator.deviceMemory, // 设备内存大小 (GB),例如 8

screen.width + 'x' + screen.height, // 屏幕分辨率,例如 2560x1440

screen.colorDepth, // 屏幕色彩深度,例如 24

window.devicePixelRatio // 设备像素比,例如 2

].join('_');

// 输出示例:"12_8_2560x1440_24_2"

虽然这些参数单独看非常普通,但如果你将 CPU核心数 + 内存大小 + 屏幕分辨率 + Canvas指纹 + Audio指纹 拼接成一个组合字符串,那么在全球数十亿设备中,产生碰撞(即两台不同设备生成完全相同的ID)的概率几乎为零。

总结

所谓的前端指纹技术,本质上是一种“找不同”的策略。开发者通过调用各种浏览器API(Canvas, Audio, WebGL, 硬件信息API等),迫使浏览器执行特定的复杂运算。由于底层硬件、驱动程序和系统实现的细微差别,这些运算结果必然会产生差异。

收集这些差异并进行哈希计算,最终生成的那个字符串,就是你的浏览器在当前互联网环境下的一个高概率唯一ID。理解其原理,不仅有助于我们在需要时实现它,更能让我们意识到前端安全与隐私保护的边界。对于更深入的安全技术探讨,可以参考云栈社区的相关板块。