一场押注AI未来的技术豪赌。

北京时间1月29日,北京智源人工智能研究院推出的多模态大模型“悟界·Emu”的核心成果“Emu3”登上《Nature》正刊。这不仅是继DeepSeek之后第二个达成此成就的中国大模型团队研究成果,更是中国首篇围绕多模态大模型核心路线登上《Nature》的论文。

Nature官网论文页面截图

《Nature》编辑点评道:“Emu3仅基于‘预测下一个token’实现了大规模文本、图像和视频的统一学习,其在生成与感知任务上的性能可与使用专门路线相当,这一成果对构建可扩展、统一的多模态智能系统具有重要意义,有望推动原生多模态助手、世界模型以及具身智能等方向的发展。”

Emu3展现的具身操作等能力,有望推动相关领域发展

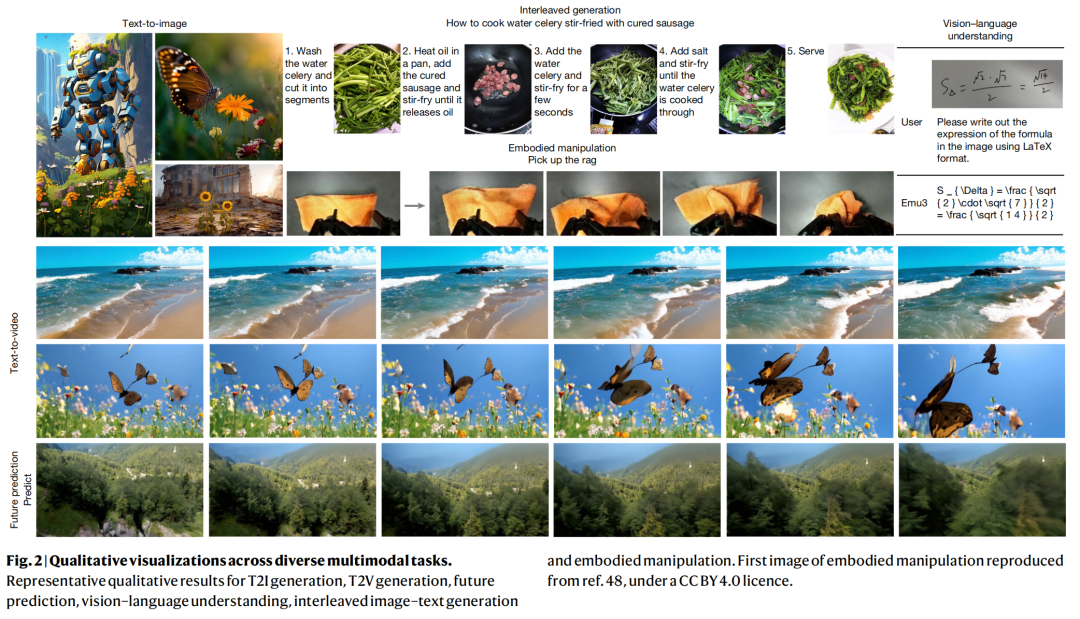

“悟界·Emu3”模型由智源研究院于2024年10月推出。该模型能够完成文本到图像生成、文本到视频生成、未来预测、视觉语言理解、交错图像文本生成以及具身操作等多方面任务。无论在感知还是生成方面,Emu3均达到了与特定任务旗舰模型相媲美的性能,对于确立自回归成为生成式AI统一路线具有里程碑意义。

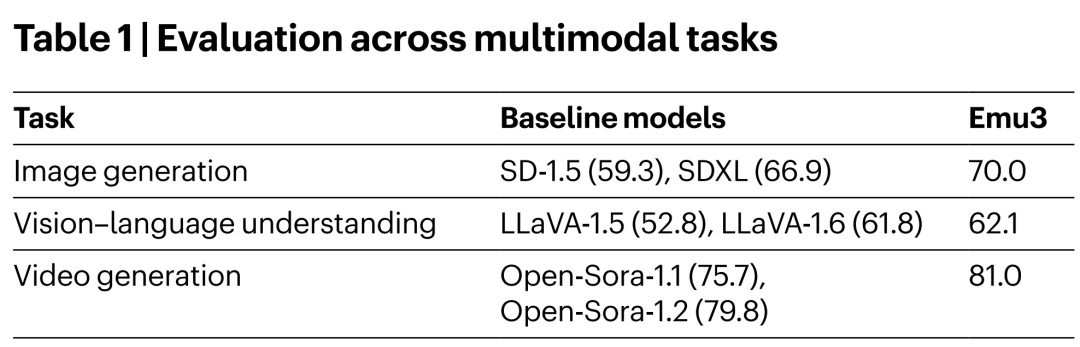

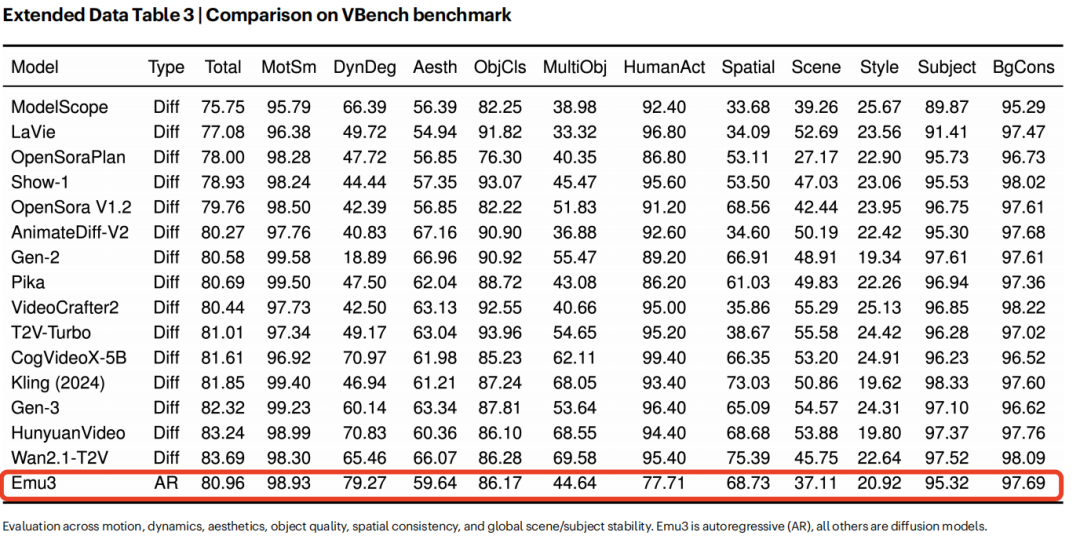

如下表所示,Emu3的图像生成在多项基准上表现优于SDXL等扩散模型;视频生成在VBench评分达81,超过Open-Sora 1.2;视觉语言理解得分62.1,略高于LLaVA-1.6。尽管这一成绩在今天看来已不鲜见,但在其研发的两年前却是一次对技术路线的重大验证。

表1 | Emu3在图像生成、视觉-语言理解和视频生成任务上的主要测评结果

前OpenAI政策主管、现Anthropic联合创始人杰克·克拉克(Jack Clark)曾评价Emu3:“不依赖花哨的架构技巧,仅用最基础的预测下一个token的逻辑,这种‘简单’被视为具备强大的扩展潜力。”

而正是这种“简单”的架构路线,对降低大模型研发门槛和成本意义重大。“越是极简的架构,可能越具备强大的生产力,对产业的价值也越大。”智源研究院院长王仲远指出,“因为它简化了多模态AI架构,减少了研发过程中的复杂性和潜在错误,从而使模型的构建和维护更高效。”

智源研究院院长王仲远

到2025年10月,“悟界·Emu”系列已迭代出多模态世界模型。Emu3.5可以理解长时序、空间一致的序列,模拟在虚拟世界中的探索和操作,不仅超越谷歌Nano Banana等模型拿下多模态SOTA,并首次指明了“多模态Scaling 范式”,让模型自发学习世界演变的内在规律,为具身智能等物理AI领域发展提供了重要新路径。

Emu3.5延续了多模态数据统一建模的核心思想

Emu3为什么能够登上《Nature》正刊?它背后诞生了什么样的原创技术?这又将对学界和产业界产生什么影响?

01. 五十人小组死磕“统一”:一场押注AI未来的技术豪赌

Emu3模型最早立项是在2024年2月,当时正值团队重新审视大模型发展路径——随着GPT-4、Sora的爆火,“预测下一个token”自回归路线彻底改变了语言模型领域,而在多模态生成领域,DiT(Diffusion Transformer)架构成为主流。

自回归技术路线是否可以作为通用路线统一多模态?一直是未解之谜。 Emu3的开创性,就在于仅采用“预测下一个token(NTP)”自回归路线,就实现统一多模态学习,训练出性能出色的原生多模态大模型。

立项前,智源团队达成一个共识——多模态是未来实现AGI的关键路径,但现有的多模态生成长期以来由扩散模型主导,而视觉语言感知则主要由组合式方法引领,并不收敛统一,存在技术天花板。

尽管已有业内人士试图统一生成与感知,但这些工作要么简单地将大语言模型与扩散模型拼接,要么在性能效果上不及那些针对生成或感知任务精心设计的专用方法。

自回归架构能否作为原生统一多模态的技术路线?这是一个重大的技术决策。最终在2024年2月底,智源研究院决定,组建一支五十人的技术攻关团队,以自回归架构为核心进行研发,并采用离散的token方式,以精简架构和大规模复用的大语言模型基础设施,开启全新的多模态模型Emu3的研发工作。

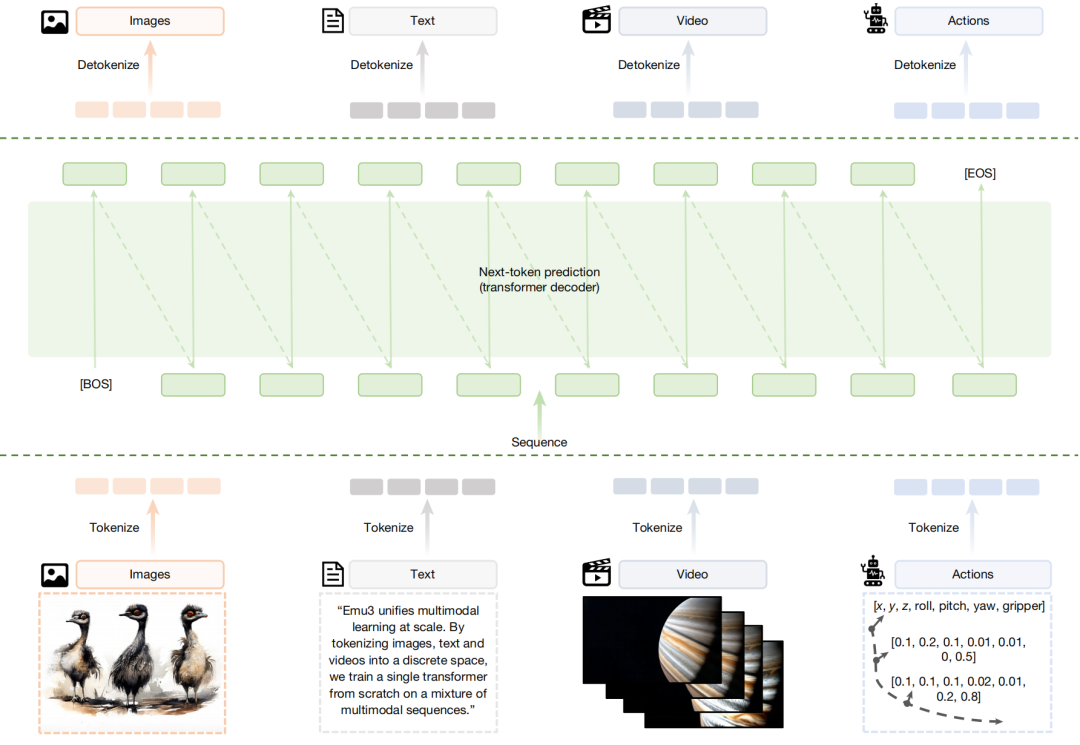

该模型开创性地将图像、文本和视频统一离散化到同一个表示空间中,并从零开始,在多模态序列混合数据上联合训练一个单一的 Transformer。

图2 | Emu3在不同多模态任务上的定性可视化结果

这是一条挑战传统的“冒险”之路,在成功之前,团队经历了重重挑战。

首先不言而喻的是技术上的挑战。 选择“离散的token”方式本身是一种冒险,因为它尝试为视觉和其他模态重新发明一种与人类文字语言对齐的“语言体系”。在图像压缩过程中,由于图像信息相较于文字的信息量更大,冗余更多,这使得基于token压缩图像时难以训练出有效模型,过程中难免受挫。

第二,更深层次的是路径上的质疑。 2024年国内各大模型团队都在如火如荼地复现GPT-4,很多团队在多模态模型的布局上存在摇摆,最终因资源消耗大、主线仍聚焦于语言模型等原因而砍掉了相关项目。智源研究院在这样的产业大背景下坚持了下来,背后需要强大的信念和定力。

第三,“多模态能否提升模型的智能”这个问题,当时还未成定论。 但智源团队坚信,下一代模型如果要进入到物理世界,仅靠文字是不够的,需要一个“见过世界”的模型。他们相信,不管突破多模态模型乃至世界模型智能升级有多难,它都是实现AGI的一条必经之路。

02. 性能匹敌专用模型:两年,Emu3已深度影响产业发展脉络

Emu3模型发布两年多以来,已经对多模态领域产生了显著影响。而进入产业应用的前提,是Emu3首先打赢了“性能”这一仗。在多模态生成与感知任务上,Emu3的整体表现可与多种成熟的任务专用模型相媲美。

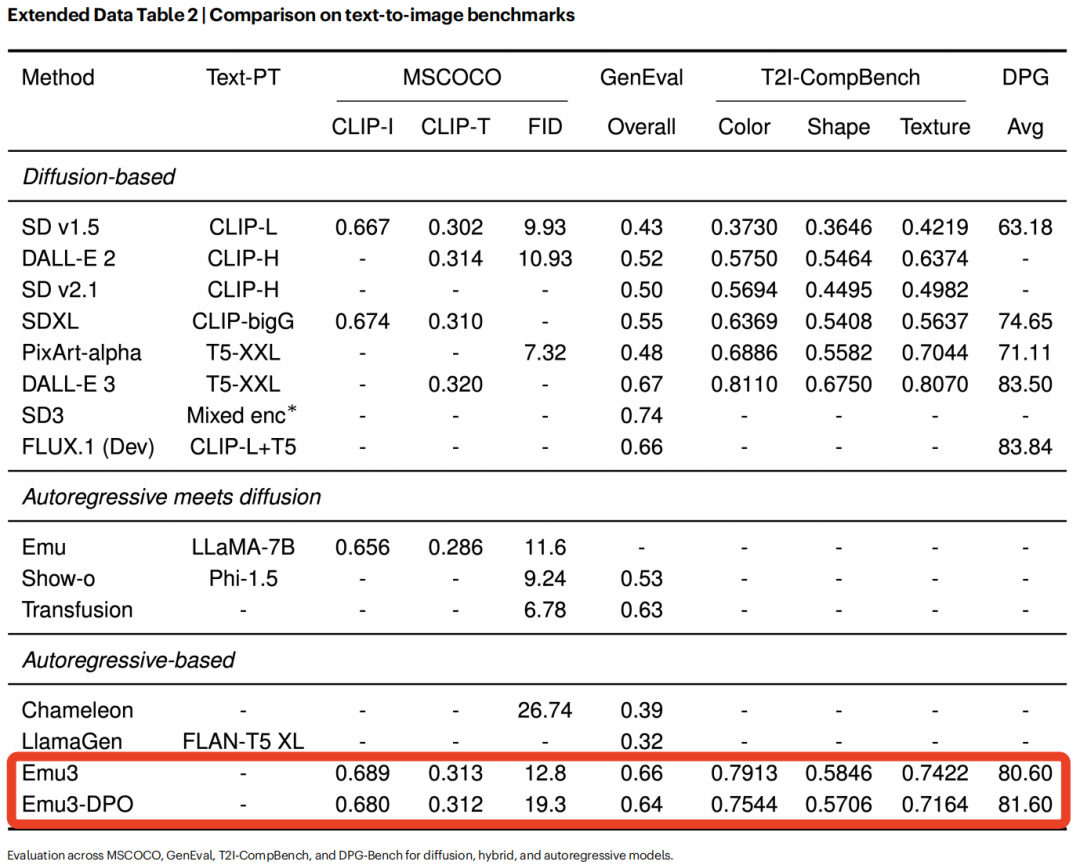

首先聚焦文本到图像生成能力,在MSCOCO-30K、GenEval、T2I-CompBench等多个基准上,Emu3的性能与当时最先进的扩散模型相当:超越了SD1.5、SDXL等模型,并接近DALL-E 3、FLUX.1(Dev) 等模型。

扩展数据表2 | Emu3在文生图基准测试中与先进扩散模型的对比

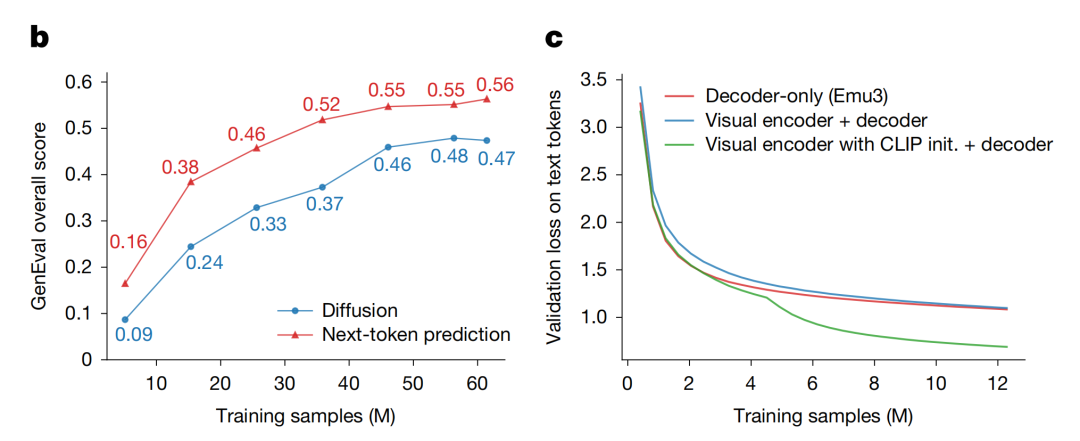

如下图所示,在文生图任务中,其效果达到扩散模型水平;在视觉语言理解方面,其可以与融合CLIP和大语言模型的主流方案比肩。

图b, c | Emu3在文生图和视觉语言理解任务上的训练效果对比

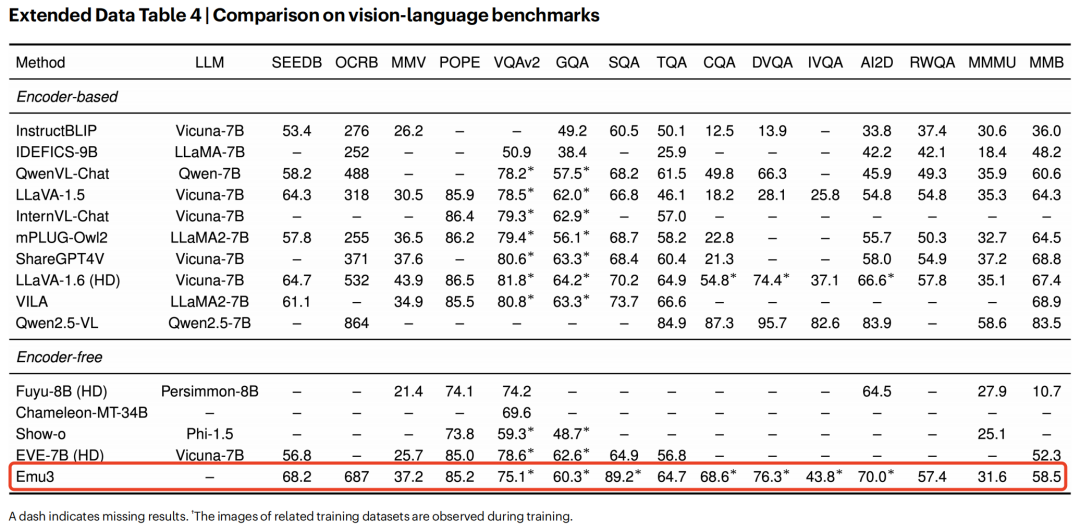

在视觉语言理解方面,Emu3作为一种纯粹的无编码器方法,在多个基准测试中达到了与其同类方法相当的性能。取得这样的视觉-语言理解能力,Emu3并未依赖专门的预训练大语言模型和CLIP。

扩展数据表4 | Emu3在视觉-语言理解多项基准上的测评成绩

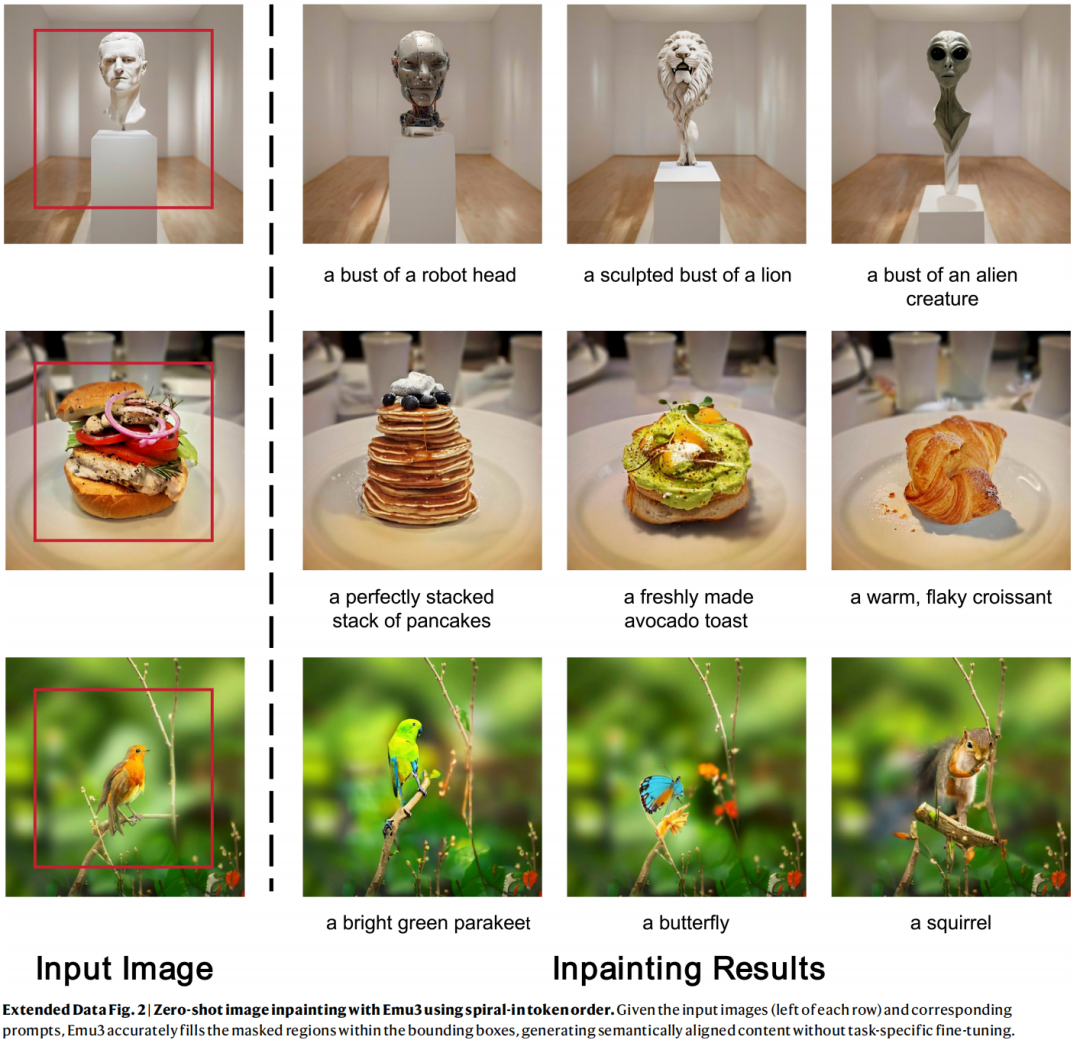

在零样本图像修复案例中,给定输入图像和相应提示,Emu3能准确填充边界框内的掩码区域,生成语义对齐的内容,且无需特定任务的微调。

扩展数据图2 | Emu3的零样本图像修复效果

同时,Emu3还具备视频生成能力。Emu3原生支持生成24帧/秒的5秒视频,并可通过自回归方法进行扩展。在VBench基准测试中,Emu3所产生的结果与其他视频扩散模型相比具有很强的竞争力:其性能超过Open Sora V1.2、Kling(2024)、Gen-3等当年的知名专用模型。

扩展数据表3 | Emu3与其他视频扩散模型在VBench上的对比

Emu3可以通过预测未来帧来扩展视频。以视频扩展的定性为例,将2秒、24帧/秒的视频token化为离散视觉token作为上下文。Emu3以同样的离散视觉token形式预测后续2秒的内容,这些token可以被解token化以生成预测的未来视频。

不同于Sora等以噪声为起点的扩散式视频生成模型,Emu3通过自回归方式逐token预测视频序列,实现基于因果的视频生成与延展,展现出对物理世界中环境、人类与动物行为的初步模拟能力。

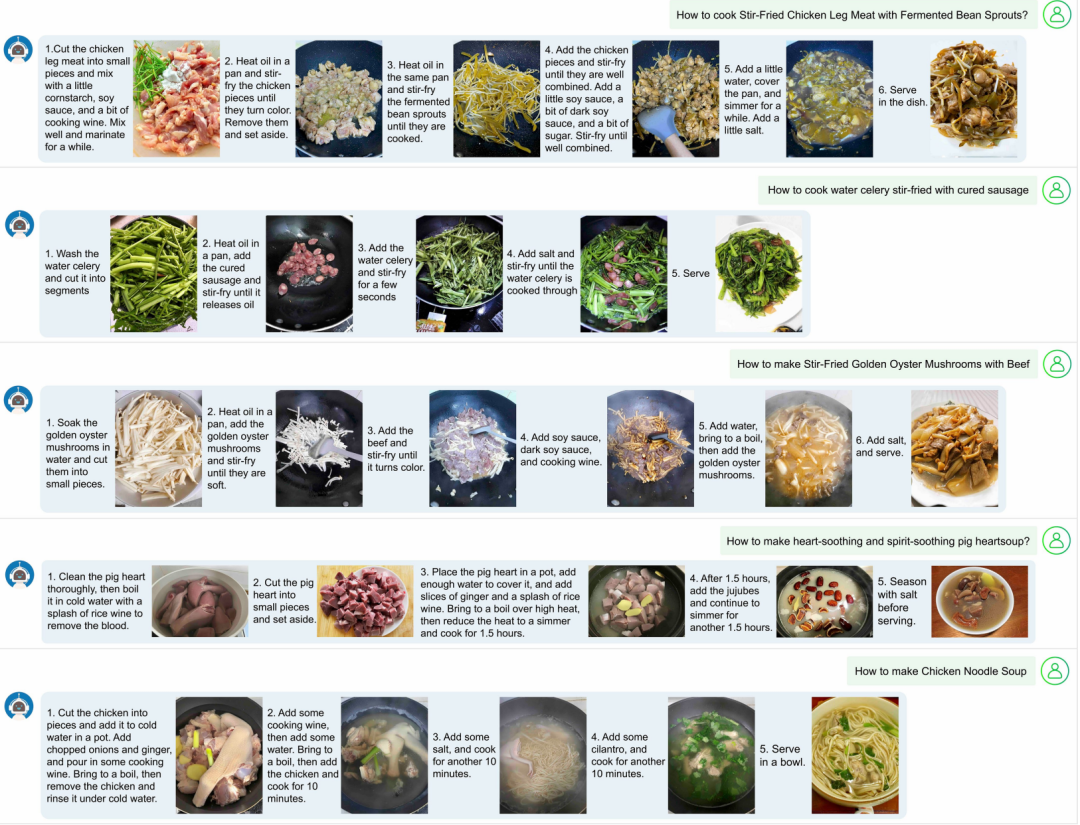

Emu3还可拓展至视觉语言交错生成,例如图文并茂的菜谱生成。

交错图文生成结果的可视化

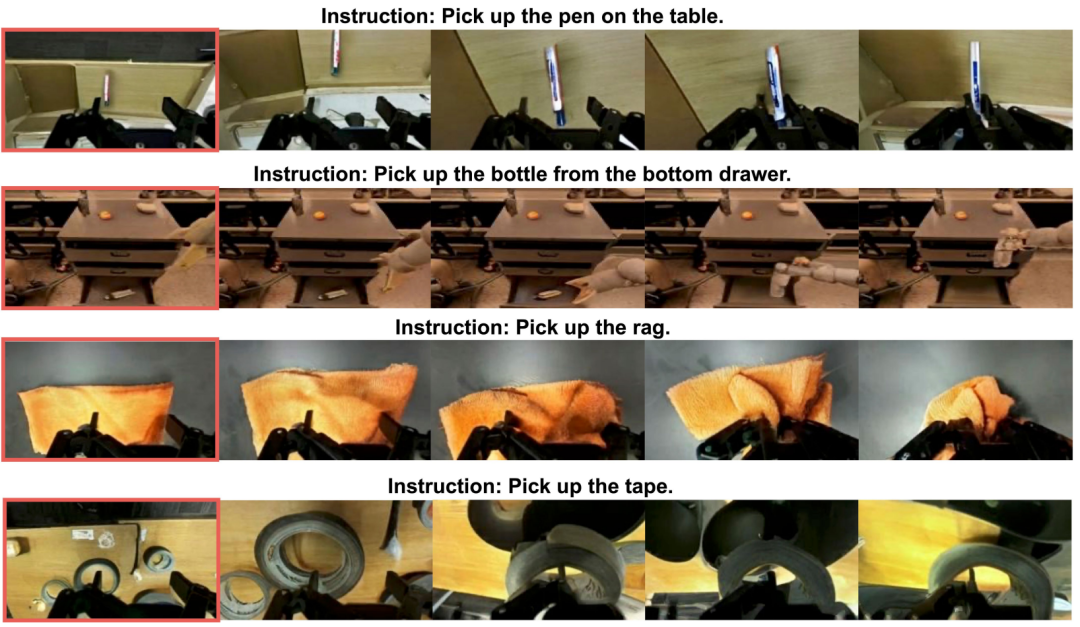

其也可拓展至视觉语言动作建模,如机器人操作VLA等,进一步体现了“预测下一个token”的通用性。

在Droid数据集上视觉预测的可视化

事实上,在《Nature》论文之外,智源研究院于2025年10月30日发布了Emu3的后续版本Emu3.5,其在多种多模态任务上继续展现出令人惊艳的效果以及SOTA的结果,对比Emu3有了全方位、大幅度的性能提升,开启多模态世界大模型新纪元。

“悟界·Emu”系列在架构理念和实际效果上都达到了产品级,这不仅使其在学术界获得了《自然》期刊的高度认可,更在业界引起了广泛关注。Emu3及后续版本的成果具有重大产业应用前景,可能改写整个多模态大模型格局。

03. 扩散模型已死?技术角度揭秘Emu3框架

Emu3及后续版本的发布,一度在开发者社区引起讨论和关注,甚至产生了“扩散模型已死”的说法。

对此,王仲远坦言,目前对于扩散模型的研究趋势尚不能定论。虽然有一些成果如Emu3.5提供了世界模型的可行路径,但并非唯一路径。 未来可能会有更多技术路径实现“预测下一个状态”,且扩散模型也在与其他技术结合改进。因此,不能断言扩散模型会消失,而是需要持续观察和学习交流。

尽管不能断言自回归路线已经一统天下,但Emu3已经为产业提供了一条新的康庄大道。

回到Emu3模型架构来看,其保留了Llama-2等成熟大语言模型的架构框架,主要修改在于扩展了嵌入层以容纳离散的视觉标记。这是一个统一的、仅含解码器的框架,该框架将语言、图像和视频建模为单一的离散标记序列,并通过下一个标记预测目标进行端到端训练。

下图展示了该框架,其方法包含五个紧密集成的组件:

- 一个大型的混合多模态训练数据集。

- 一个统一的标记器,可将图像和视频片段转换为紧凑的离散标记流(视觉分词器)。

- 一个基于Transformer的仅解码器架构,该架构扩展了大型语言模型的嵌入空间以接受视觉标记,其他方面则遵循标准的仅解码器设计选择。

- 一个两阶段优化方案,包括采用平衡交叉熵损失的大规模多模态预训练,以及与任务格式和人类偏好对齐的高质量后训练。

- 一个高效的推理后端,支持无分类器引导(CFG)、低延迟和高吞吐量,用于自回归多模态生成。

Emu3统一多模态学习的架构图

这一架构证明,仅凭“预测下一个token”,我们就能够同时支持高水平的生成能力与理解能力,并且在同一统一架构下,自然地扩展到机器人操作以及多模态交错等生成任务。智源研究团队对相关研究的多项关键技术与模型进行了开源,以推动该方向的持续研究。

同时,研究通过大规模消融实验系统分析了多项关键技术的设计选择,验证了多模态学习的规模定律、统一离散化的高效性、以及解码器架构的有效性。研究还验证了自回归路线高度通用性:直接偏好优化(DPO)方法可无缝应用于自回归视觉生成任务,使模型能够更好地对齐人类偏好。

在此研究基础上,悟界·Emu3.5进一步通过大规模长时序视频训练,学习时空与因果关系,展现出随模型与数据规模增长而提升的物理世界建模能力,并观察到多模态能力随规模扩展而涌现的趋势,实现了“预测下一个状态”的范式升级。

04. 坚持原始创新:北京智源引领大模型技术演进

自2018年创立之后,智源研究院通过多项成果深刻影响了中国AI学术和产业界。其在2021年发布了中国首个大语言模型“悟道1.0”,及当时全球最大的大语言模型(采用MoE架构)“悟道2.0”,同时因输送大量顶尖AI产业人才被称为“大模型的黄埔军校”。

智源2022年开辟的新的模型系列——悟界·Emu研究成果的发表,不仅是国际学术界对智源研究团队工作的认可,更是对中国AI原创技术路线的重要肯定。

Emu系列模型自2022年启动研发以来,围绕“原生多模态”这一核心技术主线持续迭代:

- 2022年6月,系统布局多模态大模型的研发。

- 2023年7月,发布并开源首个版本,成为最早打通多模态输入到多模态输出的统一多模态模型。

- 2023年12月,发布Emu2,通过大规模自回归生成式多模态预训练,展现出可泛化的多模态上下文学习能力。

- 2024年10月,发布Emu3,该模型只基于预测下一个token,即可完成文本、图像、视频三种模态数据的理解和生成。

- 2025年10月,推出原生多模态世界模型Emu3.5,实现从“预测下一个token”到“预测下一个状态”的能力跃迁。

自2020年启动“悟道”大模型研究以来,智源持续聚焦大模型的原始创新与长期技术路径探索。2025年6月,智源发布新一代大模型系列“悟界”,旨在构建人工智能从数字世界迈向物理世界的关键能力。

王仲远表示,开源开放是智源研究院从成立之初起就始终坚持的理念,未来智源将持续在大模型技术及产业发展中起到表率作用,不仅开放模型权重,还将开放数据训练代码和产业应用案例,促进开源生态和产业链共同发展。

结语:扎根AI基础研究,中国原始创新的胜利

Emu3登上《Nature》,这是一次中国AI原始创新的胜利。一方面,高密度的人才队伍、充足的算力资源、机构的坚定技术信仰都为其提供了动力和保障;另一方面,或许也只有智源这样产学两栖的机构才有可能完成这样的工作——相比于高校拥有更多算力、工程团队和产业化运作的优势;相比于企业,他们可以更专注于前瞻性、突破性的基础科研项目。

智源研究院的持续突破,也是北京作为“大模型第一城”在基础研究领域扎实投入的缩影。自2023年起,北京明确将AI作为“新质生产力”的核心引擎,并积极推动优势单位开源系列大模型、基础数据集,持续建设开源项目孵化平台。

随着全球大模型竞争步入深水区,对底层技术路线和基础模型的原始创新,其价值将日益凸显。Emu3的成功不仅为统一多模态学习提供了可行路径,也为通往更具通用性的世界模型和具身智能,点亮了一盏关键的技术明灯。对于关注前沿技术趋势的开发者与研究者而言,深入了解此类开源项目背后的设计思想与实现细节,无疑将大有裨益。你如何看待自回归路线统一多模态的未来?欢迎在技术社区交流你的见解。