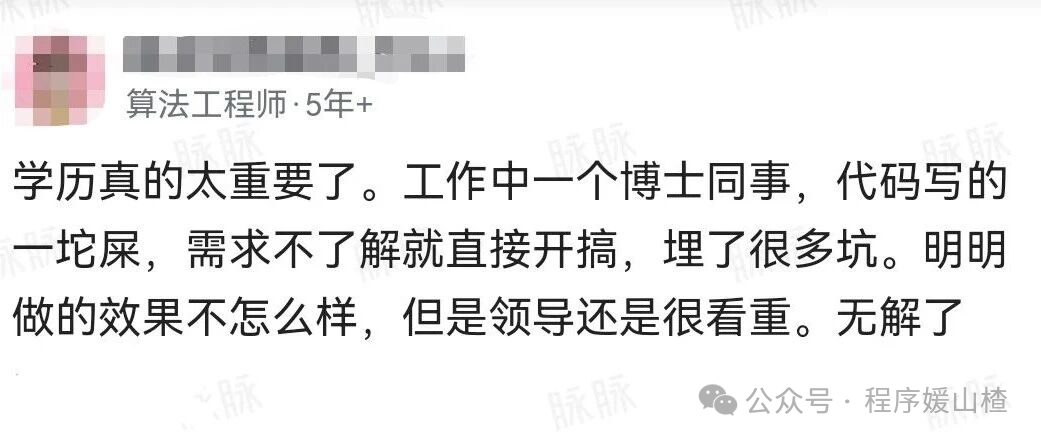

刚看到一个帖子,讨论职场中一个普遍现象:一位博士同事,代码质量一言难尽,还没理解需求就匆忙开工,在项目中埋下了不少坑。最终效果平平,却依然颇受领导器重。楼主不禁感叹:在学历面前,能力似乎显得不那么“值钱”了。

网友们的回复五花八门:有批判领导“唯学历论”的,有揣测博士更擅长人际沟通的,也有人劝楼主看开些。个人认为,学历确实像一张长期有效的“信用背书”,能快速赢得领导的初始信任,这是现实。但另一方面,能在团队中长期立足、创造稳定价值的,终究是扎实的能力与产出。博士可能承担着对外技术交流、方案撰写、项目“门面”支撑等不那么显眼却重要的工作;而你埋头苦写的每一行代码,其真正的技术难度和价值,领导未必有能力或时间去细致评估。

抛开这些职场感慨,当“提升效率”的具体任务落到头上时,我们还是要回归技术本身,用代码说话。下面,就结合一个具体的“多线程网页爬虫”面试题/实战需求,来聊聊如何把想法落地。

面试题:多线程网页爬虫

记得有一次,组里同事抱怨:单线程爬虫处理上千个页面时,电脑风扇狂转,人还得干等着。领导轻描淡写一句“改成多线程嘛”便转身离去,留下我们几个面面相觑。

仔细想想,单线程爬虫就像一个人挨家挨户送快递,效率可想而知。多线程爬虫则像组织一个配送团队协同工作,关键在于合理分配任务、避免冲突和重复劳动。其核心模型通常包含三部分:一个共享的“待爬取URL队列”、一个用于“去重”的“已访问URL集合”,以及一池子“工作线程”。这个模型其实和解决高并发访问问题的思路是相通的。

可以把这想象成一个中央任务桶(队列),初始放入一个种子URL,周围一圈工人(线程)不断从中领取URL去处理。每个工人的工作流非常清晰:下载网页 -> 解析出新的链接 -> 将未被爬取过的新链接扔回中央任务桶。因此,算法的核心流程可以概括为:循环从队列中取URL -> 检查是否已访问 -> 若未访问则标记 -> 抓取页面并解析链接 -> 将新链接送回队列,直到队列为空或达到设定的爬取上限。

光说不够,直接上代码。以下是一个用Java实现的简化版多线程爬虫骨架,虽然业务逻辑做了简化,但并发处理的套路是真实可用的:

import java.util.Set;

import java.util.concurrent.*;

import java.util.concurrent.atomic.AtomicInteger;

public class MultiThreadCrawler {

// 待爬 URL 队列,多线程安全

private final BlockingQueue<String> urlQueue = new LinkedBlockingQueue<>();

// 已访问 URL 集合,防止重复爬

private final Set<String> visited = ConcurrentHashMap.newKeySet();

// 线程池

private final ExecutorService executor;

private final AtomicInteger pageCount = new AtomicInteger(0);

private final int maxPages;

public MultiThreadCrawler(int threadNum, int maxPages) {

this.executor = Executors.newFixedThreadPool(threadNum);

this.maxPages = maxPages;

}

public void start(String seedUrl) throws InterruptedException {

urlQueue.offer(seedUrl);

// 启动工作线程

for (int i = 0; i < ((ThreadPoolExecutor) executor).getCorePoolSize(); i++) {

executor.submit(new Worker());

}

// 等待所有任务完成

executor.shutdown();

executor.awaitTermination(30, TimeUnit.MINUTES);

}

private class Worker implements Runnable {

@Override

public void run() {

try {

while (!Thread.currentThread().isInterrupted()) {

// 1 秒拿不到任务就认为没活了

String url = urlQueue.poll(1, TimeUnit.SECONDS);

if (url == null) {

break;

}

// 去重

if (!visited.add(url)) {

continue;

}

// 控制最大爬取页数

int current = pageCount.incrementAndGet();

if (current > maxPages) {

break;

}

try {

crawlPage(url);

} catch (Exception e) {

// 线上最好打日志,这里简单打印

System.err.println("crawl error: " + url + " " + e.getMessage());

}

}

} catch (InterruptedException e) {

// 收尾退出

Thread.currentThread().interrupt();

}

}

}

// 真正的“爬一页”的逻辑

private void crawlPage(String url) throws Exception {

// 这里你可以换成 HttpClient + Jsoup,下面只是个示意

System.out.println("[" + Thread.currentThread().getName() + "] crawling: " + url);

String html = download(url); // 下载页面

for (String link : extractLinks(html)) { // 解析出新的链接

if (!visited.contains(link)) {

urlQueue.offer(link); // 丢回任务队列

}

}

}

// 模拟下载

private String download(String url) throws Exception {

// 真实环境就是发 HTTP 请求了

Thread.sleep(100); // 假装网络延时

return "<a href=\"http://example.com/a\">a</a>";

}

// 模拟解析链接

private Iterable<String> extractLinks(String html) {

// 真实环境里用 Jsoup.parse(html)... 之类的

return java.util.List.of("http://example.com/a");

}

public static void main(String[] args) throws InterruptedException {

MultiThreadCrawler crawler = new MultiThreadCrawler(8, 100);

crawler.start("http://example.com");

}

}

这段代码中有几个关键点是面试官喜欢深挖的,我们来逐一分析:

-

为什么用 BlockingQueue?

在多线程环境下,如果使用普通的 List,需要自行加锁管理,容易引发死锁或导致性能瓶颈。BlockingQueue 是线程安全的,并且当队列为空时,调用 poll(timeout) 的线程会阻塞等待,避免了 while(true) 空转消耗CPU资源。

-

为什么用 ConcurrentHashMap.newKeySet() 做去重?

这里切忌使用 new HashSet<>() 然后外加 synchronized 锁,因为在高并发下,这把大锁会让所有线程串行访问,性能退化严重。ConcurrentHashMap 提供的并发集合在底层做了更细粒度的锁优化,我们直接调用 visited.add(url) 即可保证线程安全且高效。

-

AtomicInteger pageCount 的作用?

这里退出机制并非单纯等待队列为空,而是通过原子计数器全局统计已爬取的页面数,达到阈值即停止。这在回答面试官“如何控制爬取规模,避免对目标站点造成压力”时非常有用。可以顺势提及“礼貌爬虫”的概念:比如限速、设置合理的User-Agent、遵守robots协议等。

在实际项目中,我们通常还会增加一些约束条件,例如:

- 域名限制:只爬取特定白名单内的域名。

- 深度控制:限制从种子URL开始的链接跳转深度。

- 限流机制:针对同一域名使用

Semaphore 或设置请求间隔(sleep),防止访问过于频繁。

这些功能的实现逻辑基本都可以封装在 crawlPage 方法中,不会影响整体的爬虫架构。

还有一个容易踩坑的提醒:不要在工作者线程中随意捕获异常后静默处理(catch Exception 后什么都不做)。这会导致线程“无声无息”地死亡,任务卡住却难以排查。至少应该记录日志,输出出错URL,便于后续复盘。这一点与排查数据库、消息队列等中间件问题的思路一致:留下足够的排查线索。

从职场现象的观察到具体算法与并发技术的落地,希望这个从吐槽引申出的实战案例能给你带来一些启发。如果你对这类技术实践、架构思考或者纯粹的开发者闲谈感兴趣,欢迎来云栈社区逛逛,这里有不少类似的讨论和干货分享。

(温馨提示:如果真要把这类爬虫部署到生产环境,务必提前和运维同事沟通好,设定合理的爬取策略,否则大量的对外网络请求可能会触发安全警报。)