你是否也遇到过这样的困惑?GitHub上那些动辄上万行的HTTP服务器项目,代码看得一头雾水,更别提自己动手实现一个了。或者,跟着教程一通“魔改”和“拿来主义”,当面试官问起底层如何运作时,却只能支支吾吾。

问题的核心在于,大多数人只停留在“会用”的层面,缺乏“从零设计”一个高性能网络框架的系统性思维。今天,就让我们打破这个僵局。

性能先行:用数据说话

一个项目的含金量,最终要靠性能指标来证明。通过精心设计的架构与优化,这个名为 FlashHTTP 的高性能服务器交出了一份亮眼的成绩单。

在极限性能测试中,我们模拟了真实的 POST 请求创建用户场景(JSON格式),并使用行业标准的 wrk 压测工具,在 4 万并发连接下进行了长达 60 秒的持续压测。

# 测试场景:POST 请求创建用户(JSON)

# 工具:wrk(业界标准压测工具)

# 并发:40,000 连接(模拟真实高并发场景)

wrk -t4 -c40000 -d60s -s post.lua --latency \

http://localhost:8080/api/users

压测结果(60秒持续压测)

| 指标 |

10,000 并发 |

40,000 并发 |

| QPS |

451,451 🚀 |

317,591 |

| P50 延迟 |

10.67ms |

45.37ms |

| P99 延迟 |

22.96ms |

80.51ms |

| 总请求数 |

2712万 |

1909万 |

| 吞吐量 |

53.82MB/s |

37.86MB/s |

这些数字意味着什么?

- 每秒45万QPS:能够处理海量的HTTP请求。

- P99延迟低于100ms:99%的请求都能在极短时间内得到响应,用户体验流畅。

- 稳定支撑4万并发:具备了承载中大型互联网应用流量的潜力。

- 超越许多开源实现:经过对比测试,其性能表现优于GitHub上不少同类开源项目。

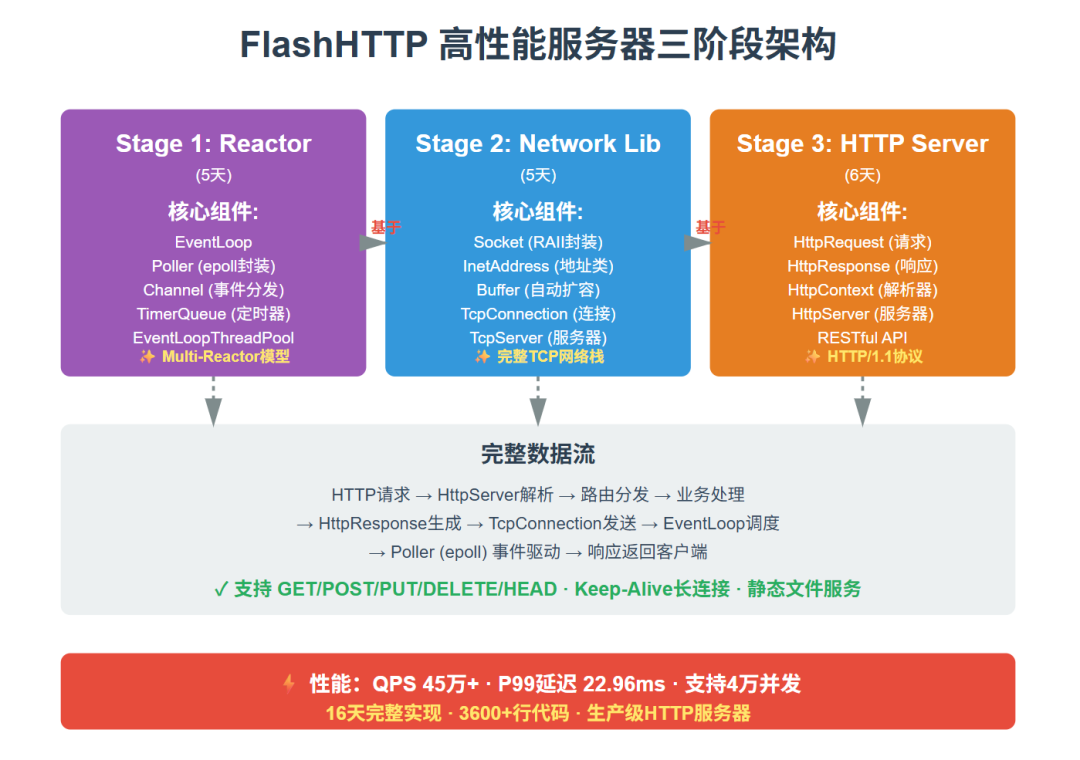

架构解析:三阶段递进式实现

为了让学习路径清晰可控,整个项目被拆解为三个循序渐进的阶段,共计16天的学习计划。每一天都目标明确,产出可运行的完整代码,确保你能持续获得成就感。

整体架构图

上图清晰地展示了FlashHTTP的三层架构:最底层的Reactor事件驱动引擎、中间层的通用网络库,以及最上层的HTTP协议服务器。每一层都建立在下一层的基础之上,数据流自底向上清晰传递。

第一阶段:构建高性能 Reactor 核心(5天)

这是整个服务器的核心引擎,也是现代高性能网络编程的基石。掌握它,你就掌握了事件驱动模型的精髓。

Day 1: epoll 封装与事件分发

├─ 实现 Poller(epoll 的 RAII 封装)

├─ 实现 Channel(文件描述符 + 事件回调)

├─ 测试:监听标准输入事件

└─ 产出:能响应 IO 事件的最小系统

Day 2: EventLoop 事件循环

├─ 实现单线程 Reactor

├─ 事件循环的启动/停止机制

├─ Channel 的注册/更新/移除

├─ 测试:单连接 echo server

└─ 产出:完整的事件循环框架

Day 3: TimerQueue 高精度定时器

├─ 基于 timerfd 实现定时器

├─ Timer 和 TimerId 设计

├─ 定时器的添加/取消/触发

├─ 测试:定时打印 + 超时关闭

└─ 产出:支持定时任务的 Reactor

Day 4: 多线程模型与线程池

├─ 实现 EventLoopThread

├─ 实现 EventLoopThreadPool

├─ eventfd 实现跨线程唤醒

├─ 测试:多线程 echo server

└─ 产出:Multi-Reactor 多线程模型

Day 5: 性能优化与压力测试

├─ 零拷贝优化

├─ 性能测试工具编写

├─ QPS/延迟 压测对比

├─ 使用示例与最佳实践

└─ 产出:完整的高性能 Reactor

核心收获:

- 深入掌握 Linux

epoll 的高性能用法。

- 透彻理解 Reactor 设计模式的本质。

- 学会多线程网络编程的关键技巧。

第二阶段:封装通用 TCP 网络库(5天)

在稳固的Reactor核心之上,我们封装出一套易用、健壮的TCP网络库,为上层应用提供坚实的基础设施。

Day 1: Socket 封装与地址类

├─ 实现 Socket RAII 封装

├─ 实现 InetAddress(IPv4/IPv6)

├─ SocketsOps 工具函数集

├─ 测试:socket 创建/绑定/监听

└─ 产出:完整的 Socket 基础设施

Day 2: Acceptor 连接接受器

├─ 封装 listening socket

├─ 集成到 EventLoop

├─ 新连接回调机制

├─ 测试:accept 新连接

└─ 产出:能接受连接的服务器

Day 3: Buffer 自动扩容缓冲区

├─ 实现应用层 Buffer

├─ 自动扩容 + prepend 空间

├─ readFd 优化(scatter-gather IO)

├─ 测试:各种读写场景

└─ 产出:高效的缓冲区组件

Day 4: TcpConnection 核心

├─ 实现 TcpConnection(封装已连接 socket)

├─ 完整的读写逻辑

├─ 优雅关闭(半关闭)

├─ 生命周期管理(shared_ptr)

├─ 测试:echo 服务器

└─ 产出:可靠的 TCP 连接抽象

Day 5: TcpServer 与性能测试

├─ 实现 TcpServer

├─ 集成 Multi-Reactor 线程池

├─ 连接管理与负载均衡

├─ echo 服务器性能测试

├─ benchmark 压测

└─ 产出:完整的高性能网络库

核心收获:

- 从代码层面理解 TCP 连接的生命周期(三次握手、数据传输、四次挥手)。

- 掌握高性能

Buffer 的设计哲学与技巧,有效解决TCP粘包/半包问题。

- 学会运用 RAII(资源获取即初始化)等现代C++理念安全管理资源。

第三阶段:实现 HTTP/1.1 协议服务器(6天)

最后,我们在通用的网络库之上,实现完整的 HTTP/1.1 协议栈,打造出最终可用的生产级HTTP服务器。

Day 1: HTTP 协议基础 + Request/Response

├─ HTTP 协议格式深度解析

├─ 实现 HttpRequest(请求解析)

├─ 实现 HttpResponse(响应生成)

├─ 支持 GET/POST/PUT/DELETE/HEAD

├─ 测试:基本 HTTP 请求响应

└─ 产出:HTTP 数据结构

Day 2: HttpContext 状态机解析器

├─ 基于状态机的协议解析

├─ 处理不完整数据(粘包/半包)

├─ 请求行/Headers/Body 解析

├─ 测试:各种请求格式

└─ 产出:健壮的 HTTP 解析器

Day 3: HttpServer + 静态文件服务

├─ 封装 HttpServer

├─ 实现 MIME Type 支持(30+ 类型)

├─ 静态文件服务(HTML/CSS/JS/图片)

├─ 路由回调机制

├─ 测试:浏览器访问

└─ 产出:可用的 HTTP 服务器

Day 4: POST 请求 + JSON/表单解析

├─ Content-Length Body 解析

├─ application/json 支持

├─ application/x-www-form-urlencoded 表单

├─ RESTful API 实现

├─ 测试:POST/PUT/DELETE 接口

└─ 产出:支持动态内容的服务器

Day 5: Keep-Alive + 大文件保护

├─ HTTP/1.1 Keep-Alive 长连接

├─ 大文件上传保护(100MB 限制)

├─ 统一错误处理(400/413/500)

├─ 完善 HEAD 方法

├─ index.html 默认文件支持

└─ 产出:生产级 HTTP 服务器

Day 6: 性能优化 + 压力测试

├─ Linux 内核参数调优(脚本)

├─ wrk 压测工具使用(Lua 脚本)

├─ 全场景性能测试(GET/POST/并发)

├─ 性能瓶颈分析与优化

├─ 生成专业性能报告

└─ 产出:45万 QPS 的高性能服务器

核心收获:

- 亲眼见证并动手实现一个 HTTP Server 从协议解析到响应生成的全过程。

- 掌握使用状态机解析复杂网络协议的经典方法。

- 学会一套完整的服务器性能分析与调优方法论。

为什么这个项目值得投入?

1. 获得“造轮子”的完整思维框架

这个项目最大的价值不在于那3600多行C++代码,而在于传递一套“从零设计”的思维模式。你会真正理解:

- 为什么选择 epoll 而不是 select/poll?(性能差距是数量级的)

- 为什么必须设计应用层 Buffer?(这是解决网络通信不确定性问题的关键)

- 为什么用状态机来解析 HTTP?(这是处理流式、不完整数据的标准做法)

- 如何实现 Keep-Alive?(连接复用如何带来数倍的性能提升)

这些“为什么”,恰恰是技术面试中区分“背诵者”与“思考者”的关键。

2. 简历上的硬核亮点

完成本项目后,你的简历可以这样写,每一项都有扎实的代码和性能数据支撑:

项目:独立设计并实现了FlashHTTP高性能 HTTP 服务器(C++)

技术栈:C++17、epoll、Multi-Reactor、HTTP/1.1

性能指标:

- QPS: 45万+(4核CPU)

- P99延迟: 22.96ms

- 支持4万并发连接

项目亮点:

1. 从零实现完整的网络库(Reactor+TcpServer)

2. 基于状态机的HTTP协议解析,支持粘包/半包处理

3. 实现RESTful API(GET/POST/PUT/DELETE/HEAD)

4. Multi-Reactor多线程模型,充分利用多核CPU

5. 性能达到 45万+ QPS,支持 4万 并发连接(wrk压测验证)

6. P99 延迟 < 100ms,可承载大型互联网应用流量

3. 强大的可扩展性基础

这不仅仅是一个HTTP服务器项目,它更是一个优秀的、你亲手打造的高性能网络/系统编程基础框架。以此为起点,你可以轻松地向多个方向扩展:

- 想实现 RPC 框架? 直接在

TcpServer 上增加序列化/反序列化模块即可。

- 想支持 WebSocket? 在

HttpServer 中实现协议升级逻辑。

- 想研究负载均衡? 基于多个

EventLoop 线程池来实现。

- 想解析 Redis 协议? 复用现有的

Buffer 和 TcpConnection 架构。

4. 掌握专业的性能调优技能

项目不仅教你实现,更教你如何验证和优化。你会亲手使用行业标准的 wrk 压测工具,并学习如何编写Lua测试脚本。同时,还会掌握关键的 Linux 内核网络参数调优技巧。

# Linux 内核调优脚本(一键优化)

sudo ./tune_kernel.sh

# wrk 压测工具 + Lua 脚本(行业标准)

wrk -t4 -c10000 -d60s -s post.lua --latency \

http://localhost:8080/api/users

快速上手:简洁的 API 设计

尽管底层复杂,但最终暴露给开发者使用的 API 却力求简洁直观。以下是一个简单的示例,展示了如何快速启动一个功能丰富的HTTP服务器。

#include "FlashHTTP/HttpServer.h"

#include "FlashHTTP/HttpRequest.h"

#include "FlashHTTP/HttpResponse.h"

using namespace flashhttp;

// HTTP 回调函数(处理业务逻辑)

void onRequest(const HttpRequest& req, HttpResponse* resp){

std::string path = req.path();

// 路由1:首页

if (path == "/") {

resp->setStatusCode(HttpResponse::k200Ok);

resp->setContentType("text/html; charset=utf-8");

resp->setBody("<h1>Welcome to FlashHTTP!</h1>");

}

// 路由2:JSON API

else if (path == "/api/users") {

resp->setStatusCode(HttpResponse::k200Ok);

resp->setContentType("application/json");

resp->setBody(R"({"users": ["Alice", "Bob", "Charlie"]})");

}

// 路由3:POST 创建用户

else if (req.method() == HttpRequest::kPost && path == "/api/users") {

std::string body = req.body(); // 获取请求 Body

// 处理 JSON 数据...

resp->setStatusCode(HttpResponse::k201Created);

resp->setBody(R"({"message": "User created"})");

}

// 404

else {

resp->setStatusCode(HttpResponse::k404NotFound);

resp->setBody("<h1>404 Not Found</h1>");

}

}

int main(){

EventLoop loop;

InetAddress addr(8080);

// 创建 HTTP 服务器(4 个工作线程)

HttpServer server(&loop, addr, "FlashHTTP");

server.setHttpCallback(onRequest);

server.setThreadNum(4);

server.start();

loop.loop(); // 启动事件循环

return 0;

}

编译运行只需几步:

mkdir build && cd build

cmake ..

make

# 启动服务器

./FlashHTTP_Server

# 访问测试

curl http://localhost:8080/

curl http://localhost:8080/api/users

这不是终点,而是起点

很多人会问:“HTTP Server 项目是不是已经烂大街了?”

关键在于深度。能够清晰阐述从 epoll 事件通知到 Buffer 处理,再到 HTTP 状态机解析的完整链条,并能用45万QPS的数据证明其实现质量的人,永远是市场上的稀缺资源。

通过这16天的系统实践,你获得的将不仅是一个能写进简历的开源实战项目,更是一套解决复杂系统问题的思维框架和一项极具竞争力的核心技术能力。从“阅读者”到“创造者”,这一步至关重要。