打开一个大型软件,为什么第一次加载总是很慢,后面操作就快多了?手机只有8GB内存,却为什么能存下几十GB的照片、安装十几个App?这背后,其实是计算机的Cache、主存、辅存三级存储结构在默默工作。

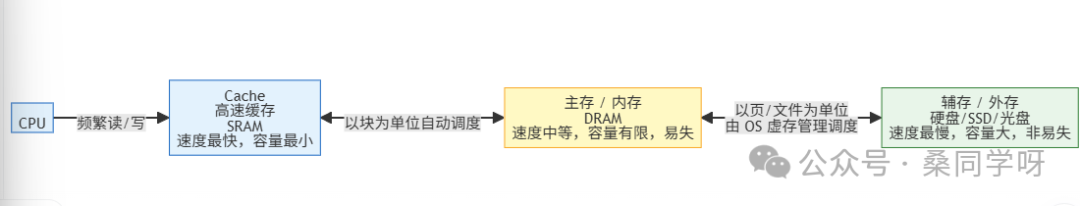

计算机的存储系统本质上是一个金字塔,它要解决的核心问题就是在速度、容量、价格之间找到最佳平衡点。快的存储容量小、价格贵,容量大的又速度慢、价格便宜。三级存储相互配合,才能实现又快、又大、又实惠的综合体验:

- 顶层:寄存器 + Cache。它们速度最快、容量最小、成本最高,就像是CPU的贴身秘书,只存放当下最常用的数据和指令。

- 中层:主存(内存)。速度中等、容量适中,是CPU的“办公桌”,专门存放正在被处理的程序和数据。

- 底层:辅存(硬盘/SSD等)。速度最慢、容量巨大、价格便宜,是整个系统的“大仓库”,用于长期存放所有数据。

为了让这套体系高效运转,还形成了两个关键的搭档组合:

- Cache + 主存:这对组合解决了 CPU跑得太快、内存速度跟不上 的矛盾,让大部分操作都能“秒速”完成。

- 主存 + 辅存:这对组合则解决了 物理内存容量不足 的问题,这就是我们常说的虚拟内存机制,让你感觉内存“变大了”。

一、三位“存储角色”的详细解读

1. Cache:CPU的“贴身秘书”

Cache(高速缓存)是离CPU最近的存储器,很多直接集成在CPU芯片内部。它就像一个高效的秘书,只记录老板(CPU)当前最急需、最常用的信息,避免老板每次都跑去大办公室(主存)翻找文件。

- 位置:位于CPU和主存之间,紧密跟随CPU。

- 材质:使用SRAM(静态随机存取存储器),其速度通常比主存(DRAM)快10到100倍,但成本极其高昂。

- 容量:极小,通常只有几KB到几十MB(例如,CPU的一级L1 Cache可能只有几十KB)。

- 核心作用:缓存CPU最近频繁使用的指令和数据,大幅减少CPU访问慢速主存的次数,从而提升整体运算速度。

- 关键特点:对程序员完全透明(无需干预),由硬件自动管理;它按固定大小的 “块” (如64字节)与主存交换数据。其高效工作的理论基础是 “局部性原理” ——CPU近期访问过的数据,很可能很快再次被访问(时间局部性);CPU访问某个数据时,其相邻的数据也很可能很快被访问(空间局部性)。

2. 主存:CPU的“办公桌”

我们购买电脑时常说的8GB、16GB内存,指的就是主存。它好比CPU的办公桌面,只能放置当前正在处理的“文件”,无法长期保存,一旦“下班断电”,桌面就会被清空。

- 位置:直接连接到系统总线上,CPU可以直接寻址访问。

- 材质:主要使用DRAM(动态随机存取存储器),这是目前最主流的内存技术。

- 容量:通常在几GB到几十GB之间(个人电脑常见8/16/32GB,服务器则更大)。

- 关键特点:易失性(断电后数据丢失);CPU可直接通过地址访问;它承上启下,对上作为Cache的数据源,对下则与辅存配合扩展容量。

3. 辅存:计算机的“大仓库”

我们存储照片、安装软件的硬盘(HDD)、固态硬盘(SSD)、U盘等,都属于辅存。它就是那个巨大的仓库,无论当前是否用到,所有数据都可以长期存放在这里,断电也不会丢失。

- 位置:通过I/O接口连接到总线,CPU不能直接访问其内容。

- 常见材质:机械硬盘(HDD,速度慢但便宜)、固态硬盘(SSD,速度快但成本较高)、U盘、光盘等。

- 容量:极大,从几百GB到几十TB不等(个人电脑常见512GB/1TB,移动硬盘可达10TB以上)。

- 关键特点:非易失性(断电后数据永久保存);速度最慢(比主存慢数十到数百倍)。CPU想要访问辅存上的数据,必须首先通过操作系统(OS)将所需数据“调入”主存,然后才有可能被Cache进一步缓存。

二、为什么必须是三级存储?

如果只用其中任意一种存储介质,都会存在致命缺陷:

- 只用Cache:速度无敌快,但容量太小,连一个完整的操作系统都装不下。

- 只用主存:速度和容量看似折中,但成本过高。想象一下用DRAM做成几十TB的“内存”,其价格足以买下数台高性能服务器。

- 只用辅存:容量大且便宜,但速度慢得让人崩溃,CPU等待数据的时间会远远超过处理数据的时间,系统将毫无效率可言。

因此,三级存储的设计哲学就是取长补短:

让顶层的Cache保证极致速度,让中层的主存保证可用性和性能平衡,让底层的辅存保证海量存储容量。三者通过硬件和操作系统的自动调度紧密配合,最终给程序员和用户呈现出一个速度快、容量足、成本可控的理想存储系统。

三、核心搭档:两个关键组合

三级存储的精髓,实际上体现在两组搭档的协同上:Cache-主存(主要由硬件管理)和主存-辅存(由操作系统与硬件协同管理),它们各自攻克一个核心难题。

1. Cache-主存搭档:解决“速度墙”问题

这套机制完全由硬件自动管理,程序员无需关心。其核心目标是让CPU尽可能多地在高速的Cache中找到所需数据,我们称之为 “命中”。

- 数据单位:主存和Cache都被划分为大小相同的 “块” ,数据的交换以块为单位进行。

- 映射方式:主存的块如何放入有限的Cache空间中?主要有三种策略:

- 直接映射:每个主存块在Cache中有唯一固定位置(简单,但容易冲突)。

- 全相联映射:主存块可以放入Cache的任何位置(灵活,但查找复杂)。

- 组相联映射:将Cache分组,主存块可以映射到特定组内的任意行(最常用的折中方案)。

- 替换算法:当Cache已满,需要调入新块时,必须换出一个旧块。常用算法有:随机、FIFO(先进先出)、LRU(最近最少使用,最常用)、LFU(最不经常使用)。

- 性能指标:命中率是关键,它等于命中次数除以总访问次数。命中率越高,平均访问时间越接近Cache的速度。平均访问时间 = 命中率 × Cache访问时间 + (1 - 命中率) × 主存访问时间。

2. 主存-辅存搭档:解决“容量墙”问题

这也就是虚拟内存技术,由操作系统主导。其核心是让应用程序“感觉”自己拥有比实际物理内存大得多的地址空间。

- 数据单位:以 “页” 为单位(常见为4KB)。主存中存放页的物理区域称为“页框”。

- 页表作用:每个进程都有自己的页表,由操作系统维护。它记录了该进程的每个逻辑页面是在物理内存中,还是在硬盘上,以及页面的状态(是否被修改等)。

- 缺页中断:当CPU试图访问一个不在物理内存中的页面时,会触发缺页中断。操作系统接管后,会从辅存(硬盘的交换区)将所需页面调入内存。如果内存已满,则需先根据某种算法选择一个页面“换出”。

- 置换算法:与Cache类似,常用FIFO、LRU、时钟算法(Clock,一种近似LRU的高效实现)等。

四、三级存储如何协同工作?一次完整的数据访问之旅

让我们用一个CPU读取数据的例子,将整个流程串联起来,加深理解。

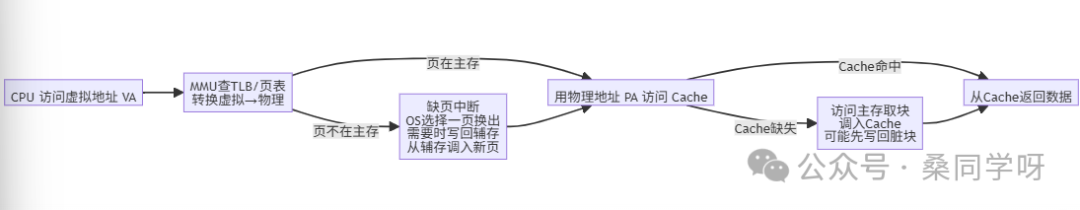

假设CPU需要读取某个数据,其完整步骤如下:

- 地址转换:CPU给出一个虚拟地址,经过内存管理单元查找页表后,转换为实际的物理地址。

- 访问Cache:用物理地址去查询Cache。

- 情况A:命中。Cache直接返回数据给CPU,流程结束(最快路径,占90%以上的情况)。

- 情况B:未命中。CPU去访问主存,将包含该数据的整个“块”调入Cache,然后再从Cache返回数据给CPU。

- 访问主存与缺页处理:如果在第2步中发现该物理地址对应的页面根本不在主存中(页表项标记为“不在内存”)。

- 触发缺页中断,操作系统接管。

- OS选择一个内存中不常用的页面换出(如果该页面被修改过,需先写回辅存)。

- OS从辅存中将所需页面调入主存的空闲页框中,并更新页表。

- 流程跳回第2步,重新访问Cache(此时大概率会触发一次Cache未命中,然后从主存加载数据)。

五、两个实例:深入理解核心逻辑

通过两个简单的例子,可以更直观地感受Cache和虚拟内存的工作原理。

实例1:Cache-主存配合(空间局部性)

看下面这个简单的C语言循环求和代码:

int sum = 0;

for (int i = 0; i < 1024; i++) {

sum += a[i];

}

假设:数组a连续存放在主存中,Cache块大小为64字节,每个int类型数据占4字节。那么,一个Cache块可以存放16个数组元素。

工作过程:

- 第一次读取

a[0]时,Cache中没有该数据(缺失),于是从主存中将包含a[0]到a[15]的整个数据块调入Cache,然后再将a[0]的值返回给CPU。

- 接下来读取

a[1]到a[15]时,由于它们都在刚才调入的同一个Cache块中,因此全部 命中,速度极快。

- 当读取

a[16]时,需要新的数据块,再次发生Cache缺失,调入a[16]到a[31]的数据块,后续的a[17]到a[31]访问又全部命中。

结论:整个1024次的循环中,只发生了大约64次(1024/16)Cache缺失,其余超过90%的访问都是高速命中。这就是 “空间局部性” 的威力——Cache一次性预取连续数据,极大地提升了遍历等操作的效率。理解这些底层原理,是深入学习 计算机基础 知识的关键。

实例2:主存-辅存配合(虚拟内存)

假设:物理内存只有4个页框(只能放4页),而一个程序需要顺序访问以下页面序列:0, 1, 2, 3, 0, 2, 1, 4, 5, 6...

我们使用简单的FIFO(先进先出)页面置换算法。

工作过程:

- 访问页面0, 1, 2, 3:它们都不在内存,依次发生缺页中断,从硬盘调入。此时内存被装满。

- 访问页面0, 2, 1:它们都在内存中,不缺页,直接访问。

- 访问页面4:内存已满,发生缺页中断。根据FIFO规则,换出最先进入的页面0,然后将页面4调入内存。

- 访问页面5、6:继续发生缺页中断,依次换出页面1、2,并调入页面5、6。

结论:这个程序逻辑上需要访问多达8个不同的页面,但物理内存实际只能容纳4页。通过操作系统的虚拟内存机制(缺页中断和页面置换),程序“以为”自己拥有足够大的内存空间,从而得以顺利运行。这正是 内存管理 中解决物理资源限制的核心思想。

六、总结

- Cache:CPU的贴身秘书,追求极致速度,容量小,成本高,由硬件透明管理,依赖局部性原理工作。

- 主存:CPU的办公桌,平衡速度与容量,直接服务于CPU,是连接高速缓存和大容量仓库的桥梁。

- 辅存:计算机的大仓库,提供海量、廉价、持久的存储空间,是最终的数据归宿。

- 核心协作:Cache与主存搭档攻克速度瓶颈,主存与辅存搭档突破容量限制,三者层层协作,共同构建了现代计算机高效、可靠、经济的存储系统。

理解了这三层存储架构及其协作原理,你就能更深刻地洞察软件性能瓶颈,甚至写出对缓存更友好的高效代码。如果想与更多开发者交流类似的技术洞见,欢迎来 云栈社区 一起探讨。