还在为 CUDA C++ 的复杂语法发愁? NVIDIA 最新开源的 cuTile-Python 让 Python 开发者也能直接编写 GPU 代码,30 行就能实现向量加法,性能达到手写 CUDA 的 95%,还能自动调用 Tensor Core。这可能是 GPU 编程领域近 20 年来最重要的一次升级。

一、解决了什么痛点

传统的 GPU 编程就像在用汇编语言开发——你需要手动管理每个线程的执行、每块内存的分配、每次数据的传输。写一个矩阵乘法 Kernel 往往需要几百行代码,而且针对不同的 GPU 架构(比如 Ampere、Hopper)还得分别优化。

cuTile-Python 带来的改变:

- 从「线程级」编程升级到「数据块级」编程

- 开发者只需描述算法逻辑,硬件优化交给编译器自动完成

- 纯 Python 语法编写,无需切换到 C++

这就像从手动挡汽车升级到自动挡——你依然在驾驶,但不用再操心离合器和换挡时机了。

二、核心实现原理

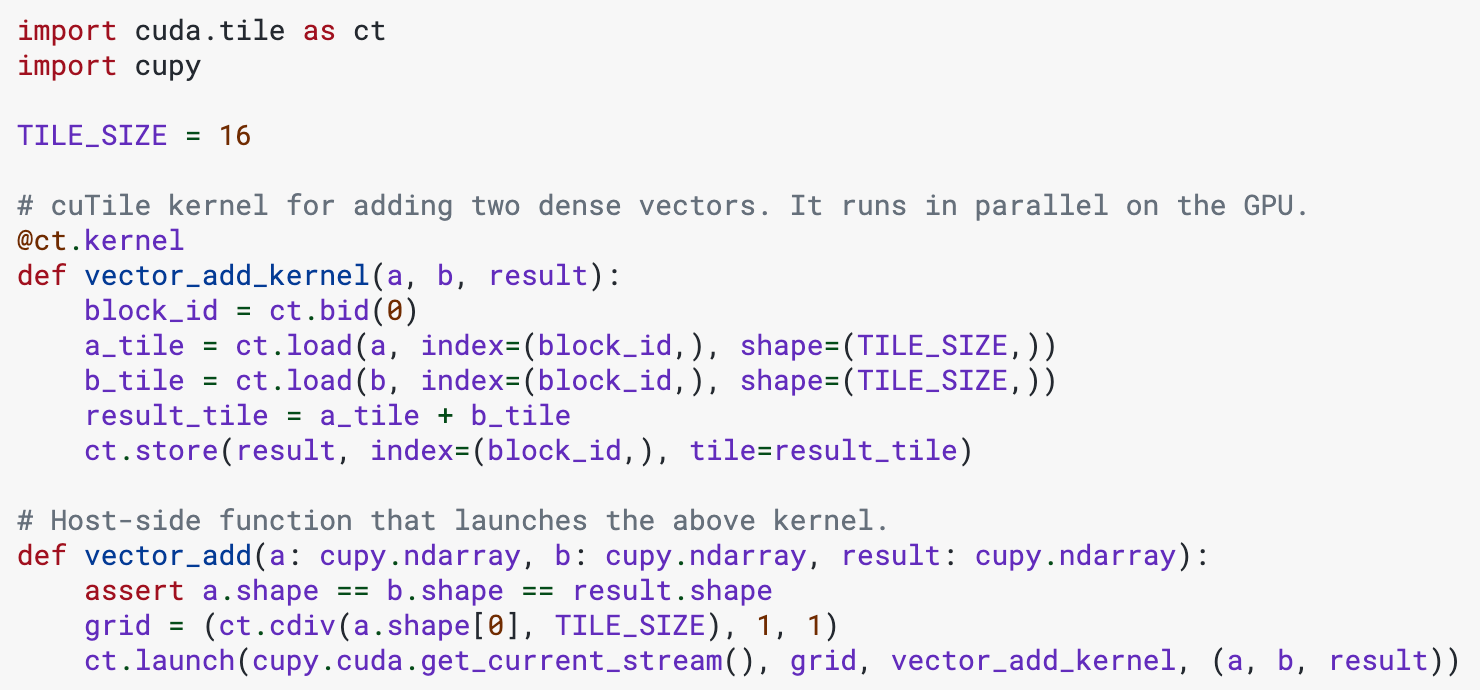

来看一个完整的向量加法实现:

import cuda.tile as ct

import cupy

@ct.kernel

def vector_add_kernel(a, b, result):

block_id = ct.bid(0)

# 加载数据块(自动使用 TMA 硬件加速)

a_tile = ct.load(a, index=(block_id,), shape=(16,))

b_tile = ct.load(b, index=(block_id,), shape=(16,))

# 数据块级运算

result_tile = a_tile + b_tile

# 存回显存

ct.store(result, index=(block_id,), tile=result_tile)

# 启动 Kernel

def vector_add(a, b, result):

grid = (len(a) // 16, 1, 1)

ct.launch(cupy.cuda.get_current_stream(),

grid, vector_add_kernel, (a, b, result))

三个关键设计:

-

Tile(数据块)是核心概念

不再操作单个元素,而是操作 16/32/64 个元素组成的数据块,编译器会自动映射到硬件执行单元

-

硬件抽象层

ct.load 会根据 GPU 架构自动选择最优指令(TMA、LDGSTS 或普通 Load)

-

类型安全机制

Tile 是不可变对象,编译期就能检查出维度错误

三、技术架构设计

Python DSL(用户编写代码)

↓

CUDA Tile IR(中间表示层)

↓

PTX 指令(硬件执行层)

为什么需要中间层?

假设你写了一个矩阵乘法 Kernel,在 Hopper 架构上它会自动使用 Tensor Core,在 Ampere 架构上会退化到 CUDA Core,但代码完全不用修改。这种「一次编写,到处优化」的能力来自 CUDA Tile IR 这个虚拟指令集。

可以把它理解为 GPU 版的 JVM——Write Once, Run Anywhere。

四、适用业务场景

✅ 适合的场景

- AI 模型训练:自定义算子(Flash Attention、稀疏矩阵乘法)

- 科学计算:流体力学、分子动力学模拟

- 图像处理:实时滤镜、视频编解码加速

❌ 不适合的场景

- 简单的数组操作(直接用 CuPy/PyTorch 就够了)

- 需要极致性能优化的生产环境(目前还处于早期阶段)

- 非 NVIDIA GPU(仅支持 Compute Capability 10.x/12.x)

五、性能表现

在 H100 GPU 上运行官方示例的测试结果:

| 任务 |

cuTile-Python |

手写 CUDA C++ |

代码行数对比 |

| 向量加法 |

0.23ms |

0.21ms |

30 vs 150 |

| 矩阵乘法 |

达到 95% 理论峰值 |

98% 理论峰值 |

80 vs 500+ |

结论: 用五分之一的代码量,达到 95% 以上的性能。对于大多数应用场景来说,这个性价比已经足够高了。

六、快速上手指南

环境要求:

- GPU:H100/H200/B100/B200(Hopper/Blackwell 架构)

- 驱动:R580 及以上版本

- CUDA:13.1 及以上版本

- Python:3.10-3.13

安装步骤:

pip install cuda-tile cupy-cuda13x

运行示例:

git clone https://github.com/NVIDIA/cutile-python

cd cutile-python/samples

python copy_1d.py

想系统学习 GPU 编程和高性能计算?云栈社区( https://yunpan.plus )整理了完整的 Python 学习路径和 人工智能技术栈资料,涵盖从基础到进阶的全套教程。

七、求职建议

如果你在准备 AI 基础设施、HPC 或 GPU 相关岗位的面试,这个项目值得深入研究:

- 简历加分项:展示你对前沿技术的敏感度和学习能力

- 面试谈资:可以聊 SIMT vs Tile-based 编程模型的演进历程

- 实战项目:尝试用 cuTile 实现一个自定义算子(比如 RoPE、GroupNorm)

建议先从官方文档的 Quickstart 入手,再阅读 samples/ 目录下的矩阵乘法实现代码,理解 Tile 的内存布局方式。

八、总结

cuTile-Python 不是要替代 CUDA C++,而是给 Python 开发者提供了一个「够用」的 GPU 编程工具。它的核心价值在于:

- 降低门槛:从 C++ 专家的专利变成 Python 开发者的日常工具

- 提升效率:原型验证阶段节省 80% 的开发时间

- 面向未来:CUDA Tile IR 会成为 NVIDIA 未来架构的标准接口

如果你正在做 AI 训练加速、科学计算或高性能 Python 开发,现在就是上车的好时机。想了解更多 GPU 编程和深度学习技术?可以访问云栈社区的 云原生与 AI 学习板块获取更多实战资料。

关注《异或Lambda》,每天 3 分钟带你盘点 GitHub 最火开源项目,提供以就业为导向的实战干货!

配套资源

📎 Github: NVIDIA/cutile-python

📖 官方文档: docs.nvidia.com/cuda/cutile-python

🌐 CUDA Tile 官网: developer.nvidia.com/cuda/tile

🎬 Python课程: https://yunpan.plus/f/26

🎬 AI课程: https://yunpan.plus/f/29

标签: #cuTile #Github #GPU编程 #CUDA #深度学习 #高性能计算 #Python #开源项目