在设计和实现卷积神经网络(CNN)时,理解卷积层如何连续传递和组合特征是构建高效模型的基础。本文将从两个核心问题入手,详细介绍卷积层的输出计算以及实现多层级联输出的多种架构方法。

问题一:卷积层的输入与输出尺寸计算

卷积层的输出尺寸由输入尺寸、卷积核参数、步长(Stride)和填充(Padding)共同决定。掌握其计算公式对于控制特征图(Feature Map)的尺度变化至关重要。

设输入特征图尺寸为 H_in * W_in,卷积核尺寸为 kernel_h * kernel_w,步长为 s,填充为 p,则输出特征图的高度 H_out 和宽度 W_out 可通过以下公式计算:

- 输出高度:

H_out = [(H_in + 2p - kernel_h) / s] + 1

- 输出宽度:

W_out = [(W_in + 2p - kernel_w) / s] + 1

其中,[] 表示向下取整。通过调整 p 和 s,我们可以实现输出尺寸的缩小、保持不变或放大。

问题二:实现多个卷积层连续输出的方法

卷积操作通过局部连接和参数共享,使用卷积核在输入上滑动进行加权求和,逐步提取特征。将多个卷积层有效地组合起来,可以使网络学习到从低级到高级的层次化特征表示,这是现代深度神经网络强大表征能力的关键。

以下是几种常见的实现多卷积层连续输出的架构方法:

-

简单堆叠

这是最基础的方式,即将上一个卷积层的输出直接作为下一个卷积层的输入。通过逐层堆叠,网络能够逐步抽象和组合特征。

-

残差连接(Residual Connection)

在简单的堆叠基础上,引入跨层快捷连接(Shortcut Connection)。将某一层的输出与后面某层的输出进行元素级相加,而非简单替换。这种结构能有效缓解深层网络中的梯度消失/爆炸问题,使得训练极深的网络(如ResNet)成为可能。

-

特征金字塔结构

该方法并行或串联使用不同尺度的卷积核,并将不同层的输出进行融合(如拼接),以构建包含多尺度信息的特征金字塔。这在目标检测(如FPN)等需要同时感知全局语境和局部细节的任务中非常有效。

-

并行卷积层(Inception结构)

在同一网络层中,并行使用多个不同尺寸(如1x1, 3x3, 5x5)的卷积核进行处理,然后将所有分支的输出在通道维度上进行拼接。这使得网络能够在同一层级捕捉不同感受野的特征。

-

多分支结构

将输入数据分流到多个独立的子网络(分支)中进行处理,每个分支可能采用不同的卷积层设计。最后再将各分支的输出通过相加、拼接或注意力加权等方式聚合。这种设计提供了极大的灵活性。

-

结合批量归一化(Batch Normalization)

在卷积层之后、激活函数之前插入批量归一化层,已成为标准实践。它对每个特征通道进行归一化,加速训练收敛,提升模型稳定性,并有一定正则化效果。

-

引入注意力机制

在卷积模块中嵌入通道注意力(如SE Block)或空间注意力模块,让网络自动学习特征图中哪些通道或空间位置更重要,从而动态调整特征响应,提升特征表示的质量。

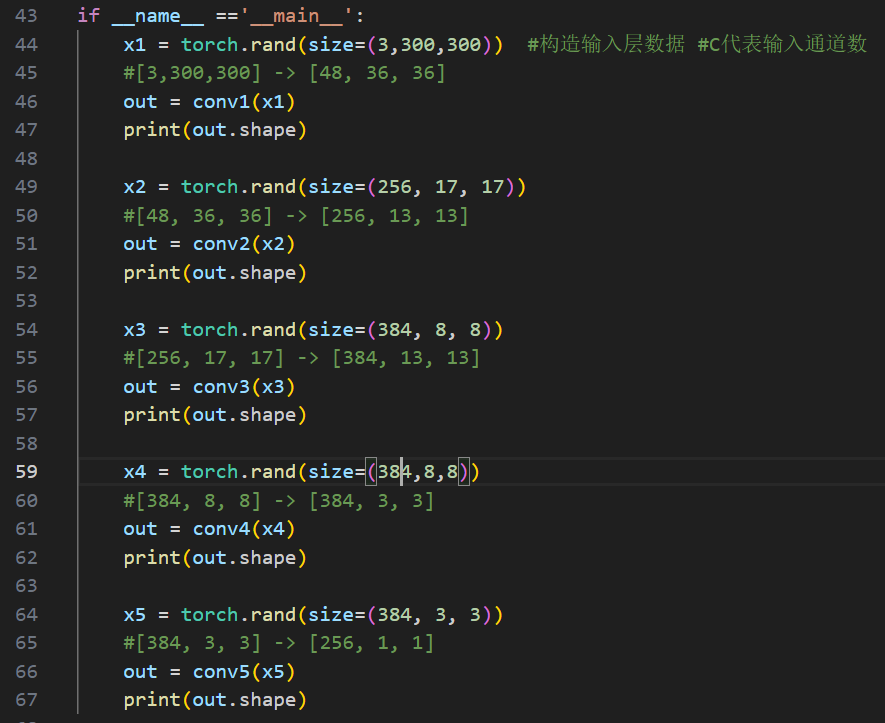

操作示例:使用PyTorch堆叠卷积层

以下是一个使用 PyTorch 框架简单堆叠两个卷积层的代码示例:

import torch

import torch.nn as nn

# 定义一个简单的两层卷积网络

class SimpleConvNet(nn.Module):

def __init__(self):

super(SimpleConvNet, self).__init__()

# 第一个卷积层:输入通道3,输出通道16,卷积核3x3,填充1保持尺寸

self.conv1 = nn.Conv2d(in_channels=3, out_channels=16, kernel_size=3, padding=1)

self.relu1 = nn.ReLU()

# 第二个卷积层:输入通道16,输出通道32

self.conv2 = nn.Conv2d(in_channels=16, out_channels=32, kernel_size=3, padding=1)

self.relu2 = nn.ReLU()

def forward(self, x):

x = self.conv1(x)

x = self.relu1(x) # 第一个卷积层的连续输出

x = self.conv2(x) # 将上一层输出作为输入

x = self.relu2(x) # 第二个卷积层的连续输出

return x

# 构造输入数据(模拟批量大小为4的3通道32x32图像)

input_data = torch.randn(4, 3, 32, 32)

model = SimpleConvNet()

output = model(input_data)

print(f'输出特征图的尺寸: {output.shape}') # 应为 torch.Size([4, 32, 32, 32])

总结与思考

在深度学习的计算机视觉任务中,多个卷积层的连续输出是构建复杂CNN模型的基石。理解输出尺寸的计算公式有助于精确控制网络的数据流。而选择合适的层级联方法(如残差连接、注意力机制等)则决定了模型的学习能力和最终性能。实践中,这些方法常常被组合使用,例如在ResNet中同时使用了残差连接和批量归一化。

需要注意的是,单纯的卷积层堆叠通常用于特征提取,要完成分类或回归等具体任务,还需要在卷积骨干网络后添加全连接层或全局池化层等结构。本文示例仅展示了特征提取部分的基本流程,旨在阐明连续输出的概念。 |