在上一篇文章中,我们探讨了QEMU如何加载并运行一个Guest虚拟系统。然而,在纯软件模拟(TCG)模式下,其性能通常只能达到宿主机硬件性能的10%左右,这显然不是QEMU的终极目标。本文将聚焦Linux平台,深入分析KVM和VirtIO两大技术如何协同工作,共同助力QEMU将虚拟化性能从10%提升至80%以上的水准。

本文的路径是:从什么是KVM,以及KVM如何优化指令和内存虚拟化处理,到什么是VirtIO及其虚拟化驱动框架,再到Linux环境下KVM、VirtIO和QEMU如何协同工作以提升性能,最后概览QEMU在其他宿主机环境下的优化手段,全面揭示QEMU实现性能飞跃的奥秘。

一、KVM:硬件辅助虚拟化的 “性能引擎”

1. 什么是 KVM?—— 内核态的虚拟化能力提供者

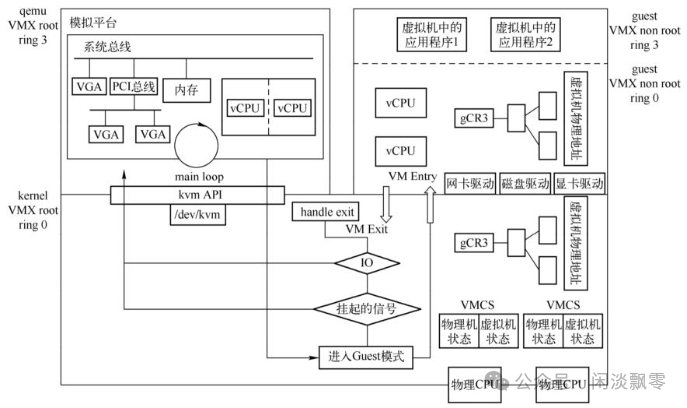

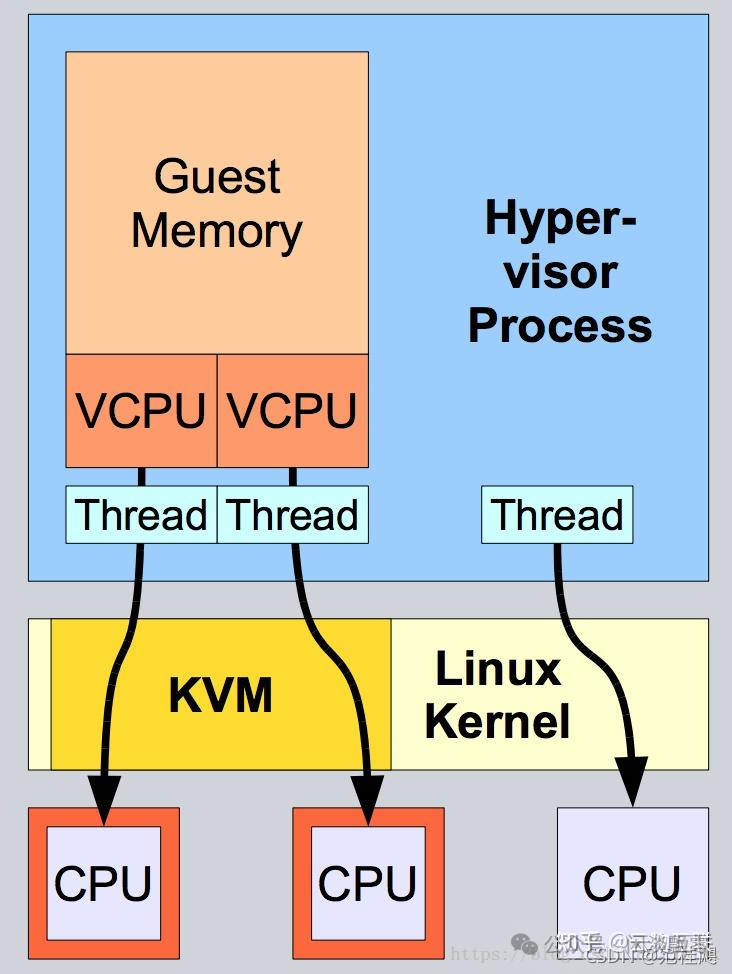

KVM 是 Linux 内核内置的硬件辅助虚拟化模块(自 Linux 2.6.20 版本集成),本质是一套内核态驱动(kvm.ko)+ 硬件虚拟化技术(如 Intel VT-x、AMD-V、ARM VMX)的组合。其核心定位是:将 Guest 系统的指令执行、内存访问、中断处理等核心操作,直接委托给宿主机硬件执行,从而避免 QEMU 纯软件模拟带来的巨大开销。

需要明确的关键认知点:

- • KVM 本身并非一个完整的虚拟化平台,而是 “虚拟化能力的内核级接口”,必须与 QEMU 配合使用,构成 QEMU-KVM 架构。

- • KVM 仅支持 “同架构虚拟化”(如 x86 主机模拟 x86 Guest、ARM 主机模拟 ARM Guest),这与车载场景中域控制器多采用 ARM 架构(如 Cortex-A53/A76)的现状高度契合。

- • 其核心价值在于:通过硬件辅助,将 Guest 指令执行效率从 “软件翻译级” 提升至 “原生硬件级”,同时大幅优化内存虚拟化的地址映射效率。作为Linux内核的关键模块,它奠定了高性能虚拟化的基石。

2. KVM 的核心优化:指令虚拟化加速

纯 QEMU(TCG模式)的性能瓶颈核心在于 “指令翻译开销”——TCG 需要将 Guest 指令动态翻译为 Host 指令,过程中存在大量冗余计算。KVM 通过硬件虚拟化技术,让 Guest 指令得以 “直接执行”,彻底突破了这一瓶颈:

(1)硬件虚拟化技术的核心逻辑

KVM 依赖宿主机 CPU 的硬件虚拟化扩展(如 Intel VT-x、ARM VMX),在 CPU 中新增了两种运行模式:

- • Root 模式:宿主机内核(KVM)和 QEMU 运行在该模式,拥有最高权限。

- • Non-Root 模式:Guest 系统(内核 + 应用)运行在该模式,权限被限制,但可直接执行绝大多数指令。

(2)指令执行流程优化(以 ARM 车载场景为例)

- QEMU 通过 KVM 提供的 ioctl 接口(如

KVM_CREATE_VM、KVM_CREATE_VCPU)创建虚拟机(VM)和虚拟 CPU(VCPU)。

- QEMU 将 Guest 系统的内核镜像、设备树加载到虚拟内存,并通过

KVM_RUN 指令启动 VCPU。

- Guest 指令在 Non-Root 模式下直接由 ARM CPU 执行,无需 TCG 翻译:

- • 普通指令(如算术运算、内存读写):直接执行,性能与原生一致。

- • 特权指令(如修改 CPU 状态、配置中断控制器):触发

VMEXIT(从 Non-Root 模式退出到 Root 模式),由 KVM 内核模块处理。

- KVM 处理完特权指令后,通过

VMENTRY 重新进入 Non-Root 模式,Guest 继续执行。

(3)VMEXIT 优化:减少模式切换开销

VMEXIT 是指令虚拟化的核心开销来源(一次模式切换耗时可达百纳秒级),KVM 通过以下手段进行优化:

- • 特权指令拦截精简:仅对必要的特权指令(如配置 MMU、触发中断)触发 VMEXIT,普通特权指令(如读取 CPU 型号)直接在 Non-Root 模式模拟。

- • 批量处理:将多次连续的 VMEXIT 合并为一次处理(例如当 Guest 频繁配置寄存器时)。

- • 硬件辅助拦截:利用 CPU 的虚拟化扩展(如 ARM 的 EL2 异常级),直接在硬件层面拦截特权指令,减少软件干预。

3. Demo:一个最小化的KVM虚拟机管理器

/dev/kvm 是 Linux 内核为 KVM 模块提供的字符设备接口。QEMU 通过一系列 ioctl() 系统调用与该设备交互,从而将原本需要软件模拟执行的 Guest 代码,转换为由 CPU 硬件直接执行。

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <fcntl.h>

#include <sys/ioctl.h>

#include <sys/mman.h>

#include <linux/kvm.h>

#define MEM_SIZE 0x100000 // 1MB内存(Guest物理内存)

#define CODE_START 0x1000 // Guest代码起始地址

// 精简的16位实模式代码:打印"A",然后挂起

unsigned char guest_code[] = {

0xb8, 0x41, 0x00, // mov ax, 0x41 ; 'A'的ASCII码

0xb4, 0x0e, // mov ah, 0x0e ; BIOS teletype功能

0xcd, 0x10, // int 0x10 ; 调用BIOS显示服务

0xf4, // hlt ; 停机

0xeb, 0xfe // jmp $ ; 无限循环

};

int main() {

int kvm_fd, vm_fd, vcpu_fd, ret;

struct kvm_userspace_memory_region mem_region;

void *guest_memory;

printf("=== KVM最小化虚拟机Demo ===\n");

// 1. 打开/dev/kvm设备

kvm_fd = open("/dev/kvm", O_RDWR);

if (kvm_fd < 0) {

perror("打开/dev/kvm失败");

exit(1);

}

printf("✓ 打开/dev/kvm成功\n");

// 2. 创建虚拟机实例

vm_fd = ioctl(kvm_fd, KVM_CREATE_VM, 0);

if (vm_fd < 0) {

perror("创建虚拟机失败");

exit(1);

}

printf("✓ 创建虚拟机实例\n");

// 3. 为Guest分配内存(通过mmap映射)

guest_memory = mmap(NULL, MEM_SIZE,

PROT_READ | PROT_WRITE,

MAP_PRIVATE | MAP_ANONYMOUS | MAP_NORESERVE,

-1, 0);

if (guest_memory == MAP_FAILED) {

perror("分配Guest内存失败");

exit(1);

}

// 将Guest代码复制到Guest内存的0x1000位置

memcpy(guest_memory + CODE_START, guest_code, sizeof(guest_code));

// 4. 设置Guest内存区域

memset(&mem_region, 0, sizeof(mem_region));

mem_region.slot = 0; // 内存插槽编号

mem_region.guest_phys_addr = 0; // Guest物理起始地址

mem_region.memory_size = MEM_SIZE; // 内存大小

mem_region.userspace_addr = (unsigned long)guest_memory; // 主机用户空间地址

ret = ioctl(vm_fd, KVM_SET_USER_MEMORY_REGION, &mem_region);

if (ret < 0) {

perror("设置内存区域失败");

exit(1);

}

printf("✓ 设置Guest内存区域 (1MB)\n");

// 5. 创建虚拟CPU (vCPU)

vcpu_fd = ioctl(vm_fd, KVM_CREATE_VCPU, 0);

if (vcpu_fd < 0) {

perror("创建vCPU失败");

exit(1);

}

printf("✓ 创建虚拟CPU\n");

// 6. 获取vCPU的kvm_run结构大小并映射

int run_size = ioctl(kvm_fd, KVM_GET_VCPU_MMAP_SIZE, 0);

struct kvm_run *run = mmap(NULL, run_size,

PROT_READ | PROT_WRITE,

MAP_SHARED, vcpu_fd, 0);

if (run == MAP_FAILED) {

perror("映射kvm_run失败");

exit(1);

}

// 7. 设置vCPU的寄存器状态(16位实模式)

struct kvm_regs regs;

struct kvm_sregs sregs;

// 获取初始寄存器状态

ret = ioctl(vcpu_fd, KVM_GET_SREGS, &sregs);

if (ret < 0) {

perror("获取特殊寄存器失败");

exit(1);

}

// 设置段寄存器(实模式)

sregs.cs.selector = 0x0;

sregs.cs.base = 0x0;

sregs.ds.selector = 0x0;

sregs.ds.base = 0x0;

sregs.es.selector = 0x0;

sregs.es.base = 0x0;

sregs.fs.selector = 0x0;

sregs.fs.base = 0x0;

sregs.gs.selector = 0x0;

sregs.gs.base = 0x0;

sregs.ss.selector = 0x0;

sregs.ss.base = 0x0;

// 设置代码段为16位实模式

sregs.cs.base = 0;

sregs.cs.limit = 0xffff;

sregs.cs.selector = 0;

ret = ioctl(vcpu_fd, KVM_SET_SREGS, &sregs);

if (ret < 0) {

perror("设置特殊寄存器失败");

exit(1);

}

// 设置通用寄存器

memset(®s, 0, sizeof(regs));

regs.rip = CODE_START; // 指令指针指向Guest代码

regs.rflags = 0x2; // 设置标志寄存器(位1为1,其他为0)

ret = ioctl(vcpu_fd, KVM_SET_REGS, ®s);

if (ret < 0) {

perror("设置通用寄存器失败");

exit(1);

}

printf("✓ 设置vCPU寄存器状态 (实模式,RIP=0x%x)\n", CODE_START);

// 8. 运行虚拟机!

printf("--- 开始执行Guest代码 ---\n");

int run_ret;

while (1) {

// 切换到Guest执行

run_ret = ioctl(vcpu_fd, KVM_RUN, 0);

if (run_ret < 0) {

perror("KVM_RUN失败");

break;

}

// 检查退出原因

switch (run->exit_reason) {

case KVM_EXIT_HLT:

printf("✓ Guest执行了HLT指令,虚拟机正常停机\n");

goto exit_loop;

case KVM_EXIT_IO:

if (run->io.direction == KVM_EXIT_IO_OUT) {

// 处理Guest的IO输出(我们简单的打印字符)

char *data = ((char *)run) + run->io.data_offset;

printf("Guest输出: %c\n", data[0]);

}

break;

case KVM_EXIT_SHUTDOWN:

printf("虚拟机接收到关机信号\n");

goto exit_loop;

default:

printf("未知退出原因: %d\n", run->exit_reason);

goto exit_loop;

}

}

exit_loop:

printf("--- Guest执行结束 ---\n");

// 9. 清理资源

munmap(run, run_size);

munmap(guest_memory, MEM_SIZE);

close(vcpu_fd);

close(vm_fd);

close(kvm_fd);

return 0;

}

(1)关键步骤与QEMU实际实现的对应关系

| Demo中的步骤 |

QEMU中的对应实现 |

说明 |

open("/dev/kvm") |

kvm_init()函数 |

QEMU初始化KVM子系统 |

KVM_CREATE_VM |

kvm_create_vm() |

创建虚拟机上下文,每个QEMU进程对应一个VM |

mmap()分配内存 |

memory_region_init_*()系列函数 |

QEMU的内存管理更复杂,支持多种内存区域 |

KVM_SET_USER_MEMORY_REGION |

kvm_set_user_memory_region() |

注册Guest物理内存到KVM |

KVM_CREATE_VCPU |

kvm_init_vcpu() |

为每个虚拟CPU创建vCPU线程 |

KVM_GET_VCPU_MMAP_SIZE |

kvm_get_vcpu_mmap_size() |

获取共享的kvm_run结构大小 |

KVM_SET_SREGS/REGS |

kvm_arch_put_regs() |

设置初始寄存器状态(包括BIOS启动) |

KVM_RUN循环 |

kvm_cpu_exec()中的主循环 |

QEMU的vCPU线程在此循环中调度Guest执行 |

(2)真实QEMU与Demo的差异

- 复杂的内存管理:真实QEMU使用多级

MemoryRegion和AddressSpace来模拟复杂的内存拓扑。

- 设备模拟:QEMU为每个虚拟设备(磁盘、网卡等)注册IO监听器,处理Guest的MMIO/PIO访问。

- 多vCPU与中断:支持SMP、APIC、中断控制器等。

- 迁移与快照:完整的虚拟机状态保存/恢复机制。

- VirtIO集成:通过virtqueue实现高效的前后端通信。

这个Demo虽然简单,但完整展示了QEMU通过/dev/kvm接口将Guest代码从软件模拟转为硬件直接执行的核心路径。

4. KVM 的核心优化:内存虚拟化加速

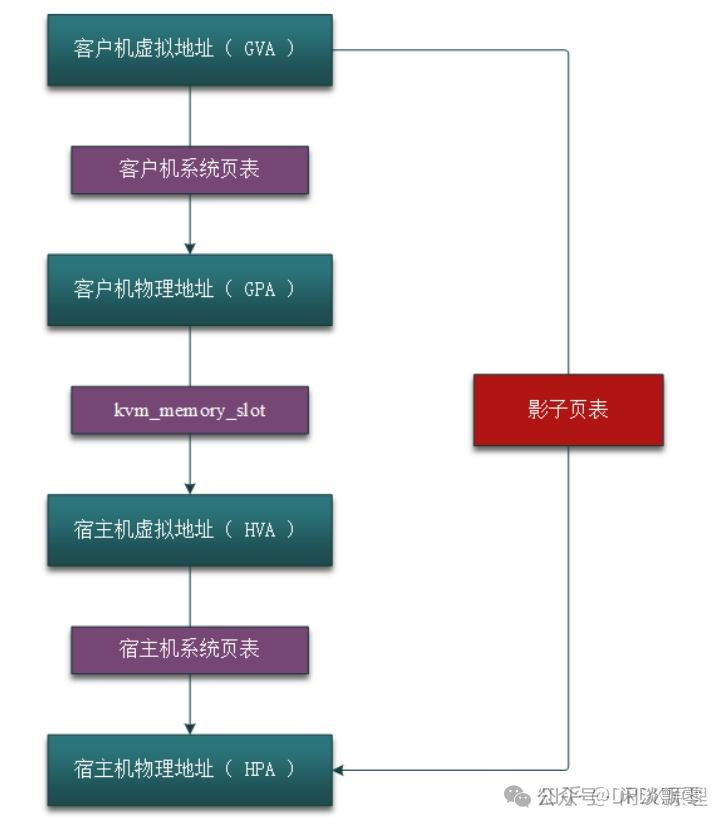

纯 QEMU 的内存访问需要经过 “Guest 虚拟地址→QEMU 模拟 MMU→Host 物理地址” 的多级翻译,开销巨大。KVM 通过硬件辅助内存虚拟化技术,优化了地址映射流程:

(1)传统内存虚拟化的痛点

在虚拟化环境中,内存寻址需要两次转换:首先将 Guest 的虚拟地址(GVA)转换成 Guest 的物理地址(GPA),然后将 GPA 转换成 Host 的物理地址(HPA)。

- • 软件实现的虚拟机内存寻址——影子页表:早期CPU不支持EPT时的方案,效率低下。

- • 硬件实现的虚拟机内存寻址——扩展页表(EPT):整个过程全部由硬件完成,效率极高。

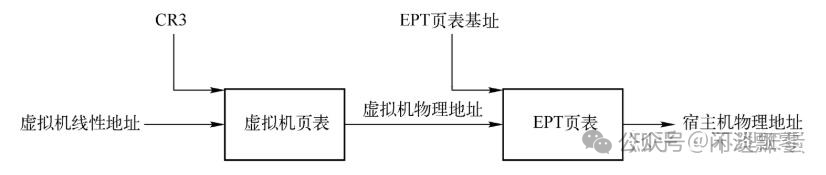

(2)KVM 的优化方案:EPT/NPT 技术

KVM 利用 CPU 的硬件辅助内存虚拟化技术(Intel EPT、AMD NPT、ARM Stage-2 MMU),将 “双重页表” 合并为 “单次硬件翻译”。下图是 EPT 的基本原理图示,EPT 在原有CR3页表地址映射的基础上,引入了 EPT 页表来实现另一层映射,这样,GVA->GPA->HPA 的两次地址转换都由硬件来完成。

这里举一个小例子来说明整个地址转换的过程。假设现在 Guest 中某个进程需要访问内存,CPU 首先会访问 Guest 中的 CR3 页表来完成 GVA 到 GPA 的转换。如果 GPA 不为空,则 CPU 接着通过 EPT 页表来实现 GPA 到 HPA 的转换(实际上,CPU 会首先查看硬件 EPT TLB 或者缓存,如果没有对应的转换,才会进一步查看 EPT 页表)。如果 HPA 为空,则 CPU 会抛出 EPT Violation 异常由 VMM 来处理。

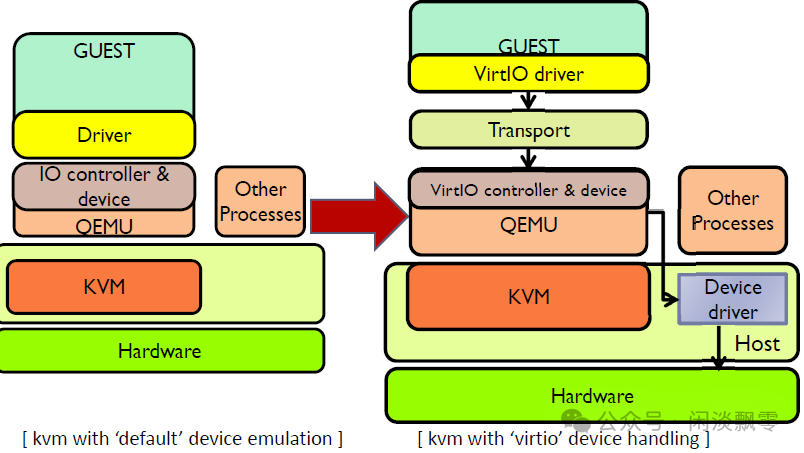

二、VirtIO:设备 I/O 虚拟化的 “性能桥梁”

1. 传统设备模拟的性能瓶颈

QEMU 纯软件模拟外设(如网卡、磁盘、CAN 控制器)时,存在两大性能问题:

- • VMEXIT 频繁:Guest 驱动的每一次寄存器读写、中断请求都会触发 VMEXIT,交给 QEMU 处理(例如发送一个网络包可能触发数十次 VMEXIT)。

- • 数据拷贝冗余:Guest 数据需要经过 “Guest 内存→QEMU 缓冲区→Host 设备缓冲区” 的多次拷贝(如 CAN 帧发送需 2-3 次拷贝),延迟高、吞吐量低。

这些问题导致纯 QEMU 的设备 I/O 性能仅为原生的 5%-20%,无法满足车载以太网、激光雷达等高速设备的传输需求。而 VirtIO 的核心思想是“半虚拟化”—— 通过 Guest 驱动与 QEMU 的协同设计,跳过冗余的硬件模拟步骤,直接高效交互。

2. 什么是 VirtIO?—— 标准化的半虚拟化驱动框架

VirtIO 是一套跨平台、标准化的半虚拟化设备接口规范(由 Linux 基金会维护),其核心是:

- • Guest 侧安装 “VirtIO 前端驱动”(如

virtio-net 网卡驱动、virtio-blk 块设备驱动),明确知道自己运行在虚拟化环境中。

- • QEMU 侧实现 “VirtIO 后端驱动”,直接与 Host 的硬件或内核子系统交互。

- • 前后端通过标准化的 “VirtQueue”(虚拟队列)传递数据,避免寄存器模拟和多次数据拷贝。

关键优势:

- • 标准化:支持多种 Guest 系统(Linux、QNX、AUTOSAR)和 Host 平台,车载场景中可无缝适配不同 ECU 的操作系统。

- • 低开销:VMEXIT 次数减少 90% 以上,数据拷贝从 3 次减少到 1 次(甚至零拷贝)。

- • 可扩展:支持网卡、块设备、串口、CAN 控制器等车载常用设备,且可自定义 VirtIO 设备(如车载激光雷达专用 VirtIO 设备)。这套标准化的虚拟化框架是现代云原生和基础设施的关键组件。

3. VirtIO 的核心架构:前端驱动→VirtQueue→后端驱动

VirtIO 的性能优势源于其精简的交互架构,核心组件包括:

(1)VirtIO 前端驱动(Guest 侧)

- • 运行在 Guest 内核中(如 Linux 内核的

drivers/net/virtio_net.c),对外提供标准的设备接口(如网卡的 struct net_device、块设备的 struct gendisk),让 Guest 应用无需修改即可使用。

- • 对内通过 “VirtIO 协议” 与后端通信,将设备请求(如发送网络包、读写磁盘)封装为 “描述符链”,放入 VirtQueue。

- • 支持中断合并、批量请求等优化,减少 VMEXIT 次数。

(2)VirtQueue(虚拟队列)

VirtIO 的核心数据结构,本质是一个环形缓冲区,用于前后端高效传递数据和请求,特点:

- • 共享内存:VirtQueue 所在的内存区域同时映射到 Guest 和 Host 的地址空间,前后端可直接访问,无需数据拷贝。

- • 描述符链:每个请求由多个描述符(

struct virtio_desc)组成,支持分散 - 聚集(scatter-gather)I/O,可直接处理 Guest 内存中的分散数据(如车载传感器的多段数据)。

- • 无锁设计:通过索引指针(

avail_idx、used_idx)实现前后端无锁访问,避免同步开销。

(3)VirtIO 后端驱动(QEMU 侧)

- • 运行在 QEMU 用户态(如

hw/net/virtio-net.c),监听 VirtQueue 中的请求。

- • 收到请求后,直接与 Host 的硬件或内核子系统交互(如通过

tap 设备发送网络包、通过 blkdev 读写磁盘)。

- • 处理完成后,将结果写入 VirtQueue 的 “已用区域”,并通过 KVM 触发 Guest 中断,通知 Guest 请求完成。

4. Demo:VirtIO-CAN虚拟总线实现

针对车载场景的 CAN 总线虚拟化需求,VirtIO 扩展了 virtio-can 设备类型,核心实现:

- • 前端驱动:Linux 内核的

drivers/net/can/virtio_can.c,提供标准的 CAN 总线接口(如 can_send、can_recv)。

- • 后端驱动:QEMU 的

hw/net/virtio-can.c,可对接 Host 的真实 CAN 卡(如 SocketCAN)或其他模拟 CAN 设备。

- • 优势:支持 CAN 2.0、CAN FD,传输延迟低至 10μs 级,满足车载实时通信需求。

Guest OS (虚拟机) QEMU (宿主机) 外部系统

┌──────────────┐ ┌─────────────┐ ┌────────────┐

│ virtio-can │ │ VirtIO-CAN │ │ SocketCAN │

│ 驱动 │◄─────────►│ 后端 │◄────────►│ vcan0 │

│ (前端) │ virtio │ (QEMU) │ socket │ 或真实CAN │

└──────────────┘ queue └─────────────┘ 接口 └────────────┘

(1)VirtIO-CAN数据结构定义

// virtio_can_demo.h - VirtIO-CAN协议定义

#ifndef VIRTIO_CAN_DEMO_H

#define VIRTIO_CAN_DEMO_H

#include <stdint.h>

#include <linux/can.h>

// VirtIO-CAN设备ID

#define VIRTIO_ID_CAN 28

// CAN队列类型

#define VIRTIO_CAN_QUEUE_TX 0 // 发送队列

#define VIRTIO_CAN_QUEUE_RX 1 // 接收队列

// CAN帧标志位

#define VIRTIO_CAN_F_RTR 0x01 // 远程传输请求

#define VIRTIO_CAN_F_ERR 0x02 // 错误帧

#define VIRTIO_CAN_F_EFD 0x04 // 扩展帧标识符

// VirtIO-CAN配置空间结构

struct virtio_can_config {

uint32_t bitrate; // 比特率 (kbps)

uint32_t bitrate_max; // 最大比特率

uint32_t bitrate_min; // 最小比特率

uint16_t max_filters; // 最大过滤器数量

uint8_t can_fd; // 支持CAN-FD

uint8_t reserved[5]; // 保留字段

};

// VirtIO-CAN帧结构(与Linux SocketCAN兼容)

struct virtio_can_frame {

uint32_t can_id; // CAN标识符 (标准/扩展)

uint8_t can_dlc; // 数据长度码

uint8_t flags; // 帧标志

uint8_t data[8]; // CAN数据

uint64_t timestamp; // 时间戳(纳秒)

};

// CAN过滤器结构

struct virtio_can_filter {

uint32_t can_id; // 过滤器标识符

uint32_t can_mask; // 过滤器掩码

};

#endif

(2)简化的VirtIO-CAN后端实现

// virtio_can_backend.c - QEMU中的VirtIO-CAN后端模拟

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <unistd.h>

#include <pthread.h>

#include <sys/socket.h>

#include <sys/ioctl.h>

#include <net/if.h>

#include <linux/can.h>

#include <linux/can/raw.h>

#include "virtio_can_demo.h"

// VirtIO队列结构(简化版)

struct virtio_queue {

int size;

int free_desc;

void **desc_buffers;

};

// VirtIO-CAN设备状态

struct virtio_can_device {

// VirtIO相关

struct virtio_can_config config;

struct virtio_queue tx_queue;

struct virtio_queue rx_queue;

// SocketCAN连接

int can_socket;

char can_iface[16];

// 线程控制

pthread_t rx_thread;

int running;

// 统计信息

uint64_t tx_frames;

uint64_t rx_frames;

uint64_t error_count;

};

// 创建CAN Socket连接

int create_can_socket(const char *ifname) {

int s;

struct sockaddr_can addr;

struct ifreq ifr;

printf("[QEMU] Creating CAN socket for interface: %s\n", ifname);

// 创建CAN原始套接字

if ((s = socket(PF_CAN, SOCK_RAW, CAN_RAW)) < 0) {

perror("socket");

return -1;

}

// 绑定到指定CAN接口

strcpy(ifr.ifr_name, ifname);

if (ioctl(s, SIOCGIFINDEX, &ifr) < 0) {

perror("ioctl");

close(s);

return -1;

}

addr.can_family = AF_CAN;

addr.can_ifindex = ifr.ifr_ifindex;

if (bind(s, (struct sockaddr *)&addr, sizeof(addr)) < 0) {

perror("bind");

close(s);

return -1;

}

printf("[QEMU] CAN socket created successfully\n");

return s;

}

// 接收线程函数:从真实CAN总线接收数据并放入VirtIO队列

void *can_receive_thread(void *arg) {

struct virtio_can_device *dev = (struct virtio_can_device *)arg;

struct can_frame frame;

int nbytes;

printf("[QEMU] CAN receive thread started\n");

while (dev->running) {

// 从SocketCAN读取CAN帧

nbytes = read(dev->can_socket, &frame, sizeof(struct can_frame));

if (nbytes < 0) {

usleep(1000); // 等待1ms避免忙等待

continue;

}

if (nbytes == sizeof(struct can_frame)) {

// 转换为VirtIO-CAN帧格式

struct virtio_can_frame vframe = {

.can_id = frame.can_id,

.can_dlc = frame.can_dlc,

.timestamp = 0 // 实际实现中应获取时间戳

};

memcpy(vframe.data, frame.data, frame.can_dlc);

// 查找可用的描述符

int desc_idx = -1;

for (int i = 0; i < dev->rx_queue.size; i++) {

if (dev->rx_queue.desc_buffers[i] != NULL) {

desc_idx = i;

break;

}

}

if (desc_idx >= 0) {

// 将帧数据复制到描述符缓冲区

memcpy(dev->rx_queue.desc_buffers[desc_idx],

&vframe, sizeof(struct virtio_can_frame));

dev->rx_queue.desc_buffers[desc_idx] = NULL;

dev->rx_queue.free_desc--;

// 发送中断通知Guest(模拟)

printf("[QEMU] Received CAN frame -> Guest (ID: 0x%X, DLC: %d)\n",

frame.can_id, frame.can_dlc);

dev->rx_frames++;

} else {

printf("[QEMU] Warning: RX queue full, dropping frame\n");

dev->error_count++;

}

}

}

printf("[QEMU] CAN receive thread stopped\n");

return NULL;

}

// 处理Guest发送的CAN帧

void process_tx_frame(struct virtio_can_device *dev,

struct virtio_can_frame *frame) {

struct can_frame raw_frame;

// 转换格式

raw_frame.can_id = frame->can_id;

raw_frame.can_dlc = frame->can_dlc;

memcpy(raw_frame.data, frame->data, frame->can_dlc);

// 发送到真实CAN总线

if (write(dev->can_socket, &raw_frame, sizeof(struct can_frame)) > 0) {

printf("[QEMU] Transmitted CAN frame <- Guest (ID: 0x%X, DLC: %d)\n",

raw_frame.can_id, raw_frame.can_dlc);

dev->tx_frames++;

} else {

printf("[QEMU] Error transmitting frame\n");

dev->error_count++;

}

}

// 模拟VirtIO设备配置

void configure_virtio_can(struct virtio_can_device *dev) {

// 设置默认配置

dev->config.bitrate = 500; // 500 kbps

dev->config.bitrate_max = 1000; // 1 Mbps

dev->config.bitrate_min = 10; // 10 kbps

dev->config.max_filters = 1024;

dev->config.can_fd = 0; // 默认不支持CAN-FD

printf("[QEMU] VirtIO-CAN configured: bitrate=%d kbps\n",

dev->config.bitrate);

}

// 初始化VirtIO队列

void init_virtio_queues(struct virtio_can_device *dev) {

// 初始化发送队列

dev->tx_queue.size = 64;

dev->tx_queue.free_desc = dev->tx_queue.size;

dev->tx_queue.desc_buffers = malloc(dev->tx_queue.size * sizeof(void *));

// 初始化接收队列

dev->rx_queue.size = 64;

dev->rx_queue.free_desc = dev->rx_queue.size;

dev->rx_queue.desc_buffers = malloc(dev->rx_queue.size * sizeof(void *));

printf("[QEMU] VirtIO queues initialized: TX=%d, RX=%d descriptors\n",

dev->tx_queue.size, dev->rx_queue.size);

}

// 启动VirtIO-CAN设备

void start_virtio_can_device(const char *can_iface) {

struct virtio_can_device dev = {0};

printf("=== Starting VirtIO-CAN Device Demo ===\n");

// 1. 配置VirtIO设备

configure_virtio_can(&dev);

strcpy(dev.can_iface, can_iface);

// 2. 初始化VirtIO队列

init_virtio_queues(&dev);

// 3. 连接真实CAN总线

dev.can_socket = create_can_socket(can_iface);

if (dev.can_socket < 0) {

fprintf(stderr, "Failed to create CAN socket\n");

return;

}

// 4. 启动接收线程

dev.running = 1;

if (pthread_create(&dev.rx_thread, NULL, can_receive_thread, &dev) != 0) {

fprintf(stderr, "Failed to create receive thread\n");

close(dev.can_socket);

return;

}

// 5. 主循环:模拟设备运行

printf("[QEMU] VirtIO-CAN device ready. Press Ctrl+C to stop.\n");

printf("[QEMU] Statistics: TX=%lu, RX=%lu, Errors=%lu\n",

dev.tx_frames, dev.rx_frames, dev.error_count);

// 模拟一些传输事件

sleep(2);

// 6. 清理

dev.running = 0;

pthread_join(dev.rx_thread, NULL);

close(dev.can_socket);

printf("[QEMU] VirtIO-CAN device stopped\n");

printf("[QEMU] Final statistics: TX=%lu, RX=%lu, Errors=%lu\n",

dev.tx_frames, dev.rx_frames, dev.error_count);

}

int main(int argc, char *argv[]) {

const char *can_iface = "vcan0";

if (argc > 1) {

can_iface = argv[1];

}

start_virtio_can_device(can_iface);

return 0;

}

(3)前端驱动模拟(Guest侧)

// virtio_can_frontend.c - Guest中的VirtIO-CAN前端驱动模拟

#include <stdio.h>

#include <string.h>

#include "virtio_can_demo.h"

// 模拟Guest内存中的VirtIO队列

struct guest_virtqueue {

struct virtio_can_frame *buffer;

int capacity;

int head;

int tail;

};

// 初始化前端驱动

void virtio_can_driver_init(void) {

printf("[Guest] VirtIO-CAN driver initializing...\n");

printf("[Guest] Reading device configuration...\n");

printf("[Guest] Setting up virtqueues (TX/RX)...\n");

printf("[Guest] Driver ready\n");

}

// 发送CAN帧

int virtio_can_send_frame(struct guest_virtqueue *tx_queue,

struct virtio_can_frame *frame) {

if (tx_queue->tail >= tx_queue->capacity) {

return -1; // 队列满

}

// 将帧复制到发送缓冲区

memcpy(&tx_queue->buffer[tx_queue->tail], frame,

sizeof(struct virtio_can_frame));

tx_queue->tail++;

// 通知设备(后端)有数据要发送

printf("[Guest] CAN frame queued for transmission (ID: 0x%X)\n",

frame->can_id);

return 0;

}

// 接收CAN帧

int virtio_can_receive_frame(struct guest_virtqueue *rx_queue,

struct virtio_can_frame *frame) {

if (rx_queue->head >= rx_queue->tail) {

return -1; // 队列空

}

// 从接收缓冲区读取帧

memcpy(frame, &rx_queue->buffer[rx_queue->head],

sizeof(struct virtio_can_frame));

rx_queue->head++;

printf("[Guest] CAN frame received (ID: 0x%X, DLC: %d)\n",

frame->can_id, frame->can_dlc);

return 0;

}

// 演示前端驱动的使用

void demo_frontend_driver(void) {

struct guest_virtqueue tx_queue, rx_queue;

struct virtio_can_frame tx_frame, rx_frame;

printf("\n=== Guest VirtIO-CAN Driver Demo ===\n");

// 初始化驱动

virtio_can_driver_init();

// 模拟发送几个CAN帧

printf("\n[Guest] Sending CAN frames:\n");

// 帧1:标准数据帧

tx_frame.can_id = 0x123;

tx_frame.can_dlc = 8;

memcpy(tx_frame.data, "HelloCAN", 8);

tx_frame.flags = 0;

virtio_can_send_frame(&tx_queue, &tx_frame);

// 帧2:扩展帧

tx_frame.can_id = 0x1FFFFFFF | (1 << 31); // 扩展帧标志

tx_frame.can_dlc = 4;

memcpy(tx_frame.data, "Test", 4);

tx_frame.flags = VIRTIO_CAN_F_EFD;

virtio_can_send_frame(&tx_queue, &tx_frame);

// 帧3:远程帧

tx_frame.can_id = 0x456;

tx_frame.can_dlc = 0;

tx_frame.flags = VIRTIO_CAN_F_RTR;

virtio_can_send_frame(&tx_queue, &tx_frame);

// 模拟接收CAN帧

printf("\n[Guest] Receiving CAN frames:\n");

for (int i = 0; i < 3; i++) {

if (virtio_can_receive_frame(&rx_queue, &rx_frame) == 0) {

printf(" Frame %d: ID=0x%08X, Data=", i+1, rx_frame.can_id);

for (int j = 0; j < rx_frame.can_dlc; j++) {

printf("%02X ", rx_frame.data[j]);

}

printf("\n");

}

}

}

(4)QEMU中VirtIO-CAN的实现架构

// 实际QEMU源码中的关键结构(简化)

// hw/net/virtio-can.c

typedef struct VirtIOCAN {

VirtIODevice parent_obj; // 继承VirtIO设备

VirtQueue *vq[2]; // TX和RX队列

// 后端连接

SocketCANState *can_backend; // SocketCAN后端

QEMUTimer *tx_timer; // 发送定时器

// 配置

struct virtio_can_config config; // 设备配置

uint32_t host_features; // 主机支持特性

uint32_t guest_features; // Guest协商特性

// 状态

uint32_t status; // 设备状态

bool peer_closed; // 对端关闭

} VirtIOCAN;

// QEMU类型系统注册

static const TypeInfo virtio_can_info = {

.name = TYPE_VIRTIO_CAN,

.parent = TYPE_VIRTIO_DEVICE,

.instance_size = sizeof(VirtIOCAN),

.class_init = virtio_can_class_init,

};

// 设备初始化

static void virtio_can_device_realize(DeviceState *dev, Error **errp) {

VirtIOCAN *vc = VIRTIO_CAN(dev);

VirtIODevice *vdev = VIRTIO_DEVICE(dev);

// 初始化VirtIO设备

virtio_init(vdev, "virtio-can", VIRTIO_ID_CAN,

sizeof(struct virtio_can_config));

// 创建virtqueue

vc->vq[VIRTIO_CAN_QUEUE_TX] = virtio_add_queue(vdev, 64,

virtio_can_handle_tx);

vc->vq[VIRTIO_CAN_QUEUE_RX] = virtio_add_queue(vdev, 64,

virtio_can_handle_rx);

// 连接SocketCAN后端

vc->can_backend = socket_can_create("vcan0");

// 设置设备特性

virtio_can_set_features(vdev, vc->host_features);

}

三、Linux 环境下 QEMU-KVM-VirtIO 协同工作流程

KVM 解决了 “指令执行” 和 “内存访问” 的性能瓶颈,VirtIO 解决了 “设备 I/O” 的性能瓶颈,三者协同形成了完整的高性能虚拟化方案。以下以 “车载 ARM 域控制器中,Guest 系统通过 VirtIO-CAN 发送 CAN 帧” 为例,拆解全流程协同逻辑:

1. 协同前提:初始化配置

- • QEMU 启动时,通过

-enable-kvm 参数加载 KVM 模块,创建 VM 和 VCPU。

- • QEMU 通过

-device virtio-can-pci,netdev=can0 配置 VirtIO-CAN 设备,初始化 VirtQueue(共享内存区域),并将 VirtQueue 映射到 Guest 和 Host 地址空间。

- • KVM 为 VM 配置 Stage-2 页表,将 Guest 的虚拟内存(包括 VirtQueue 地址)映射到 Host 物理内存。

- • Guest 系统启动后,加载

virtio_can 前端驱动,识别 VirtIO-CAN 设备,初始化 CAN 总线参数(如波特率 500kbps)。

2. 核心协同流程:CAN 帧发送全链路

(1)Guest 应用发起 CAN 帧发送

Guest 中的车载控制应用调用 CAN 驱动接口(如 can_send(fd, &frame, sizeof(frame))),请求发送 CAN 帧(ID=0x123,数据 = 0x010203)。

(2)VirtIO 前端驱动处理

- • 前端驱动将 CAN 帧数据封装为描述符链,放入 VirtQueue 的 “可用区域”。

- • 前端驱动调用

virtqueue_kick(vq),通过 KVM 的 KVM_IRQFD 接口触发 “轻量级通知”(无需 VMEXIT),告知 QEMU 有新请求。

(3)QEMU 后端驱动处理

- • QEMU 监听 VirtQueue 的

avail_idx 变化,发现新请求后,直接从共享内存的 VirtQueue 中读取描述符链和 CAN 帧数据。

- • QEMU 后端驱动将 CAN 帧数据通过 Host 的 SocketCAN 接口(如

can0)发送到真实 CAN 总线(或其他模拟设备)。

(4)处理结果反馈

- • CAN 帧发送完成后,QEMU 后端驱动将结果(发送成功)写入 VirtQueue 的 “已用区域”。

- • QEMU 通过 KVM 的

KVM_INTERRUPT 接口触发 Guest 的 CAN 接收中断。

- • KVM 将中断请求转发到 Guest 的 VCPU(Non-Root 模式),Guest 的

virtio_can 前端驱动执行中断服务程序(ISR)。

- • 前端驱动读取 VirtQueue 的 “已用区域”,确认发送成功,返回结果给 Guest 应用。

3. 协同优化关键点

- • 指令执行:Guest 应用、驱动的指令通过 KVM 直接在 ARM CPU 执行,无 TCG 翻译开销。

- • 内存访问:VirtQueue 共享内存通过 KVM 的 Stage-2 页表直接映射,CAN 帧数据无需拷贝,直接从 Guest 内存传递到 Host CAN 卡。

- • 设备 I/O:仅在 “触发中断” 时发生 1 次 VMEXIT,相比传统模拟设备(数十次 VMEXIT),开销大幅降低。

4. 性能对比:纯 QEMU vs QEMU-KVM-VirtIO

该对比验证了 KVM 与 VirtIO 的协同优化效果,使其能满足车载场景中实时通信和高吞吐量的需求。

| 性能指标 |

纯 QEMU(TCG 模式) |

QEMU-KVM-VirtIO |

提升幅度 |

| CAN 帧发送延迟 |

500μs-1ms |

10μs-50μs |

10-50 倍 |

| 每秒 CAN 帧吞吐量 |

1000-5000 帧 |

10 万 - 50 万帧 |

20-100 倍 |

| VMEXIT 次数(每帧) |

20-30 次 |

1-2 次 |

90%+ 减少 |

| CPU 占用率 |

80%-100% |

5%-15% |

80%+ 降低 |

四、QEMU 在其他宿主机环境的优化手段

除了 Linux 平台的 KVM+VirtIO 方案,QEMU 在其他宿主机环境也提供了针对性的性能优化手段,以适配不同车载部署场景:

1. 非 Linux 宿主机:Hyper-V(Windows)/Xen(类 Unix)

- • Hyper-V:QEMU 通过

hv_kvp、hv_balloon 等驱动与 Hyper-V 协同,利用 Hyper-V 的硬件辅助虚拟化(如 AMD-Vi/Intel VT-d)和合成设备(Synthetic Device),性能接近 KVM+VirtIO。

- • Xen:QEMU 作为 Xen 的 “设备模型守护进程”(qemu-dm),配合 Xen 的半虚拟化(PV)和硬件辅助虚拟化(HVM),通过 XenBus 与 Guest 前端驱动通信,优化设备 I/O 性能。

2. 无硬件虚拟化支持的场景:TCG 优化

对于无硬件虚拟化扩展的嵌入式设备(如老旧 ARM Cortex-A 系列),QEMU 通过 TCG 优化提升性能:

- • 指令块缓存优化:扩大 TCG 代码缓存(Code Cache)容量,减少重复翻译。

- • 超标量翻译:一次性翻译多个 Guest 指令为 Host 指令块,提升并行执行效率。

- • 架构专属优化:针对 ARM、RISC-V 等架构的指令集特性,优化 IR 生成和 Host 指令映射(如 ARM NEON 向量指令的批量翻译)。

3. 车载专用优化:实时性增强

针对车载实时系统(如 AUTOSAR RTOS),QEMU 提供实时性优化:

- • 中断延迟控制:通过

--enable-realtime 参数优化 KVM 的 VMEXIT/VMENTRY 调度,将中断延迟控制在 10μs 以内。

- • 时间同步:集成 PTP(精确时间协议),确保 Guest 与 Host 的时间同步,满足车载 CAN 总线的时序要求。

- • 资源隔离:通过 KVM 的 CPU 亲和性配置(taskset),将 VCPU 绑定到专属 Host CPU 核心,避免调度干扰。

五、总结:QEMU 性能优化的核心逻辑与车载启示

QEMU 从 10% 到 80%+ 的性能飞跃,本质是“硬件辅助虚拟化(KVM)解决核心计算瓶颈”与“半虚拟化设备(VirtIO)解决 I/O 瓶颈”的协同优化逻辑:

- • KVM 的核心价值在于 “让指令和内存访问回归硬件原生性能”,通过 VMX/SVM、EPT/Stage-2 MMU 等硬件技术,消除了软件模拟的冗余开销。

- • VirtIO 的核心价值在于 “让设备 I/O 跳过硬件模拟陷阱”,通过标准化的前后端驱动和共享内存队列,实现了高效数据传输。

- • 两者与 QEMU 的协同,既保留了 QEMU 强大的设备模拟能力和跨平台兼容性,又弥补了纯软件仿真的性能短板,为车载等高要求场景提供了可行的虚拟化解决方案。