Catai 是一个开源的、跨平台的本地 AI 助手平台,专为运行 GGUF 格式的大语言模型(LLMs)而设计。它提供了一个用户友好的 Web 聊天界面、强大的命令行工具(CLI)进行模型管理,以及灵活的 Node.js/TypeScript API,支持 Function Calling 和 JSON Schema Grammar 等高级功能,使开发者能够轻松地在本地构建高性能、注重隐私的 AI 应用。

在人工智能日益普及的今天,将大语言模型部署到本地设备,以实现数据隐私保护和低延迟交互,已成为开发者和企业关注的焦点。Catai 正是为此而生的开源项目,它基于强大的 Llama.cpp 和 Node-Llama-Cpp 生态,为用户提供了一套完整的 GGUF 模型本地运行、管理与开发方案。

Catai 旨在让您的 AI 助手完全在本地计算机上运行。

安装与启动

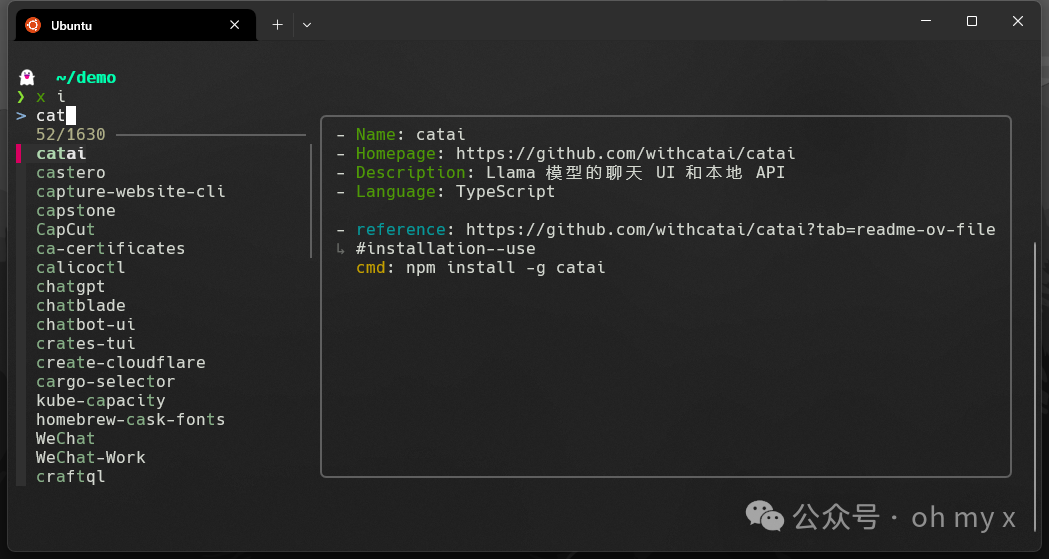

Catai 可通过包管理工具进行快速安装。

# 启用 install 模块的交互式 APP,install 可简写为 `ix i`

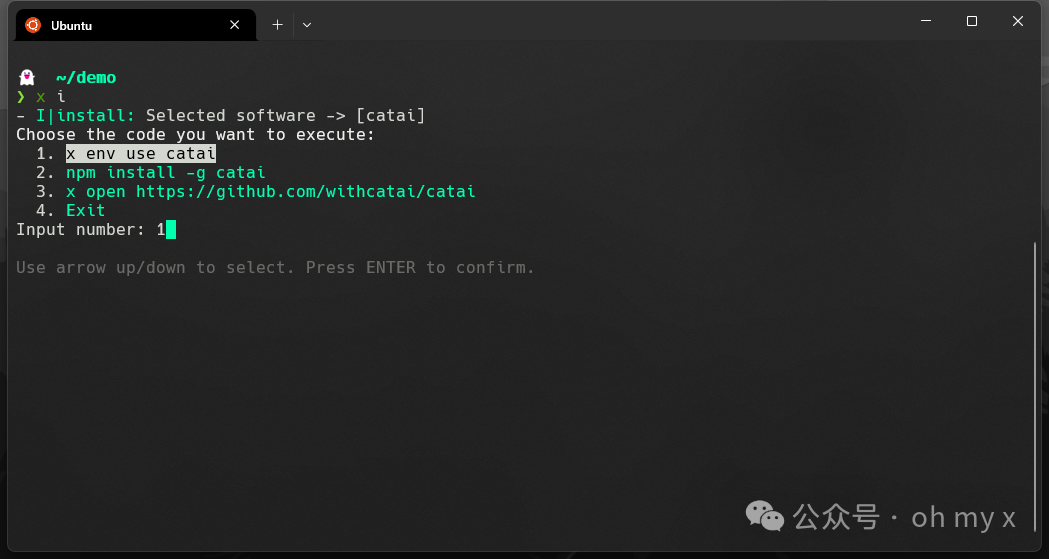

选定软件后,按下回车键将展示一系列操作选项。

本地化 AI 助手的基石

Catai 不仅仅是一个聊天界面,它是一个集模型管理、Web 服务和开发 API 于一体的综合性平台。它专注于 GGUF 格式的模型,这种格式因其高效的量化和跨平台兼容性,成为在消费级硬件上运行 LLMs 的主流选择。

通过 Catai,用户可以轻松地将大型模型部署到本地,并通过其提供的 Web UI 进行交互,享受实时、私密的 AI 体验。

核心功能与技术特点

Catai 在用户体验和开发者集成方面都提供了显著的优势。

1. 友好的 Web 聊天界面

Catai 提供了一个简洁高效的 Web 聊天用户界面(通过 catai serve 或 catai up 命令启动),具备以下关键特性:

- 实时文本流:响应内容实时生成,提供流畅的交互体验。

- 代码辅助与高亮:自动检测编程语言,并对代码块进行高亮显示,非常适合编程辅助场景。

- 消息追溯:用户可以点击用户图标查看原始消息,方便上下文管理。

2. 强大的命令行模型管理

Catai 提供了全面的 CLI 工具,极大地简化了 GGUF 模型的生命周期管理:

- 模型安装与管理:支持通过名称、URL 或本地路径安装任何 GGUF 模型。

- 模型切换与查看:快速设置当前使用的模型(

catai use)和查看已安装模型列表(catai models)。

- 跨平台兼容性:Catai 依赖于

node-llama-cpp,确保了在主流操作系统上的原生支持,包括 Windows (win32-x64-msvc)、Linux (x64, arm64, armv7l, ppc64le) 和 Mac (darwin-x64, darwin-arm64)。

3. 高级 LLM 开发能力

对于开发者而言,Catai 提供了强大的开发 API,将本地 LLM 的能力提升到了新的高度:

- Function Calling:允许模型决定何时调用外部工具或函数,是构建复杂 AI Agent 的关键能力。

- LlamaJsonSchemaGrammar:开发者可以定义严格的 JSON Schema,强制模型输出符合特定结构的数据格式,确保了输出的可靠性和可解析性。

- 低层级集成:开发者可以直接利用 Catai 提供的工具(如

downloadModel 和 initCatAILlama)与底层的 node-llama-cpp 进行集成,实现更精细的控制。

Catai 的核心优势

Catai 凭借其独特的设计,在本地 LLM 领域脱颖而出。

1. 极致的本地化与隐私保护

Catai 确保所有模型运行和数据处理都在本地完成,无需将敏感信息上传至云端。这对于注重数据安全和隐私的企业或个人用户来说,是不可替代的优势。

2. 高效的模型下载机制

为了解决 GGUF 模型文件体积庞大的问题,Catai 默认采用多线程下载技术。这显著提高了模型获取速度,优化了用户首次使用的体验。

3. 灵活的双重 API 接口

Catai 不仅提供了简单的 Web API 接口(通过 HTTP POST 请求),方便快速集成到任何语言的后端服务中;同时还提供了功能强大的 TypeScript/Node.js 开发 API,满足深度定制和高级功能开发的需求。

4. 简化 GGUF 生态的复杂性

GGUF 模型和 llama.cpp 的生态虽然强大,但配置和管理相对复杂。Catai 通过其 CLI 和封装的 API,将这些复杂性抽象化,让开发者能够专注于应用逻辑,而不是底层模型的加载和运行。

应用场景

Catai 的多功能性使其适用于多种场景。

1. 个人离线知识库与问答

用户可以下载专业领域的 GGUF 模型,在没有网络连接的环境下,进行文档总结、代码生成或专业知识问答,确保工作流程的连续性。

2. 本地 AI Agent 和工具链开发

开发者可以利用 Catai 的 Function Calling 和 JSON Schema Grammar 功能,在本地构建复杂的 AI Agent。例如,开发一个本地代码审查工具,要求模型以严格的 JSON 格式输出错误报告。

3. 嵌入式和边缘计算应用原型

由于 Catai 支持多种 Linux 和 ARM 架构,它可以作为在边缘设备或嵌入式系统中运行 LLM 应用的原型平台,利用本地算力提供智能服务。

4. 教学与研究环境

对于 AI 学习者和研究人员,Catai 提供了一个稳定、易于管理的本地环境,用于测试不同的 GGUF 模型、调整参数(如 topP 和 temperature)以及探索模型行为。

总结

Catai 是 Node.js 生态 与本地大模型技术栈之间一座高效的桥梁。它通过提供一站式的模型管理、用户友好的聊天界面和强大的开发 API,极大地降低了本地运行 GGUF 模型的门槛。无论是追求数据隐私的个人用户,还是希望在本地环境中构建高性能 AI 应用的开发者,Catai 都提供了一个可靠、灵活且功能强大的解决方案。随着 Function Calling 等前沿功能的不断完善,Catai 有望成为本地 LLM 应用开发领域的重要工具。

来源: https://github.com/withcatai/catai/blob/main/README.md