什么是 TensorFlow?

什么是 TensorFlow?

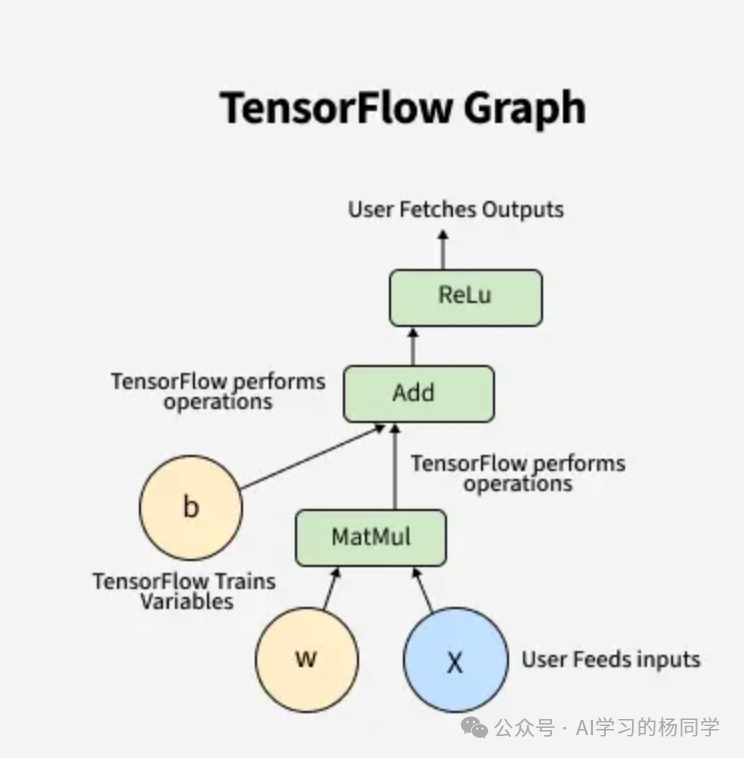

一句话讲清楚 TensorFlow 是 Google Brain 团队开发的深度学习框架,其核心设计基于计算图。它将复杂的数学运算表示为图中的节点,让数据(张量)在其中流动执行。这种设计支持从研究实验到大规模生产部署的完整链路。

- Tensor = 多维数组(数据)

- Flow = 数据在计算图中流动(执行)

本质上,你的代码定义了计算逻辑,TensorFlow 负责将其构建为计算图,并进行优化、自动求导,最终在CPU、GPU或TPU等多设备上高效执行。

核心基础概念:理解 TensorFlow 的工作方式

核心基础概念:理解 TensorFlow 的工作方式

-

张量(Tensor)

多维数组,是 TensorFlow 中承载数据的基本单位。

-

计算图(Computation Graph)

TensorFlow 早期版本(1.x)的执行核心。它将运算定义为图的节点,用边表示张量流,实现高效的静态优化与分布式执行。

-

Eager Execution(TF2 默认)

像普通 Python 代码一样即刻执行,无需先构建静态图,极大提升了调试的友好度。

-

自动求导(AutoGrad)

自动记录前向运算的轨迹,在训练时自动计算梯度并反向传播,这是现代深度学习框架的基石。

-

Keras(TF2 核心 API)

一个被 TensorFlow 完整集成的高级API,提供了统一、简洁的接口来构建和训练模型,大大降低了使用门槛。

TensorFlow 架构深度解析

TensorFlow 架构深度解析

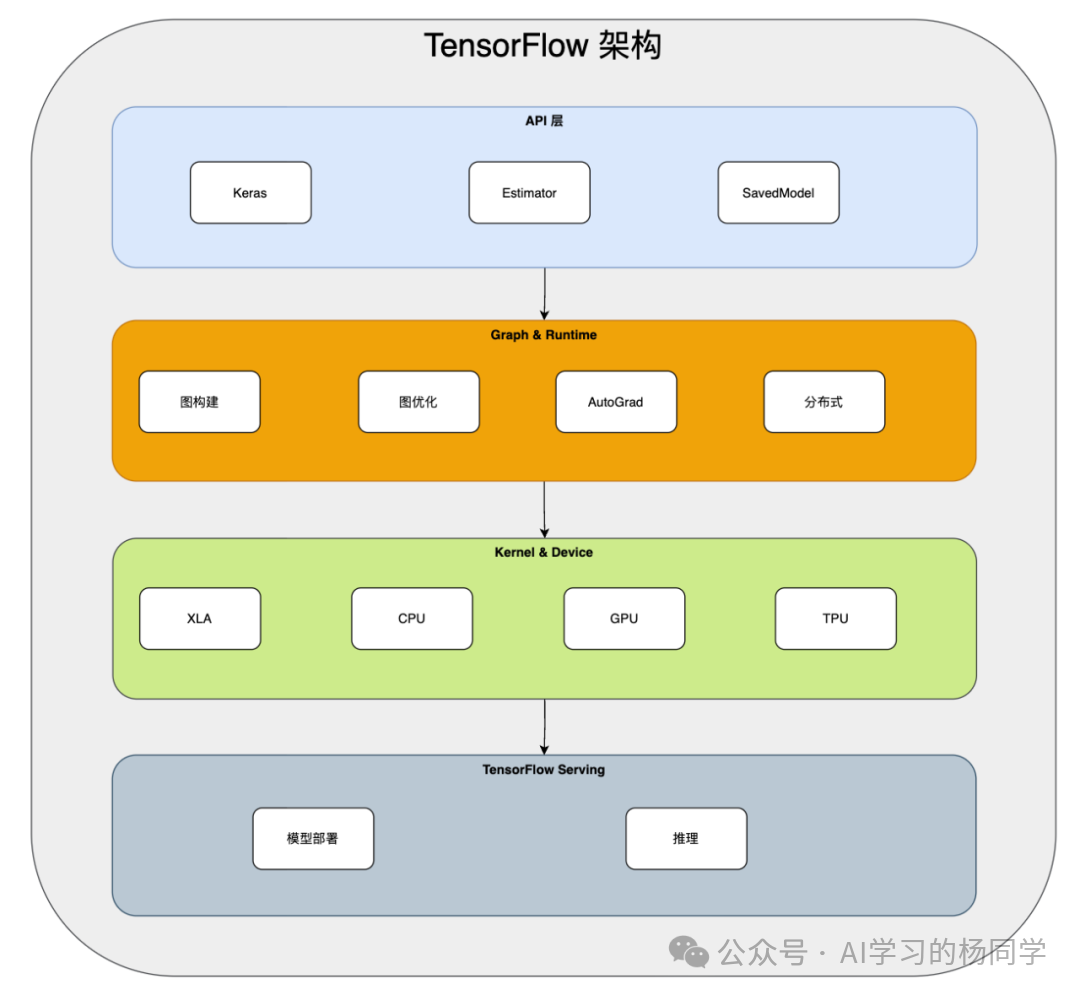

TensorFlow 的架构是分层的,从高层的易用API到底层的硬件执行,每一层都有明确的职责:

- API 层:提供

Keras、Estimator 等高级接口以及用于模型交换的 SavedModel 格式。

- Graph & Runtime 层:负责计算图的构建、优化、自动求导以及分布式执行策略。

- Kernel & Device 层:包含具体的运算内核(Kernel),并通过XLA编译器优化,调度到CPU、GPU或TPU等不同设备上执行。

- TensorFlow Serving:专为生产环境设计的模型部署与高性能推理系统。

TensorFlow Serving:工业级部署的核心

TensorFlow Serving:工业级部署的核心

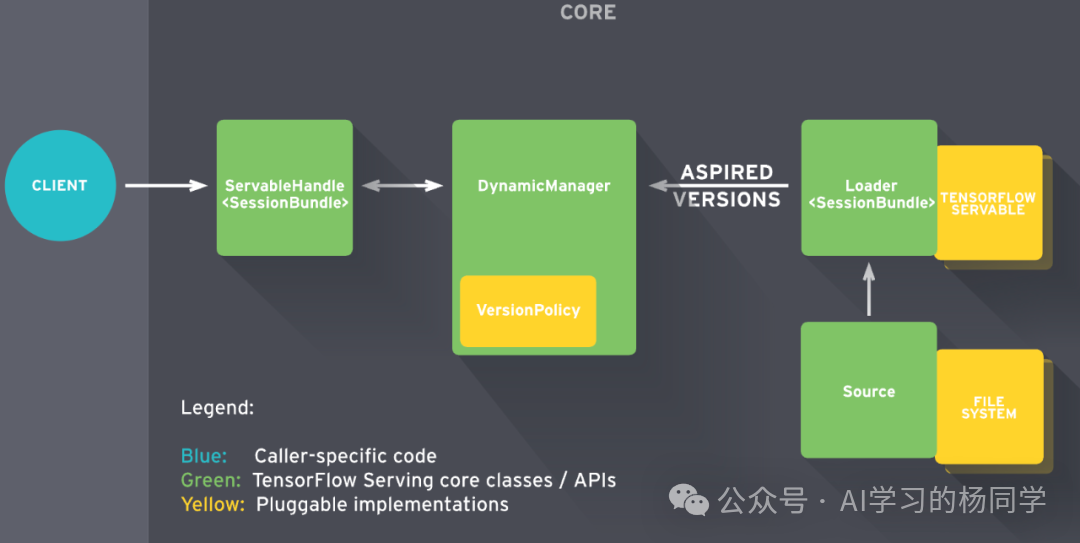

TensorFlow Serving 是模型从训练走向生产的关键组件,其架构设计围绕模型的动态管理与版本控制。上图清晰地展示了其核心流程:

角色区分:

- 蓝色:客户端(Client)调用代码。

- 绿色:TensorFlow Serving 的核心类与API,提供通用能力。

- 黄色:可插拔的实现组件,如文件系统、模型服务载体,保证了架构的灵活性。

核心流程:

- 模型来源(Source):从文件系统等存储源获取模型资源,并传递给加载器(Loader)。

- 版本管理:Loader 将模型封装为可服务的

TensorFlow Servable,并向动态管理器(DynamicManager)提供“期望版本(Aspired Versions)”列表。

- 策略控制:DynamicManager 根据预设的版本策略(VersionPolicy),决策模型的加载、热更新与下线。

- 服务响应:客户端请求通过 ServableHandle(内部封装了模型会话)最终抵达已加载的模型,完成推理并返回结果。

这种设计分离了通用逻辑与具体实现,使得 Serving 既能稳定服务,又能灵活适配不同的存储后端和模型格式,满足企业级部署的复杂需求。

TensorFlow 实战案例:MNIST手写数字识别

TensorFlow 实战案例:MNIST手写数字识别

一个完整的机器学习流程通常包含:加载数据 → 构建模型 → 训练 → 评估 → 导出模型。下面我们使用 Python 和 Keras API 来实现经典的MNIST手写数字识别任务。

import tensorflow as tf

from tensorflow.keras import layers, models

# Step 1:加载数据

(x_train, y_train), (x_test, y_test) = tf.keras.datasets.mnist.load_data()

# 归一化像素值到[0, 1]区间

x_train, x_test = x_train / 255.0, x_test / 255.0

# Step 2:定义模型

model = models.Sequential([

layers.Flatten(input_shape=(28, 28)), # 将28x28图像展平为784维向量

layers.Dense(128, activation='relu'), # 全连接层,128个神经元

layers.Dense(10, activation='softmax') # 输出层,10个类别(数字0-9)

])

# Step 3:编译模型

model.compile(

optimizer='adam', # 优化器

loss='sparse_categorical_crossentropy', # 损失函数

metrics=['accuracy'] # 评估指标

)

# Step 4:训练模型

model.fit(x_train, y_train, epochs=5, batch_size=32)

# Step 5:评估模型

loss, acc = model.evaluate(x_test, y_test)

print(f"Test accuracy: {acc:.4f}")

# Step 6:导出模型用于 Serving

model.save("saved_model/mnist")

TF1.x vs TF2.x 核心对比

TF1.x vs TF2.x 核心对比

TensorFlow 2.x 是对1.x版本的一次重大重构,旨在解决1.x版本难用、复杂的问题。

| 特性 |

TF1.x |

TF2.x |

| 执行模式 |

静态图,必须通过 Session 运行 |

默认启用 Eager Execution,即时执行 |

| API 整合 |

多套API(layers, estimator, slim)分散 |

API 完全统一到 Keras |

| 可读性 |

较低,代码冗长 |

极高,类似普通Python代码 |

| 新手友好度 |

困难 |

非常友好 |

| 图优化 |

需手动构建与管理 |

通过 AutoGraph 自动转换,兼顾易用与性能 |

一句话总结:TF2 = 易用性 + 强大性能,它已不再是那个令人望而生畏的“难用框架”。

PyTorch 是主流?TensorFlow 真的退出了吗?

PyTorch 是主流?TensorFlow 真的退出了吗?

这是业界常见的讨论与误解,我们需要客观看待两者的生态定位。

1. PyTorch 是学术研究的主流,但非工业部署的唯一选择

- PyTorch 优势:纯动态图(Eager-first),编码体验如同原生

Python,调试极其方便。因此,全球绝大多数前沿AI论文和开源项目(如OpenAI、Meta的研究)都采用PyTorch,使其成为学术圈的绝对主流。

2. TensorFlow 并未退出,而是战略聚焦于工程与部署

TensorFlow 在以下领域依然拥有强大甚至领先的生态:

- 大规模生产部署:

TensorFlow Serving 和 TFX 构成了目前最成熟的端到端机器学习工程平台之一。

- 移动与边缘端:

TensorFlow Lite 在移动端推理优化方面积累深厚,处于行业领先地位。

- Web端:

TensorFlow.js 让在浏览器中运行机器学习模型成为可能。

- 硬件支持:对谷歌自家TPU的原生支持最佳。

- 企业现有基建:大量企业已有的AI工程体系基于TensorFlow构建,迁移成本高。

| 3. 两者是分工而非简单的竞争关系 |

场景 |

最佳选择 |

| 科研、快速实验、论文复现 |

PyTorch |

| 大规模服务化部署、移动端应用 |

TensorFlow |

| 使用谷歌TPU |

TensorFlow |

| 构建完整MLOps流水线 |

TFX (基于TF) |

它们更像是“研究院”与“工程部”的关系,在各目的领域发挥所长。

4. 行业现状与未来展望

- 研究领域:PyTorch 占据主导地位。

- 工程与生产领域:TensorFlow 保持稳定,拥有不可替代的完整解决方案。

- 短期(2-3年):双框架共存格局将持续。

- 中长期:新兴框架如JAX正在崛起,但TensorFlow凭借其庞大的工业生态,不会轻易退出市场。

TensorFlow 技术路线图

TensorFlow 技术路线图

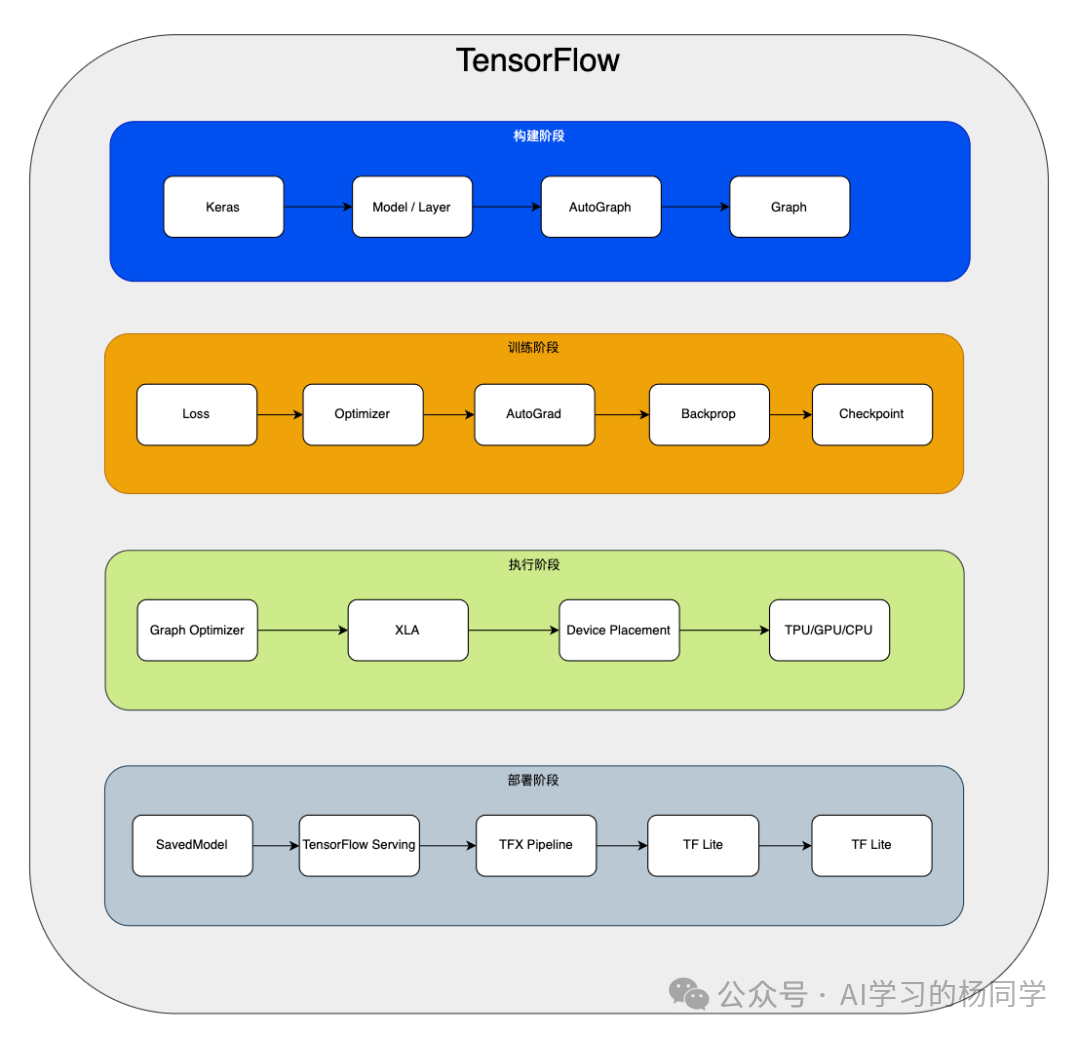

从模型构建到最终部署,TensorFlow 提供了一条完整的技术路径:

- 构建阶段:使用

Keras API定义模型和层,AutoGraph 自动将其转换为高效的计算图。

- 训练阶段:定义损失函数和优化器,

AutoGrad 负责自动求导和反向传播,并支持训练 checkpoint。

- 执行阶段:计算图经过优化(如

XLA 编译)、设备分配后,在TPU/GPU/CPU上执行。

- 部署阶段:模型以

SavedModel 格式导出,可通过 TensorFlow Serving 进行服务化,或转换为 TF Lite 部署到移动端,亦可通过 TF.js 在浏览器中运行。

核心要点总结

核心要点总结

- 定位清晰:TensorFlow 并未退场,其战略重心已明确转向“工程与生产部署第一框架”。

- 生态互补:PyTorch 因其灵活易用主导科研;TensorFlow 凭借完整工具链深耕工业落地,两者将长期共存。

- 版本革新:TF2.x 通过全面拥抱Eager Execution和Keras API,彻底解决了1.x版本的可用性问题。

- 生产标杆:在模型服务化(

Serving)、端到端流水线(TFX)、移动端(Lite)等生产环节,TensorFlow 生态依然是最成熟的选择之一。

- 核心能力:其基石在于计算图抽象、自动微分、跨平台设备调度以及全栈部署能力。