Letta Code 定位为一个 “Memory-First、Model-Agnostic 的 Agent Harness”。其核心目标是构建能够持续演进、具备长期记忆的编码智能体,并将其无缝集成到日常开发工作流中。它能够跨越不同会话记住代码库上下文、用户偏好以及历史交互记录,并借助“技能”与“子代理”机制实现工作的复用与并行化。

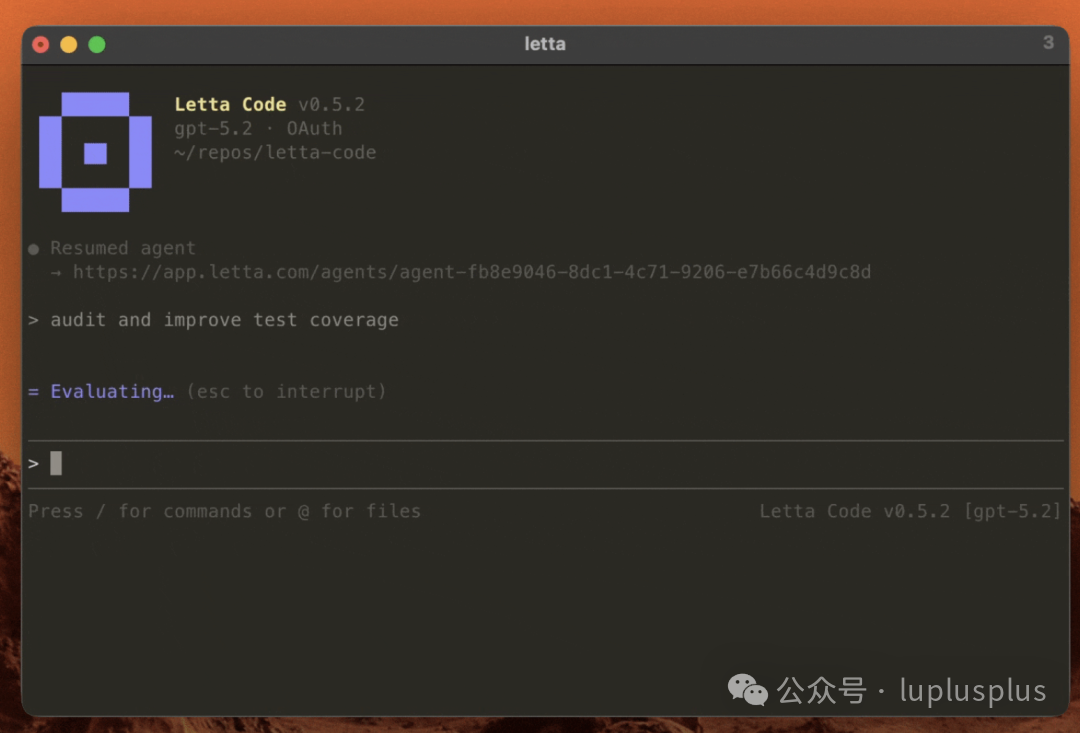

作为一款开源工具,Letta Code 能够与多种主流大语言模型(如 Claude、GPT、Gemini 等)协同工作,提供了从命令行界面到图形化代理开发环境的完整能力栈。

核心价值

- 长期记忆带来的连贯性:智能体可以持续学习并改进,积累项目特定的惯例与约定,显著降低每次任务开始时“重新熟悉项目”的上下文交换成本。

- 模型中立与可替换性:避免被单一模型供应商锁定,用户可以根据任务需求、成本预算或性能表现,灵活切换或试验不同的模型后端。

- 易于集成自动化流程:支持 CLI 和无头模式运行,便于嵌入自动化脚本、批处理任务或 CI/CD 流水线中,实现开发流程的智能化增强。

- 提供免费额度:其免费计划包含一定的 Claude API 调用额度,为开发者提供了实用的入门体验。

核心功能详解

-

分层记忆管理

通过 /init、/remember 等命令创建并维护结构化的记忆块,涵盖用户身份、代理角色、项目背景、团队约定等多个层级。支持快速初始化和深度研究两种模式,旨在将智能体培养成对特定代码库“了如指掌”的长期协作者。

-

模型无关与工具集切换

在启动时通过 --model 参数或在交互会话中使用 /model 命令即可切换底层模型。/toolset 命令允许用户切换不同的工具集(如 default/codex/gemini),方便在模型能力与使用成本之间进行权衡和实验。

-

技能抽象与复用

将常见的、可重复的操作(如代码审查、生成测试、编写文档等)抽象封装为“技能”。这些技能可以跨项目和会话进行迁移与应用,持续积累和扩展智能体的能力库。

-

子代理与后台进程

面对复杂任务时,可以将其拆解为多个可并行执行的子代理,提升效率。同时支持启动后台进程来维持需要长时间运行的任务流。

-

无头模式与自动化支持

使用 letta -p “你的指令” 进行一次性指令执行,并可输出 JSON 格式结果或流式响应。配合 --yolo、--permission-mode 等参数,可以精细控制代理的权限与行为模式,非常适合自动化场景。

-

以CLI为核心的开发者体验

通过 npm install -g @letta-ai/letta-code 即可快速安装使用。交互式命令以 / 开头,支持命令自动补全、快捷键操作和会话管理,符合开发者使用习惯。

产品定位与适用场景

相较于 Claude Code 等一次性会话编码助手,Letta Code 更强调 “开源可定制 + 状态化长期记忆 + 模型灵活替换”,其目标是成为一个 “随着使用频率增加而不断进化的工程伙伴”。这一特性在需要长期协作、深度积累代码库知识的团队环境中价值尤为突出。

目标用户群体包括:

- 中小型至大型工程团队,希望将 LLM 能力深度融入日常开发(如自动化生成文档、执行代码审查、编写修复补丁、生成单元测试等)。

- 对数据主权或审计合规有较高要求的企业或组织(可选择自托管部署方案)。

- 需要在不同模型的能力与成本之间进行动态平衡和实验的技术团队。

项目开源地址:https://github.com/letta-ai/letta-code |