服务一多,链路一长,线上问题排查就像大海捞针。日志分散在不同节点,调用关系全靠推测,这曾是许多开发者面临的困境。本文将分享在 easyms.golang 项目中,如何从零开始引入 OpenTelemetry 和 Jaeger,成功串联起 HTTP、gRPC、RabbitMQ 和 GORM,最终构建起清晰的分布式调用链。这是一次完整的技术落地实践复盘。

微服务时代的“迷雾”与“寻路”

随着 easyms.golang 微服务项目的服务数量不断增长,新的挑战也随之而来。当一个用户请求在多个服务间流转,涉及 HTTP、gRPC 调用、消息队列传递以及多次数据库操作时,一旦出现异常或性能瓶颈,如何快速准确地定位问题根源?

在单体架构中,查看日志或许就能定位问题。但在分布式系统中,面对散落在各个节点、时间戳可能不完全同步的日志,排查工作往往演变成一场耗时费力的“大海捞针”。我们迫切需要一种机制,能够将这些分散的足迹串联起来,形成一个完整的“故事线”。这,就是引入 分布式追踪 的核心驱动力。

技术选型:为何是 OpenTelemetry + Jaeger

在选择应用性能监控方案时,Jaeger 和 SkyWalking 都是常见的选择。但对于我们的 Go 技术栈项目,OpenTelemetry + Jaeger 的组合是更优解。它不仅让我们遵循了云原生的开放标准,避免了厂商锁定,还为未来的架构演进预留了空间——如果想切换到其他后端(如 Grafana Tempo),几乎无需修改业务代码,只需更换 Exporter 配置。

更重要的是,相比于一些一体化 APM 方案,OTel + Jaeger 的组合更符合项目已有的可观测性体系(例如,已经集成了 Prometheus 用于指标,Loki 用于日志)。这种“各司其职、协同工作”的模式,让整个可观测性体系更具弹性和扩展性。

实战演练:在 easyms.golang 中构建追踪体系

接下来,将以 easyms.golang 项目为例,详细解析如何一步步将 OpenTelemetry 集成到各个关键组件中。

第一步:奠定基础 - 追踪模块与配置

首先在 internal/shared/ 目录下创建了 tracing 包,作为 OpenTelemetry 的统一初始化入口。

1. tracing 模块 (internal/shared/tracing/tracing.go)

这个模块负责初始化 OTel 的 TracerProvider,并配置 OTLP HTTP Exporter 将追踪数据发送到 Jaeger。

package tracing

import (

"context"

"go.opentelemetry.io/otel"

"go.opentelemetry.io/otel/exporters/otlp/otlptrace/otlptracehttp"

"go.opentelemetry.io/otel/propagation"

"go.opentelemetry.io/otel/sdk/resource"

"go.opentelemetry.io/otel/sdk/trace"

semconv "go.opentelemetry.io/otel/semconv/v1.21.0"

)

// InitTracerProvider 初始化并注册 OpenTelemetry Tracer Provider。

func InitTracerProvider(serviceName, endpoint string) (func(context.Context) error, error) {

// 配置 OTLP HTTP Exporter,指向 Jaeger Collector

exporter, err := otlptracehttp.New(context.Background(), otlptracehttp.WithEndpoint(endpoint), otlptracehttp.WithInsecure())

if err != nil {

return nil, err

}

// 定义服务资源,用于在 Jaeger UI 中识别服务

res, err := resource.New(context.Background(),

resource.WithAttributes(semconv.ServiceNameKey.String(serviceName)),

)

if err != nil {

return nil, err

}

// 创建 TracerProvider,配置批量处理器和资源

tp := trace.NewTracerProvider(

trace.WithBatcher(exporter),

trace.WithResource(res),

)

// 设置全局 TracerProvider 和 W3C Trace Context 传播器

otel.SetTracerProvider(tp)

otel.SetTextMapPropagator(propagation.NewCompositeTextMapPropagator(propagation.TraceContext{}, propagation.Baggage{}))

return tp.Shutdown, nil // 返回 shutdown 函数,用于优雅关闭

}

2. 配置模型 (internal/shared/models/config.go)

为了灵活控制追踪的启用和配置,在 AppConfig 中增加了 TracingConfig。

package models

// ... 其他导入

// AppConfig 定义应用核心配置

type AppConfig struct {

// ... 其他配置

Tracing TracingConfig `yaml:"tracing,omitempty"` // 新增分布式追踪配置

}

// TracingConfig 定义分布式追踪配置

type TracingConfig struct {

Enable bool `yaml:"enable"`

Endpoint string `yaml:"endpoint"` // 例如: http://jaeger:14268/api/traces

}

3. 服务入口初始化 (internal/services/auth/cmd/authsvc/main.go)

在每个服务的 main.go 中,加载配置后,根据 TracingConfig 启用追踪。

package main

// ... 其他导入

import "easyms/internal/shared/tracing" // 引入 tracing 包

func main() {

// ... 配置加载逻辑

appConfig := config.GetAppConfig()

// ... 日志初始化

// 初始化分布式追踪系统

if appConfig.Tracing.Enable {

shutdown, err := tracing.InitTracerProvider(serverName, appConfig.Tracing.Endpoint)

if err != nil {

logger.Error(err, "Failed to initialize tracer provider", serverName)

} else {

defer shutdown(context.Background()) // 确保服务退出时刷新数据

}

}

// ... 其他服务启动逻辑

}

第二步:上下文传播 - 打通微服务间的调用链路

上下文传播是实现全链路追踪的关键,它确保 Trace ID 能在不同组件、不同服务间无缝传递。

1. HTTP 入口 (Gin 框架)

对于 Gin 框架,OpenTelemetry 提供了便捷的中间件 otelgin。

package main

// ... 其他导入

import "go.opentelemetry.io/contrib/instrumentation/github.com/gin-gonic/gin/otelgin" // 引入 otelgin

func main() {

// ...

g := gin.Default()

// 添加 OpenTelemetry Gin 中间件

if appConfig.Tracing.Enable {

g.Use(otelgin.Middleware(serverName))

}

// ...

}

2. gRPC 服务间调用

gRPC 的追踪通过 otelgrpc 库实现,利用 StatsHandler 机制。

package main

// ... 其他导入

import "go.opentelemetry.io/contrib/instrumentation/google.golang.org/grpc/otelgrpc" // 引入 otelgrpc

func main() {

// ... gRPC 服务端启动

go func() {

// ...

var s *grpc.Server

if appConfig.Tracing.Enable {

// gRPC 服务端 StatsHandler

s = grpc.NewServer(grpc.StatsHandler(otelgrpc.NewServerHandler()))

} else {

s = grpc.NewServer()

}

// ...

}()

// ... gRPC-Gateway 客户端调用

go func() {

// ...

var opts []grpc.DialOption

if appConfig.Tracing.Enable {

// gRPC 客户端 StatsHandler

opts = []grpc.DialOption{

grpc.WithTransportCredentials(insecure.NewCredentials()),

grpc.WithStatsHandler(otelgrpc.NewClientHandler()),

}

} else {

opts = []grpc.DialOption{grpc.WithTransportCredentials(insecure.NewCredentials())}

}

// ...

}()

}

3. 消息队列 (RabbitMQ) - 巧妙的适配

在消息队列中传递追踪上下文,需要将 Trace ID 注入到消息头。由于 amqp.Table 与 OTel TextMapCarrier 接口的期望类型不符,我们创建了一个自定义适配器 amqpHeadersCarrier。

// internal/shared/mq/rabbitmq.go

package mq

// ... 其他导入

import (

"go.opentelemetry.io/otel"

"go.opentelemetry.io/otel/propagation"

)

// amqpHeadersCarrier 实现了 propagation.TextMapCarrier 接口

type amqpHeadersCarrier map[string]interface{}

func (c amqpHeadersCarrier) Get(key string) string { /* ... */ }

func (c amqpHeadersCarrier) Set(key, value string) { c[key] = value }

func (c amqpHeadersCarrier) Keys() []string { /* ... */ }

// --- 发布端 (Publish 方法中) ---

func (p *RabbitMQPublisher) Publish(ctx context.Context, event Event) error {

// ...

if event.Headers == nil {

event.Headers = make(map[string]interface{})

}

// 使用自定义 carrier 注入追踪信息

otel.GetTextMapPropagator().Inject(ctx, amqpHeadersCarrier(event.Headers))

msg := amqp.Publishing{

// ...

Headers: amqp.Table(event.Headers), // 将 Headers 传递给 AMQP

}

// ...

}

// --- 消费端 (Consume 方法中) ---

func (c *RabbitMQConsumer) Consume(...) error {

// ...

go func() {

for d := range msgs {

// 使用自定义 carrier 从消息头提取追踪信息

propagator := otel.GetTextMapPropagator()

ctx := propagator.Extract(context.Background(), amqpHeadersCarrier(d.Headers))

// 将带有追踪信息的 ctx 传递给业务 handler

if err := handler(ctx, d.Body); err == nil { /* ... */ }

}

}()

// ...

}

4. 数据库操作 (GORM)

GORM 同样提供了 OpenTelemetry 插件,只需在初始化 gorm.DB 实例时注册即可。

// internal/shared/db/factory.go

package db

// ... 其他导入

import "gorm.io/plugin/opentelemetry/tracing" // 引入 GORM OTel 插件

// createGormDB 是一个辅助函数,用于创建和配置 gorm.DB 实例

func createGormDB(dialector gorm.Dialector, dbType string) (*gorm.DB, error) {

// ...

db, err := gorm.Open(dialector, config)

// ...

// 注册 OpenTelemetry 插件

if err := db.Use(tracing.NewPlugin()); err != nil {

return nil, err

}

return db, nil

}

一次有价值的重构:context.Context 的全面引入

为了让 GORM 插件能够从上下文中获取父 Span,对 db 包中的所有数据库操作接口和实现进行了全面重构,为其增加了 context.Context 参数。这虽然是一项涉及面广的工作,但它强制遵循了 Go 语言的并发最佳实践,确保了 Context 在整个调用栈中的正确传递,为未来的超时控制、取消操作等奠定了坚实基础。

第三步:本地验证 - 部署 Jaeger

在 docker-compose.yaml 中添加了 Jaeger 服务,并配置了各微服务指向 Jaeger 的 OTLP 收集器。

# deploy/docker/docker-compose.yaml

services:

# ... 其他服务

jaeger:

image: jaegertracing/all-in-one:latest

container_name: jaeger

ports:

- "16686:16686" # Jaeger UI 端口

- "14268:14268" # OTLP HTTP Collector 端口

networks:

- easy-network

environment:

- COLLECTOR_OTLP_ENABLED=true # 启用 OTLP 收集器

auth-svc:

# ...

environment:

- EASYMS_TRACING_ENABLE=true

- EASYMS_TRACING_ENDPOINT=http://jaeger:14268/api/traces

depends_on:

- jaeger # 确保 Jaeger 先启动

# ...

成果展示:系统运行状态的全局洞察

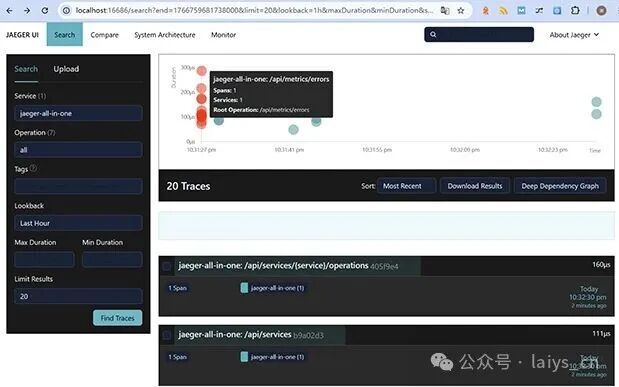

完成以上改造并启动整个环境后,访问 Jaeger UI (http://localhost:16686)。在服务列表中选择任意一个服务,点击“查找追踪”,即可看到清晰的调用链图。

图:Jaeger UI 界面,显示服务监控图表及追踪信息列表。

例如,一个从 API Gateway 发起,经过认证服务、消息队列,最终由订单服务处理的请求,其完整的生命周期、每个环节的耗时、服务间的依赖关系,都以直观的图形化方式呈现。这极大地提升了排查问题、分析性能瓶颈的效率。

我们能清晰地看到:

- 请求从哪个服务开始,经过了哪些服务。

- 每个服务内部执行了哪些操作(如 HTTP 处理、gRPC 调用、SQL 查询、消息发布/消费)。

- 每个操作的耗时,从而快速定位性能瓶颈。

- 服务间的错误传递,帮助追踪异常的源头。

总结与展望

通过这次实践,成功为 easyms.golang 项目集成了基于 OpenTelemetry 的全链路追踪能力。整个过程虽然涉及多处改造,但核心思路是清晰的:构建统一的 tracing 模块,并利用 OTel 社区丰富的生态对各组件进行“无侵入式”的埋点。

这次改造不仅解决了当下的排错痛点,更为未来的系统可观测性建设打下了坚实基础。接下来,还可以探索:

- 智能采样策略:在生产环境中,根据业务重要性或错误率动态调整追踪采样策略,平衡性能开销与数据覆盖。

- 业务上下文传递:利用 OpenTelemetry 的 Baggage 功能,在调用链中传递用户 ID、租户 ID 等业务信息,实现更精细化的业务追踪。

- 日志与追踪关联:在日志中自动注入 Trace ID 和 Span ID,并在 Grafana 等工具中实现从追踪到日志的无缝跳转,真正打通可观测性的三大支柱。

项目源码

本文所讨论的 easyms.golang 项目已开源:

欢迎访问 云栈社区 交流更多关于微服务架构与可观测性的实践经验。