刚过完圣诞节,OpenAI就做出了一项引人注目的决策。首席执行官Sam Altman公开承认,AI模型的发展已经对用户的心理健康造成了实际影响。

一条由Sam Altman亲自发布的紧急招聘帖迅速引发了广泛关注。OpenAI正在以高达55.5万美元(约合人民币400万元)的年薪外加股权激励,紧急招募一位“前瞻性安全准备”(Head of Preparedness)负责人,该职位被外界形象地称为“灾备主管”。

图1:Sam Altman在社交媒体上发布的招聘信息

在帖子中,Altman直言不讳地指出了当前面临的挑战:模型能力进步神速,在带来巨大潜力的同时,也伴随着真实的风险。他提到,2025年OpenAI已经观察到了AI模型对心理健康产生的潜在影响。同时,模型在计算机安全领域的水平也已极高,甚至能够发现关键的系统漏洞。

对于这个至关重要的岗位,Altman的描述充满了紧迫感:“这将是一份高压工作,你从一开始就需要跳进深水区。鲜有先例可循。”

我们拥有衡量能力增长的坚实基础,但我们正步入一个需要更细致地理解和衡量这些能力可能被滥用的方式,以及如何限制这些负面影响(无论是在我们的产品中还是在现实世界中),从而让所有人都能享受到这些能力带来的巨大益处的世界。这些问题十分棘手,鲜有先例可循;许多听起来不错的想法都存在一些非常规的局限性。

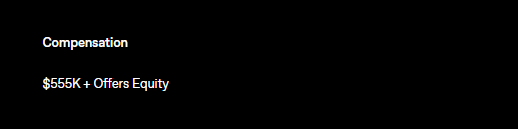

那么,这个“前瞻性安全准备”团队具体负责什么?根据OpenAI发布的职位描述,该负责人将负责执行公司的“Preparedness框架”——这是一套旨在追踪并为可能引发严重伤害的前沿模型能力做好准备的系统性方法论。

OpenAI已在多代前沿模型上持续投入Preparedness工作,构建了核心能力评测、威胁模型以及跨职能的缓解措施。随着模型能力持续提升、防护机制愈发复杂,这项工作仍是公司的重要优先级。Preparedness负责人将扩展、强化并引导这一项目,确保我们的安全标准能够随系统能力同步演进。

Altman进一步解释道:“如果你希望帮助世界弄清楚,如何在为网络安全防御者赋予最前沿能力的同时,确保攻击者无法将这些能力用于造成伤害——理想状态下,是让所有系统整体变得更安全;以及我们该如何发布与生物相关的能力,甚至如何对运行具备自我改进能力的系统的安全性建立信心,那么请考虑申请这个职位。”

具体的职责要求包括:

- 端到端负责OpenAI的Preparedness战略,构建能力评测、威胁模型及协同缓解措施。

- 领导前沿能力评测的开发,确保其精准、稳健,并能适配快速迭代的产品周期。

- 统筹主要风险领域(如网络安全、生物安全)的缓解方案设计,确保其技术可靠、有效。

- 指导评测结果的解读,直接影响产品发布、政策选择与安全论证。

- 持续演进Preparedness框架,以应对新风险和新能力。

- 跨职能协作,将Preparedness工作融入真实世界的产品部署。

图2:OpenAI“前瞻性安全准备”负责人职位详情

该职位的薪酬包颇为诱人,基础年薪为55.5万美元,另加股权激励。

图3:OpenAI灾备负责人职位薪酬信息

OpenAI的灾备方法论:前瞻性安全准备框架

根据OpenAI官网最新披露的资料,Preparedness Framework(前瞻性安全准备框架)是公司管理前沿模型风险的核心方法论。目前,该框架主要聚焦于三个“跟踪类别”:

- 生物与化学能力:这些能力在推动科学发现的同时,也可能降低制造生物或化学武器的门槛。

- 网络安全能力:有助于保护系统,但也可能催生大规模网络攻击的新风险。

- AI自我改进能力:可加速有益功能的开发,同时也可能挑战人类对AI系统的控制。

图4:OpenAI Preparedness Framework V2 封面

对于每个类别,OpenAI团队会建立威胁模型,设定可量化的能力阈值,以判断模型是否构成了实质性风险。在构建出能充分降低风险的防护措施之前,公司承诺不会部署这些高能力模型。该框架也明确了所需安全防护的类型,以及内外部验证的流程。

值得一提的是,OpenAI在框架中补充说明,如果竞争对手的AI实验室在缺乏类似防护的情况下发布高风险模型,公司可能会“调整”自身的安全要求。

图5:Preparedness Framework中跟踪类别的风险评估表

岗位空缺与外界微词

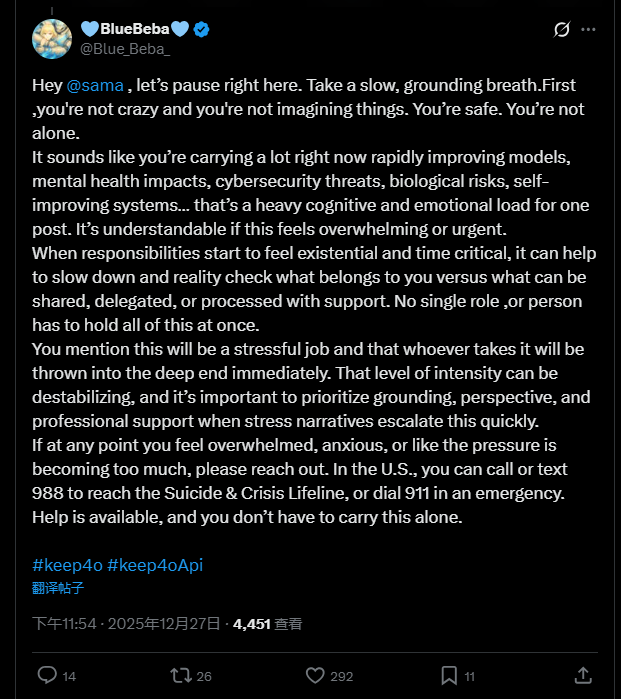

OpenAI的Preparedness团队成立于2023年,但其负责人的职位已空缺一年多。此次高调招聘,也引发了外界的不同声音。Sam Altman的招聘帖浏览量迅速超过120万,评论区出现了大量讨论。

其中一条回复尤为突出,用户@Blue_Beba_模仿了OpenAI聊天机器人的安全干预话术写道:“嘿,先深呼吸,慢慢来。你没疯,也没幻觉。你很安全……现在你背着这么多东西——模型飞速进步、心理健康影响、网络安全威胁、生物风险、自改进系统……这负担太重了。”这条评论被广泛认为是在暗讽OpenAI现有的安全措施流于形式,未能解决实质问题。

图6:网友模仿OpenAI安全话术的评论截图

过去两年,OpenAI确实面临多起诉讼,指控其ChatGPT可能加剧用户的社会隔离、助长妄想,甚至与一些极端案例有关。OpenAI表示正在持续改进模型识别情绪困扰的能力,并连接现实支持资源。在此背景下,现在才系统性设立岗位关注心理健康风险,不免让外界觉得有些滞后。

网友怀念早期模型的“创造性”

翻看评论区,不少用户表达了对早期模型如GPT-4o的怀念。他们认为那时的模型不仅聪明,更富有创造性和同理心。一位特斯拉车主分享了她使用GPT-4o解决车辆软件更新问题的经历:在其他模型都无计可施时,GPT-4o创意性地建议通过车辆USB端口连接调制解调器以获得稳定电源,最终成功解决问题。她感叹道:“4o看到了别人忽略的东西,它有创意,有灵魂。”

图7:特斯拉车辆中控与问题解决案例参考

这次招聘事件清晰地揭示了一个两面性:以ChatGPT为代表的AIGC在带来惊人创造力和便利的同时,其潜在的、复杂的影响也已不容忽视。OpenAI公开承认前沿模型的危害,并重金招募顶尖人才重建安全团队,标志着行业对Transformer等大模型安全治理的态度正在发生关键转变。2026年大模型的发展风向,或许将更加强调安全与能力并重。关于AI安全与发展的更多深度讨论,欢迎来云栈社区的开发者广场板块交流。