你有没有感觉,不管是 Claude Code、Cursor 还是其他 AI 编程工具,一开始用起来惊为天人,但聊久了就感觉它“变笨”了?理解力下降,甚至忘了最初简单的要求。

这很可能不是模型本身的问题,而是上下文(Context)被填满导致的性能衰减。掌握主动的上下文管理技巧,才能让这类工具长期保持高效。

图1:过多的文件和信息溢出屏幕,形象比喻了上下文过载的状态。

为什么上下文是稀缺资源?

Claude Code 默认模型的上下文窗口约为 20 万 token。听起来很多?实际上,系统自带的提示词、工具定义等就已占据了约 10% 的初始空间。

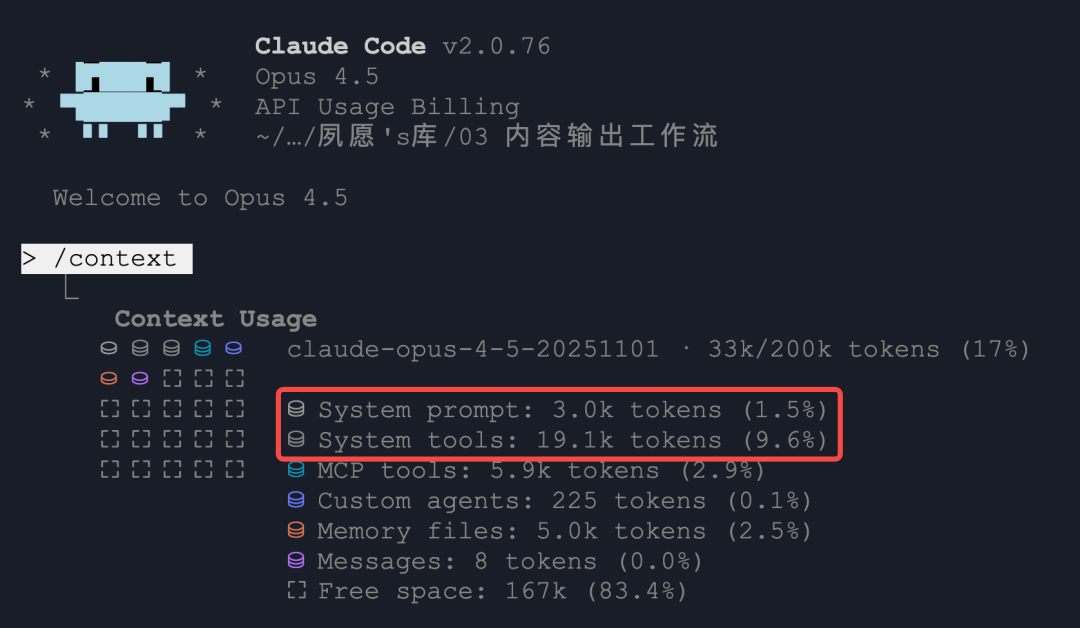

图2:Claude Code界面显示,系统提示和工具已消耗了可观的上下文token。

这意味着,还没开始你的任务,可用上下文就已经打了折扣。有人会说,不是有 100 万甚至更长上下文的模型吗?实测表明,超长上下文会带来处理效率下降,并且在超过一定阈值(如 20 万 token)后,模型的回答质量和逻辑连贯性会出现明显下滑。

因此,最稳妥的策略是:默认 Claude Code 只有 20 万有效上下文,并学会精打细算地使用它。

策略一:预防 - 从源头减少上下文消耗

1. 善用子 Agent (Sub-agent)

这是最高效的策略之一。想象一个场景:你让 Claude Code 调研一个大型项目目录。如果它在主对话中执行所有文件读取、代码搜索和分析,整个过程中的大量中间结果和代码片段都会挤占主对话的上下文。

图3:不同功能的子Agent可以像特派员一样,独立完成任务并返回结论。

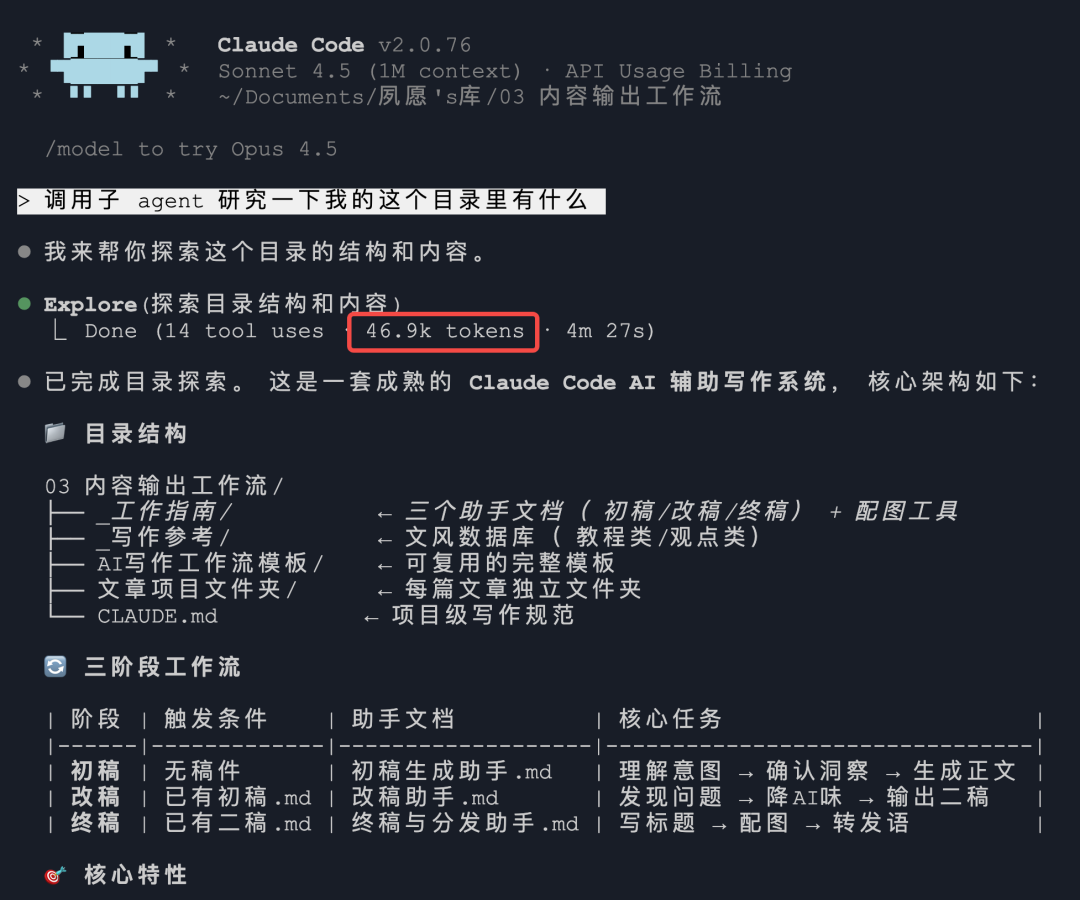

更好的做法是使用子 Agent。你可以将它理解为派出的“调研专员”。它在一个独立的会话中工作,完成任务后,只将精简的结论(如“这是一个XX项目,核心结构是YY,问题代码位于ZZ”)汇报给主对话。

图4:子Agent完成了目录探索,消耗了自身会话的token,但只将核心结论传回主对话,极大节省了主上下文。

这样一来,虽然子 Agent 自身可能消耗了数万 token 进行工作,但主对话的上下文只增加了很少的、有价值的信息。凡是“调研”、“搜索”、“阅读”性质的任务,都应尽量交给子 Agent 去完成。 这些任务的中间过程是“上下文垃圾”,不应污染主工作区。此外,子 Agent 支持并发,能进一步提升效率。

2. 约束 AI 的输出字数

在项目级的 CLAUDE.md 或对话开始时明确要求:“请用最精简的语言回复,聚焦核心答案,避免冗长解释。”

Claude 默认倾向于提供详细解释,这对于新手学习很有帮助。但如果你已经熟悉上下文,这些解释就成了无效负担。主动约束输出,能显著延长单次对话的有效寿命。

图5:主动“剪断”不必要的冗余输出,保持上下文简洁。

策略二:补救 - 上下文已冗长怎么办?

1. 多使用 ESC 回退,而非持续纠错

当你发现 Claude Code 写的代码有 Bug 时,如果上下文已较长,最佳做法不是将报错信息继续发给它让它调试。因为此时模型可能已处于“不聪明”的状态,继续对话容易陷入“bug 越改越多”的循环。

更有效的做法是:按 ESC 回退到修改前的状态,重新执行指令。 大模型输出具有随机性,上次可能走进了死胡同,重启一次或许就选择了正确的路径。回退后,你还可以在指令中补充:“刚才尝试了 XX 方案,遇到了 XX 问题,请避免此路径。” 相当于提前帮模型排雷。

图6:遇到死胡同时,及时回退并选择新路径,比在原地死磕更高效。

2. 谨慎使用 /compact 压缩命令

上下文接近满载时,你可能会想使用 /compact 命令进行压缩。但压缩后,模型对之前细节的记忆是模糊的。当它需要引用之前的具体代码或文档时,往往需要重新读取原始内容。

既然总要重新读,那么压缩生成的摘要本身在上下文中就成了新的“占位符”。此时,不如直接开启一个新的、纯净的对话窗口,将必要的核心信息(如当前代码状态、目标)重新传递过去,这样模型能处在更“清醒”的状态。

图7:与其费力压缩堆积的“垃圾”信息,不如换一个干净的“垃圾桶”(新对话)。

策略三:养成日常好习惯

一个窗口,专事专办

完成一个独立功能或修复一个 Bug 后,立即做两件事:

git commit,提交清晰的修改说明。- 关闭当前 Claude Code 窗口,为新任务开启一个全新的窗口。

切忌在同一个已冗长的对话中连续处理多个复杂任务。 上下文如同工作内存,保持窗口“新鲜”,就是保持模型“聪明”。

图8:像筛选文件一样,主动管理对话,保留精华,剔除冗余。

官方优化与主动管理的平衡

开发 Claude 的 Anthropic 公司当然也意识到了上下文管理的重要性,并做了一些自动化优化,例如:

- 自动“卸载”暂时不需要的已读文件。

- 在上下文过长时自动尝试压缩。

- Plan 模式中自动调用子 Agent 进行调研。

这些优化有效,但是被动的。等到系统自动触发压缩时,模型的性能可能已经受损一段时间了。因此,掌握并实践上述主动管理技巧,才能确保你手中的 Claude Code这类AI编程工具 始终处于最佳状态。

图9:将上下文管理的主动权握在自己手中,而非完全依赖自动化。

通过预防、补救和习惯养成三个层面的策略,你可以有效避免 AI 助手“越用越笨”的问题,让其持续成为高效的生产力伙伴。如果你有更多关于 AI 开发工具的使用心得,欢迎在 云栈社区 与广大开发者交流探讨。