以精准预测2008年次贷危机闻名的"大空头"迈克尔·伯里(Michael Burry)近期将矛头指向AI领域,重点关注AI芯片的折旧问题。伯里在社交媒体发文指出,部分超大规模算力服务商通过延长芯片折旧年限、压低折旧费用,人为放大AI热潮带来的账面利润,并将此称为"现代财报中最常见的欺诈之一"。

据其估算,2026年至2028年间,这种会计处理方式可能导致行业低估约1760亿美元的折旧支出。他特别点名甲骨文和Meta,预测到2028年两家公司的利润可能分别被高估27%和21%。

这一言论引发广泛关注,正值人工智能泡沫论甚嚣尘上之际,媒体、分析师和企业高管纷纷就芯片折旧及科技巨头资本支出问题发表看法。

那么,AI芯片的真实使用寿命究竟多长?芯片折旧是否会成为引爆AI泡沫的导火索?科技巨头是否存在为美化利润表而操纵财务数据的行为?这些问题的答案关乎万亿美元市场的走向。

01 芯片折旧期存在分歧

要理解这场争论,首先需明确折旧在AI数据中心语境下的含义及其对财务报表的影响。折旧是会计学中将固定资产成本分摊到预期使用寿命的做法。对于单价数万美元的AI芯片,企业不会在购入当年一次性计入成本,而是根据预估使用寿命逐年摊销。

使用寿命的设定具有显著财务杠杆效应。在总投入不变的情况下,折旧年限越长,每年分摊的折旧费用越低,当期净利润数据就越好看;反之,若缩短折旧年限,当期利润将承受巨大成本压力。

过去两年间,随着AI资本支出激增,全球科技巨头不约而同地延长了服务器资产使用寿命:

- 微软在2022年将服务器和网络设备使用寿命从四年延长至六年

- 谷歌在2023年将服务器折旧年限延长至六年

- 甲骨文在2024年将服务器使用寿命从五年延长至六年

- Meta今年一月宣布将服务器预计使用寿命从五年延长至五年半,并估算此项调整将使2025年折旧费用减少29亿美元,直接增加同等规模账面利润

不过巨头阵营中也出现异类。亚马逊曾在2024年将服务器使用寿命从五年延长至六年,但今年又将部分服务器设备使用年限从六年缩短至五年,公开承认原因是观察到"技术发展速度加快,特别是在人工智能和机器学习领域"。

然而在许多人看来,即使是缩短后的五年也显得过于乐观。分析显示,若五大云巨头的服务器在三年内而非各公司假设的年限内失去价值,它们的年度税前利润总和将减少260亿美元,相当于去年总利润的8%。按当前市值与税前利润之比计算,这将导致总价值缩水7800亿美元;若假设服务器折旧期为两年,缩水规模将升至1.6万亿美元。

核心问题在于:多少年的芯片折旧期才是合理的?

02 芯片实际寿命可能短于预期

认为算力服务商芯片折旧期估计过于乐观的观点基于以下几个因素:

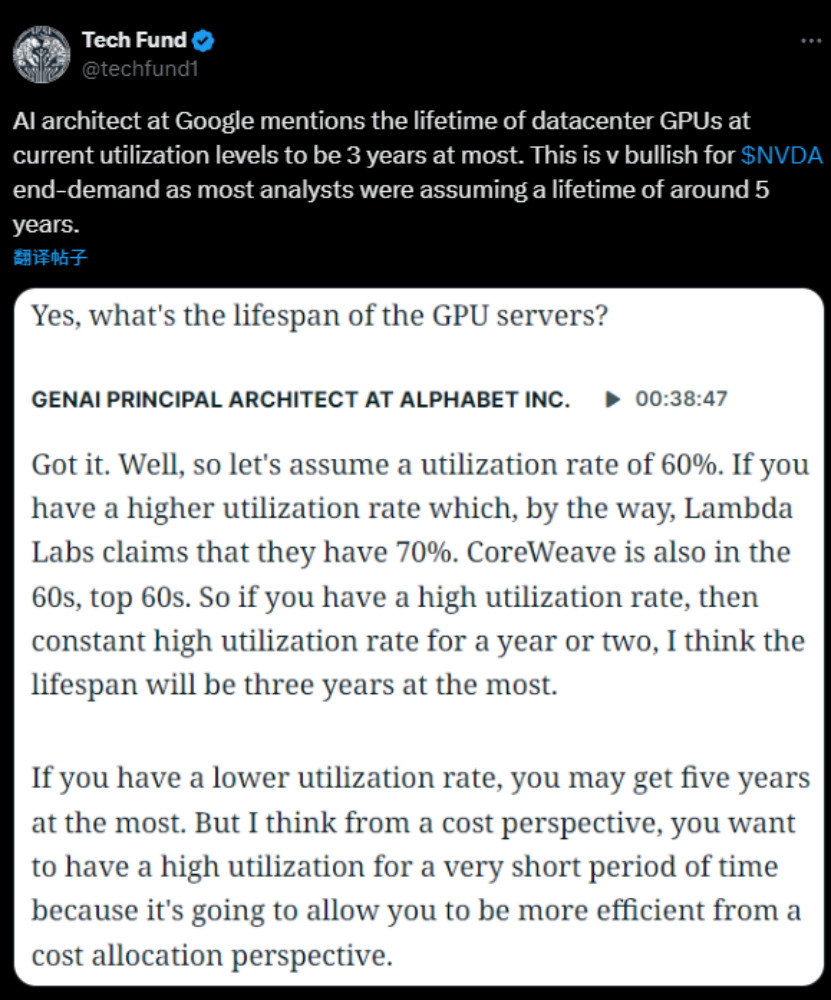

高强度物理损耗。据谷歌一位GenAI架构师透露,数据中心GPU承担了AI训练和推理的绝大部分负载,其性能下降速度远超其他组件。在云巨头数据中心常见的60%-70%高利用率下,GPU寿命可能被缩短至1-2年,最多不超过3年。

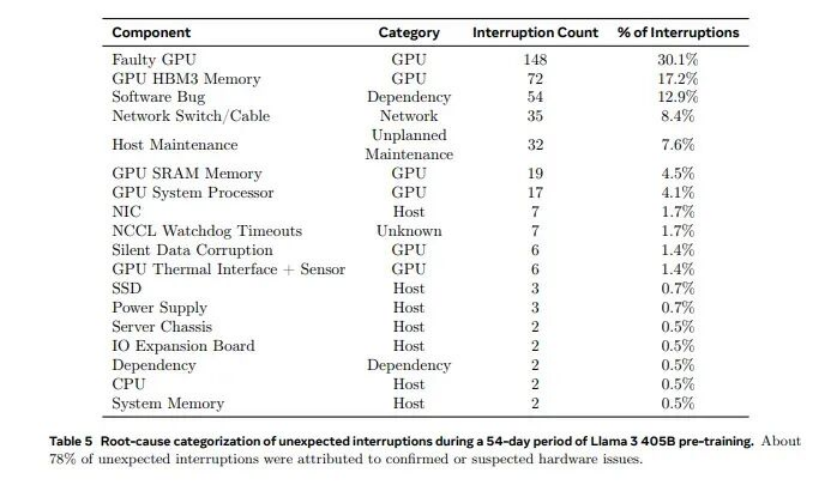

Meta公司研究数据侧面印证了这一观点。在描述使用Nvidia H100 GPU训练Llama 3模型时,Meta披露即使在约38%的利用率下,由GPU故障和HBM3高带宽内存故障导致的训练中断合计占总故障的47.3%。分析推论,若将利用率提升至行业常见的60%-70%,故障率可能显著增加。这表明在AI训练中至关重要的GPU组件同时也是最脆弱的,高强度训练会导致频繁的硬件不稳定和维护需求,大幅增加运维成本,降低资产有效产出率。

技术迭代加速。英伟达已将产品迭代周期从两年缩短至一年,CEO黄仁勋在今年3月发布Blackwell芯片时曾表示:"当Blackwell芯片开始量产时,Hopper芯片就无人问津了。"AI芯片生命周期更多由技术迭代而非物理损耗决定。

Groq公司CEO Jonathan Ross观点更为激进,表示该公司正采用1年期的芯片摊销,并直言那些采用3到5年摊销期的人"完全错了"。

经济寿命考量。在数据中心电力容量成为核心瓶颈的当下,"每瓦特Token产出"成为衡量资产价值的关键指标。以NVIDIA H100服务器为例的投资回报测算显示:搭载8卡H100的服务器在2023年算力紧缺时,租赁价格高昂,仅需十多个月即可收回成本;但随着2024年供给缓解和租赁价格下滑,按中期租价每卡1美元/小时计算,即使100%售出率下,5年总收入也无法覆盖设备购置和运维电力成本,最终导致亏损。

迈克尔·伯里也在社交平台指出:"A100每FLOP消耗的电力是H100的2-3倍,因此仅电力成本就比H100高2-3倍。而英伟达声称H100在推理方面的能效比Blackwell低25倍。"由于新一代芯片能效比显著提升,继续运行能效较低的旧芯片意味着占用宝贵的电力容量,产生巨大机会成本。这种能效比驱动的经济性淘汰可能导致企业在物理寿命结束前提前退役旧硬件。

03 价值级联与巨头支出合理性

另一方面,有分析认为科技巨头采用较长芯片折旧期具有合理性,核心论据是大型科技公司采用"价值级联"模式,不会简单淘汰过时芯片。

所谓"价值级联",指巨头利用工作负载多样性构建硬件梯级利用体系。AI工作负载分为对算力要求极高的训练和相对宽容的推理。训练下一代基础模型需要Blackwell等最新芯片,但进入推理阶段后需求发生分化:实时聊天机器人等延迟敏感型任务仍需较新硬件;而对实时性要求不高、成本敏感的吞吐量敏感型任务——如离线数据分析、文档摘要、内容审核等——老旧芯片提供极高性价比。完全折旧的A100虽然单次响应速度不如新一代芯片,但在处理大规模批处理作业时,其极低的总拥有成本使其极具竞争力。这种"新三年、旧三年"的级联模式从根本上拉长了硬件的经济寿命。

这一模式有历史数据支持。微软Azure的公开硬件退役政策显示,采用Nvidia K80、P100 GPU的虚拟机系列直到2023年才退役,实际服役时间达7-9年;计划于2025年退役的V100系列服役时间也接近7.5年。证明在拥有丰富应用场景的巨头内部,硬件生命周期可以超过技术迭代周期。

支撑这一长周期逻辑的不仅是技术可行性,还有财务上对产能的迫切需求。巨头们的巨额资本支出并非盲目投机,而是有强劲订单支撑。据统计,2022年二季度至2025年二季度的三年间,五大科技巨头的"剩余履约义务"增速达90.7%,超过同期资本支出约64%的增速,表明AI算力处于供不应求状态。

微软手握近4000亿美元积压订单,亚马逊AWS积压订单达2000亿美元。在履约压力下,巨头必须进行大量投资。乐观者认为,面对这种史无前例的资本支出高峰,采用更长折旧年限将巨额成本平滑到未来5-6年经营中,是避免当期利润产生灾难性波动、稳定投资者预期的合理财务策略。

04 结语

AI芯片折旧问题本质上是技术加速迭代与资产管理模式之间的错配。一方面,英伟达的1年迭代周期快速压缩前沿芯片性能寿命;另一方面,超大规模企业通过价值级联模式和爆棚订单需求,试图构建让芯片服役6-7年的经济闭环。

这两种逻辑的博弈意味着,评估AI巨头真实能力的指标不能再单纯依赖受会计估计影响显著的净利润。分析师建议应回归企业的经营性现金流本身。只有那些能够通过真实业务需求消化天量算力,并产生强劲现金流覆盖资本支出的企业,才能验证价值级联模式的有效性,最终穿越技术迭代周期。

无论如何,巨头间的算力竞赛已无法回头。马克·扎克伯格在Meta2025年三季度财报电话会中提到,最糟糕的情况不过是提前建设了未来几年所需资源。但与其受限于资本支出,让可盈利的核心业务无法投入,不如加快算力投资进程,确保公司拥有足够算力。

扎克伯格口中的"最糟糕的情况"究竟只是资源前置,还是如"大空头"所言足以席卷整个AI行业的风暴,时间将给出答案。