对于资深的系统运维人员而言,awk 堪称处理文本与日志数据最得心应手的工具,没有之一。

你是否也常常面临以下这些场景?

- 需要从几个GB的Nginx日志中迅速找出访问最频繁的IP地址。

- 必须统计服务器监控日志里CPU使用率超标的时段。

- 要从结构杂乱的应用日志中提取关键信息,并按照特定格式进行整理。

如果还在依赖 grep 命令逐行筛选,或是手动将日志导入 Excel 进行统计,那么掌握本文的内容将让你的工作效率获得数倍提升。

awk作为Linux系统自带的强大工具,无需安装任何额外依赖。它的魅力在于,往往只需一行命令,就能解决绝大多数文本处理需求。

本文将深入浅出地解析awk,每个核心概念和实战命令都配有详细解释,确保即使是初学者也能轻松理解并上手应用。

一、awk基础入门:快速理解核心概念

1. awk是什么?

awk本质上是一个流式文本处理工具,其工作原理可以简单概括为:

- 按行读取:逐行处理文本文件,内存占用极低。

- 字段分割:根据指定的分隔符,将每一行文本切割成若干个“字段”。

- 条件执行:对满足特定条件的行,执行预定义的动作,如打印、计算、统计等。

2. 核心语法(必须掌握)

awk [选项] ‘条件{动作}’ 文件名

- 选项:最常用的是

-F,用于指定字段分隔符(例如空格、冒号、制表符)。

- 条件:这是一个可选项。只有满足条件的行,才会执行后面的

{动作}。如果省略,则默认处理文件的所有行。

- 动作:对符合条件的行执行的操作,最基础也最常用的动作是

print(打印内容)。

3. 入门案例:解析 /etc/passwd 文件

/etc/passwd 是Linux系统中存储用户信息的基础文件,其每行格式固定,由冒号分隔,是练习awk的绝佳样本:

root:x:0:0:root:/root:/bin/bash

案例1:提取所有用户名(第1个字段)

# 命令

awk -F ‘:’ ‘{print $1}’ /etc/passwd

# 命令解释

# -F ‘:’ :指定字段分隔符为冒号,将每行切割成7个字段。

# $1 :代表当前行的第1个字段(即用户名)。$2代表第2个字段,以此类推。$0则代表整行内容。

# {print $1} :动作为打印第1个字段。

# 执行结果:将列出系统中所有的用户名,例如 root, bin, www 等。

案例2:仅显示 root 用户的完整信息

# 命令

awk -F ‘:’ ‘$1==“root”{print $0}’ /etc/passwd

# 命令解释

# $1==“root” :条件,判断第1个字段是否等于字符串 “root”。

# {print $0} :满足条件时,打印整行内容。

# 执行结果:仅输出 `root:x:0:0:root:/root:/bin/bash` 这一行。

案例3:找出UID小于100的系统用户

# 命令

awk -F ‘:’ ‘$3<100{print $1, $3}’ /etc/passwd

# 命令解释

# $3<100 :条件,判断第3个字段(用户UID)的值是否小于100(通常系统用户的UID小于100)。

# {print $1, $3} :打印用户名和其对应的UID,多个字段用逗号分隔,输出时默认以空格隔开。

# 执行结果:例如 root 0, bin 1, daemon 2 等。

4. 必须掌握的awk内置变量

记住以下几个内置变量,能让你的文本处理工作事半功倍:

| 变量 |

作用 |

简单示例 |

$0 |

代表整行内容 |

awk ‘{print $0}’ test.txt → 打印文件所有行 |

$n |

代表第 n 个字段 |

awk -F ‘:’ ‘{print $7}’ /etc/passwd → 打印所有用户的登录shell |

NR |

当前处理的行号 |

awk ‘NR==5{print $0}’ test.txt → 只打印第5行 |

NF |

当前行的字段总数 |

awk -F ‘:’ ‘{print NF}’ /etc/passwd → 每行输出 7 |

FS |

输入字段分隔符(等同 -F 选项) |

awk ‘BEGIN{FS=“:“}{print $1}’ /etc/passwd → 效果同 -F ‘:‘ |

OFS |

输出字段分隔符(print时字段间的分隔符) |

见下文进阶技巧 |

实用技巧:BEGIN{} 块中的内容会在处理文件之前执行,常用于设置分隔符、初始化变量等。

二、运维高频场景实战:命令详解与应用

以下案例均来源于生产环境中的常见需求,命令可直接复制使用,我们将对每个参数进行透彻解析。

场景1:Nginx访问日志分析(最常用)

标准的Nginx访问日志(/var/log/nginx/access.log)格式示例如下:

192.168.1.100 - - [07/Jan/2026:12:00:00 +0800] “GET /index.html HTTP/1.1” 200 1024

其默认空格分隔的字段对应关系为:

- 客户端 IP →

$1

- 空白占位符 →

$2

- 空白占位符 →

$3

- 访问时间戳 →

$4

- 请求方法+URL+协议 →

$7

- 状态码 →

$9

- 响应体大小 →

$10

需求1:统计访问量最高的前10个IP

# 命令

awk ‘{print $1}’ access.log | sort | uniq -c | sort -nr | head -10

# 命令逐层拆解

# 1. awk ‘{print $1}’ access.log → 提取日志中所有客户端IP(第1字段)。

# 2. sort → 对IP地址列表进行排序,为下一步去重统计做准备。

# 3. uniq -c → 统计每个唯一IP出现的次数(`-c` 参数表示计数)。

# 4. sort -nr → 按统计次数进行降序排序(`-n` 按数值大小,`-r` 反向即降序)。

# 5. head -10 → 仅显示排序结果的前10行。

# 执行结果:输出格式为 `访问次数 IP地址`,例如 `1200 192.168.1.100`。

需求2:快速定位所有404状态码的异常请求

# 命令

awk ‘$9==“404”{print $1, $7}’ access.log

# 命令拆解

# $9==“404” :条件,筛选出状态码(第9字段)等于404的行。

# {print $1, $7} :动作,打印出问题请求的客户端IP和请求的URL。

# 执行结果:例如 `192.168.1.200 /test.jpg`,表示该IP请求了一个不存在的资源。

需求3:统计最热门的访问URL(前5名)

# 命令

awk ‘{print $7}’ access.log | sort | uniq -c | sort -nr | head -5

# 命令拆解

# awk ‘{print $7}’ → 提取所有请求的URL路径(第7字段)。

# 后续的管道操作与需求1逻辑完全一致,实现对URL的排序、计数和取Top N。

# 执行结果:例如 `800 /index.html`,表示首页被访问了800次。

需求4:精确查看日志文件的第100至200行

# 命令

awk ‘NR>=100 && NR<=200{print $0}’ access.log

# 命令拆解

# NR>=100 && NR<=200 :组合条件,利用行号`NR`变量筛选行号在100到200之间(含)的行。

# {print $0} :打印这些行的完整内容。

# 使用场景:当需要分析日志文件中特定时间段或位置的记录时,比组合使用 `head` 和 `tail` 命令更为直观方便。

场景2:系统监控日志分析(筛选异常指标)

假设有一个系统监控日志 sys_monitor.log,其格式混合使用了空格和等号作为分隔符:

2026-01-07 12:00:00 host1 cpu=85 mem=60 disk=40

2026-01-07 12:01:00 host1 cpu=95 mem=70 disk=45

2026-01-07 12:02:00 host2 cpu=70 mem=50 disk=30

需求:筛选出CPU使用率超过90%的记录

# 命令

awk -F ‘[ =]+’ ‘$6>90{print $1, $2, $3, $6}’ sys_monitor.log

# 重点拆解

# -F ‘[ =]+’ :通过正则表达式指定分隔符为“一个或多个空格或等号”。`[ =]`匹配空格或等号,`+`表示一个或多个。

# 为何这样写?因为日志中`cpu=85`这类数据是由等号分隔的键值对,而整体字段间由空格分隔。

# 应用此分隔符后,示例行被切割为:$1=2026-01-07, $2=12:00:00, $3=host1, $4=cpu, $5=85, $6=mem...

# $6>90 :条件,判断第6个字段(即CPU使用率的数值)是否大于90。

# {print $1, $2, $3, $6} :动作,打印出时间、主机名和异常的CPU值。

# 执行结果:`2026-01-07 12:01:00 host1 95`

场景3:MySQL慢查询日志分析(定位性能瓶颈)

MySQL慢查询日志(slow_query.log)中,执行缓慢的SQL语句前会有一行元数据,包含 Query_time 字段:

# Time: 2026-01-07T12:00:00Z

# User@Host: root[root] @ localhost []

# Query_time: 5.20 Lock_time: 0.01 Rows_sent: 10 Rows_examined: 1000

SELECT * FROM user WHERE id=1;

需求:提取执行时间超过5秒的SQL语句及其耗时

# 命令

awk ‘/Query_time/ {time=$3; getline; if(time>5) print time, $0}’ slow_query.log

# 逐条拆解

# /Query_time/ :条件,使用正则匹配包含“Query_time”字符串的行(即记录执行时间的那一行)。

# time=$3 :将该行的第3个字段(即执行时间,如5.20)赋值给变量`time`。

# getline :awk内置命令,作用是读取输入文件的下一行内容(在这里就是具体的SQL语句行)。

# if(time>5) :判断变量`time`的值是否大于5。

# print time, $0 :如果条件满足,则打印执行时间和下一行(`$0`代表刚读入的整行,即SQL语句)。

# 执行结果:`5.20 SELECT * FROM user WHERE id=1;`

三、awk进阶技巧:提升效率的实用操作

技巧1:自定义输出格式(让结果更规整)

默认情况下,print 多个字段时以空格分隔。通过 OFS(Output Field Separator)变量可以自定义输出分隔符。

# 命令

awk -F ‘:’ ‘BEGIN{OFS=“|”} {print $1, $3, $7}’ /etc/passwd

# 拆解

# BEGIN{OFS=“|”} :在处理任何行之前,将输出字段分隔符设置为竖线 `|`。

# {print $1, $3, $7} :打印用户名、UID和登录shell。

# 执行结果:`root|0|/bin/bash`。这种格式非常便于直接导入Excel或数据库进行分析。

技巧2:实时统计总和与平均值

无需借助电子表格,awk可以轻松完成数值字段的聚合计算。例如,统计监控日志中所有记录的平均CPU使用率。

# 假设日志简化格式为:host1 cpu=85

# 命令

awk -F ‘[ =]+’ ‘{sum+=$5; count++} END{print “平均CPU:”, sum/count}’ sys_monitor.log

# 拆解

# {sum+=$5; count++} :对每一行,将CPU值(第5字段)累加到变量`sum`中,并将计数器`count`加1。

# END{} :在所有行处理完毕后,执行`END`块内的动作。

# print “平均CPU:”, sum/count :计算并打印总和除以计数,即平均值。

# 优势:对于大规模日志的统计计算,比人工处理快数个数量级。

技巧3:强大的组合技(awk管道协作)

awk本身功能强大,与 sort, uniq, grep 等命令结合,能应对更复杂的分析需求。

# 案例:统计Nginx日志中每种HTTP状态码的出现频次

awk ‘{print $9}’ access.log | sort | uniq -c

# 拆解

# awk ‘{print $9}’ → 提取所有状态码(第9字段)。

# sort → 将状态码排序,使相同状态码相邻。

# uniq -c → 统计每个唯一状态码出现的次数。

# 执行结果:`1200 200`(200状态码出现1200次),`50 404`(404状态码出现50次)。

四、生产环境实战:一键生成Nginx日志分析报告脚本

将以下代码保存为脚本,即可快速生成一份标准的Nginx访问日志分析报告,极大提升日常巡检效率。

1. 脚本代码 (nginx_log_analysis.sh)

#!/bin/bash

# Nginx 日志分析一键脚本

# 用法:./nginx_log_analysis.sh /var/log/nginx/access.log

# 第一步:判断用户是否传入了日志文件路径

LOG_FILE=$1

if [ -z “$LOG_FILE” ]; then

echo “❌ 用法错误!请输入日志文件路径”

echo “✅ 正确用法:./nginx_log_analysis.sh /var/log/nginx/access.log”

exit 1

fi

# 第二步:判断日志文件是否存在

if [ ! -f “$LOG_FILE” ]; then

echo “❌ 错误:文件 $LOG_FILE 不存在!”

exit 1

fi

# 第三步:开始分析日志,输出报告

echo -e “\n========== Nginx 日志分析报告 ==========\n”

echo “📌 访问量 TOP10 IP 排行”

awk ‘{print $1}’ “$LOG_FILE” | sort | uniq -c | sort -nr | head -10

echo -e “\n📌 404 异常请求 TOP20”

awk ‘$9==“404”{print $1, $7}’ “$LOG_FILE” | head -20

echo -e “\n📌 访问量 TOP10 URL 排行”

awk ‘{print $7}’ “$LOG_FILE” | sort | uniq -c | sort -nr | head -10

echo -e “\n📌 各状态码访问次数统计”

awk ‘{print $9}’ “$LOG_FILE” | sort | uniq -c | sort -nr

echo -e “\n========== 分析完成 ==========\n”

2. 脚本使用步骤

# 1. 创建脚本文件

vim nginx_log_analysis.sh

# 2. 将上方代码粘贴到文件中,保存并退出(在vim中按Esc键,输入 :wq 回车)

# 3. 赋予脚本执行权限

chmod +x nginx_log_analysis.sh

# 4. 运行脚本(请替换为你的实际日志路径)

./nginx_log_analysis.sh /var/log/nginx/access.log

3. 脚本执行效果

运行后,脚本会自动输出一份包含 TOP10访问IP、最新的20条404请求、TOP10访问URL以及所有状态码统计 的清晰报告,省去手动输入多条命令的繁琐。

五、常见问题与避坑指南

-

字段分隔符设置错误导致提取错位

- 问题:使用

awk -F ‘ ‘ 处理含有连续多个空格的日志行时,字段编号会与预期不符。

- 解决:使用

awk -F ‘[ ]+’ 来匹配一个或多个空格作为分隔符,或者直接省略 -F(awk默认会将连续空格视为一个分隔符)。

-

字符串比较时遗漏引号

- 问题:

awk -F ‘:’ $1=root{print $0} (root未加引号,会被识别为变量)。

- 解决:字符串比较必须使用双引号包裹:

$1==“root”。

-

处理超大日志文件时速度缓慢

- 原因:虽然awk逐行处理,但先通过条件过滤掉无关行,再进行后续统计,可以显著减少数据量。

- 优化:先筛选,后统计。例如

awk ‘$9==“404”{print $1}’ access.log | sort | uniq -c 比先提取所有IP再过滤404要高效。

六、总结

对于运维工程师而言,掌握awk并不需要学习复杂的编程语法。核心在于牢记 “分隔符、字段、条件、动作” 这四大要素,足以应对80%以上的日常文本处理需求。

- 应急故障排查:使用awk快速筛选和提取关键日志行。

- 日常数据统计:利用awk进行计数、求和、平均值计算,告别手动处理电子表格。

- 自动化脚本编写:将awk命令嵌入Shell脚本,实现日志分析的自动化与标准化。

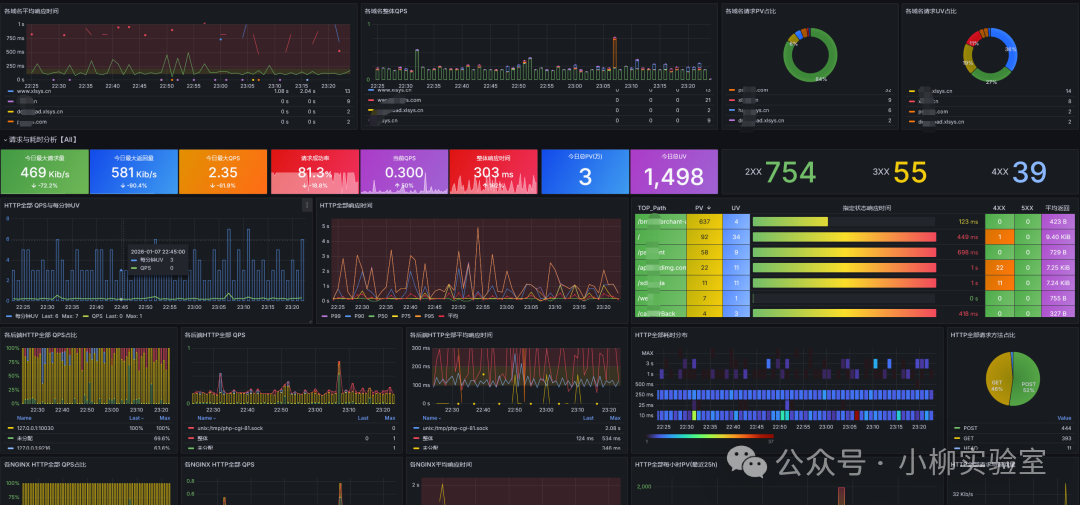

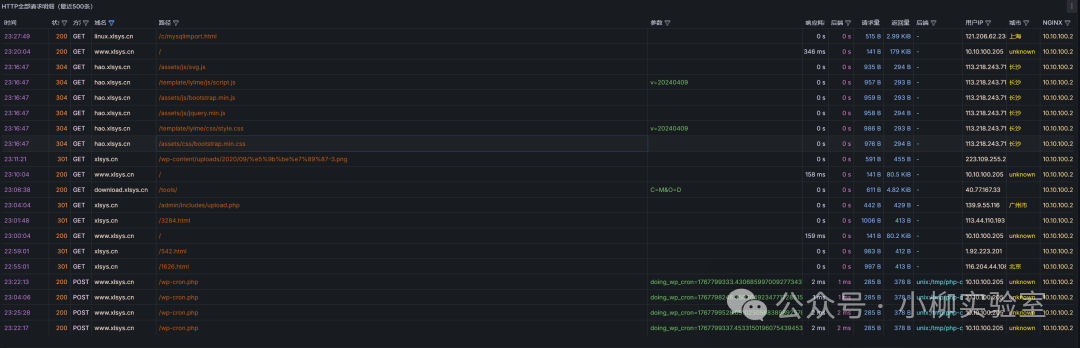

从今天开始,尝试在实际工作中运用上述命令,你将深刻体会到高效日志分析带来的便捷。当然,对于更复杂的集中化日志管理,搭建专业的日志服务器并在统一的仪表盘上进行可视化监控是更优的选择。

希望这篇详实的指南能帮助你彻底掌握awk这个利器。如果在学习或实践中遇到问题,欢迎在云栈社区的运维板块与广大开发者一同交流探讨。