很多人第一次接触 OpenCode ,都会有一种错觉:

“这不就是又一个AI写代码的工具吗?”

但真正用过之后,才会意识到一件事:OpenCode并不是在“帮你写代码”,而是在“重构你和代码的关系”。

过去我们写代码的流程是线性的:想清楚 → 写代码 → 运行 → 报错 → 查资料 → 改代码。

而OpenCode把这条直线,折叠成了一个 可对话、可回溯、可演化的闭环系统:

你不是一次性把需求“喂”给AI,而是让AI作为一个长期参与项目的协作者,理解你的代码历史、上下文决策和真实意图。

这意味着什么?

意味着你不再需要在每一次对话里重新解释项目背景;

意味着AI不只是生成代码片段,而是能参与重构、排错、设计权衡;

更意味着 AI编程开始从“即兴发挥”走向“工程协作”。

如果你已经厌倦了“写prompt—复制代码—祈祷能跑”的体验,

如果你开始关心:代码为什么这样写?未来还能怎么演进?

那么,OpenCode这套工具链,值得你认真看一眼。

接下来这篇文章,我们会从 它为什么诞生、和Claude/Cursor工具的本质差异、真实安装与使用方式、以及如何把它用到工程级水平 ,一步步拆开讲清楚。

01 OpenCode到底是什么?

先给结论,再讲细节:

OpenCode是一个100%开源、模型完全解耦的AI编程智能体系统。

https://github.com/anomalyco/opencode

它不仅仅是一个IDE,

也不仅仅能一键写代码。

它更像是:

一套把AI拉进工程体系里的基础设施。

这也是为什么,很多人会说它是:

开源版的Claude Code,但更工程化。

目前的数据也很说明问题:

- 4.6万Star

- 500+贡献者

- 每月约65万开发者在用

这不是一个“玩票项目”,

而是一个已经被真实工程场景反复打磨的系统,其背后的开源协作理念在开源实战板块有深入的探讨。

02 它为什么和Claude Code看起来像?

官方对自己的定位其实很坦率。

OpenCode和Claude Code的核心差异,不在“谁更聪明”,而在 控制权。

简单对比一下就很清楚:

- 完全开源

所有代码在GitHub,行为是可审计的

- 不绑定模型

Claude、GPT、Gemini、DeepSeek、本地模型都能用

75+ LLM provider,随时切换

- 工程优先,而不是产品优先

Prompt、Context、Agent都是可以配置、版本化的

一句话总结就是:

Claude Code更像一辆调校得很好的跑车

OpenCode更像一个你能自己改发动机的车库

03 OpenCode真正厉害的地方,不是“能写代码”

如果只看功能清单,OpenCode很容易被误解成“功能堆满”。

但真正拉开差距的,其实是下面这几件事。

1、LSP自动加载:AI真真能“看懂项目语言”

OpenCode内置了LSP(Language Server Protocol)支持。

| LSP Server |

Extensions |

Requirements |

| astro |

.astro |

Auto-installs for Astro projects |

| bash |

.sh, .bash, .zsh, .ksh |

Auto-installs bash-language-server |

| clangd |

.c, .cpp, .cc, .cxx, .c++, .h, .hpp, .hh, .hxx, .h++ |

Auto-installs for C/C++ projects |

| csharp |

.cs |

.NET SDK installed |

| clojure-lsp |

.clj, .cljs, .cljc, .edn |

clojure-lsp command available |

| dart |

.dart |

dart command available |

这意味着什么?

意味着它不是靠猜,而是:

- 知道你用的是哪种语言

- 知道这个项目的语法、类型、依赖关系

- 能像IDE一样理解代码结构

这是AI从“生成代码”,走向“理解代码”的关键一步。

2、Plan/Build 双模式:把“想清楚”前置

这是我个人认为 OpenCode最重要的设计。

它强制区分两种状态:

- Plan模式:

只分析、只拆解方案,不允许动代码

- Build模式:

按确认过的方案执行修改

这背后的工程直觉非常朴素:

大多数AI写烂的代码,

不是写错了,

而是一开始就理解错了。

Plan模式,本质上是把“需求评审 + 设计讨论”这一步,显性化了。

3、多Agent+多会话:AI开始像“团队”而不是“嘴炮”

在OpenCode里,你可以:

- 同一个项目,开多个会话

- 不同Agent各司其职

- 用

@general处理复杂搜索、跨文件分析

这不是噱头,而是 贴近真实工程分工 的设计。

04 安装与启动

1、一键安装(官方推荐)

curl -fsSL https://opencode.ai/install | bash

装完后直接:

opencode

就能启动。

2、各平台包管理器全覆盖

不想用脚本?也没问题:

# macOS / Linux

brew install opencode

# Windows

choco install opencode

scoop install extras/opencode

# Node

npm install -g opencode-ai

# Docker

docker run -it --rm ghcr.io/anomalyco/opencode

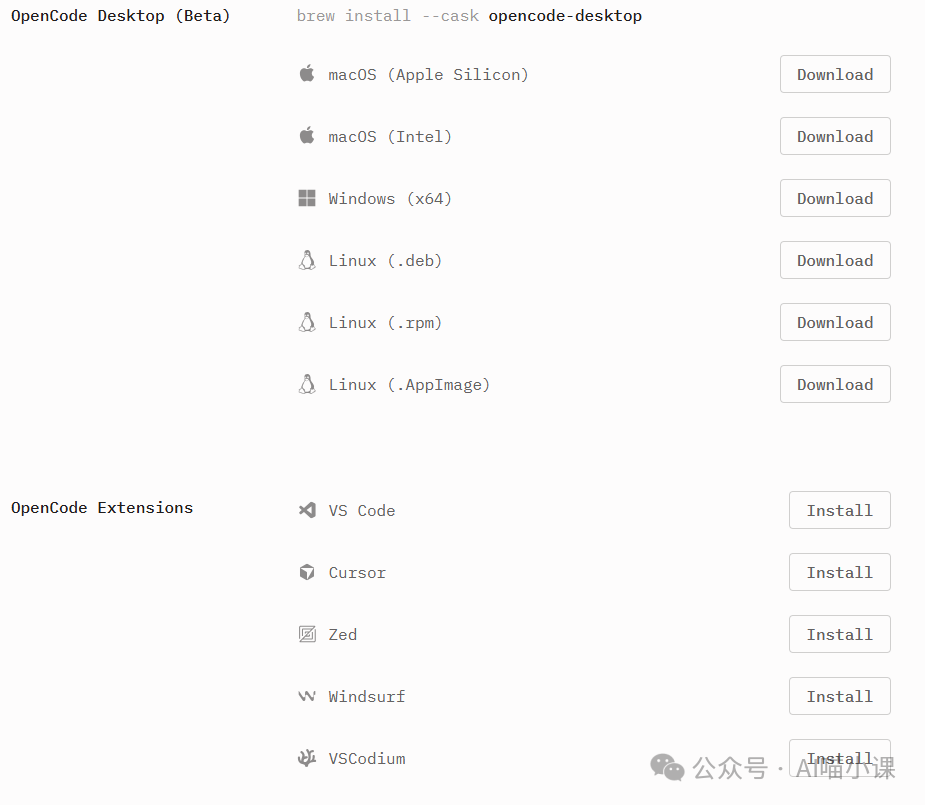

甚至还有桌面版(Beta)和IDE插件,

你可以完全按自己的习惯来。

https://opencode.ai/download

启动OpenCode:

进入你的项目目录:

cd your-project

opencode

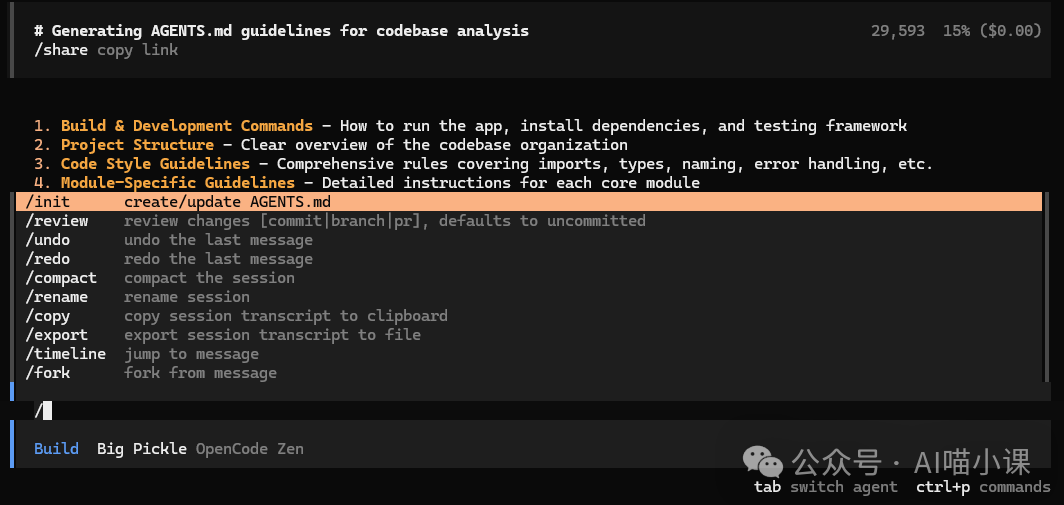

然后第一件事,不是写需求,而是:

/init

这个命令会生成一个 AGENTS.md 文件。

你可以把它理解成:

AI的项目入职手册

它会帮助OpenCode理解:

强烈建议commit到Git,

这是团队级使用的基础。这份文档的撰写原则和最佳实践,可以参考我们整理的技术文档规范。

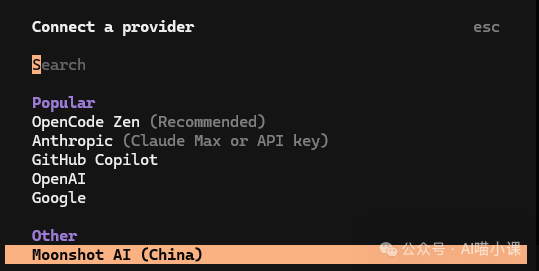

05 模型配置

OpenCode支持的模型提供商很多:

- OpenAI

- Anthropic

- Gemini

- DeepSeek

- Ollama/LM Studio/llama.cpp

- Groq/Together/Fireworks/OpenRouter

- ……

配置方式也极简单:

/connect

按提示选provider,填API Key即可。

Key会保存在本地,不会上传。

06 独具特色的使用方式

OpenCode并不局限在一个交互方式里。

1、非交互模式

opencode run “Explain how closures work in JavaScript”

可以直接写进脚本、CI流程。

2、服务端/客户端分离

你可以在服务器上跑:

opencode serve

然后在本地甚至手机上:

opencode attach http://server-ip:4096

这意味着:

重活在服务器,操作在轻终端。

对需要在服务器上编译、测试的项目来说,非常爽。

3、Web界面

opencode web

直接浏览器操作,不碰终端也行。

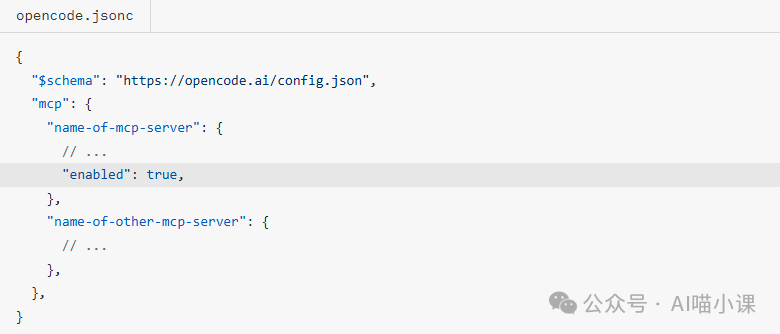

07 MCP+Skills:OpenCode真正的“扩展性核心”

如果说前面都是好用,

那 MCP和Skills ,就是可无限进化。

1、MCP:给AI接上外部世界

通过MCP,OpenCode可以:

- 查Sentry错误

- 搜GitHub代码

- 查技术文档

- 接内部系统

而且配置非常干净、可控。

2、Skills:把经验封装成能力

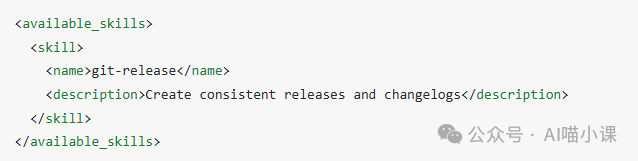

Skill本质上是:

可复用的工程经验模板

你可以把:

- 发布流程

- Code Review规范

- CI检查逻辑

全部封装成Skill,团队直接复用。

这一步,OpenCode已经不只是“工具”,

而是 工程方法的载体。这种将AI能力模块化的思路,正是现代人工智能应用开发的核心趋势之一。

OpenCode的价值

如果你只是:

OpenCode可能显得有点“重”。

但如果你:

- 在维护长期项目

- 开始被AI生成代码反噬

- 想让AI成为“靠谱同事”而不是“灵感老虎机”

那OpenCode,非常值得你投入时间。

想要探索更多AI与开发的深度结合,或分享你的OpenCode使用心得?欢迎访问云栈社区进行技术交流。