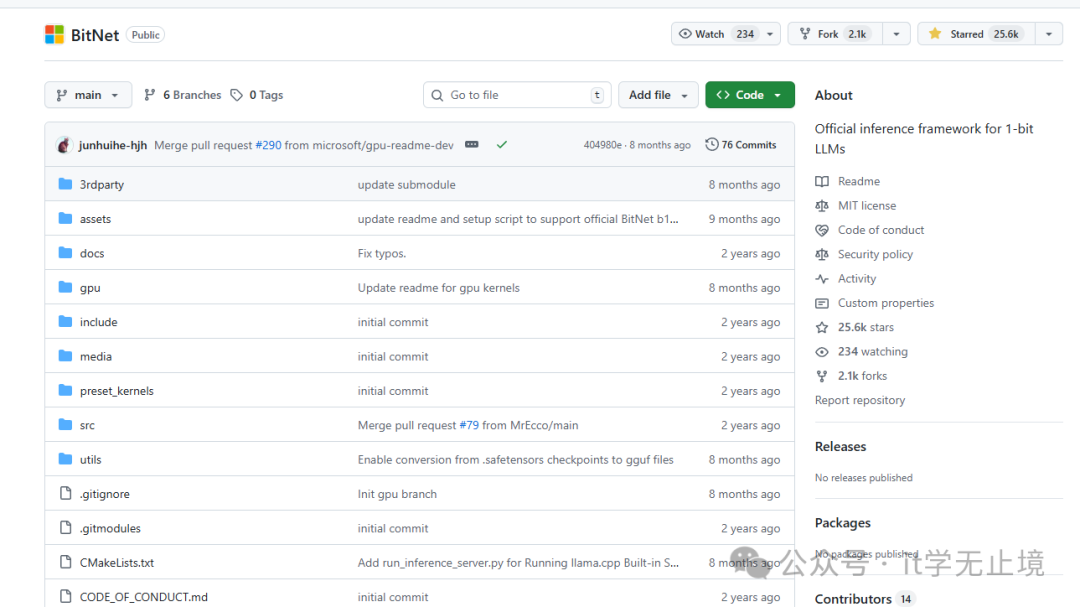

微软近期在GitHub上开源了一个名为BitNet的项目,这是一个能够直接在普通CPU上流畅运行千亿参数大语言模型的推理框架。这标志着,无需依赖昂贵的GPU或云端服务器,仅凭本地笔记本电脑即可部署和运行以往难以想象的大型模型。

什么是BitNet?

简而言之,BitNet是微软官方推出的1-bit LLM推理框架,其核心是一个名为 bitnet.cpp 的库。

传统的大语言模型(例如GPT系列)普遍采用32位或16位浮点数存储参数,计算过程涉及大量浮点乘法运算,这也正是它们必须依赖GPU算力的原因。

而BitNet的设计思路截然不同。它将模型参数压缩至1.58位(接近1位),并利用超高效的加法运算替代了昂贵的浮点乘法,从底层重构了AI模型的计算逻辑。

它具备哪些优势?

1. CPU也能运行千亿参数模型

根据微软官方文档,BitNet能够在标准CPU上高效运行千亿参数的1-bit模型,且推理速度表现不俗。这意味着,过去需要数万美元GPU集群才能运行的GPT-3级别模型,现在可能仅需一台普通笔记本电脑即可实现。

2. 无损压缩,性能不打折

你可能会担忧,如此极端的参数压缩是否会显著损害模型性能?答案是:几乎不会。BitNet采用了特殊的1-bit量化技术,在极大压缩模型体积的同时,其推理性能与传统16位模型几乎持平。微软的测试结果表明,BitNet b1.58模型在性能相当的前提下,推理速度能获得数倍的提升。

3. 超轻量级部署

BitNet的部署流程极为简洁,仅需几条命令即可在本地环境搭建完整的推理服务。它不依赖复杂的Python环境或CUDA配置,整个框架由C++编写,直接编译后即可运行,极大降低了使用门槛。

技术原理:用加法取代乘法

BitNet的核心创新在于其1-bit线性层。

传统的线性层计算遵循公式:

output = input × weight + bias

此处的 × 代表浮点乘法,是大模型计算中最耗资源的操作。

而BitNet的线性层计算则变为:

output = (sign(input) × sign(weight)) × scale + bias

这里的 sign() 函数将输入和权重转换为仅包含 ±1 的二进制值。随后,通过高效的加法运算来模拟传统的乘法操作。这种设计使得BitNet的计算效率相比传统模型有了数十倍的飞跃。

如何使用BitNet?

你可以通过以下步骤快速体验BitNet:

步骤1:克隆仓库

git clone https://github.com/microsoft/BitNet.git

cd BitNet

步骤2:编译

make -j4

步骤3:下载模型

BitNet支持多种1-bit模型,你可以从Hugging Face下载预训练好的模型文件,例如一个70亿参数的模型:

wget https://huggingface.co/microsoft/BitNet-b1.58-7B/resolve/main/bitnet-b1.58-7b.gguf

步骤4:运行推理

./bitnet -m bitnet-b1.58-7b.gguf -p "Hello, BitNet!"

至此,你已经在CPU上成功运行了一个拥有70亿参数的1-bit大语言模型。

它能用来做什么?

1. 本地AI助手

你可以在离线环境下,于个人电脑上部署功能强大的AI助手,既无需担心数据隐私泄露,也免去了持续的云服务费用。

2. 边缘设备部署

得益于其轻量级特性,BitNet非常适合部署在智能手机、智能手表乃至各类嵌入式系统等边缘设备上,推动AI能力真正下沉。

3. 大规模AI应用

对于企业而言,BitNet能够显著降低大规模AI应用的部署与运营成本,有助于大模型技术在更广泛的行业场景中普及。

一点思考

BitNet的出现,不禁让人联想到早期的个人计算机革命。正如当年IBM PC将计算能力从实验室带入千家万户,BitNet正在致力于将大语言模型从昂贵的专用硬件中解放出来,使其能够运行在每个人的桌面上。这不仅是技术的演进,更是推动AI民主化进程中的关键一步。

结语

如果你对大语言模型感兴趣,或正在寻找一种低成本的AI本地化部署方案,那么BitNet无疑是一个值得深入关注的开源项目。

最优秀的技术往往并非最复杂的,而是最能解决实际问题的。BitNet没有炫酷的理论包装,但其通过重构计算范式,精准地解决了大模型普及道路上的核心瓶颈——成本与可用性。期待未来有更多开发者基于BitNet构建出创新且实用的AI应用,让人工智能技术更自然地融入我们的工作与生活。对于此类前沿技术的实践与探讨,也欢迎你来到云栈社区与更多开发者交流分享。