今天为大家介绍的项目是 TARS,一个由字节跳动开源的、在 GitHub 上标星超过 23.5k 的多模态 AI 代理栈(AI Agent Stack)。它目前包含两个核心子项目:Agent TARS 和 UI-TARS-desktop。

1. Agent TARS:通用的多模态 AI 代理栈

Agent TARS 是一个通用的多模态 AI 代理栈,旨在将 GUI Agent 和视觉识别的强大能力引入终端、计算机、浏览器乃至你的产品中。

它的目标是通过前沿的多模态大语言模型(LLMs)以及与各种现实世界 MCP(Model Context Protocol)工具的无缝集成,打造更接近人类完成任务方式的工作流。该项目主要提供 CLI(命令行界面)和 Web UI 供开发者使用。

核心特征

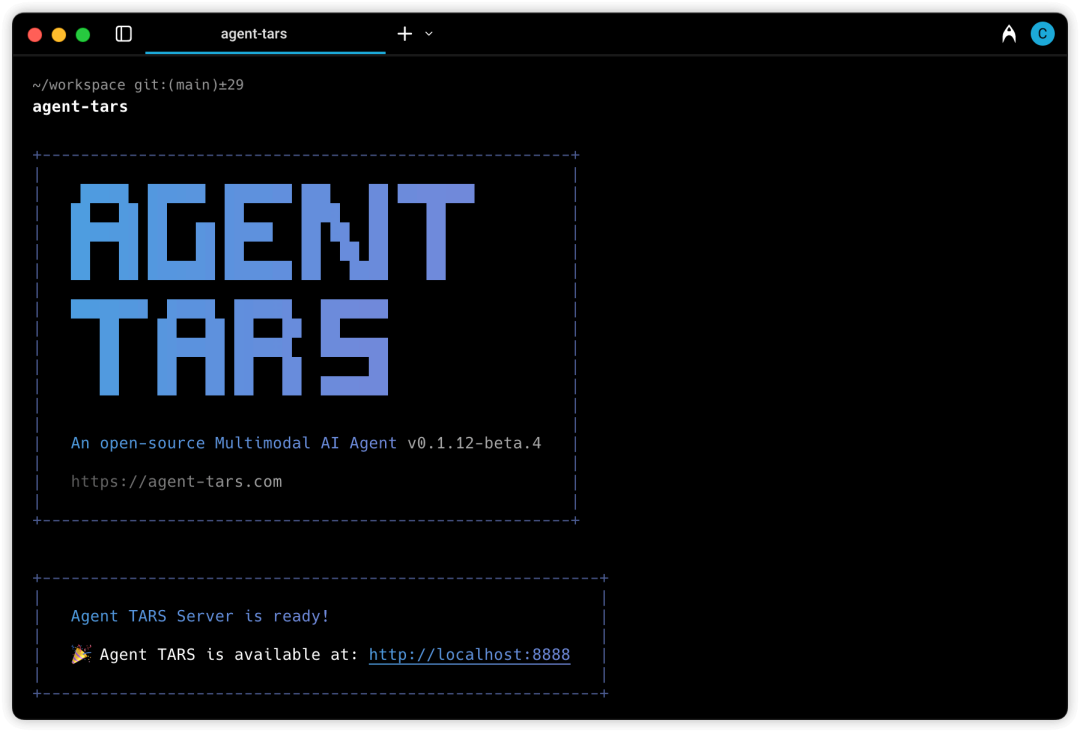

- 开箱即用:提供一键启动的 CLI,支持带界面的 Web UI 模式和无界面的服务器执行模式。

- 混合浏览器智能体:能够通过 GUI Agent、DOM 操作或混合策略来控制浏览器,实现网页自动化。

- 事件流驱动:基于协议驱动的事件流(Event Stream)来驱动上下文工程(Context Engineering)和代理用户界面(Agent UI)。

- 强大的工具集成:内核构建在 MCP 之上,同时支持挂载额外的 MCP Servers 来连接现实世界的各类工具,极大地扩展了 AI Agent 的能力边界。

快速开始

你可以通过以下几种方式快速启动 Agent TARS:

# 使用 `npx` 临时启动(无需安装)。

npx @agent-tars/cli@latest

# 全局安装,需要 Node.js >= 22 环境。

npm install @agent-tars/cli@latest -g

# 使用你喜欢的模型提供商运行,例如火山引擎或 Anthropic。

agent-tars --provider volcengine --model doubao-1-5-thinking-vision-pro-250428 --apiKey your-api-key

agent-tars --provider anthropic --model claude-3-7-sonnet-latest --apiKey your-api-key

2. UI-TARS Desktop:本机原生 GUI 智能体

UI-TARS Desktop 是一个由 UI-TARS 框架和 Seed-1.5-VL/1.6 系列视觉语言模型驱动的原生 GUI 智能体应用。它可以直接在你的本地计算机上运行,通过自然语言指令来控制桌面应用。

核心特征

- 视觉语言驱动:完全由视觉语言模型(Vision-Language Model)驱动,实现用自然语言控制电脑。

- 精准的视觉识别:支持屏幕截图和视觉元素识别,让智能体能“看到”屏幕内容。

- 底层输入控制:提供精确的鼠标移动、点击和键盘输入模拟控制。

- 跨平台支持:兼容 Windows、macOS 及浏览器环境。

- 实时反馈:操作过程中提供实时状态反馈和显示。

- 隐私安全:所有数据处理均在本地完成,保障了用户隐私和安全。

作为一个功能强大的 开源实战 项目,UI-TARS-desktop 的代码仓库地址为:https://github.com/bytedance/UI-TARS-desktop。

整个 TARS 项目栈基于现代化的技术构建,其 CLI 工具依赖于 Node.js 环境,展示了在桌面自动化和智能交互领域的前沿探索。对于关注 AI 与自动化结合的开发者而言,这无疑是一个值得深入研究的技术范本。如果你对这类技术讨论感兴趣,欢迎在技术社区进行交流。 |