随着人工智能技术的飞速演进,语音交互正逐渐成为人机交互的核心前沿。Fun-Audio-Chat 作为阿里巴巴通义百聆团队开源的新一代端到端语音交互模型,凭借其独特的双分辨率架构与高效的 Core-Cocktail 训练策略,在语音理解、情感感知与任务执行等多方面展现出卓越性能,为语音交互领域注入了新的活力。

一、项目概述

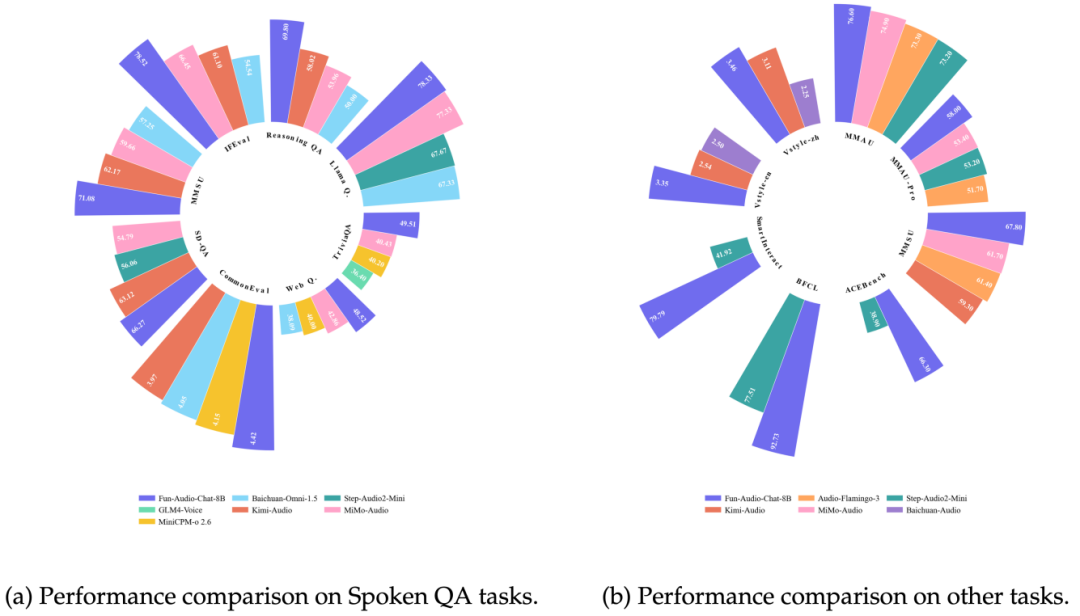

Fun-Audio-Chat 是一款专注于提供自然、低延迟体验的大型音频语言模型(LALM)。其核心创新在于引入了双分辨率语音表征:一个以 5Hz 帧率运行的高效共享主干网络负责语义理解,搭配一个以 25Hz 帧率工作的精细语音重建头部(SRH)来保障高质量语音输出。这一设计在显著降低计算开销的同时,依然能生成自然流畅的语音。配合其独特的 Core-Cocktail 训练策略,模型在获得强大语音能力的同时,也保留了基础文本语言模型的优秀性能。在口语问答、音频理解、语音功能调用等多个权威基准测试中,Fun-Audio-Chat 均取得了领先的成绩。

二、核心功能

(一)端到端语音交互

Fun-Audio-Chat 摒弃了传统的 ASR(语音识别) + LLM(大语言模型) + TTS(文本转语音) 多模块串联模式,采用端到端的 Speech-to-Speech (S2S) 架构。这意味着模型可以直接从用户的语音输入生成语音回应,消除了模块间信息传递的损耗与延迟,实现了更高效、更流畅的对话体验。

(二)情绪感知与情感回应

模型具备深层次的上下文与副语言信息理解能力。它能够通过分析用户的语义内容、语气、语速乃至停顿等细微特征,来感知用户的情绪状态。无论是用户感到生气、焦虑还是开心,Fun-Audio-Chat 都能给出恰如其分的安慰、陪伴或共鸣,提供更具同理心的交互体验。

(三)自然语音指令执行

Fun-Audio-Chat 支持 Speech Function Call 功能。用户只需用自然的口语下达指令,例如“帮我定一个明早七点的闹钟”或“查询一下北京明天的天气”,模型便能理解意图并自动调用相应的函数或工具来完成复杂任务,让语音控制变得更加智能和便捷。

三、技术揭秘

(一)端到端 S2S 架构

如前所述,其端到端设计是效率提升的关键。这种一体化架构不仅简化了系统 pipeline,更从根本上降低了因模块拼接带来的累计延迟和错误,是实现“真·实时”语音交互的基础。

(二)双分辨率设计

这是模型在效率与质量间取得平衡的核心技术。Shared LLM Backbone 以较低的 5Hz 帧率处理语音,高效抽取高层语义;而 Speech Reconstruction Head (SRH) 则以更高的 25Hz 帧率负责细节重建,合成高保真语音。官方数据显示,该设计将GPU计算开销降低了近 50%,为大规模部署提供了可能。

(三)Core-Cocktail 训练策略

为了在赋予模型强大语音能力的同时,避免其遗忘原有的文本语言能力(灾难性遗忘),团队采用了 Core-Cocktail 两阶段训练法。第一阶段在多任务混合数据上进行预训练,让模型同时学习语音和文本的通用语义表示;第二阶段在特定任务数据上进行有目标的微调,以进一步提升专项性能。这种策略确保了模型能力的均衡与全面。

(四)海量多任务数据训练

模型的强大泛化能力源于其背后海量、多样的训练数据。Fun-Audio-Chat 经过了覆盖数百万小时的多任务数据锤炼,场景囊括音频理解、语音问答、情感分析、工具调用等,这使得它能够更“接地气”地理解真实世界中的用户意图,从而在多个评测榜单上脱颖而出。

四、应用场景

(一)语音聊天

作为自然的语音对话伙伴,适用于日常社交、语言练习、休闲娱乐等场景,提供近似真人的交流体验。

(二)情感陪伴

凭借其情绪感知能力,可作为数字陪伴助手,在用户需要倾诉或鼓励时提供情感支持。

(三)智能设备控制

无缝融入智能家居、车载系统、可穿戴设备等,通过自然语音实现全屋智能或设备功能的操控。

(四)语音客服

应用于企业客服场景,能够快速理解用户问题并提供标准、准确的解答,提升服务效率与用户体验。

(五)角色扮演

用户可指令模型扮演特定角色,如游戏NPC、虚拟主播、故事讲解员等,创造丰富的沉浸式互动内容。

五、快速使用指南

(一)环境准备

确保系统已安装 ffmpeg,建议使用 conda 创建隔离环境:

conda create -n FunAudioChat python=3.12 -y

conda activate FunAudioChat

pip install torch==2.8.0 torchaudio==2.8.0 --index-url https://download.pytorch.org/whl/cu128

git clone --recurse-submodules https://github.com/FunAudioLLM/Fun-Audio-Chat

cd Fun-Audio-Chat

pip install -r requirements.txt

(二)下载模型

可通过 Hugging Face Hub 或 ModelScope 下载模型,任选其一:

方式一 (Hugging Face):

pip install huggingface-hub

hf download FunAudioLLM/Fun-Audio-Chat-8B --local-dir ./pretrained_models/Fun-Audio-Chat-8B

hf download FunAudioLLM/Fun-CosyVoice3-0.5B-2512 --local-dir ./pretrained_models/Fun-CosyVoice3-0.5B-2512

方式二 (ModelScope):

modelscope download --model FunAudioLLM/Fun-Audio-Chat-8B --local_dir pretrained_models/Fun-Audio-Chat-8B

modelscope download --model FunAudioLLM/Fun-CosyVoice3-0.5B-2512 --local_dir pretrained_models/Fun-CosyVoice3-0.5B-2512

下载后目录结构应如下:

pretrained_models/

├── Fun-Audio-Chat-8B/ # 主模型

└── Fun-CosyVoice3-0.5B-2512/ # 去分词器

(三)运行基础推理

在项目根目录下执行:

export PYTHONPATH=`pwd`

python examples/infer_s2t.py

python examples/infer_s2s.py

其中,infer_s2t.py 默认使用 utils/constant.py 中的 DEFAULT_S2T_PROMPT,可根据任务需求手动修改。

(四)启动 Web 演示

- 启动服务端 (建议使用第二块GPU):

pip install sphn aiohttp

python -m web_demo.server.server --model-path pretrained_models/Fun-Audio-Chat-8B --port 11236 --tts-gpu 1

- 启动客户端 (需 Node.js 环境):

cd web_demo/client

nvm use

openssl req -x509 -newkey rsa:4096 -keyout key.pem -out cert.pem -days 365 -nodes

echo "VITE_QUEUE_API_PATH=/api" > .env.local

npm install

npm run dev

六、结语

Fun-Audio-Chat 通过其端到端的架构、创新的双分辨率设计以及高效的训练策略,在 人工智能 语音交互领域树立了新的标杆。它不仅在多项测试中表现优异,更提供了从情感陪护到智能控制等丰富的应用可能性。随着技术的持续迭代与 开源实战 社区的共同努力,此类模型有望进一步推动智能语音交互的普及与深化。对于开发者而言,深入研究和应用此类 智能 & 数据 & 云 前沿技术,将是构建下一代人机交互应用的关键。

项目地址

本文介绍了阿里巴巴开源的Fun-Audio-Chat模型,更多前沿AI技术动态与开源项目深度解读,欢迎访问 云栈社区 进行交流与探索。