在服务器性能监控中,iowait指标飙升是运维工程师经常遇到的警报之一。很多同事会直接将其等同于磁盘I/O瓶颈或系统I/O负载过高,但这种理解并不完全准确。实际上,iowait的数值高低需要结合具体场景来分析:高iowait不代表系统一定有I/O瓶颈,单独一个高数值不一定是问题所在;反之,iowait低也不意味着系统就没有I/O问题。

要厘清这个概念,首先要理解iowait的本质。在Linux系统中,iowait是CPU空闲(idle)时间的一部分,它表示CPU因为等待I/O操作(主要是块设备I/O)完成而消耗的时间百分比。关键在于:它并非I/O操作本身占用CPU的时间,而是CPU因无事可做、被动等待I/O完成所耗费的时间。因此,iowait的大小不仅受I/O速度影响,也受到CPU自身忙闲程度的制约。

下面,我们通过两组对比实验来验证这一点。

实验一:CPU空闲时的高iowait

首先,我们使用taskset命令将一个读磁盘的dd命令绑定到特定的CPU(例如CPU 1)上执行。为了排除页缓存(Page Cache)的干扰,我们指定dd使用直接I/O(Direct IO)模式。

taskset -c 1 dd if=/dev/sda of=/dev/null count=1M bs=4k iflag=direct

接着,使用mpstat命令监控该CPU的实时性能数据。

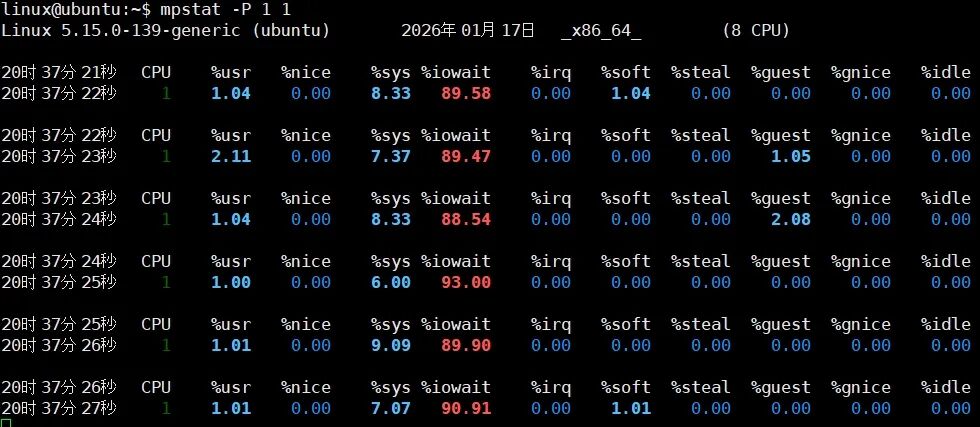

mpstat -P 1 1

从监控截图可以看到,此时该CPU的iowait值高达90%左右,而用户态(%usr)和系统态(%sys)的利用率都很低。这说明当CPU没有其他任务可执行时,它大部分时间都在等待这个I/O操作完成。

实验二:CPU繁忙时的低iowait

现在,我们做一个对比实验。在保持上述dd命令运行的同时,在同一个CPU 1上再绑定运行一个死循环(deadloop)程序,让这个CPU始终处于繁忙状态。

taskset -c 1 ./deadloop

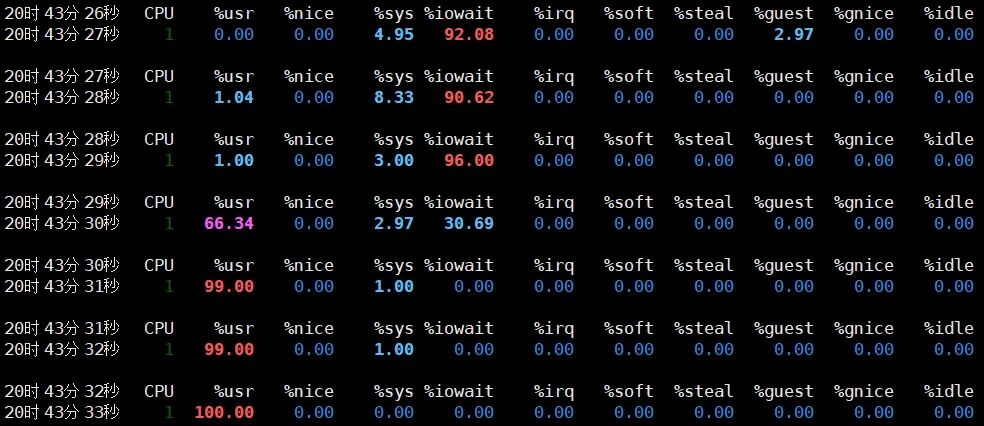

此时,再次观察mpstat的输出,会发现情况发生了戏剧性的变化。

可以看到,用户态CPU利用率瞬间飙升至接近100%,而iowait则降到了0。这个实验清晰地表明:两个实验的I/O负载(同一个dd命令)基本是相同的,但iowait值却天差地别。原因在于,第二个实验中CPU忙于执行死循环,dd进程在发起I/O请求后,如果CPU正在执行其他任务,其等待I/O的时间就不会被计入iowait。这恰恰说明了iowait是CPU空闲时的度量,而非直接的I/O负载度量。

除了CPU忙闲状态,I/O模型的选择也会极大地影响iowait对负载的反映。异步I/O(AIO)模式下,进程发起I/O请求后不会阻塞等待,而是继续执行其他任务,这同样会“掩盖”掉一部分等待时间。下面我们用fio工具来演示同步I/O与异步I/O的区别。

我们进行两个fio磁盘压力测试:

- 实验一(异步I/O):使用

libaio引擎。

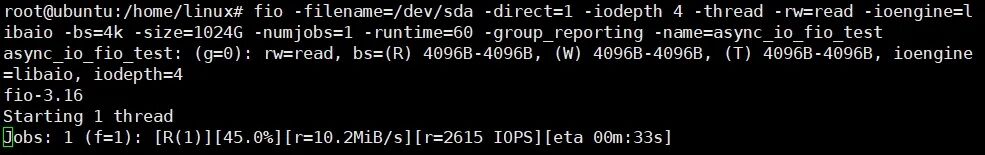

fio -filename=/dev/sda -direct=1 -iodepth 4 -thread -rw=read -ioengine=libaio -bs=4k -size=1024G -numjobs=1 -runtime=60 -group_reporting -name=async_io_fio_test

- 实验二(同步I/O):使用

sync引擎,其他参数不变。

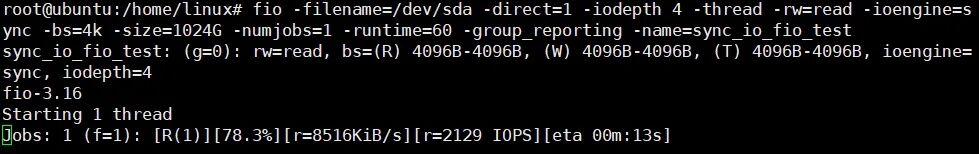

fio -filename=/dev/sda -direct=1 -iodepth 4 -thread -rw=read -ioengine=sync -bs=4k -size=1024G -numjobs=1 -runtime=60 -group_reporting -name=sync_io_fio_test

实验一(异步I/O)结果:

fio测试输出显示带宽约为10MiB/s,IOPS为2615。

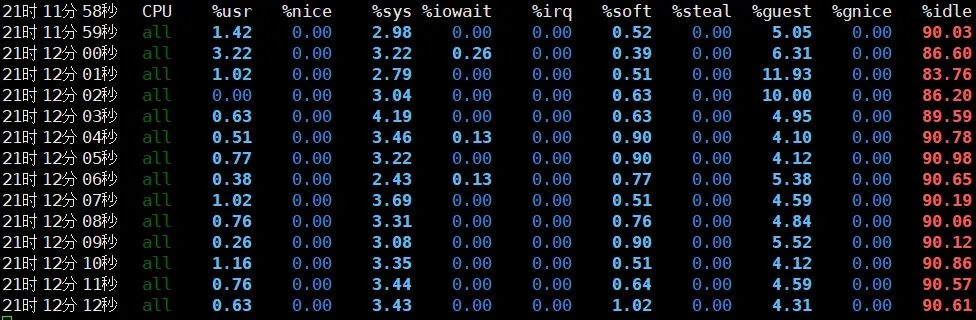

对应的系统mpstat监控显示,整个系统的iowait几乎为0。

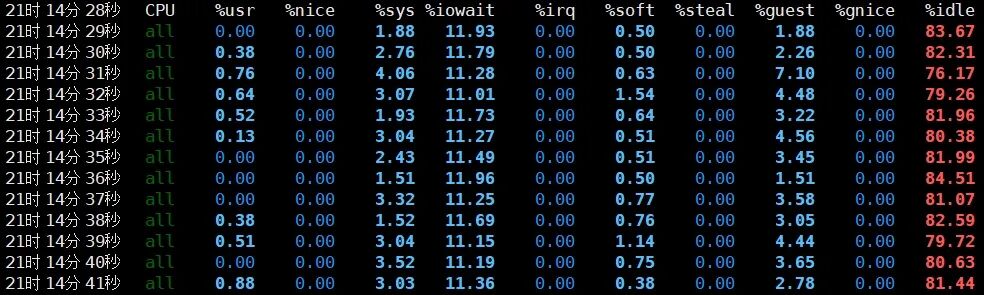

实验二(同步I/O)结果:

fio测试输出显示带宽约为8.3MiB/s,IOPS为2129,性能略低于异步I/O。

对应的系统mpstat监控显示,此时系统出现了约11%的iowait。

通过这组对比可以发现一个有趣的现象:异步I/O由于效率更高,实际产生的I/O负载(带宽、IOPS)更大,但其iowait反而更低。这进一步证明了,我们不能单纯依据iowait的数值高低来武断地判断系统I/O负载的大小或是否存在瓶颈。

总结:如何正确理解iowait?

综上所述,在解读iowait指标时,务必牢记以下两个核心特性:

- 发生条件特定:iowait只发生在CPU空闲(idle)时。只有当CPU没有其他进程可执行,并且至少有一个进程在等待I/O操作完成时,这段等待时间才会被计入iowait。

- 非直接度量:iowait不是I/O负载的直接度量标准。高iowait仅意味着CPU经常因等待I/O而空闲,但这可能是由于I/O系统确实繁忙(真实瓶颈),也可能是CPU本身负载太轻。要准确诊断,必须结合磁盘I/O吞吐量、IOPS、I/O延迟、CPU利用率等多个指标进行综合分析。

下次在监控系统中看到iowait飙升时,不必立即恐慌。它更像是一个提示你“需要进一步排查”的信号,而非一个确凿的“故障判决书”。深入理解其背后的原理,才能做出更精准的性能诊断。关于更多系统性能分析与优化的实践经验,欢迎在云栈社区与广大开发者共同探讨。